论文阅读笔记:《Interconnected Question Generation with Coreference Alignment and Conversion Flow Modeling》

论文阅读;《Interconnected Question Generation with Coreference Alignment and Conversion Flow Modeling》

作者:Yifan Gao, Piji Li, Irwin King, Michael R.yu

论文来源:ACL2019

WHAT

CQG会话问题生成,对于给定文章最终想要生成会话QA对的形式,并且要在每轮对话中实现平稳的过渡。

使用共指想要生成相互关联的问题。

HOW

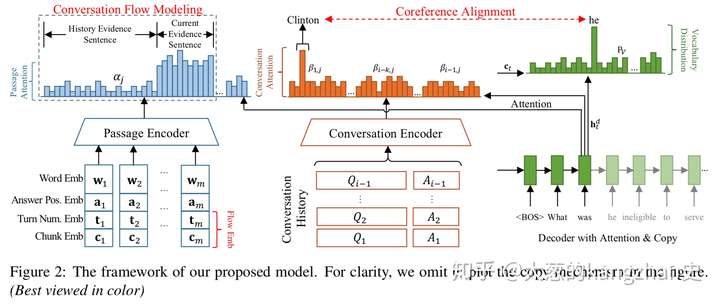

一、 模型

1.多源编码器(使用bi-LSTM)

1) 文章编码器

输入词嵌入、答案位置嵌入,在每个答案位置嵌入要使用BIO标签打在答案位置嵌入上,获得一个隐藏状态

2)会话编码器

使用<q><a>标记历史QA对,形成一个QA序列;先使用词级Bi-LSTM生成关于上下文的隐藏状态,再使用上下文级Bi-LSTM生成关于上下文之间依赖的隐藏状态

2.具有注意力机制和复制机制的解码器(LSTM)

解码器的本身应该决定在每个解码时间步长时应该更多的关注段落隐藏层还是历史对话隐藏层状态。这里用到的是seq2seq模型的计算方法,计算出词注意力权重和文章注意力权重,对话注意力权重,然后计算上下文向量,和单词的概率分布。

3.共指对比建模

会话问题的关键是使用共指回溯历史会话。

共指建模的作用是查看看正确的非共指代词以生成公指代词的参考词

预处理阶段:使用共指消解系统找到共指关系

训练阶段:引入损失函数

4.会话流建模

1)流嵌入

在段落编码器中引入了一个门控自注意建模机制,通过答案位置嵌入的自注意力机来获得与答案相关的有效信息,通过嵌入轮数和块来更好的会话流建模。这里需要了解一下self-maching

门控的实质就是一个全连接层

2)流损失

目的:应该关注当前证据句而忽视历史证据句

二、 实验

数据集的准备:CoQA,ATM获得

步骤:

定位答案位置

会话历史轮数的确定(对话中的大多数问题在两轮内具有有限的依赖关系,因此,选择历史轮数为3,确保目标问题具有足够的转换历史信息来生成,避免从所有QA对的回合中引入过多的噪声)

有监督的训练

Feeling

相比于前人的工作,此模型的确有很大的进步,创新性也值得借鉴,但是本模型是抽取式的问答,生成的问题也是很简单的问题,如果想要实现对复杂问题的生成或者想要包含深度语义信息的问题此模型并不能解决。

研一NLP初学小白,欢迎各路大神一起讨论。

论文阅读笔记:《Interconnected Question Generation with Coreference Alignment and Conversion Flow Modeling》的更多相关文章

- 《MuseGAN: Multi-track Sequential Generative Adversarial Networks for Symbolic Music Generation and Accompaniment》论文阅读笔记

出处:2018 AAAI SourceCode:https://github.com/salu133445/musegan abstract: (写得不错 值得借鉴)重点阐述了生成音乐和生成图片,视频 ...

- (转)Introductory guide to Generative Adversarial Networks (GANs) and their promise!

Introductory guide to Generative Adversarial Networks (GANs) and their promise! Introduction Neural ...

- 生成对抗网络(Generative Adversarial Networks,GAN)初探

1. 从纳什均衡(Nash equilibrium)说起 我们先来看看纳什均衡的经济学定义: 所谓纳什均衡,指的是参与人的这样一种策略组合,在该策略组合上,任何参与人单独改变策略都不会得到好处.换句话 ...

- 生成对抗网络(Generative Adversarial Networks, GAN)

生成对抗网络(Generative Adversarial Networks, GAN)是一种深度学习模型,是近年来复杂分布上无监督学习最具前景的学习方法之一. GAN 主要包括了两个部分,即 ...

- StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks 论文笔记

StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks 本文将利 ...

- 论文笔记之:Semi-Supervised Learning with Generative Adversarial Networks

Semi-Supervised Learning with Generative Adversarial Networks 引言:本文将产生式对抗网络(GAN)拓展到半监督学习,通过强制判别器来输出类 ...

- 《Self-Attention Generative Adversarial Networks》里的注意力计算

前天看了 criss-cross 里的注意力模型 仔细理解了 在: https://www.cnblogs.com/yjphhw/p/10750797.html 今天又看了一个注意力模型 < ...

- Paper Reading: Perceptual Generative Adversarial Networks for Small Object Detection

Perceptual Generative Adversarial Networks for Small Object Detection 2017-07-11 19:47:46 CVPR 20 ...

- SalGAN: Visual saliency prediction with generative adversarial networks

SalGAN: Visual saliency prediction with generative adversarial networks 2017-03-17 摘要:本文引入了对抗网络的对抗训练 ...

- Generative Adversarial Networks,gan论文的畅想

前天看完Generative Adversarial Networks的论文,不知道有什么用处,总想着机器生成的数据会有机器的局限性,所以百度看了一些别人 的看法和观点,可能我是机器学习小白吧,看完之 ...

随机推荐

- v-slot vue2.6新增指令使用指南

子组件 <template> <div class="wrapper"> <slot name="demo" :msg=" ...

- 自己写IRP,做文件操作,遇到的坑

在写文件的时候没问题,但是写完文件之后,就出问题了, 什么问题呢,是因为写完文件之后,文件关闭之后, 调用了一个叫做 CcFlushCache 的函数,这个函数是从CcWriteBehind 调过来的 ...

- 《构建之法》IT行业的创新 读书笔记 WEEK 5

本周选读邹欣老师的<构建之法>第16章——IT行业的创新. 邹欣老师将本章话题分成五个部分来阐述:创新的迷思.创新的时机.创新的招数.魔方的创新.创新和作坊,博主认为时机和招数这两个部分在 ...

- LeetCode Array Easy 53. Maximum Subarray 个人解法 和分治思想的学习

Description Given an integer array nums, find the contiguous subarray (containing at least one numbe ...

- iptables 防火墙(上)

iptables 防火墙(上) 1. 防火墙概述 1.1 概念与作用 网络中的防火墙是一种将内部网络和外部网络分开的方法,是一种隔离技术.防火墙在内网与外网通信时进行访问控制,依据所设置的规则对数据包 ...

- Oracle 环境部署 以及数据库创建 ,用户新建和权限分配

1.右键我的电脑--->属性--->高级系统设置 2.环境变量---->新建 总共配置三个变量 (1)变量名 ORACLE_HOME 变量值 G:\app\TH\product\11 ...

- linux配置java环境变量(详细)(转)

linux配置java环境变量(详细) 一. 解压安装jdk 在shell终端下进入jdk-6u14-linux-i586.bin文件所在目录, 执行命令 ./jdk-6u14-linux-i586. ...

- vue css动画原理

从隐藏到显现 从显现到隐藏 <!DOCTYPE html> <html> <head> <meta charset="UTF-8"> ...

- TCP三次挥手

tcp:三次握手 client和server之间需要经历三次握手才能建立连接(connnect()方法中封装了三次握手的步骤)syn:同步请求,建立连接的请求ack:对syn请求包的确认 应答syn: ...

- Dart编程实例 - Const 关键字

Dart编程实例 - Const 关键字 void main() { final v1 = 12; const v2 = 13; v2 = 12; } 本文转自:http://codingdict.c ...