scrapy微信爬虫使用总结

scrapy+selenium+Chrome+微信公众号爬虫

概述

1、微信公众号爬虫思路:

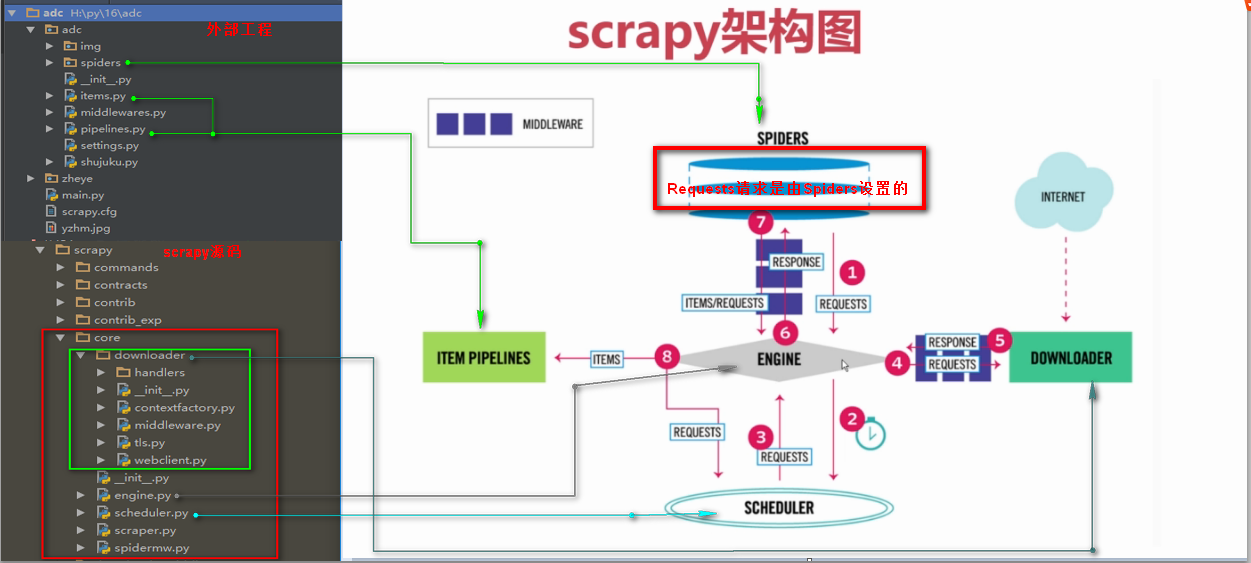

2、scrapy框架图

3、scrapy经典教程

参考:

4、其它

参考:

实践

1、环境的安装

- selenium安装(pip install selenium)

- chromedriver安装(注意与chrome版本兼容问题)

- beautifulsoup4

- scrapy

- MongoDB、pymongo

MongoDB:

具体命令如下:

python连接MongoDB,需安装pip install mongoengine

启动:

sudo ./mongod --port 27017 dbpath "/software/mongodb-4.0.0/data/db" --logpath "/software/mongodb-4.0.0/log/mongodb.log" --logappend --replSet rs0

Windows下MongoDB数据导出:

mongodump --port 27017 -d wechat -o D:\MongoDB

Linux下MongoDB数据导入:

./mongorestore -h 127.0.0.1 --port 27017 -d wechat --drop /software/mongodb-4.0.0/wechat

数据导入时注意:

Do you run mongo in replica set, i.e., mongod --replSet rs0?

If yes, please remember to run in your mongo shell the command: rs.initiate()

参考:

2、cookie获取

selenium进行登录验证,保存cookies,为scrapy做准备。

3、爬虫

- cookies:scrapy spider初始化函数调用Chromedriver,并获取cookies

- 定位:spider初始化函数利用Chromedriver定位到需要抓取的页面

- 解析:parse函数处理Chromedriver自动定scrapy爬虫利用selenium实现用户登录和cookie传递位的页面信息,以及下一页URL

- 保存:scrapy配置MongoDB保存数据

参考:

scrapy爬虫利用selenium实现用户登录和cookie传递

4、django调用爬虫

5、django构建搜索引擎,搜索爬过的信息

参考:

环境配置:

elasticsearch-rtf安装、pip install mongo-connector、pip install mongo-connector[elastic5]、pip install elastic2-doc-manager

MongoDB数据同步到elasticsearch:

mongo-connector -m localhost:27017 -t localhost:9200 -d elastic2_doc_manager

其它问题

1、selenium在新页面定位元素问题

参考:

解决Selenium弹出新页面无法定位元素问题(Unable to locate element)

3、在管道中关闭爬虫

spider.crawler.engine.close_spider(spider, 'bandwidth_exceeded')

scrapy微信爬虫使用总结的更多相关文章

- 爬虫学习之基于Scrapy的爬虫自动登录

###概述 在前面两篇(爬虫学习之基于Scrapy的网络爬虫和爬虫学习之简单的网络爬虫)文章中我们通过两个实际的案例,采用不同的方式进行了内容提取.我们对网络爬虫有了一个比较初级的认识,只要发起请求获 ...

- scrapy爬虫学习系列二:scrapy简单爬虫样例学习

系列文章列表: scrapy爬虫学习系列一:scrapy爬虫环境的准备: http://www.cnblogs.com/zhaojiedi1992/p/zhaojiedi_python_00 ...

- Scrapy框架-----爬虫

说明:文章是本人读了崔庆才的Python3---网络爬虫开发实战,做的简单整理,希望能帮助正在学习的小伙伴~~ 1. 准备工作: 安装Scrapy框架.MongoDB和PyMongo库,如果没有安装, ...

- Scrapy创建爬虫项目

1.打开cmd命令行工具,输入scrapy startproject 项目名称 2.使用pycharm打开项目,查看项目目录 3.创建爬虫,打开CMD,cd命令进入到爬虫项目文件夹,输入scrapy ...

- Scrapy - CrawlSpider爬虫

crawlSpider 爬虫 思路: 从response中提取满足某个条件的url地址,发送给引擎,同时能够指定callback函数. 1. 创建项目 scrapy startproject mysp ...

- 【Python爬虫实战】微信爬虫

所谓微信爬虫,即自动获取微信的相关文章信息的一种爬虫.微信对我们的限制是很多的,所以我们需要采取一些手段解决这些限制主要包括伪装浏览器.使用代理IP等方式http://weixin.sogou.com ...

- 第三百五十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy分布式爬虫要点

第三百五十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy分布式爬虫要点 1.分布式爬虫原理 2.分布式爬虫优点 3.分布式爬虫需要解决的问题

- 第三百三十五节,web爬虫讲解2—Scrapy框架爬虫—豆瓣登录与利用打码接口实现自动识别验证码

第三百三十五节,web爬虫讲解2—Scrapy框架爬虫—豆瓣登录与利用打码接口实现自动识别验证码 打码接口文件 # -*- coding: cp936 -*- import sys import os ...

- 第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息

第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息 crapy爬取百度新闻,爬取Ajax动态生成的信息,抓取百度新闻首页的新闻rul地址 有多 ...

随机推荐

- mybatis项目启动报错 The content of element type "resultMap" must match "(constructor?,id*,result*,association*,collection*,discriminator?)".

启动项目报错 2018-02-26 17:09:51,535 ERROR [org.springframework.web.context.ContextLoader] - Context initi ...

- Mysql管理工具 SqlYog快捷键大全

Ctrl+M 创建一个新的连接Ctrl+N 使用当前设置新建连接Ctrl+F4 断开当前连接 对象浏览器F5 刷新对象浏览器(默认)Ctrl+B 设置焦点于对象浏览器 SQL 窗口 ...

- 在ubuntu英文系统下使用中文输入法

How to install and use Chinese Input Method in the English Locale in Ubuntu ?(1) Check if there exis ...

- 设置redis访问密码

在服务器上,这里以linux服务器为例,为redis配置密码. 1.第一种方式 (当前这种linux配置redis密码的方法是一种临时的,如果redis重启之后密码就会失效,) (1)首先进入redi ...

- Linux rhel7 下MySQL5.7.18详细安装文档

Linux rhel7 下MySQL5.7.18详细安装文档 本文安装MySQL5.7使用的是vm虚拟机rhel7操作系统 ,ftp文件传输是FileZilla3.27,远程连接xssh5.0 1 登 ...

- 启动Sql server的服务CMD命令

启动:net start mssqlserver 停止:net stop mssqlserver

- 论文笔记之:End-to-End Localization and Ranking for Relative Attributes

End-to-End Localization and Ranking for Relative Attributes arXiv Paper 摘要:本文提出一种 end-to-end 的属性识别方 ...

- Unity3D学习笔记(二十五):文件操作

文件是什么? 存储在硬盘上的最后的节点. 文件夹是什么? 文件的上级单位称为文件夹. 文件夹的基本结构? 文件夹是层级化结构的,对于同级的文件夹不可以重名,父文件夹和子文件夹可以同名> IO:I ...

- NS3 fifth.cc 拥塞窗口实例

fifth.cc /* -*- Mode:C++; c-file-style:"gnu"; indent-tabs-mode:nil; -*- */ /* * This progr ...

- C++:为什么unique_ptr的Deleter是模板类型参数,而shared_ptr的Deleter不是?

为什么unique_ptr的Deleter是模板类型参数,而shared_ptr的Deleter不是? template <class T, class D = default_delete&l ...