MapReduce 开发环境搭建(Eclipse\MyEclipse + Maven)

写在前面的话

可详细参考,一定得去看

HBase 开发环境搭建(Eclipse\MyEclipse + Maven)

Zookeeper项目开发环境搭建(Eclipse\MyEclipse + Maven)

Hive项目开发环境搭建(Eclipse\MyEclipse + Maven)

我这里,相信,能看此博客的朋友,想必是有一定基础的了。我前期写了大量的基础性博文。可以去补下基础。

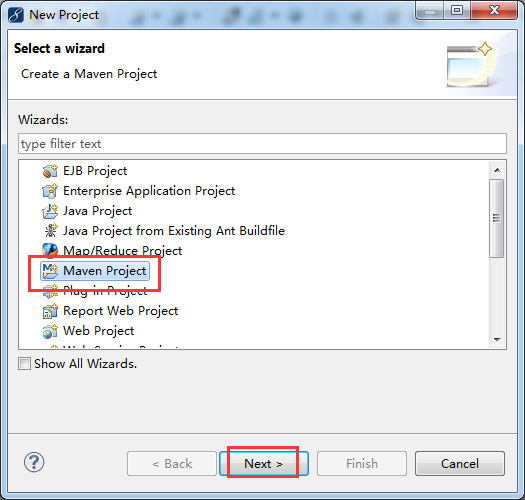

步骤一:File -> New -> Project -> Maven Project

步骤二:自行设置,待会创建的myHBase工程,放在哪个目录下。

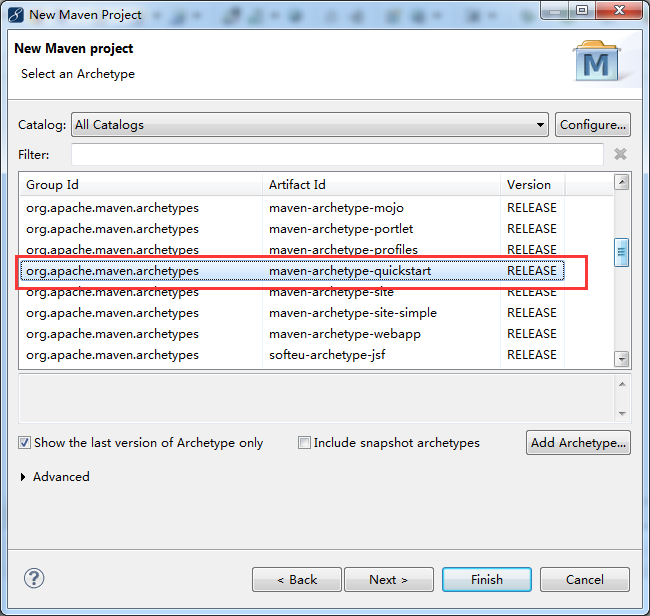

步骤三:

步骤四:自行设置

步骤五:修改jdk

省略,很简单!

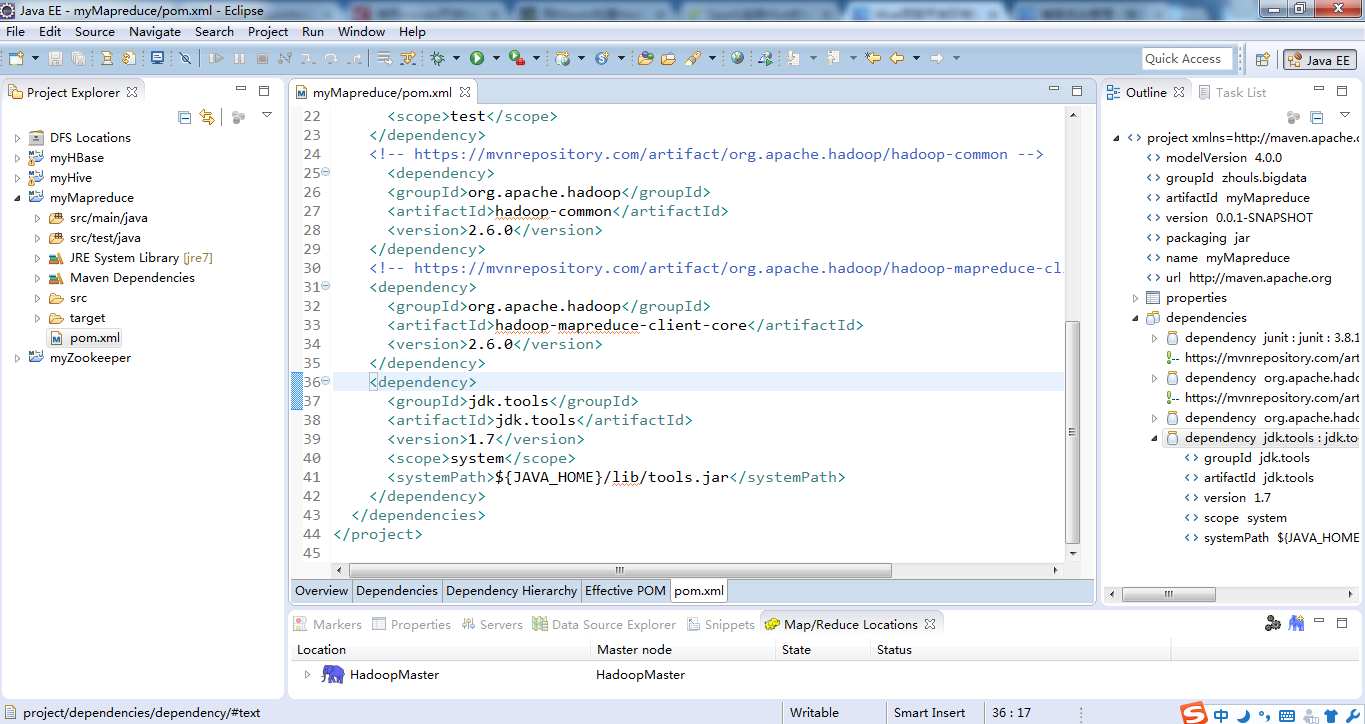

步骤六:修改pom.xml配置文件

官网Maven的zookeeper配置文件内容:

地址:http://www.mvnrepository.com/search?q=mapreduce

因为我的hadoop版本是hadoop-2.6.0

参考: http://blog.csdn.net/e421083458/article/details/45792111

1、

2、

暂时这些吧,以后需要,可以自行再加呢!

最后的pom.xml配置文件为

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>zhouls.bigdata</groupId>

<artifactId>myMapreduce</artifactId>

<version>0.0.1-SNAPSHOT</version>

<packaging>jar</packaging>

<name>myMapreduce</name>

<url>http://maven.apache.org</url>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>3.8.1</version>

<scope>test</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-common -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-mapreduce-client-core -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.6.0</version>

</dependency>

</dependencies>

</project>

当然,这只是初步而已,最简单的,以后可以自行增删。

步骤七:这里,给大家,通过一组简单的Hive应用程序实例来向大家展示Hive的某些功能。

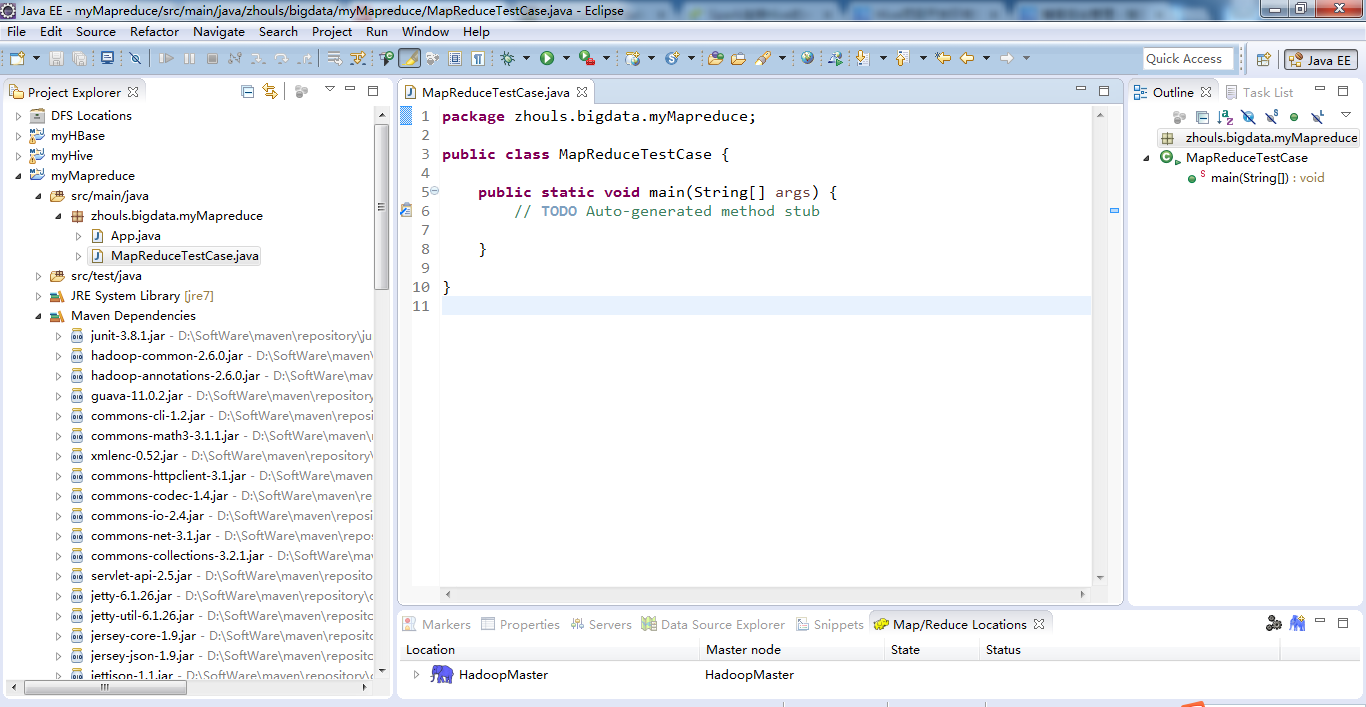

类名为MapReduceTestCase.java

package zhouls.bigdata.myMapreduce;

import java.io.IOException;

import java.util.StringTokenizer;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class MapReduceTestCase

{

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(MapReduceTestCase.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path("hdfs:/HadoopMaster:9000/djt.txt"));

FileOutputFormat.setOutputPath(job, new Path("hdfs:/HadoopMaster:9000/word-count"));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

或者

package zhouls.bigdata.myMapreduce;

import java.io.IOException;

import java.util.regex.Pattern;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner;

/**

* 基于样本数据做Hadoop工程师薪资统计:计算各工作年限段的薪水范围

*/

public class SalaryCount extends Configured implements Tool

{

public static class SalaryMapper extends Mapper<LongWritable, Text, Text, Text>

{

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException

{

// 美团 3-5年经验 15-30k 北京 【够牛就来】hadoop高级工程...

//北信源 3-5年经验 15-20k 北京 Java高级工程师(有Hadoo...

// 蘑菇街 3-5年经验 10-24k 杭州 hadoop开发工程师

//第一步,将输入的纯文本文件的数据转化成String

String line = value.toString();//读取每行数据

String[] record = line.split( "\\s+");//使用空格正则解析数据

//key=record[1]:输出3-5年经验

//value=record[2]:15-30k

//作为Mapper输出,发给 Reduce 端

//第二步

if(record.length >= 3)//因为取得的薪资在第3列,所以要大于3

{

context.write( new Text(record[1]), new Text(record[2]) );

//Map输出,record数组的第2列,第3列

}

}

}

public static class SalaryReducer extends Reducer< Text, Text, Text, Text>

{

public void reduce(Text Key, Iterable< Text> Values, Context context) throws IOException, InterruptedException

{

int low = 0;//记录最低工资

int high = 0;//记录最高工资

int count = 1;

//针对同一个工作年限(key),循环薪资集合(values),并拆分value值,统计出最低工资low和最高工资high

for (Text value : Values)

{

String[] arr = value.toString().split("-");//其中的一行而已,15 30K

int l = filterSalary(arr[0]);//过滤数据 //15

int h = filterSalary(arr[1]);//过滤数据 //30

if(count==1 || l< low)

{

low = l;

}

if(count==1 || h>high)

{

high = h;

}

count++;

}

context.write(Key, new Text(low + "-" +high + "k"));//即10-30K

}

}

//正则表达式提取工资值,因为15 30k,后面有k,不干净

public static int filterSalary(String salary)//过滤数据

{

String sal = Pattern.compile("[^0-9]").matcher(salary).replaceAll("");

return Integer.parseInt(sal);

}

public int run(String[] args) throws Exception

{

//第一步:读取配置文件

Configuration conf = new Configuration();//读取配置文件

//第二步:输出路径存在就先删除

Path out = new Path(args[1]);//定义输出路径的Path对象,mypath

FileSystem hdfs = out.getFileSystem(conf);//通过路径下的getFileSystem来获得文件系统

if (hdfs.isDirectory(out))

{//删除已经存在的输出目录

hdfs.delete(out, true);

}

//第三步:构建job对象

Job job = new Job(conf, "SalaryCount" );//新建一个任务

job.setJarByClass(SalaryCount.class);//设置 主类

//通过job对象来设置主类SalaryCount.class

//第四步:指定数据的输入路径和输出路径

FileInputFormat.addInputPath(job, new Path(args[0]));// 文件输入路径

FileOutputFormat.setOutputPath(job, new Path(args[1]));// 文件输出路径

//第五步:指定Mapper和Reducer

job.setMapperClass(SalaryMapper.class);// Mapper

job.setReducerClass(SalaryReducer.class);// Reducer

//第六步:设置map函数和reducer函数的输出类型

job.setOutputKeyClass(Text.class);//输出结果key类型

job.setOutputValueClass(Text.class);//输出结果的value类型

//第七步:提交作业

job.waitForCompletion(true);//等待完成退出作业

return 0;

}

/**

* @param args 输入文件、输出路径,可在Eclipse中Run Configurations中配Arguments,如:

* hdfs://HadoopMaster:9000/salary.txt

* hdfs://HadoopMaster:9000/salary/out

*/

public static void main(String[] args) throws Exception

{

//第一步

String[] args0 =

{

"hdfs://HadoopMaster:9000/salary/",

"hdfs://HadoopMaster:9000/salary/out"

};

//第二步

int ec = ToolRunner.run(new Configuration(), new SalaryCount(), args0);

//第一个参数是读取配置文件,第二个参数是主类Temperature,第三个参数是输如路径和输出路径的属组

System.exit(ec);

}

}

MapReduce 开发环境搭建(Eclipse\MyEclipse + Maven)的更多相关文章

- 基于 Eclipse 的 MapReduce 开发环境搭建

文 / vincentzh 原文连接:http://www.cnblogs.com/vincentzh/p/6055850.html 上周末本来要写这篇的,结果没想到上周末自己环境都没有搭起来,运行起 ...

- android开发1:安卓开发环境搭建(eclipse+jdk+sdk)

计划折腾折腾安卓开发了,从0开始的确很痛苦,不过相信上手应该也不会太慢.哈哈 一.Android简介 Android 是基于Linux内核的软件平台和操作系统. Android构架主要由3部分组成,l ...

- Linux学习总结(十)—— Java开发环境搭建:JDK+Maven

Java开发环境最基础的两个开源软件是JDK和Maven. JDK 到Oracle官网下载相对应的源码包,这里我选择的是:Linux x64系统的jdk-8u131-linux-x64.tar.gz. ...

- JavaWeb开发环境搭建Eclipse配置Tomcat

转载请标明出处:http://blog.csdn.net/wu_wxc/article/details/48651251本文出自[吴孝城的CSDN博客] 工具: Eclipse官网下载:http:// ...

- mac下搭建java开发环境:eclipse+tomcat+maven

一.安装eclipse 直接下载 二.安装JDK 下载mac版专用的jdk1.7,地址如下:http://jdk7.java.net/macportpreview/, 确认java使用的版本:开一个终 ...

- Java WEB开发环境搭建以及创建Maven Web项目

根据此链接博文学习配置: http://www.cnblogs.com/zyw-205520/p/4767633.html 1.JDK的安装 自行百度,(最好是jdk1.7版本的) 测试如下图,即完成 ...

- JAVA开发环境搭建 - Eclipse基本配置

Eclipse设置的内容包括许多方面,不同的开发人员,不同的项目需要,可能对Eclipse的设置不尽相同.如下内容仅是对本人的一些基本设置做一些记录,以作备忘.后期会逐渐对相关内容进行更新,仅供参考. ...

- Ubuntu下Java开发环境搭建(eclipse)

最近把工作环境转移到了Ubuntu Kylin下,发现在这下面Java环境还是很方便的.然而也经历了一些摸索的过程,故作文以记之. 一/开发前准备 安装系统/配置软件源,这部分内容没什么需要注意的.O ...

- windows8.1下android开发环境搭建(Eclipse+Android sdk+ADT+Genymotion)

一.基本jdk.eclipse环境 二.android sdk 1.下载安装:https://developer.android.com/sdk/installing/index.html?pkg=t ...

随机推荐

- c#做动态(gif)中文验证码

无意中在国外论坛发现一个gif动画类,我使用它来制作了一个动态验证码 : 一:首先新建一个类库 1:新建AnimatedGifEncoder类 using System; using System.C ...

- Google chrome的字体设置

http://blog.sina.com.cn/s/blog_a3b863da01016sv3.html 谷歌浏览器(Google chrome)速度很快,很好用.问题是字体显示有时候不对:用英文版的 ...

- Git教程之撤销修改(7)

自然,你是不会犯错的.不过现在是凌晨两点,你正在赶一份工作报告,你在readme.txt中添加了一行:

- 第一章 CLR的执行模型

编译器将源代码编译为托管模块.托管木块包含: PE32或PE32+头 CLR头 元数据 IL(中间语言)代码 PE32头的文件可在32或64位的电脑上运行,PE32+的只能在64上运行.Window6 ...

- sizeof(结构体)的计算

摘要: 经常被计算结构体的sizeof给搞晕,于是找了个时间,静下心来,搞定它. 一.为什么结构体计算这么乱? 答案是字节对齐,计算机存储系统中以Byte为单位存储数据,不同数据类型所占的空间不同,如 ...

- CSS那些事儿-阅读随笔2(选择符的组合与优先级/权重)

在知道了CSS选择符最基础的知识后,就要综合利用它们了.这里就记录几种常见的用法. 1.针对性的使用类选择符或者ID选择符 类选择符在一个页面中可能会在不同的地方应用,那么就需要有针对性地使用类选择符 ...

- No Hibernate Session bound to thread, and configuration does not allow

今天晚上挺悲催的,遇到了这个问题花费我很长时间,现在总结如下: 到这这种情况的发生有两种情况: 1,没有配置事物只要在Spring配置文件中添加如下代码: <bean id="txMa ...

- .net 测试工具类

fluentassertions QuickStart (替换Assert ) https://github.com/dennisdoomen/fluentassertions/wiki Moq ...

- 在Visual Studio 2010中使用DSL Tool特定领域开发 开篇

本来是很想写关于VS的DSL的文章的,有点小忙,就一直在拖延,忽然有看见了"<在Visual Studio 2012中使用VMSDK开发特定领域语言>",又有写的欲望了 ...

- jquery serialize()方法的扩展

Jquery提供的序列化表单方法serialize方法确实方便,但是我在使用的时候发现了一个弊端:当我使用type:“post”进行ajax请求的时候, 这个时候参数data:$("#myf ...