Attention篇(一)

主要是阅读以下博文的总结:

https://zhuanlan.zhihu.com/p/31547842

https://www.zhihu.com/question/68482809/answer/264632289

https://blog.csdn.net/thriving_fcl/article/details/73381217

https://kexue.fm/archives/4765

http://ir.dlut.edu.cn/news/detail/486

这篇主要讲的是soft-Attention

在不同的论文中Attention分为soft Attention 与Hard Attention、Global Attention和Local Attention以及Self Attention以及组合Attention中的层次化Attention等等

soft Attention的本质:

从概念上理解,把Attention仍然理解为从大量信息中有选择地筛选出少量重要信息并聚焦到这些重要信息上,忽略大多不重要的信息,这种思路仍然成立。聚焦的过程体现在权重系数的计算上,权重越大越聚焦于其对应的Value值上,即权重代表了信息的重要性,而Value是其对应的信息。

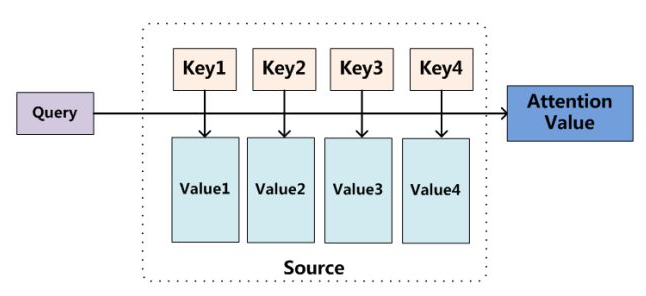

对其理解可以参考如图:

我们可以这样来看待Attention机制(参考上图):将Source中的构成元素想象成是由一系列的<Key,Value>数据对构成,此时给定Target中的某个元素Query,通过计算Query和各个Key的相似性或者相关性,得到每个Key对应Value的权重系数,然后对Value进行加权求和,即得到了最终的Attention数值。所以本质上Attention机制是对Source中元素的Value值进行加权求和,而Query和Key用来计算对应Value的权重系数。即可以将其本质思想改写为如下公式:

也可以将Attention机制看作一种软寻址(Soft Addressing):Source可以看作存储器内存储的内容,元素由地址Key和值Value组成,当前有个Key=Query的查询,目的是取出存储器中对应的Value值,即Attention数值。通过Query和存储器内元素Key的地址进行相似性比较来寻址,之所以说是软寻址,指的不像一般寻址只从存储内容里面找出一条内容,而是可能从每个Key地址都会取出内容,取出内容的重要性根据Query和Key的相似性来决定,之后对Value进行加权求和,这样就可以取出最终的Value值,也即Attention值。所以不少研究人员将Attention机制看作软寻址的一种特例,这也是非常有道理的。

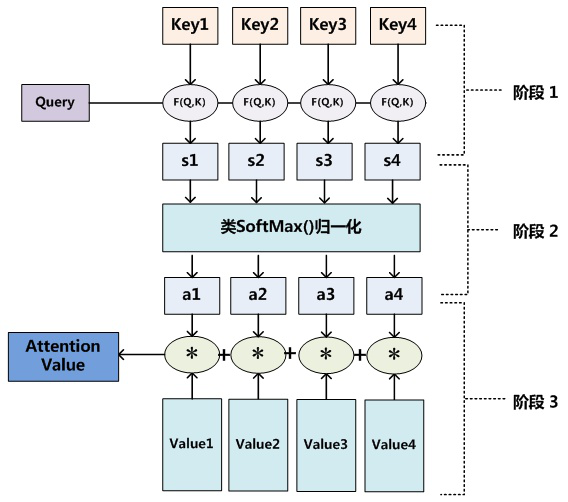

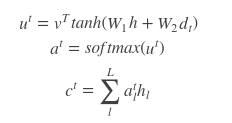

至于Attention机制的具体计算过程,如果对目前大多数方法进行抽象的话,可以将其归纳为两个过程:第一个过程是根据Query和Key计算权重系数,第二个过程根据权重系数对Value进行加权求和。而第一个过程又可以细分为两个阶段:第一个阶段根据Query和Key计算两者的相似性或者相关性;第二个阶段对第一阶段的原始分值进行归一化处理;这样,可以将Attention的计算过程抽象为如图展示的三个阶段:

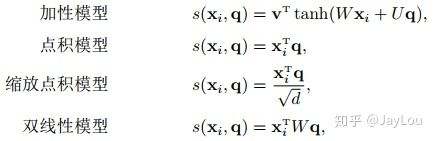

在第一个阶段,可以引入不同的函数和计算机制,根据Query和某个Key_i,计算两者的相似性或者相关性,最常见的方法包括:求两者的向量点积、求两者的向量Cosine相似性或者通过再引入额外的神经网络来求值,即如下方式:

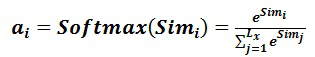

第一阶段产生的分值根据具体产生的方法不同其数值取值范围也不一样,第二阶段引入类似SoftMax的计算方式对第一阶段的得分进行数值转换,一方面可以进行归一化,将原始计算分值整理成所有元素权重之和为1的概率分布;另一方面也可以通过SoftMax的内在机制更加突出重要元素的权重。即一般采用如下公式计算:

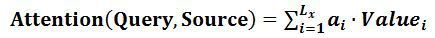

第二阶段的计算结果a_i即为value_i对应的权重系数,然后进行加权求和即可得到Attention数值:

通过如上三个阶段的计算,即可求出针对Query的Attention数值,目前绝大多数具体的注意力机制计算方法都符合上述的三阶段抽象计算过程。

Q,K,V理解以及运算:

上面提到的query与key之间计算相似度有许多方法,如dot、general、concat和MLP等方式,具体公式如下所示。而attention模型抽象为query、key和value之间的相似度计算,总共有3个阶段。第一阶段:query与keyi使用特定的相似度函数计算相似度,得到si;第二阶段:对si进行softmax()归一化得到ai;第三阶段,将ai与valuei对应相乘再求和,得到最终的attention value。其实对比传统的attention公式,我们可以看出,这两套公式还是很像的

分类模型中具体代码

#用的较多的乘性soft-attention

def attention(inputs, attention_size, time_major=False, return_alphas=False):

if isinstance(inputs, tuple):

# In case of Bi-RNN, concatenate the forward and the backward RNN outputs.

inputs = tf.concat(inputs, 2)

if time_major:

# (T,B,D) => (B,T,D)

inputs = tf.array_ops.transpose(inputs, [1, 0, 2])

hidden_size = inputs.shape[2].value # D value - hidden size of the RNN layer

# Trainable parameters

w_omega = tf.Variable(tf.random_normal([hidden_size, attention_size], stddev=0.1))

b_omega = tf.Variable(tf.random_normal([attention_size], stddev=0.1))

u_omega = tf.Variable(tf.random_normal([attention_size], stddev=0.1))

with tf.name_scope('v'):

# Applying fully connected layer with non-linear activation to each of the B*T timestamps;

# the shape of `v` is (B,T,D)*(D,A)=(B,T,A), where A=attention_size

v = tf.tanh(tf.tensordot(inputs, w_omega, axes=1) + b_omega)

# For each of the timestamps its vector of size A from `v` is reduced with `u` vector

#这里最后一维为1会自动进行维度删除

vu = tf.tensordot(v, u_omega, axes=1, name='vu') # (B,T) shape

alphas = tf.nn.softmax(vu, name='alphas') # (B,T) shape

# Output of (Bi-)RNN is reduced with attention vector; the result has (B,D) shape

output = tf.reduce_sum(inputs * tf.expand_dims(alphas, -1), 1)

if not return_alphas:

return output

else:

return output, alphas

从以上代码来看:

至于Attention机制的具体计算过程,如果对目前大多数方法进行抽象的话,可以将其归纳为两个过程:第一个过程是根据Query和Key计算权重系数,第二个过程根据权重系数对Value进行加权求和。而第一个过程又可以细分为两个阶段:第一个阶段根据Query和Key计算两者的相似性或者相关性,第二个阶段对第一阶段的原始分值进行归一化处理。

一些思考:

在文本分类中k、v都是网络层的输出,q是随机生成的向量。第一个过程的第一个阶段,会先后经过一次非线性变换和线性变换,其中的权重系数W都是随机的(为什么要这样做,考虑该如何获得各特征的重要程度,可以通过神经网络去学习,经过训练后的W会倾向于重要的特征);

attention其实就是学出一个权重分布,再拿这个权重分布施加在原来的特征之上,给重要的特征分布较大的权重,为不重要的特征分布较小的特征,以此来加大重要特征的影响。一方面在网络输出层后再加个attention是因为对于文本分类而言对于最后的类别而言不同的特征可能所起的作用不同。但是另一方面,在NLP中常用的LSTM其输出门就有一定的特征选择作用了,输出的为对类别决定性更大的特征,所以在LSTM后再加Attention似乎意义不大。

Attention设计之初用于seq2seq,较为典型的Attention为乘性Attention和加性Attention

对于Attention总结较好的文章:https://www.zhihu.com/question/68482809

Attention篇(一)的更多相关文章

- Attention篇(二)

主要是对<Attention is all you need>的分析 结合:http://www.cnblogs.com/robert-dlut/p/8638283.html 以及自己的 ...

- TGL站长关于常见问题的回复

问题地址: http://www.thegrouplet.com/thread-112923-1-1.html 问题: 网站配有太多的模板是否影响网站加载速度 月光答复: wp不需要删除其他的模板,不 ...

- Ajax完整篇(转载)

Ajax 完整教程 第 1 页 Ajax 简介Ajax 由 HTML.JavaScript™ 技术.DHTML 和 DOM 组成,这一杰出的方法可以将笨拙的 Web 界面转化成交互性的 Ajax 应用 ...

- (转)注意力机制(Attention Mechanism)在自然语言处理中的应用

注意力机制(Attention Mechanism)在自然语言处理中的应用 本文转自:http://www.cnblogs.com/robert-dlut/p/5952032.html 近年来,深度 ...

- 注意力机制(Attention Mechanism)在自然语言处理中的应用

注意力机制(Attention Mechanism)在自然语言处理中的应用 近年来,深度学习的研究越来越深入,在各个领域也都获得了不少突破性的进展.基于注意力(attention)机制的神经网络成为了 ...

- (转)Attention

本文转自:http://www.cosmosshadow.com/ml/%E7%A5%9E%E7%BB%8F%E7%BD%91%E7%BB%9C/2016/03/08/Attention.ht ...

- 论文笔记之:Attention For Fine-Grained Categorization

Attention For Fine-Grained Categorization Google ICLR 2015 本文说是将Ba et al. 的基于RNN 的attention model 拓展 ...

- SQL Server 服务器磁盘测试之SQLIO篇

原文:SQL Server 服务器磁盘测试之SQLIO篇 数据库调优工作中,有一部分是需要排查IO问题的,例如IO的速度或者RAID级别无法响应高并发下的快速请求.最常见的就是查看磁盘每次读写的响应速 ...

- Multimodal —— 看图说话(Image Caption)任务的论文笔记(三)引入视觉哨兵的自适应attention机制

在此前的两篇博客中所介绍的两个论文,分别介绍了encoder-decoder框架以及引入attention之后在Image Caption任务上的应用. 这篇博客所介绍的文章所考虑的是生成captio ...

随机推荐

- Pytorch数据类型转换

Pytorch数据类型转换 载入模块生成数据 import torch import numpy as np a_numpy = np.array([1,2,3]) Numpy转换为Tensor a_ ...

- 六、显式锁和AQS

显式锁和AQS 一.显式锁 Synchronized 关键字结合对象的监视器,JVM 为我们提供了一种『内置锁』的语义,这种锁很简便,不需要我们关心加锁和释放锁的过程,我们只需要告诉虚拟机哪些代码 ...

- APP兼容性测试(三)测试方案设计

1. 背景 App的兼容性问题可能会导致流失潜在的客户,为了尽量减少因兼容性问题导致的同类问题,进一步提高产品的质量,提升用户体验,所以进行兼容性测试,尽可能多的保证更多的用户都可以正常使用app. ...

- border和outline的区别

如果有一个需求,给一个元素增加一条边框,想必大家会习惯且娴熟的使用border来实现,我也是这样 但其实outline也能达到同样的效果,并且在有些场景下会更适用,比如下面的demo 使用bord ...

- mysql批量更新数据(性能优化)--第二种方式

Spring+Mybatis 手动控制事务 参考: https://blog.csdn.net/qq_41750175/article/details/87621170 public boolean ...

- Spring-@ControllerAdvice 拦截异常并统一处理

在spring 3.2中,新增了@ControllerAdvice 注解, 可以用于定义@ExceptionHandler.@InitBinder.@ModelAttribute,并应用到所有@Req ...

- 机器学习(十一)-------- 异常检测(Anomaly Detection)

异常检测(Anomaly Detection) 给定数据集

- NET 判断是否为回文

比如: 12321,第一位等于第五位,第二位等于第四位 /// <summary> /// 判断是否为回文 /// 比如:12321,第一位等于第五位,第二位等于第四位 /// </ ...

- js、jquery、css属性及出错集合

*)注意使用jquery设置css的语法 css("propertyname","value");#单个时时逗号 css({"propertyname ...

- Python【day 11】函数名的应用

函数名的应用 1.函数名字可以作为参数进行传递 2.函数名可以像变量一样进行多次赋值传递,通过print(函数名.__name__)查看原函数 3.函数名表示函数的内存地址 4.函数名()表示函数的执 ...