knn算法详解

邻近算法,或者说K最近邻(kNN,k-NearestNeighbor)分类算法是数据挖掘分类技术中最简单的方法之一。所谓K最近邻,就是k个最近的邻居的意思,说的是每个样本都可以用它最接近的k个邻居来代表。判断邻居就是用向量距离大小来刻画。

一张必不可少的图

一张必不可少的图算法流程

缺点

import numpy as np

import matplotlib.pyplot as plt #绘图

import pandas as pd

再导入数据集

以excel格式为例,我的iris目标文件存储在

"D://test_knn"中

url = "D://test_knn./iris.csv" #url path # Assign column names to the dataset

names = ['sepal-length', 'sepal-width', 'petal-length', 'petal-width', 'Class'] # Read dataset to pandas dataframe

dataset = pd.read_csv(url, names=names)

可以用下面函数检验导入是否成功

dataset.head() #默认读取前五行

输出结果如下:

sepal-length sepal-width petal-length petal-width Class

0 5.1 3.5 1.4 0.2 Iris-setosa

1 4.9 3.0 1.4 0.2 Iris-setosa

2 4.7 3.2 1.3 0.2 Iris-setosa

3 4.6 3.1 1.5 0.2 Iris-setosa

4 5.0 3.6 1.4 0.2 Iris-setosa

2.Preprocessing the dataset 数据预处理

x= dataset.iloc[:, :-1].values #x 属性

#第一个冒号是所有列,第二个是所有行,除了最后一个(Purchased) y = dataset.iloc[:, 4].values #y 标签

# 只取最后一个作为依赖变量。

3.Train Test Split

把数据划分成训练集和测试集

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.20)

80%的数据划分到训练集,20%的数据划分到测试集

4.Feature scaling

from sklearn.preprocessing import StandardScaler #导入库 这个不知道可以去查查用法

scaler = StandardScaler()

scaler.fit(X_train) X_train = scaler.transform(X_train)

X_test = scaler.transform(X_test)

5.Training and Predictions 训练预测

from sklearn.neighbors import KNeighborsClassifier

classifier = KNeighborsClassifier(n_neighbors=5) # k=5

classifier.fit(X_train, y_train)

y_pred=classifier.predict(X_test)

6.Evaluating the algorithm

from sklearn.metrics import classification_report, confusion_matrix

print(confusion_matrix(y_test, y_pred))

print(classification_report(y_test, y_pred))

预期输出结果如下:

The output of the above script looks like this:

[[11 0 0]

0 13 0]

0 1 6]]

precision recall f1-score support Iris-setosa 1.00 1.00 1.00 11

Iris-versicolor 1.00 1.00 1.00 13

Iris-virginica 1.00 1.00 1.00 6

avg/total 1.00 1.00 1.00 30

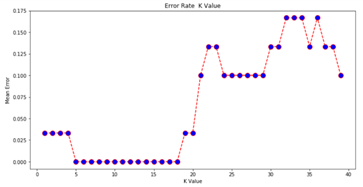

7.Comparing Error Rate with the K Value

把各种可能的k的取值,及其对应的分类误差率(error rate)绘制在一张图上。

error = [] # Calculating error for K values between 1 and 40

for i in range(1, 40):

knn = KNeighborsClassifier(n_neighbors=i)

knn.fit(X_train, y_train)

pred_i = knn.predict(X_test)

error.append(np.mean(pred_i != y_test))

plt.figure(figsize=(12, 6))

plt.plot(range(1, 40), error, color='red', linestyle='dashed', marker='o',

markerfacecolor='blue', markersize=10)

plt.title('Error Rate K Value')

plt.xlabel('K Value')

plt.ylabel('Mean Error')

输出结果预期如下:

至此, 这套knn算法就实现了,现在体会到python工具包的强大了,好多底层的算法都不需要自己写函数实现。

搜了一下用C实现knn,代码很繁琐,但是很直观,每一步干什么很清楚。python写的话呢,如果对这些库不熟悉,那就很头秃了,需要一个一个函数查它的用法,不过,如果真的掌握了可以更快更轻松地实现。就是这样子了!

刚开始做的时候看到一堆代码,一脸懵逼,感觉在看文言文一样。其实只要耐心看,真的只是了解一点库函数用法,算法本身思想很简单!

第一个机器学习算法笔记,开心!

knn算法详解的更多相关文章

- 算法代码[置顶] 机器学习实战之KNN算法详解

改章节笔者在深圳喝咖啡的时候突然想到的...之前就有想写几篇关于算法代码的文章,所以回家到以后就奋笔疾书的写出来发表了 前一段时间介绍了Kmeans聚类,而KNN这个算法刚好是聚类以后经常使用的匹配技 ...

- 机器学习-KNN算法详解与实战

最邻近规则分类(K-Nearest Neighbor)KNN算法 1.综述 1.1 Cover和Hart在1968年提出了最初的邻近算法 1.2 分类(classification)算法 1.3 输入 ...

- 机器学习-K近邻(KNN)算法详解

一.KNN算法描述 KNN(K Near Neighbor):找到k个最近的邻居,即每个样本都可以用它最接近的这k个邻居中所占数量最多的类别来代表.KNN算法属于有监督学习方式的分类算法,所谓K近 ...

- BM算法 Boyer-Moore高质量实现代码详解与算法详解

Boyer-Moore高质量实现代码详解与算法详解 鉴于我见到对算法本身分析非常透彻的文章以及实现的非常精巧的文章,所以就转载了,本文的贡献在于将两者结合起来,方便大家了解代码实现! 算法详解转自:h ...

- kmp算法详解

转自:http://blog.csdn.net/ddupd/article/details/19899263 KMP算法详解 KMP算法简介: KMP算法是一种高效的字符串匹配算法,关于字符串匹配最简 ...

- 机器学习经典算法详解及Python实现--基于SMO的SVM分类器

原文:http://blog.csdn.net/suipingsp/article/details/41645779 支持向量机基本上是最好的有监督学习算法,因其英文名为support vector ...

- [转] KMP算法详解

转载自:http://www.matrix67.com/blog/archives/115 KMP算法详解 如果机房马上要关门了,或者你急着要和MM约会,请直接跳到第六个自然段. 我们这里说的K ...

- 【转】AC算法详解

原文转自:http://blog.csdn.net/joylnwang/article/details/6793192 AC算法是Alfred V.Aho(<编译原理>(龙书)的作者),和 ...

- KMP算法详解(转自中学生OI写的。。ORZ!)

KMP算法详解 如果机房马上要关门了,或者你急着要和MM约会,请直接跳到第六个自然段. 我们这里说的KMP不是拿来放电影的(虽然我很喜欢这个软件),而是一种算法.KMP算法是拿来处理字符串匹配的.换句 ...

随机推荐

- 【THUSC2017】【LOJ2982】宇宙广播 计算几何 高斯消元

题目大意 有 \(n\) 个 \(n\) 维空间中的球,求这些球的所有公切面. 保证不会无解或有无穷多组解. \(n\leq 10\) 题解 你可以认为这是一道传统题. 记公切面为 \(a_1x_1+ ...

- Linux中查看TCP连接数

一.查看哪些IP连接本机 netstat -an 二.查看TCP连接数 1)统计80端口连接数netstat -nat|grep -i "80"|wc -l 2)统计httpd协议 ...

- LOJ#2244 起床困难综合症

解:m = 0的部分分,直接模拟.有and 0的部分分,直接模拟.<=1000的部分分,枚举攻击力之后模拟.所有操作相同的部分分,可以合并成只有一个操作.然后枚举m或者逐位贪心. 正解是逐位贪心 ...

- Nacos集群环境的搭建与配置

Nacos集群环境的搭建与配置 集群搭建 一.环境: 服务器环境:CENTOS-7.4-64位 三台服务器IP:192.168.102.57:8848,192.168.102.59:8848,192. ...

- IIS 常用命令

Ø 简介 本文主要介绍 IIS 常用的命令,主要包含以下内容: 1. IIS 重启方法 2. 站点重启方法 3. 应用程序池重启方法 1. IIS 重启方法 1) 重启 IIS ...

- design language

design language https://en.wikipedia.org/wiki/Design_language 设计语言(设计词汇)是一种超架构的方案和风格, 它用于指导产品组件或者架构配 ...

- 利用JS写一个计算平方的网页

<!-- 计算一个数的平方并显示出来 --> <!DOCTYPE html> <html> <head> <meta charset=" ...

- springBoot和Mybatis输出sql日志

利用slf4j来输出日志. 首先需要版本兼容的slf4j-log4j12.log4j.slf4j-api.slf4j-nop.slf4j-simple这5个包. 可以去maven知识库中找到这5个包的 ...

- 题解 P3871 【[TJOI2010]中位数】

orz各位大佬,题解太强了,主席树,堆,线段树,splay,还有暴力,太巨了.所以我用的是fhq treap(好像更高级).算了. 反正都是平衡树,这道题就是动态求中位数,不会做的同学可以先做弱化版P ...

- mui框架中dialog框的实现

<script type="text/javascript" charset="utf-8"> //mui初始化 mui.init({ swipeB ...