大数据笔记(二)——Apache Hadoop的体系结构

一.分布式存储

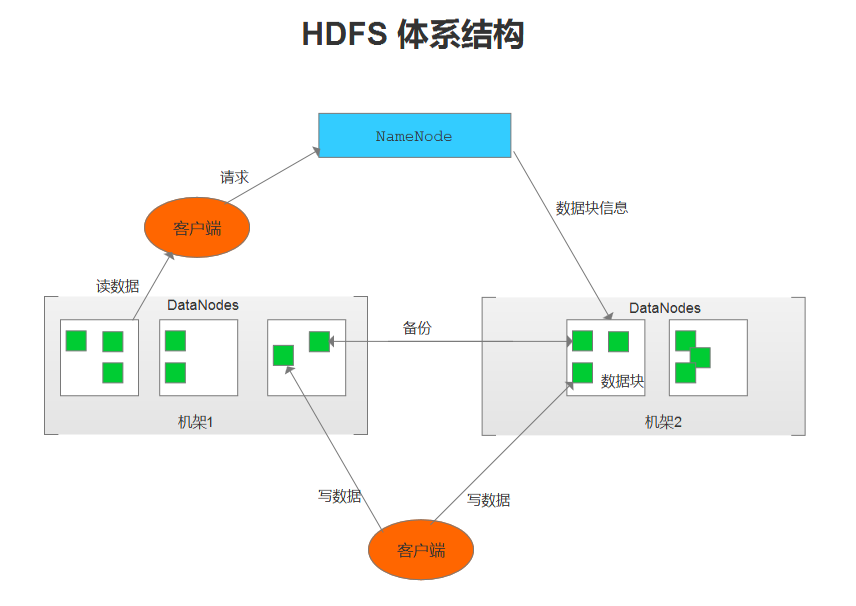

- NameNode(名称节点)

1.维护HDFS文件系统,是HDFS的主节点。

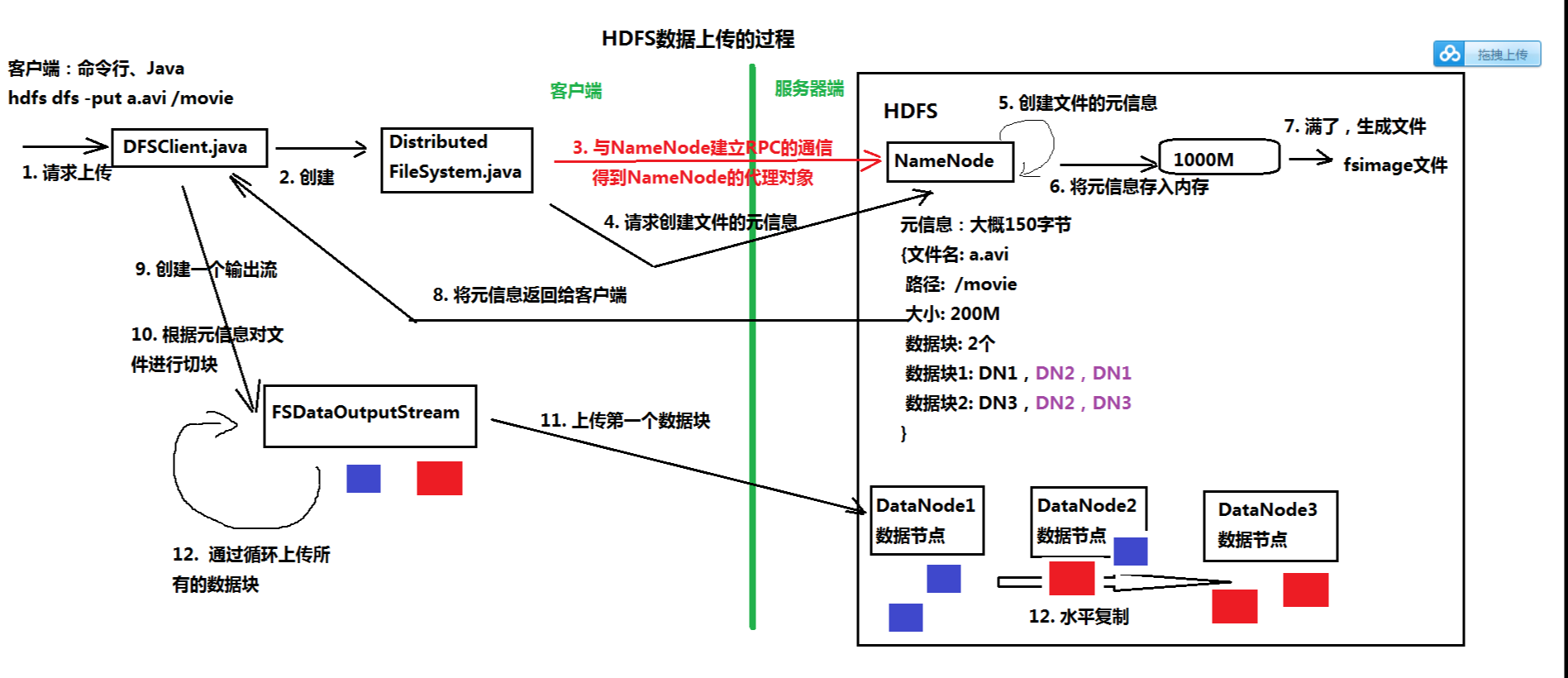

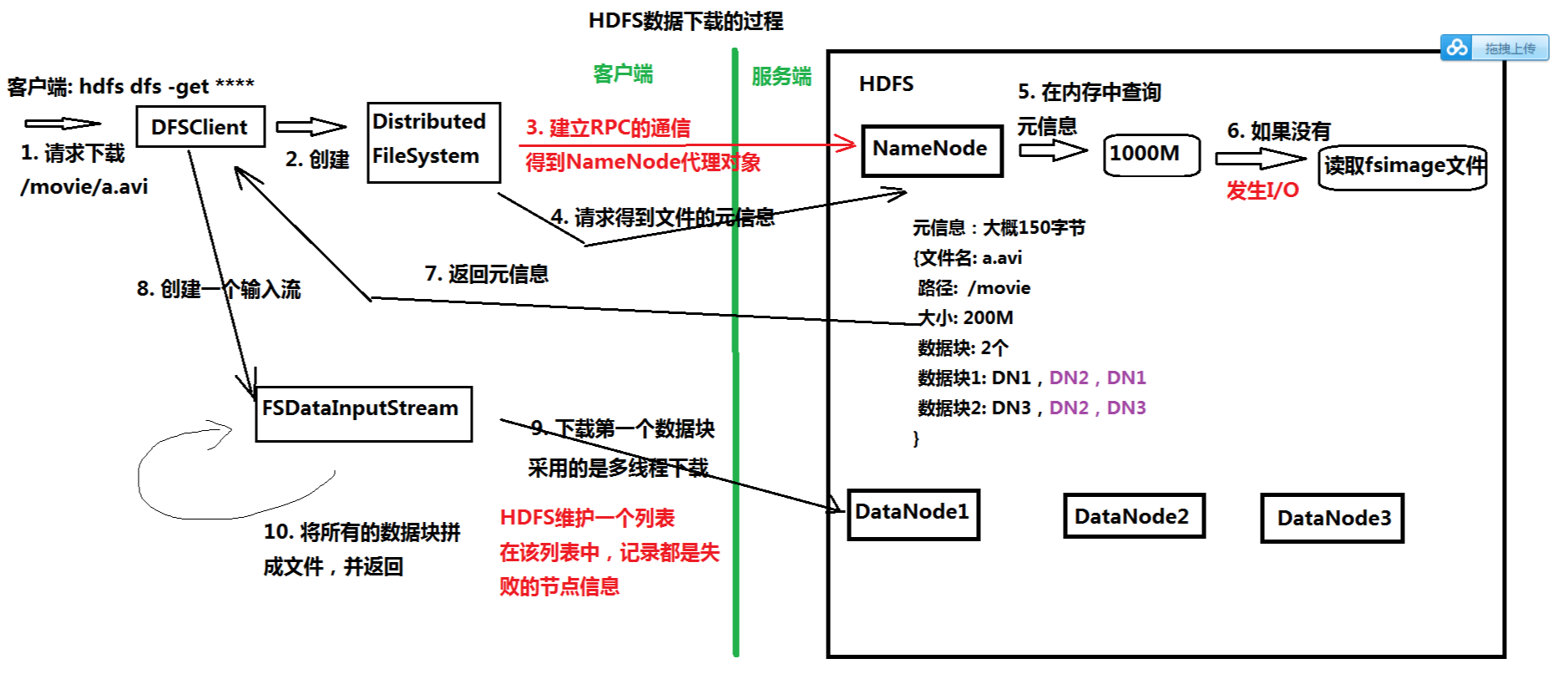

2.接收客户端的请求:上传、下载文件、创建目录等。

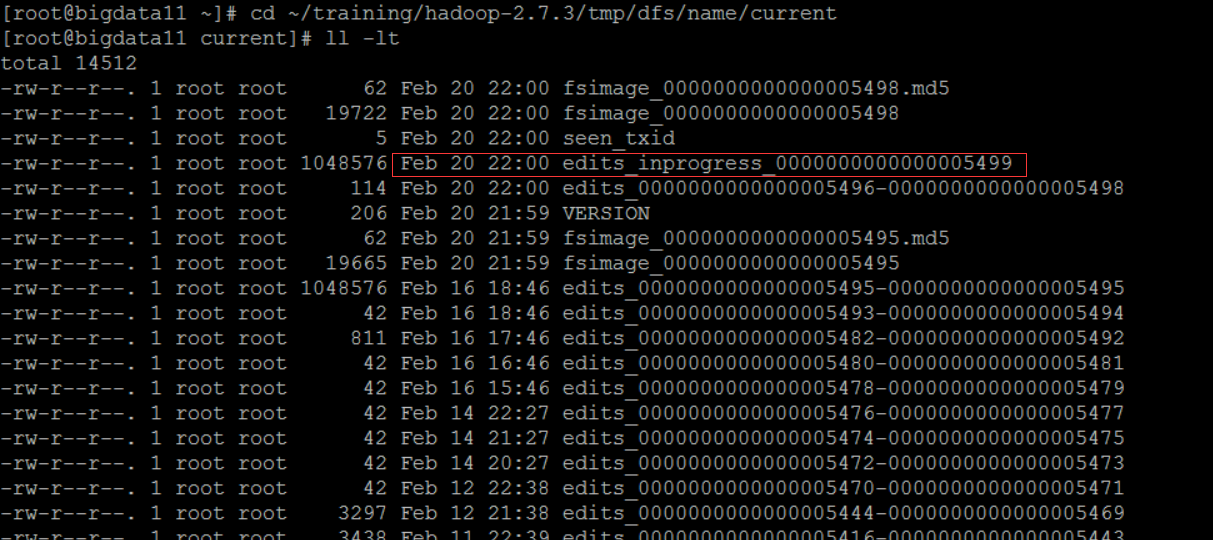

3.记录客户端操作的日志(edits文件),保存了HDFS最新的状态

1)Edits文件保存了自最后一次检查点之后所有针对HDFS文件系统的操作,比如:增加文件、重命名文件、删除目录等

2)保存目录:$HADOOP_HOME/tmp/dfs/name/current

可以使用 hdfs oev -i 命令将日志(二进制)输出为 XML文件

hdfs oev -i edits_inprogress_0000000000000005499 -o ~/temp/log.xml

4.维护文件元信息,将内存中不常用的文件元信息保存在硬盘上(fsimage文件)

1)fsimage是HDFS文件系统存于硬盘中的元数据检查点,里面记录了自最后一次检查点之前HDFS文件系统中所有目录和文件的序列化信息

2)保存目录:edits

3)可以使用 hdfs oev -i 命令将日志(二进制)输出为 XML文件

- DataNode(数据节点)

1.以数据块为单位,保存数据

1)Hadoop1.0的数据块大小:64M

2)Hadoop2.0的数据库大小:128M

2.在全分布模式下,至少两个DataNode节点

3.数据保存的目录:由 hadoop.tmp.dir 参数指定

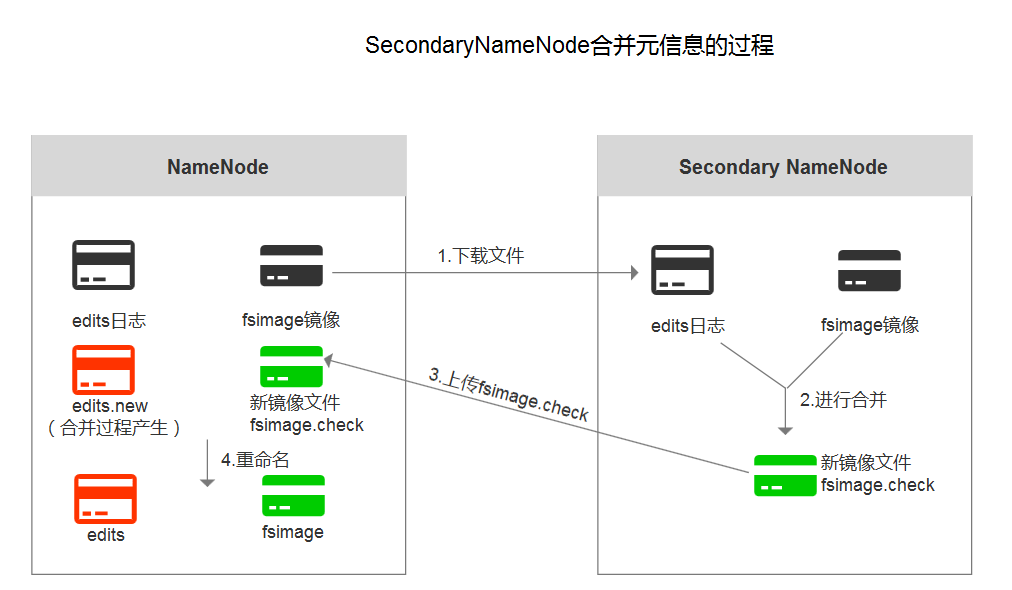

- Secondary NameNode(第二名称节点)

1.主要作用:合并日志

2.合并时机:HDFS发出检查点的时候

3.日志合并过程:

- HDFS存在的问题

1)NameNode单点故障问题

解决方案:Hadoop2.0中,使用Zookeeper实现NameNode的HA功能

2)NameNode压力过大,且内存受限,影响系统扩展性

解决方案:Hadoop2.0中,使用NameNode联盟实现水平扩展

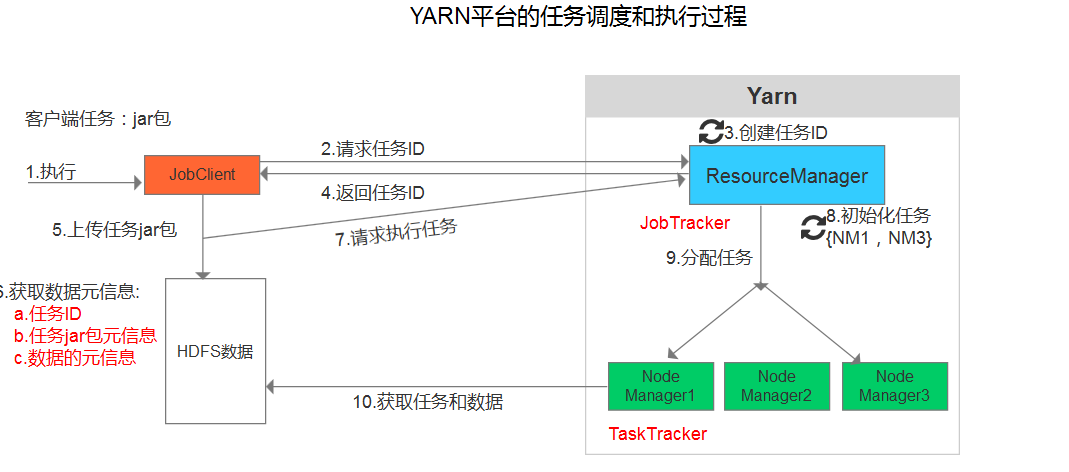

二.YARN:分布式计算(MapReduce)

- ResourceManager(资源管理器)

1.接收客户端的请求,执行任务

2.分配资源

3.分配任务

- NodeManager(节点管理器:运行任务 MapReduce)

从 DataNode上获取数据,执行任务

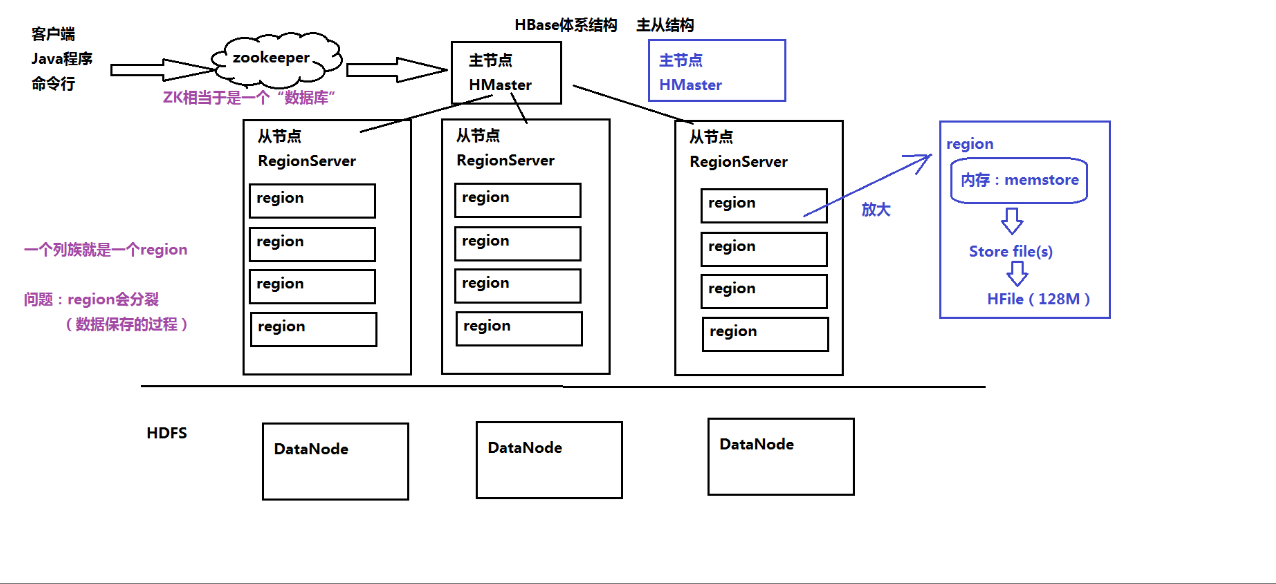

三.HBase的体系结构

大数据笔记(二)——Apache Hadoop的体系结构的更多相关文章

- 大数据笔记13:Hadoop安装之Hadoop的配置安装

1.准备Linux环境 1.0点击VMware快捷方式,右键打开文件所在位置 -> 双击vmnetcfg.exe -> VMnet1 host-only ->修改subnet ip ...

- 大数据软件安装之Hadoop(Apache)(数据存储及计算)

大数据软件安装之Hadoop(Apache)(数据存储及计算) 一.生产环境准备 1.修改主机名 vim /etc/sysconfig/network 2.修改静态ip vim /etc/udev/r ...

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

引言 在之前的大数据学习系列中,搭建了Hadoop+Spark+HBase+Hive 环境以及一些测试.其实要说的话,我开始学习大数据的时候,搭建的就是集群,并不是单机模式和伪分布式.至于为什么先写单 ...

- 玩转大数据系列之Apache Pig高级技能之函数编程(六)

原创不易,转载请务必注明,原创地址,谢谢配合! http://qindongliang.iteye.com/ Pig系列的学习文档,希望对大家有用,感谢关注散仙! Apache Pig的前世今生 Ap ...

- 大数据平台搭建(hadoop+spark)

大数据平台搭建(hadoop+spark) 一.基本信息 1. 服务器基本信息 主机名 ip地址 安装服务 spark-master 172.16.200.81 jdk.hadoop.spark.sc ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

- 大数据学习系列之六 ----- Hadoop+Spark环境搭建

引言 在上一篇中 大数据学习系列之五 ----- Hive整合HBase图文详解 : http://www.panchengming.com/2017/12/18/pancm62/ 中使用Hive整合 ...

- 阿里巴巴飞天大数据架构体系与Hadoop生态系统

很多人问阿里的飞天大数据平台.云梯2.MaxCompute.实时计算到底是什么,和自建Hadoop平台有什么区别. 先说Hadoop 什么是Hadoop? Hadoop是一个开源.高可靠.可扩展的分布 ...

- 决战大数据之二:CentOS 7 最新JDK 8安装

决战大数据之二:CentOS 7 最新JDK 8安装 [TOC] 修改hostname # hostnamectl set-hostname node1 --static # reboot now 重 ...

- 大数据实时计算工程师/Hadoop工程师/数据分析师职业路线图

http://edu.51cto.com/roadmap/view/id-29.html http://my.oschina.net/infiniteSpace/blog/308401 大数据实时计算 ...

随机推荐

- 【监控笔记】【1.4】Pssdiag和Sqldiag管理器

--没有实操过,有点复杂,先写上以后有用到再深入研究 统计与诊断数据是任何 SQL故障修复工作的关键所在. 如果没有掌握这些数据,就无法确定数据性能问题的根源.数据表的瓶颈可能并不是由索引问题造成的: ...

- java基础笔记(8)

java的多线程 进程:程序的执行过程,持有内存资源 线程:是系统的最小执行单元,共享进程的资源 线程之间可以互斥.也可以同步: Thraed类: 通过一个案例来了解线程Thread类和Runnabl ...

- [BZOJ 3930] [CQOI 2015]选数(莫比乌斯反演+杜教筛)

[BZOJ 3930] [CQOI 2015]选数(莫比乌斯反演+杜教筛) 题面 我们知道,从区间\([L,R]\)(L和R为整数)中选取N个整数,总共有\((R-L+1)^N\)种方案.求最大公约数 ...

- [LeetCode] 135. 分发糖果

题目链接 : https://leetcode-cn.com/problems/candy/ 题目描述: 老师想给孩子们分发糖果,有 N 个孩子站成了一条直线,老师会根据每个孩子的表现,预先给他们评分 ...

- 深入理解 JavaScript中的变量、值、传参

1. demo 如果你对下面的代码没有任何疑问就能自信的回答出输出的内容,那么本篇文章就不值得你浪费时间了. var var1 = 1 var var2 = true var var3 = [1,2, ...

- mac安装卸载brew

1.安装 访问https://brew.sh,copy图中的命令到命令行中,进行下载安装 2.卸载 官方版本的卸载: /usr/bin/ruby -e "$(curl -fsSL https ...

- sass和less的对比

); < { ; { { ; } ); } ); } ); // if 条件 @dr: if(@my-option = true, { button { ...

- Nginx的端口修改问题

转自:https://www.cnblogs.com/fengyuhuawu/p/7867728.html 修改 nginx.conf 文件实现. 在 Linux 上该文件的路径为 /usr/loca ...

- PAT Basic 1041 考试座位号 (15 分)

每个 PAT 考生在参加考试时都会被分配两个座位号,一个是试机座位,一个是考试座位.正常情况下,考生在入场时先得到试机座位号码,入座进入试机状态后,系统会显示该考生的考试座位号码,考试时考生需要换到考 ...

- Linux日常之定时向文件传内容

一. Linux中定时执行任务使用的命令是crontab 流程如下: 1. 使用命令crontab -e进入编辑界面 2. [Ctrl]+X进行保存退出 3. 重启crontab服务,这样才可以生效, ...