BS4爬取豆瓣电影

爬取豆瓣top250部电影

####创建表:

#connect.py

from sqlalchemy import create_engine

# HOSTNAME='localhost'

# PORT='3306'

# USERNAME='root'

# PASSWORD='123456'

# DATABASE='douban'

db_url='mysql+pymysql://root:123456@localhost:3306/douban?charset=utf8'

engine=create_engine(db_url)

#创建映像

from sqlalchemy.ext.declarative import declarative_base

Base=declarative_base(engine)

#创建会话

from sqlalchemy.orm import sessionmaker

Session=sessionmaker(engine)

session=Session()

##################创建表

from sqlalchemy import Column,String,Integer,DateTime

from datetime import datetime

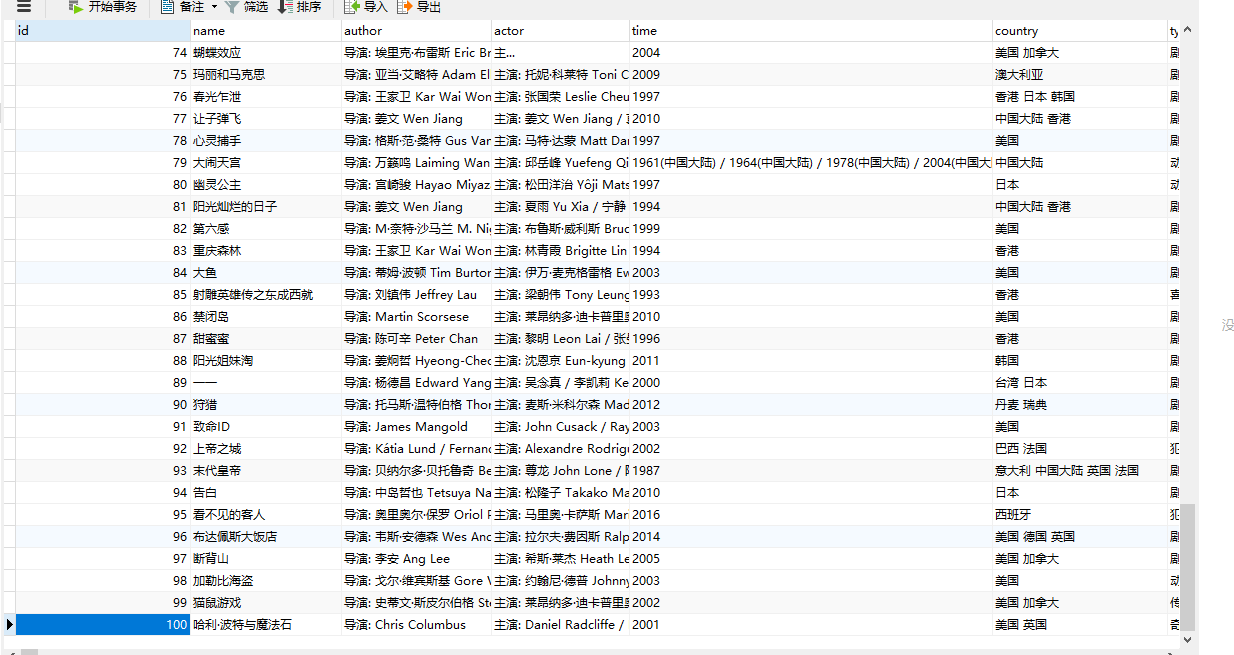

class Douban(Base):

__tablename__='douban'

id=Column(Integer,primary_key=True,autoincrement=True)

name=Column(String(50))

author=Column(String(100),nullable=True)

actor=Column(String(100))

time=Column(String(50))

country=Column(String(100))

type=Column(String(100))

createtime=Column(DateTime,default=datetime.now)

def __repr__(self):

return '<Douban(id=%s,name=%s,author=%s,actor=%s,time=%s,country=%s,type=%s,createtime=%s)>'%(

self.id,

self.name,

self.author,

self.actor,

self.time,

self.country,

self.type,

self.creatime

)

if __name__=='__main__':

Base.metadata.create_all()

# user=Douban()

# user.type='你好'

# user.country='你'

# user.author='666'

# user.actor='你好啊'

# session.add(user)

# session.commit()

###爬取数据并保存到数据库:

#douban.py

import requests,re

from bs4 import BeautifulSoup

import time,datetime

# import pymysql

# conn=pymysql.connect(host='127.0.0.1',user='root',passwd='123456',db='mysql',charset='utf8')

# cur=conn.cursor()

# cur.execute('use douban;')

# cur.execute("insert into douban.douban(author,actor,country) VALUES('aa','bb','bb')")

# conn.commit()

#导入sqlalchemy

from connect import Douban,session

headers={'Referer':'https://movie.douban.com/explore',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; '

'WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36'}

def get_html(x):

num = 0

for n in range(x+1):

url='https://movie.douban.com/top250?start=%s&filter='%(n*25)

html=requests.get(url,headers=headers).text

soup=BeautifulSoup(html,'lxml')

# print(type(soup))

content_all=soup.select('div[class="item"]')

for m in content_all:

num+=1

title=m.select('span[class="title"]')[0].string

print(title)

content=m.select('div[class="bd"] > p[class=""]')[0]

#返回字符串迭代器

text=content.stripped_strings

li = []

for i in text:

i=str(i)

# print(i)

li.append(i)

print(li)

#获取演员和国家列表

author_list=li[0].split('\xa0\xa0\xa0')

country_list=li[1].split('\xa0/\xa0')

# print(author_list)

# print(country_list)

#从列表取出数据

author=author_list[0]

actor=author_list[1]

time=country_list[0]

country=country_list[1]

type=country_list[2]

print(author)

print(actor)

print(time)

print(country,type+'\n\n')

print('总共获取%s' % num)

#第一种插入方式特别注意,此处用单双引号来区分内容,且%s要加引号,否则会报错

# sql="insert into douban(name,author,actor,time,country,type) VALUES('%s','%s','%s','%s','%s','%s')"%(

# title,

# author,

# actor,

# time,

# country,

# type

# )

# cur.execute(sql)

# conn.commit()

### 第二种插入方法,使用sqlalchemy插入

data=Douban(name=title,

author=author,

actor=actor,

#字符串格式需转换成日期格式

time=time,

# time=datetime.strptime(time,'%Y')

country=country,

type=type,

)

session.add(data)

session.commit()

if __name__=='__main__':

x=input('输入数字:')

x=int(x)

get_html(x)

# conn.close()

BS4爬取豆瓣电影的更多相关文章

- urllib+BeautifulSoup无登录模式爬取豆瓣电影Top250

对于简单的爬虫任务,尤其对于初学者,urllib+BeautifulSoup足以满足大部分的任务. 1.urllib是Python3自带的库,不需要安装,但是BeautifulSoup却是需要安装的. ...

- python2.7爬取豆瓣电影top250并写入到TXT,Excel,MySQL数据库

python2.7爬取豆瓣电影top250并分别写入到TXT,Excel,MySQL数据库 1.任务 爬取豆瓣电影top250 以txt文件保存 以Excel文档保存 将数据录入数据库 2.分析 电影 ...

- Python开发爬虫之静态网页抓取篇:爬取“豆瓣电影 Top 250”电影数据

所谓静态页面是指纯粹的HTML格式的页面,这样的页面在浏览器中展示的内容都在HTML源码中. 目标:爬取豆瓣电影TOP250的所有电影名称,网址为:https://movie.douban.com/t ...

- 爬取豆瓣电影排行top250

功能描述V1.0: 爬取豆瓣电影排行top250 功能分析: 使用的库 1.time 2.json 3.requests 4.BuautifulSoup 5.RequestException 上机实验 ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- python 爬取豆瓣电影评论,并进行词云展示及出现的问题解决办法

本文旨在提供爬取豆瓣电影<我不是药神>评论和词云展示的代码样例 1.分析URL 2.爬取前10页评论 3.进行词云展示 1.分析URL 我不是药神 短评 第一页url https://mo ...

- Python爬取豆瓣电影top

Python爬取豆瓣电影top250 下面以四种方法去解析数据,前面三种以插件库来解析,第四种以正则表达式去解析. xpath pyquery beaufifulsoup re 爬取信息:名称 评分 ...

- python 爬取豆瓣电影短评并wordcloud生成词云图

最近学到数据可视化到了词云图,正好学到爬虫,各种爬网站 [实验名称] 爬取豆瓣电影<千与千寻>的评论并生成词云 1. 利用爬虫获得电影评论的文本数据 2. 处理文本数据生成词云图 第一步, ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

随机推荐

- scrapy笔记2

cookies的使用: 使用 scrapy.http.cookie.CookieJar 类的extract_cookies方法,CookieJar._cookies就是我们需要的cookies,是一个 ...

- scala高级性质-隐式转换 -02

今天我们来介绍scala的高级特性,上次已经介绍过他的一个特性:高阶函数,这次是隐式转换 1.隐式转换的例子 read的例子 解析:发现这个file没有read的方法,然后就开始在开始在这个上下文里面 ...

- Java文件 ---RandomAccessFile示例

RandomAccessFile是用来访问那些保存数据记录的文件的,你就可以用seek( )方法来访问记录,并进行读写了.这些记录的大小不必相同:但是其大小和位置必须是可知的.但是该类仅限于操作文件 ...

- luoguP1726 上白泽慧音

P1726 上白泽慧音 题目描述 在幻想乡,上白泽慧音是以知识渊博闻名的老师.春雪异变导致人间之里的很多道路都被大雪堵塞,使有的学生不能顺利地到达慧音所在的村庄.因此慧音决定换一个能够聚集最多人数的村 ...

- Java 虚拟机结构分析

本博文主要介绍了JVM(Java Virtual Machine)的组成部分以及它们内部的工作机制和原理.需要注意的是,虽然平时我们用的大多是Sun(现已被Oracle收购)JDK提供的JVM,但是J ...

- Android通过用代码画虚线椭圆边框背景来学习一下shape的用法

在Android程序开发中,我们经常会去用到Shape这个东西去定义各种各样的形状,shape可以绘制矩形环形以及椭圆,所以只需要用椭圆即可,在使用的时候将控件比如imageview或textview ...

- finally在return之后还是之前运行

finally在运行前打印出来是return的数据,finally是最后修改的数据,如果finally存在对返回值的修改,则以finally修改的值为准. 综上所述,finally最后运行.

- Python全栈(一)编程语言介绍

一.编程语言介绍 程序是计算机能读懂的语言,是人和计算机沟通的方式. 计算机无法理解符号,只能理解0,1的二进制. 计算机内的运行状态就像灯泡的开关一样来表示各庄状态,两个灯泡能表示4种状态,无数的灯 ...

- Rbac_权限管理

click!!! https://github.com/ugfly1210/rbac_100 有关于 rbac 的所有代码,包括 README. 用户和角色 : 多对多字段放在哪张表更好点? 用户找角 ...

- 如何在乌班图上配置java开发环境

不想说的那么细,每条命令都说一下,在现在这个浮躁的时代,很少有人能看的下去,我就直接上命令,最简单的快捷的方式. 1:安装软件 2:设置root密码 3:配置mysql远程登录 4:安装java运行环 ...