Python 爬虫 ajax爬取马云爸爸微博内容

ajax爬取情况

有时候我们在用 Requests 抓取页面的时候,得到的结果可能和在浏览器中看到的是不一样的,在浏览器中可以看到正常显示的页面数据,但是使用 Requests 得到的结果并没有,这其中的原因是 Requests 获取的都是原始的 HTML 文档,而浏览器中的页面则是页面又经过 JavaScript 处理数据后生成的结果,这些数据的来源有多种,可能是通过 Ajax 加载的,可能是包含在了 HTML 文档中的,也可能是经过 JavaScript 经过特定算法计算后生成的

项目代码如下

import requests

from fake_useragent import UserAgent

from pyquery import PyQuery

from urllib.parse import urlencode

from requests.packages import urllib3

from pymongo import MongoClient # 关闭警告

urllib3.disable_warnings() base_url = 'https://m.weibo.cn/api/container/getIndex?' # 激活本地MongoDB客户端

client = MongoClient('localhost',27001)

# 创建数据库

pages = client['pages']

# 创建集合

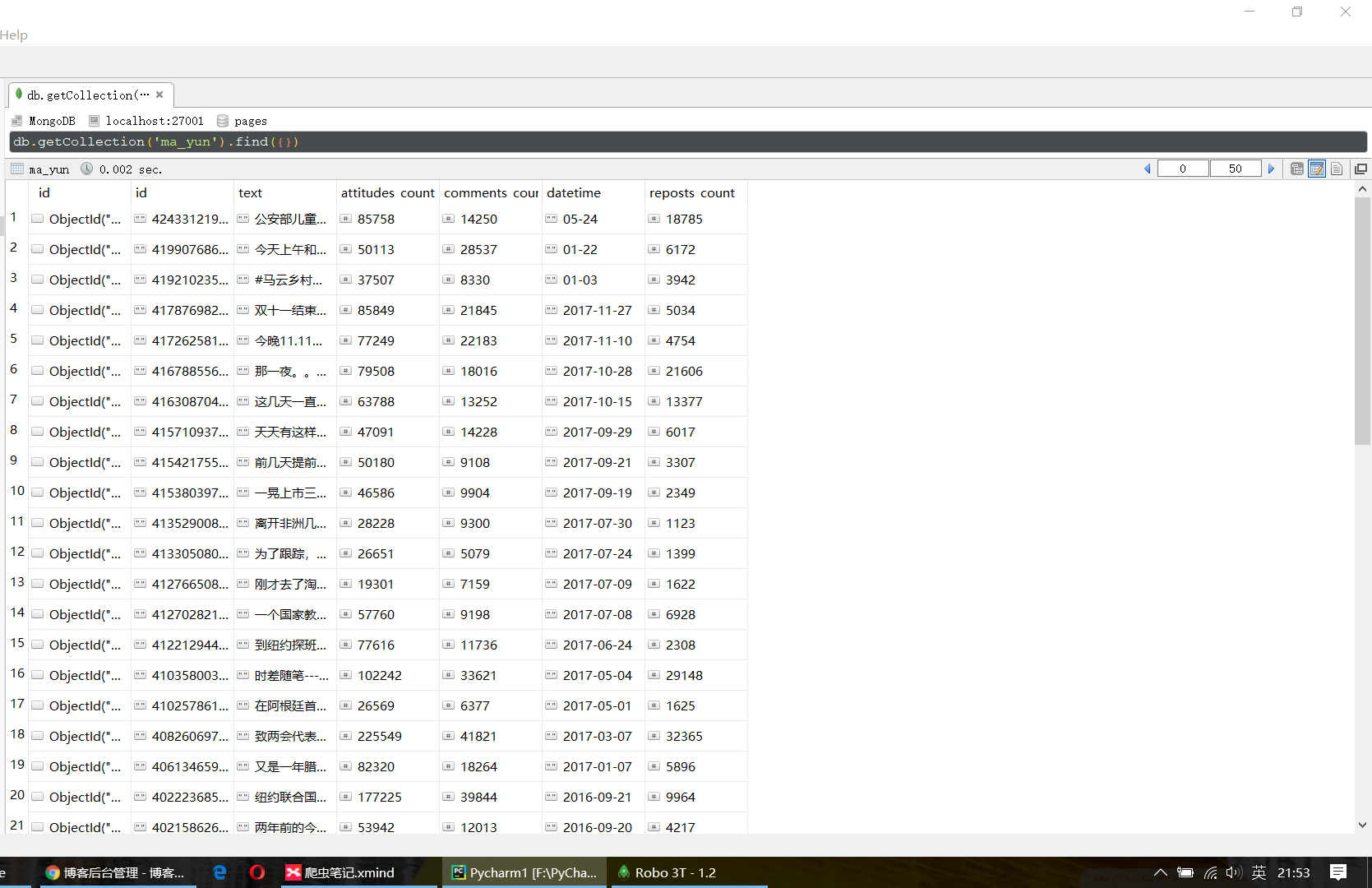

ma_yun = pages['ma_yun'] # 保存到mongoDB中

def save_to_mongo(result):

if ma_yun.insert_one(result):

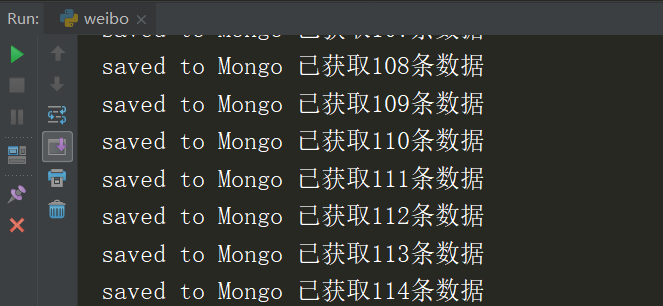

print('saved to Mongo','已获取{number}条数据'.format(number=ma_yun.count())) # 生成UA

def create_user_agent():

ua = UserAgent(use_cache_server=False)

# print(ua.chrome)

return ua.chrome # 生成headers

def create_headers():

headers = {

'User-Agent': create_user_agent()

}

return headers # 获取页面

def get_page(page):

# 设置参数

params = {

'sudaref':'germey.gitbooks.io',

'display':'',

'retcode':'',

'type':'uid',

'value':'',

'containerid':'',

'page':page

}

url = base_url + urlencode(params)

try:

response = requests.get(url,create_headers(),verify=False)

if response.status_code == 200:

return response.json()

except requests.ConnectionError as e:

print('Error',e.args) # 解析页面

def parse_page(json):

if json:

items = json.get('data').get('cards')

if items != None:

for item in items:

item = item.get('mblog')

weibo = {}

weibo['id'] = item.get('id')

# 将正文中的 HTML 标签去除掉

weibo['text'] = PyQuery(item.get('text')).text()

# 点赞数

weibo['attitudes_count'] = item.get('attitudes_count')

# 评论数

weibo['comments_count'] = item.get('comments_count')

# 发布时间

weibo['datetime'] = item.get('created_at')

# 转发数

weibo['reposts_count'] = item.get('reposts_count') yield weibo # 设置主方法进行调用其他方法

def main():

for page in range(1,30):

json = get_page(page)

results = parse_page(json)

for result in results:

save_to_mongo(result) if __name__ == '__main__':

main()

项目运行情况

Python 爬虫 ajax爬取马云爸爸微博内容的更多相关文章

- python爬虫:爬取读者某一期内容

学会了怎么使用os模块 #!/usr/bin/python# -*- encoding:utf-8 -*- import requestsimport osfrom bs4 import Beauti ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- from appium import webdriver 使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium)

使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium) - 北平吴彦祖 - 博客园 https://www.cnblogs.com/stevenshushu/p ...

- Python爬虫之爬取站内所有图片

title date tags layut Python爬虫之爬取站内所有图片 2018-10-07 Python post 目标是 http://www.5442.com/meinv/ 如需在非li ...

- python爬虫实战---爬取大众点评评论

python爬虫实战—爬取大众点评评论(加密字体) 1.首先打开一个店铺找到评论 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经 ...

- Python爬虫之爬取淘女郎照片示例详解

这篇文章主要介绍了Python爬虫之爬取淘女郎照片示例详解,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧 本篇目标 抓取淘宝MM ...

- python 爬虫之爬取大街网(思路)

由于需要,本人需要对大街网招聘信息进行分析,故写了个爬虫进行爬取.这里我将记录一下,本人爬取大街网的思路. 附:爬取得数据仅供自己分析所用,并未用作其它用途. 附:本篇适合有一定 爬虫基础 crawl ...

- python爬虫项目-爬取雪球网金融数据(关注、持续更新)

(一)python金融数据爬虫项目 爬取目标:雪球网(起始url:https://xueqiu.com/hq#exchange=CN&firstName=1&secondName=1_ ...

随机推荐

- JavaScript数据结构-3.List

<!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title> ...

- apollo应用配置集成及使用

apollo应用配置集成及使用 1. 开发环境Apollo地址 用户名:apollo 密码:admin 开发环境Apollo管理台地址:http://localhost:8070/ ...

- Django与前端的交互

在创建Django项目后,我们创建了一个App,我将这个App的名字命名为Cal,并在Cal这个文件夹下创建文件 templates. 创建templates文件夹以后,在项目settings.py文 ...

- Kibana插件sentinl实现邮件报警

为什么会突然想用到对日志的异常内容进行邮件报警,是因为在上周公司的线上业务多次出现锁表,开发在优化sql的同时,我也在想是不是可以对日志的异常内容进行检测并实现邮件预警. 在网上查询了一些资料后,决定 ...

- Intel万兆网卡背靠背连接ping不通那点事儿

对那些整天喊着“玩大的,玩狠的”口号的人来说,我下面要说的这点事儿,根本就不算事儿.所以,如果你正好喜欢喊口号,就不要往下看了,因为我要讲述的,你可能不感兴趣,也可能看不懂. 今天,是我加入I公司3个 ...

- 玩转树莓派《二》——用python实现动画与多媒体

环境:树莓派,系统raspbian,系统自带两个版本的python以及pygame. 1.画板 程序如下: !/home/pi/game_1.py import pygame width = 640 ...

- JS日期、月份的加减

JS日期.月份的加减 需要注意的是返回的月份是从0开始计算的,也就是说返回的月份要比实际月份少一个月,因此要相应的加上1 // 日期,在原有日期基础上,增加days天数,默认增加1天 function ...

- RabbitMQ---8、连接断开处理-断线重连

本文转载于:https://www.itsvse.com/thread-4636-1-1.html: 参考文献:http://www.likecs.com/show-29874.html:https: ...

- [javaSE] IO流(管道流)

之前我们使用io流,都是需要一个中间数组,管道流可以直接输入流对接输出流,一般和多线程配合使用,当读取流中没数据时会阻塞当前的线程,对其他线程没有影响 定义一个类Read实现Runable接口,实现r ...

- oracle数据库的安装与连接关键点

一.window xp系统上安装Oracle Database 10G 解锁Scott.Hr账号并重置口令 远程连接数oracle数据库地址 二.在Mac系统上使用Navicat远程连接oracle数 ...