Scrapy学习篇(十二)之设置随机IP代理(IPProxy)

当我们需要大量的爬取网站信息时,除了切换User-Agent之外,另外一个重要的方式就是设置IP代理,以防止我们的爬虫被拒绝,下面我们就来演示scrapy如何设置随机IPProxy。

设置随机IPProxy

同样的你想要设置IPProxy ,首先需要找到可用的IPProxy ,通常情况下,一些代理网站会提供一些免费的ip代理,但是其稳定性和可用性很难得到保证,但是初学阶段,只能硬着头皮去找了,当然后期我们可以有其他的方法来寻找可用的IP代理,拿到可用的IPProxy 以后,将其添加到settings.py文件中,像下面这样,当然了,当你看到这篇文章的时候,他们肯定是已经失效了,你需要自己去找了。

PROXIES = ['http://183.207.95.27:80', 'http://111.6.100.99:80', 'http://122.72.99.103:80',

'http://106.46.132.2:80', 'http://112.16.4.99:81', 'http://123.58.166.113:9000',

'http://118.178.124.33:3128', 'http://116.62.11.138:3128', 'http://121.42.176.133:3128',

'http://111.13.2.131:80', 'http://111.13.7.117:80', 'http://121.248.112.20:3128',

'http://112.5.56.108:3128', 'http://42.51.26.79:3128', 'http://183.232.65.201:3128',

'http://118.190.14.150:3128', 'http://123.57.221.41:3128', 'http://183.232.65.203:3128',

'http://166.111.77.32:3128', 'http://42.202.130.246:3128', 'http://122.228.25.97:8101',

'http://61.136.163.245:3128', 'http://121.40.23.227:3128', 'http://123.96.6.216:808',

'http://59.61.72.202:8080', 'http://114.141.166.242:80', 'http://61.136.163.246:3128',

'http://60.31.239.166:3128', 'http://114.55.31.115:3128', 'http://202.85.213.220:3128']而后,在middlewares.py文件中,添加下面的代码。

import scrapy

from scrapy import signals

import random class ProxyMiddleware(object): def __init__(self, ip):

self.ip = ip @classmethod

def from_crawler(cls, crawler):

return cls(ip=crawler.settings.get('PROXIES')) def process_request(self, request, spider):

ip = random.choice(self.ip)

request.meta['proxy'] = ip

其基本的逻辑和上一篇设置User-Agent非常类似,因此这个地方不多赘述。

最后将我们自定义的类添加到下载器中间件设置中,如下。

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.ProxyMiddleware': 543,

}测试我们的代理

为了检测我们的代理是否设置成功,下面就以一个例子来进行测试。

我们在spider.py文件中写入下面的代码

import scrapy

class Spider(scrapy.Spider):

name = 'ip'

allowed_domains = []

def start_requests(self):

url = 'http://ip.chinaz.com/getip.aspx'

for i in range(4):

yield scrapy.Request(url=url, callback=self.parse, dont_filter=True)

def parse(self,response):

print(response.text)

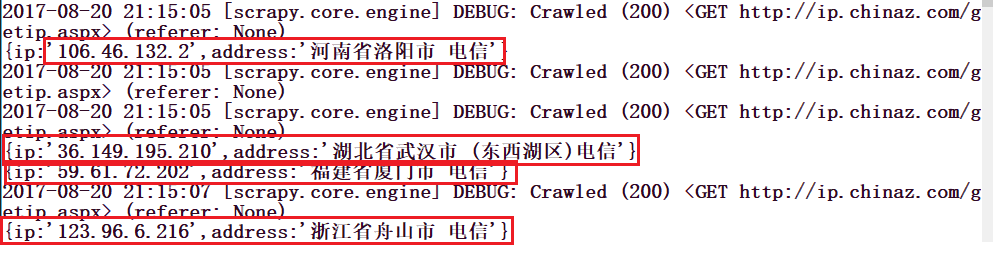

上面的代码中,url = 'http://ip.chinaz.com/getip.aspx'这个网站可以显示我们的ip地址,我们用它来测试,请注意,在Request()中,我们必须添加dont_filter=True因为我们多次请求的是同一个网址,scrapy默认会把重复的网址过滤掉。运行这个项目,我们可以看到如下的输出。

Scrapy学习篇(十二)之设置随机IP代理(IPProxy)的更多相关文章

- Scrapy学习篇(二)之常用命令行工具

简介 Scrapy是通过Scrapy命令行工具进行控制的,包括创建新的项目,爬虫的启动,相关的设置,Scrapy提供了两种内置的命令,分别是全局命令和项目命令,顾名思义,全局命令就是在任意位置都可以执 ...

- oracle学习篇十二:索引

索引: 查询User_indexes可以获取有关用户已创建的索引的详细信息. 查询User_ind_partitions可以获取有关用户已创建的分区索引的详细信息. 查询User_ind_column ...

- Scrapy学习篇(十)之下载器中间件(Downloader Middleware)

下载器中间件是介于Scrapy的request/response处理的钩子框架,是用于全局修改Scrapy request和response的一个轻量.底层的系统. 激活Downloader Midd ...

- Scrapy实战篇(二)之爬取链家网成交房源数据(下)

在上一小节中,我们已经提取到了房源的具体信息,这一节中,我们主要是对提取到的数据进行后续的处理,以及进行相关的设置. 数据处理 我们这里以把数据存储到mongo数据库为例.编写pipelines.py ...

- Scrapy学习篇(七)之Item Pipeline

在之前的Scrapy学习篇(四)之数据的存储的章节中,我们其实已经使用了Item Pipeline,那一章节主要的目的是形成一个笼统的认识,知道scrapy能干些什么,但是,为了形成一个更加全面的体系 ...

- 第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP

第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP 设置代理ip只需要,自定义一个中间件,重写process_request方法, request ...

- python3.4学习笔记(十二) python正则表达式的使用,使用pyspider匹配输出带.html结尾的URL

python3.4学习笔记(十二) python正则表达式的使用,使用pyspider匹配输出带.html结尾的URL实战例子:使用pyspider匹配输出带.html结尾的URL:@config(a ...

- Tensorflow深度学习之十二:基础图像处理之二

Tensorflow深度学习之十二:基础图像处理之二 from:https://blog.csdn.net/davincil/article/details/76598474 首先放出原始图像: ...

- - 高级篇:二,IL设置静态属性,字段和类型转换

- 高级篇:二,IL设置静态属性,字段和类型转换 静态属性赋值 先来看 Reflector反射出的IL源码(感谢Moen的提示),这次用 Release模式编译,去掉那些无用的辅助指令 public ...

随机推荐

- zabbix3.4.7利用Windows性能监视器监控各项资源指标

zabbix自带的windows监控模板并没有监控windows cpu使用率的监控 在cmd命令的窗口输入perfmon,就会弹出一下界面 点击性能监视器 点击如图加号,出现很多参数 选择proce ...

- 【log4j】使用注意事项

实际过程中,使用log4j遇到的一些问题,进行总结: 1.log4j.properties文件的放置路径: 必须放在src的根目录下,这样就不需要额外的加载了 2.申明一个log对象 Logger l ...

- 数据分析---SQL(Access数据库)

1. SQL(Structure Quest Language) 一种结构化查询语言,它是一种通用的关系型数据库操作语言,用于存取数据,查询,更新和管理数据库. 2. 基本语句 Select, Cre ...

- Python—内置函数

内置函数 内置函数补充 all: 所有iterable类型,包含的元素要全为真才返回真 >>> all([0,-1,5]) False >>> all([-1,5 ...

- Linux c读取系统内存使用信息

系统的内存使用信息能够在虚拟文件系统/proc/meminfo中找到,如图 所以只要打开/proc/meminfo文件,然后从中读取信息就好了 #include <stdio.h>#inc ...

- Forth 词典和词汇

body, table{font-family: 微软雅黑; font-size: 13.5pt} table{border-collapse: collapse; border: solid gra ...

- python编码及转换

第一种:ASCII码 ASCII(American Standard Code for Information Interchange,美国信息交换标准代码)是基于拉丁字母的一套电脑编码系统,主要用于 ...

- Python中异常处理

高级语言通常都配置了一套try...except...finally的错误处理机制. 1.我们先看一个try的机制 try: res=1/0except ZeroDivisionError as e: ...

- MFC VC++ 根据文件名获取程序的Pid

环境:PC Win7 VS VC++ .MFC 使用,输入文件名即可获取程序的pid,进而可以对程序进行操作,比如关闭Porcess等. 头文件: #include <TlHelp32.h> ...

- 【转载】 强化学习(十一) Prioritized Replay DQN

原文地址: https://www.cnblogs.com/pinard/p/9797695.html ------------------------------------------------ ...