实时同步到Hbase的优化-1

最近没有管测试环境的,上去看了下,好家伙,kafka羁留了上百万数据,于是打算把数据同步到测试的Hbase库中,在这期间发现了插入性能问题

def putMapData(tableName: String , columnFamily:String, key:String , mapData:Map[String , String]) = {

val startTime = System.currentTimeMillis()

val table: Table = Init(tableName , columnFamily)

val endTime = System.currentTimeMillis()

Logger.getLogger("处理事务").info(s"插入的时间:${(endTime - startTime)}")

try{

//TODO rowKeyWithMD5Prefix

val rowkey = HbaseTools.rowKeyByMD5(key)

val put: Put = new Put(rowkey)

if(mapData.size > 0){

for((k , v) <- mapData){

put.addColumn(Bytes.toBytes(columnFamily) ,Bytes.toBytes(k.toString) , Bytes.toBytes(v.toString))

}

}

table.put(put)

}catch{

case e:Exception => e.printStackTrace()

}finally {

table.close()

}

}

/**

* @return 构建表的连接

* */

def Init(tableName: String , columnFamily:String):Table = {

val hTableDescriptor = new HTableDescriptor(TableName.valueOf(tableName))

val hColumnDescriptor = new HColumnDescriptor(columnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(!admin.tableExists(TableName.valueOf(tableName))){

// admin.createTable(hTableDescriptor)

createHTable(conn , tableName , , Array(columnFamily)) }

conn.getTable(TableName.valueOf(tableName))

}

发现一条数据过来,会进行一次init,就是判断这个表是不是存在的,如果不存在那么创建表,但是这个过程要50~70ms时间,海量数据下来,处理是非常慢的

也就是说:这块儿代码及其耗费时间

val hTableDescriptor = new HTableDescriptor(TableName.valueOf(tableName))

val hColumnDescriptor = new HColumnDescriptor(columnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(!admin.tableExists(TableName.valueOf(tableName))){

createHTable(conn , tableName , , Array(columnFamily)) }

所以,尽量在实时处理时候,不要走这些从程序;

因此,将上面的代码提升带object的成员变量处:

private val config: Configuration = HBaseConfiguration.create()

config.set("hbase.zookeeper.quorum" , GlobalConfigUtils.hbaseQuorem)

config.set("hbase.master" , GlobalConfigUtils.hbaseMaster)

config.set("hbase.zookeeper.property.clientPort" , GlobalConfigUtils.clientPort)

config.set("hbase.rpc.timeout" , GlobalConfigUtils.rpcTimeout)

config.set("hbase.client.operator.timeout" , GlobalConfigUtils.operatorTimeout)

config.set("hbase.client.scanner.timeout.period" , GlobalConfigUtils.scannTimeout)

private val conn: Connection = ConnectionFactory.createConnection(config)

private val admin: Admin = conn.getAdmin

val atomic = new AtomicInteger(0)

var resultAtomic = 0

val hTableDescriptor = new HTableDescriptor(TableName.valueOf(GlobalConfigUtils.tableOrderInfo))

val hColumnDescriptor = new HColumnDescriptor(GlobalConfigUtils.tableColumnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(!admin.tableExists(TableName.valueOf(GlobalConfigUtils.tableOrderInfo))){

createHTable(conn , GlobalConfigUtils.tableOrderInfo , 10 , Array(GlobalConfigUtils.tableColumnFamily))

}private val config: Configuration = HBaseConfiguration.create()

config.set("hbase.zookeeper.quorum" , GlobalConfigUtils.hbaseQuorem)

config.set("hbase.master" , GlobalConfigUtils.hbaseMaster)

config.set("hbase.zookeeper.property.clientPort" , GlobalConfigUtils.clientPort)

config.set("hbase.rpc.timeout" , GlobalConfigUtils.rpcTimeout)

config.set("hbase.client.operator.timeout" , GlobalConfigUtils.operatorTimeout)

config.set("hbase.client.scanner.timeout.period" , GlobalConfigUtils.scannTimeout)

private val conn: Connection = ConnectionFactory.createConnection(config)

private val admin: Admin = conn.getAdmin

val atomic = new AtomicInteger(0)

var resultAtomic = 0

val hTableDescriptor = new HTableDescriptor(TableName.valueOf(GlobalConfigUtils.tableOrderInfo))

val hColumnDescriptor = new HColumnDescriptor(GlobalConfigUtils.tableColumnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(!admin.tableExists(TableName.valueOf(GlobalConfigUtils.tableOrderInfo))){

createHTable(conn , GlobalConfigUtils.tableOrderInfo , 10 , Array(GlobalConfigUtils.tableColumnFamily))

}

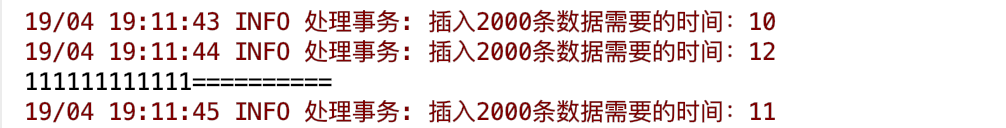

然后我在提交代码。发现:

以前的2000条数据插入时间大概需要140000ms的时间

现在处理的时间:

速度提升了大概140000 /10 倍

实时同步到Hbase的优化-1的更多相关文章

- Mysql 到 Hbase 数据如何实时同步,强大的 Streamsets 告诉你

很多情况大数据集群需要获取业务数据,用于分析.通常有两种方式: 业务直接或间接写入的方式 业务的关系型数据库同步到大数据集群的方式 第一种可以是在业务中编写代码,将觉得需要发送的数据发送到消息队列,最 ...

- Mysql数据实时同步

企业运维的数据库最常见的是 mysql;但是 mysql 有个缺陷:当数据量达到千万条的时候,mysql 的相关操作会变的非常迟缓; 如果这个时候有需求需要实时展示数据;对于 mysql 来说是一种灾 ...

- HBase性能优化方法总结(转)

本文主要是从HBase应用程序设计与开发的角度,总结几种常用的性能优化方法.有关HBase系统配置级别的优化,这里涉及的不多,这部分可以参考:淘宝Ken Wu同学的博客. 1. 表的设计 1.1 Pr ...

- HBase性能优化方法总结(转)

原文链接:HBase性能优化方法总结(一):表的设计 本文主要是从HBase应用程序设计与开发的角度,总结几种常用的性能优化方法.有关HBase系统配置级别的优化,可参考:淘宝Ken Wu同学的博客. ...

- Hbase性能优化

HBase性能优化方法总结 1. 表的设计 1.1 Pre-Creating Regions 默认情况下,在创建HBase表的时候会自动创建一个region分区,当导入数据的时候,所有的HBase客户 ...

- 基于Canal和Kafka实现MySQL的Binlog近实时同步

前提 近段时间,业务系统架构基本完备,数据层面的建设比较薄弱,因为笔者目前工作重心在于搭建一个小型的数据平台.优先级比较高的一个任务就是需要近实时同步业务系统的数据(包括保存.更新或者软删除)到一个另 ...

- hbase读写优化

一.hbase读优化 客户端优化 1.scan缓存是否设置合理? 优化原理:一次scan请求,实际并不会一次就将所有数据加载到本地,而是多次RPC请求进行加载.默认100条数据大小. 优化建议:大sc ...

- inotify+rsync实现实时同步部署

1.1.架构规划 1.1.1架构规划准备 服务器系统 角色 IP Centos6.7 x86_64 NFS服务器端(NFS-server-inotify-tools) 192.168.1.14 Cen ...

- lsyncd 实时同步

1. 几大实时同步工具比较 1.1 inotify + rsync 最近一直在寻求生产服务服务器上的同步替代方案,原先使用的是inotify + rsync,但随着文件数量的增大到100W+,目录下的 ...

随机推荐

- python之文件的读写和文件目录以及文件夹的操作实现代码

这篇文章主要介绍了python之文件的读写和文件目录以及文件夹的操作实现代码,需要的朋友可以参考下 为了安全起见,最好还是给打开的文件对象指定一个名字,这样在完成操作之后可以迅速关闭文件,防止一些无用 ...

- Day058--django--app

1. 完整的登录示例 form表单使用的注意事项: 1. action="" method="post" action 提交的地址 met ...

- 20175221曾祥杰 实验二《Java面向对象程序设计》

实验二<Java面向对象程序设计> 实验报告封面 课程:Java程序设计 班级:1752班 姓名:曾祥杰 学号:20175221 指导教师:娄嘉鹏 实验日期:2019年4月17日 实验时间 ...

- Entity Framework系列教程汇总

翻译自http://www.entityframeworktutorial.net/,使用EF几年时间了,一直没有系统总结过,所以翻译这一系统文章作为总结,由于英语功底有限,翻译的可能有些问题,欢迎指 ...

- 树莓派的系统安装,并且利用网线直连 Mac 进行配置

最近单位给了我一个新的树莓派3B+让我自己玩.下面是我记录的我如何安装 Raspbian Stretch Lite 系统,然后如何成功不用独立显示屏而利用 MacBook 对其进行配置. 安装 Ras ...

- Spring cloud gateway

==================================为什么需要API gateway?==================================企业后台微服务互联互通, 因为 ...

- Windows API 调用示例

Ø 简介 本文主要记录 Windows API 的调用示例,因为这项技术并不常用,属于 C# 中比较孤僻或接触底层的技术,并不常用.但是有时候也可以借助他完成一些 C# 本身不能完成的功能,例如:通 ...

- vue+element 正则表达式进行表单验证

<template> <el-form :model="form" label-width="115px" ref="form&qu ...

- JSP/Serlet 使用fileupload上传文件

需要引用的jar commons-fileupload-1.3.1.jar commons-io-2.2.jar index.jsp <body> <center> <h ...

- 优化算法:AdaGrad | RMSProp | AdaDelta | Adam

0 - 引入 简单的梯度下降等优化算法存在一个问题:目标函数自变量的每一个元素在相同时间步都使用同一个学习率来迭代,如果存在如下图的情况(不同自变量的梯度值有较大差别时候),存在如下问题: 选择较小的 ...