记intel杯比赛中各种bug与debug【其三】:intel chainer的安装与使用

现在在训练模型,闲着来写一篇

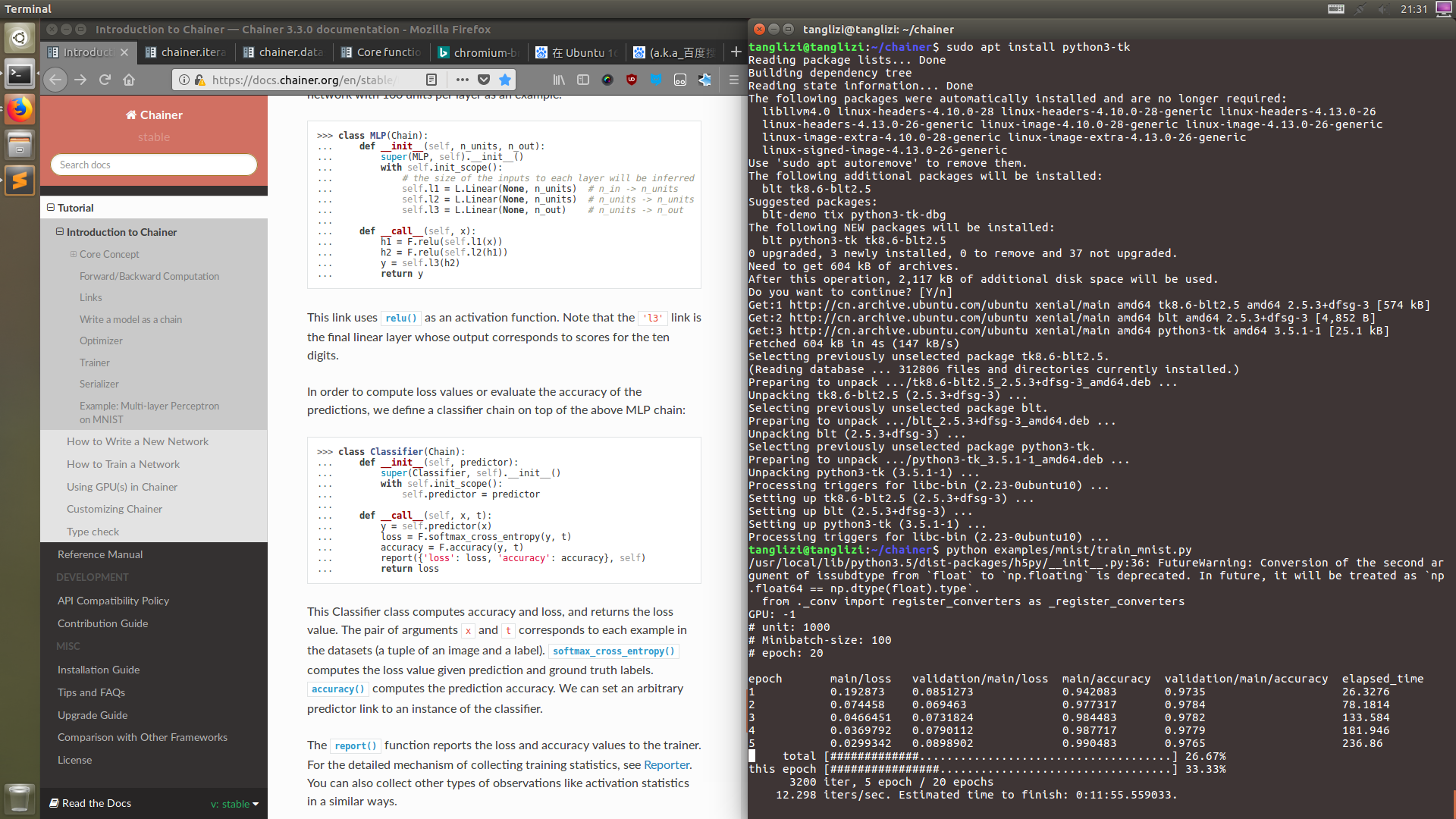

顺着这篇文章,顺利安装上intel chainer

再次感谢 大黄老鼠

intel chainer 使用

头一次使用chainer,本以为又入了一个大坑,实际尝试感觉非常兴奋

chainer的使用十分顺畅,开发起来特别友好

可能是跟pytorch相似的原因,特喜欢chainer

网络结构编写

这里如果用过pytorch,就会发现代码几乎没变,写起来就会非常顺手

在chainer中layers被视为links,Module被叫做Chain, chainer的意思由此可见

chainer的创新是突出了一个数据带领结构(“Define-by-Run”),所以就连layer的输入大小都不需要填写

模型会自动帮我们写

class Network(chainer.Chain):

def __init__(self):

super(Network, self).__init__()

with self.init__scope():

self.in=chainer.links.Linear(None, 256)

self.hidden=chainer.links.Linear(None, 64)

self.out=chainer.links.Linear(None, 5)

def __call__(self, x):

x=chainer.functions.relu(self.in(x))

x=chainer.functions.relu(self.hidden(x))

x=self.out(x)

return x

class Classifier(chainer.Chainer):

def __init__(self, predicor):

super(Classifier, self).__init__()

with self.init__scope():

self.predictor=predictor

def __call__(self, x, t):

x=self.predictor(x)

loss=chainer.functions.softmax_cross_entropy(x, t)

accuracy=chainer.functions.accuracy(x, t)

chainer.reporter.report({'loss': loss, 'accuracy': accuracy}, self)

return loss

训练模型

简要写一下chainer训练时要写什么

- model

- optimizer

- trainer(可选,需要updater和必要的参数)

- updater(以下皆可选, 需iterator, optimizer)

- iterator(需dataset,batch_size)

- dataset(类型为TupleDataset)

- extensions(需trainer)

我们把训练方式分为两种

- 一种为pytorch风格

定义好model, optimizer, criterion

嵌套循环,计算loss然后bp即可

def lossfun(data, label):

...

return loss

model=Network()

optimizer=chainer.optimizers.Adam()

optimizer.setup(model)

for epoch in params['epoch']:

for step, batch in enumerate(dataset):

model.cleargrads()

# model.reset_state()

loss=lossfun(batch['data'], batch['label'])

loss.backward()

optimizer.update()

或者简单写成

model=Network()

optimizer=chainer.optimizers.Adam()

optimizer.setup(model)

for epoch in params['epoch']:

for step, batch in enumerate(dataset):

# model.reset_state()

optimizer.update(lossfun, data, label)

- 另一种是带trainer的chainer风格

若有需要,重写updater和iterator,塞进trainer即可

若需要拓展,只需trainer.extend(...),十分方便

这里就简单的写一下

model=Classifier(Network())

optimizer=chainer.optimizers.Adam()

optimizer.setup(model)

trainset=chainer.datasets.TupleDataset(data, label)

train_iter=chainer.iterators.SerialIterator(trainset, params['batch_size'], shuffle=True, repeat=True)

updater=trainer.StandardUpdater(train_iter, model)

trainer=chainer.training.Trainer(updater, (params['epoch'], 'epoch'), params['name'])

# 这里是各种拓展

trainer.run()

使用模型

跟pytorch一样,十分简单

predict=model(data)

...

记intel杯比赛中各种bug与debug【其三】:intel chainer的安装与使用的更多相关文章

- 记intel杯比赛中各种bug与debug【其一】:安装intel caffe

因为intel杯创新软件比赛过程中,并没有任何记录.现在用一点时间把全过程重演一次用作记录. 学习 pytorch 一段时间后,intel比赛突然不让用 pytoch 了,于是打算转战intel ca ...

- 记intel杯比赛中各种bug与debug【其二】:intel caffe的使用和大坑

放弃使用pytorch,学习caffe 本文仅记录个人观点,不免存在许多错误 Caffe 学习 caffe模型生成需要如下步骤 编写network.prototxt 编写solver.prototxt ...

- 记intel杯比赛中各种bug与debug【其四】:基于长短时记忆神经网络的中文分词的实现

(标题长一点就能让外行人感觉到高大上) 直接切入主题好了,这个比赛还必须一个神经网络才可以 所以我们结合主题,打算写一个神经网络的中文分词 这里主要写一下数据的收集和处理,网络的设计,代码的编写和模型 ...

- 记intel杯比赛中各种bug与debug【其五】:朴素贝叶斯分类器的实现和针对性的优化

咱这个项目最主要的就是这个了 贝叶斯分类器用于做可以统计概率的二元分类 典型的例子就是垃圾邮件过滤 理论基础 对于贝叶斯算法,这里附上两个链接,便于理解: 朴素贝叶斯分类器的应用-阮一峰的网络日志 基 ...

- SQL Server 字段类型 decimal(18,6)小数点前是几位?记一次数据库SP的BUG处理

原文:SQL Server 字段类型 decimal(18,6)小数点前是几位?记一次数据库SP的BUG处理 SQL Server 字段类型 decimal(18,6)小数点前是几位? 不可否认,这是 ...

- gcc中的内嵌汇编语言(Intel i386平台)

[转]http://bbs.chinaunix.net/thread-2149855-1-1.html 一.声明 虽然Linux的核心代码大部分是用C语言编写的,但是不可避免的其中还是有一部分是用汇 ...

- 那些盒模型在IE6中的BUG们,工程狮的你可曾遇到过?

HTML5学堂 那些盒模型在IE6中的BUG们,工程狮的你可曾遇到过? IE6已经渐渐的开始退出浏览器的历史舞台.虽然当年IE6作为微软的一款利器击败网景,但之后也因为版本的持续不更新而被火狐和谷歌三 ...

- 转:移动开发中一些bug及解决方案

网页开发要面对各种各样的浏览器,让人很头疼,而移动开发中,你不但要面对浏览器,还要面对各种版本的手机,iOS好一点,而安卓就五花八门了,你可能在开发中也被它们折磨过,或者正在被它们折磨,我在这里说几个 ...

- 写代码的心得,怎么减少编程中的 bug?

遭遇 bug 的时候,理性的程序员会说:这个 bug 能复现吗? 自负型:这不可能,在我这是好好的. 经验型:不应该,以前怎么没问题? 幻想型:可能是数据有问题. 无辜型:我好几个星期都没碰这块代码了 ...

随机推荐

- Java8内置的四大核心函数式接口

package java_8; import org.junit.Test; import java.util.ArrayList; import java.util.Arrays; import j ...

- 跨域调用接口——WebClient通过get和post请求api

AJAX不可以实现跨域请求,经过特殊处理才行.一般后台可以通过WebClient实现跨域请求~ //get 请求 string url = string.Format("htt ...

- 《汇编语言(第三版)》pushf 和 popf 指令,以及标志寄存器在 Debug 中的表示

pushf 和 popf pushf 的功能是将标志寄存器的值压栈,而 popf 是从栈中弹出数据,输入标志寄存器. pushf 和 popf,为直接访问寄存器提供了方法. 格式 pushf popf ...

- node.js连接数据库基本操作、封装数据库操作,输出到网页

声明:以下代码测试通过,不同于直接的复制粘贴乱七八糟未测试的代码,完全可以用,最后会附上所有的代码和sql文件 首先建立表,建表语句如下: /* SQLyog Ultimate v12.08 (64 ...

- 【原创】查询占CPU高的oracle进程

1:首先使用TOP命令传到占用CPU高的SPID号 PID USERNAME THR PRI NICE SIZE RES STATE TIME CPU COMMAND3575 oracle 1 12 ...

- pic中断特别说明

在调试产品W660-MODBUS过程中发现,程序工作在偶然情况下会工作异常,经过将近一个礼拜的追踪,发现PIC中断有一下两个怪异特性: 在刚进入中断时就应该清除中断标志,如果在最后返回之前才清除标志, ...

- Mojo For Chromium Developers

Overview This document contains the minimum amount of information needed for a developer to start us ...

- Maven缺少jar添加方式

Maven 中央仓库地址: 1. http://www.sonatype.org/nexus/ 2. http://mvnrepository.com/ (本人推荐仓库) 3. http://repo ...

- (WC2018模拟十二)【FJOI2016集训Day7T1】挑选子序列

题解: 这题太神仙了,先咕着,放个令人****的官方题解(精确覆盖问题是NP完全问题啊摔) Dancing Link X学习资料:QAQ TAT qwq Orz Donald Knuth大神... p ...

- hadoop-17-hive数据库元数据查看

hadoop-17-hive数据库元数据查看 存在本地的mysql中: user001用户中 : > mysql -uhive -phive mysql> use hive; mysql& ...