python爬虫——《瓜子网》的广州二手车市场信息

由于多线程爬取数据比单线程的效率要高,尤其对于爬取数据量大的情况,效果更好,所以这次采用多线程进行爬取。具体代码和流程如下:

import math

import re

from concurrent.futures import ThreadPoolExecutor

import requests

import lxml

import lxml.etree

# 获取网页源代码

def getHtml(url, header):

try:

response = requests.get(url, headers=header)

response.raise_for_status()

return response.content.decode('utf-8')

except:

return ''

# 获取翻页url

def getPageUrl(url, response):

mytree = lxml.etree.HTML(response)

# 页码

carNum = mytree.xpath('//*[@id="post"]/p[3]/text()')[0]

carNum = math.ceil(int(re.findall('(\d+)', carNum)[0]) / 40)

urlList = url.rsplit('/', maxsplit=1)

pageUrlList = []

if carNum != 0:

for i in range(1, carNum + 1):

pageUrl = urlList[0] + "/o" + str(i) + "/" + urlList[1]

pageUrlList.append(pageUrl)

return pageUrlList

# 获取汽车品牌

def getCarBrand(response):

mytree = lxml.etree.HTML(response)

# 汽车品牌url

carBrandUrl = mytree.xpath('//div[@class="dd-all clearfix js-brand js-option-hid-info"]/ul/li/p/a/@href')

# 汽车品牌名

carBrandName = mytree.xpath('//div[@class="dd-all clearfix js-brand js-option-hid-info"]/ul/li/p/a/text()')

carBrandDict = {}

for i in range(len(carBrandName)):

carBrandDict[carBrandName[i]] = "https://www.guazi.com" + carBrandUrl[i]

return carBrandDict

# 获取汽车信息

def getCarInfo(pageUrl, carBrandName):

response = getHtml(pageUrl, header)

mytree = lxml.etree.HTML(response)

for i in range(40):

# 汽车名称

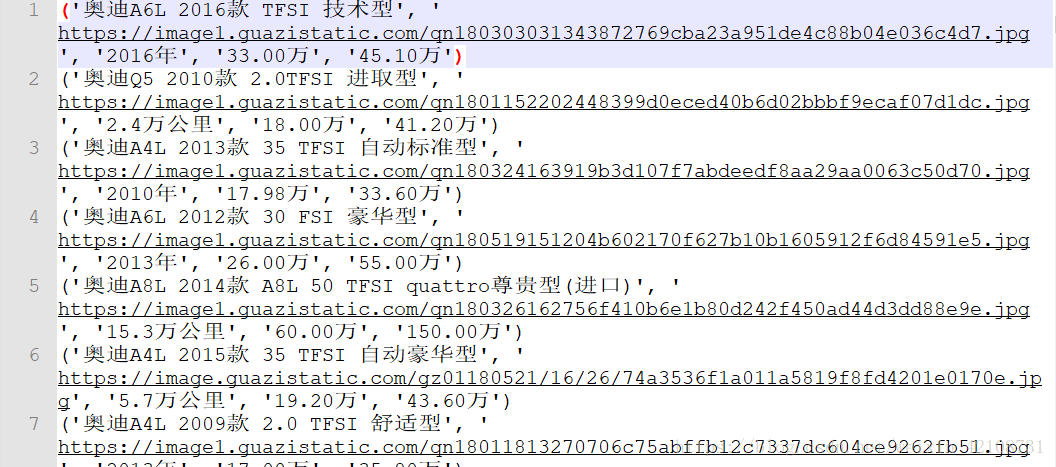

carName = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/h2/text()')[i]

# 汽车图片

carPic = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/img/@src')[i]

carPic = carPic.rsplit("jpg", maxsplit=1)[0] + 'jpg'

# 汽车出产年份、里程数

carInfo = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[1]/text()')[i]

# 现价

carCurrentPrice = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[2]/p/text()')[i] + "万"

# 原价

carOriginPrice = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[2]/em/text()')[i]

print(carName, carPic, carInfo, carCurrentPrice, carOriginPrice)

# 写入文件

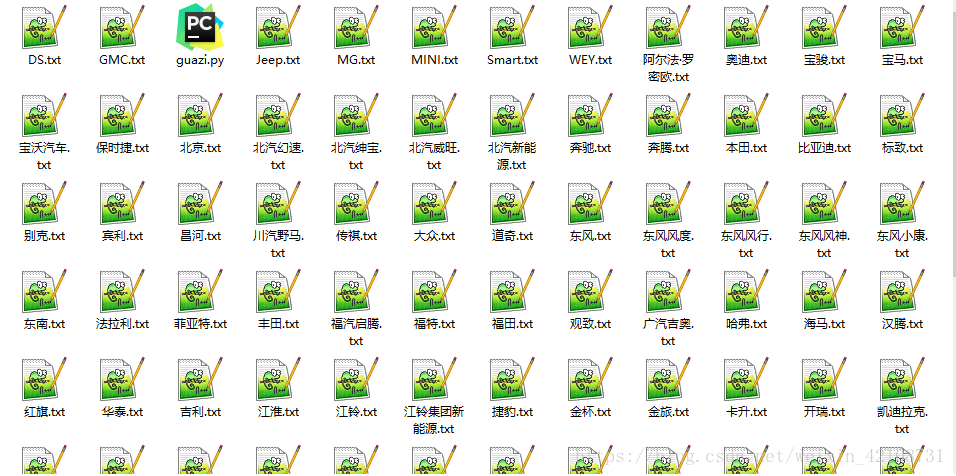

path = carBrandName + '.txt'

with open(path, 'a+') as f:

f.write(str((carName, carPic, carInfo, carCurrentPrice, carOriginPrice)) + '\n')

if __name__ == '__main__':

url = 'https://www.guazi.com/gz/buy/'

header = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_5) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.85 Safari/537.36",

}

# 获得初始页源代码

html = getHtml(url, header)

# 获取汽车品牌信息字典

carBrandDict = getCarBrand(html)

# 多线程(10条的线程池)

with ThreadPoolExecutor(10) as exT:

# 程序执行流程

# 根据汽车品牌进行爬取

for carBrandName, carBrandUrl in carBrandDict.items():

# 获取不同品牌页面源代码

html = getHtml(carBrandUrl, header)

# 获取当前品牌页面的页码url

pageUrlList = getPageUrl(carBrandUrl, html)

# 翻页

for pageUrl in pageUrlList:

# 获取汽车信息并写入文件

exT.submit(getCarInfo, pageUrl, carBrandName)结果如下:

由于《瓜子网》更新过域名,所以之前有评论说网页打不开,现已做了处理,程序能正常爬取数据啦!

以上就是我的分享,如果有什么不足之处请指出,多交流,谢谢!

如果喜欢,请关注我的博客:https://www.cnblogs.com/qiuwuzhidi/

想获取更多数据或定制爬虫的请点击python爬虫专业定制

python爬虫——《瓜子网》的广州二手车市场信息的更多相关文章

- python爬虫实例--网易云音乐排行榜爬虫

网易云音乐,以前是有个api 链接的json下载的,现在没了, 只有音乐id,title , 只能看播放请求了, 但是播放请求都是加密的值,好坑... 进过各种努力, 终于找到了个大神写的博客,3.6 ...

- Python 爬虫 当当网图书 scrapy

目标站点需求分析 获取当当网每个图书名字和评论数 涉及的库 scrapy,mysql 获取解析单页源码 保存到数据库中 结果

- python爬虫 赶集网

#coding=utf-8import requestsfrom lxml import etreefrom sqlalchemy import create_enginefrom sqlalchem ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- Python爬虫开源项目代码,爬取微信、淘宝、豆瓣、知乎、新浪微博、QQ、去哪网等 代码整理

作者:SFLYQ 今天为大家整理了32个Python爬虫项目.整理的原因是,爬虫入门简单快速,也非常适合新入门的小伙伴培养信心.所有链接指向GitHub,祝大家玩的愉快 1.WechatSogou [ ...

- python链家网高并发异步爬虫asyncio+aiohttp+aiomysql异步存入数据

python链家网二手房异步IO爬虫,使用asyncio.aiohttp和aiomysql 很多小伙伴初学python时都会学习到爬虫,刚入门时会使用requests.urllib这些同步的库进行单线 ...

- python爬虫:爬取慕课网视频

前段时间安装了一个慕课网app,发现不用注册就可以在线看其中的视频,就有了想爬取其中的视频,用来在电脑上学习.决定花两天时间用学了一段时间的python做一做.(我的新书<Python爬虫开发与 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- Python爬虫教程-15-读取cookie(人人网)和SSL(12306官网)

Python爬虫教程-15-爬虫读取cookie(人人网)和SSL(12306官网) 上一篇写道关于存储cookie文件,本篇介绍怎样读取cookie文件 cookie的读取 案例v16ssl文件:h ...

随机推荐

- Get和Post区别(转载)

转载自:https://www.cnblogs.com/logsharing/p/8448446.html GET和POST是HTTP请求的两种基本方法,要说它们的区别,接触过WEB开发的人都能说出一 ...

- 如何优雅地学习计算机编程-C++1

如何优雅的学习计算机编程--C++ 0.导入 如何优雅地学习计算机编程.我们得首先了解编程是什么?打个比方--写信. 大家都知道写信所用的语言双方都懂,这样的信才做到了信息交流,人和计算机也是如此人和 ...

- 【LiteOS】LiteOS任务篇-源码分析-创建任务函数

目录 前言 链接 参考 笔录草稿 部分源码分析 源码分析 LOS_TaskCreate函数 LOS_TaskCreateOnly函数 宏 OS_TCB_FROM_PENDLIST 和 宏 LOS_DL ...

- 力扣 - 347. 前 K 个高频元素

目录 题目 思路1(哈希表与排序) 代码 复杂度分析 思路2(建堆) 代码 复杂度分析 题目 347. 前 K 个高频元素 思路1(哈希表与排序) 先用哈希表记录所有的值出现的次数 然后将按照出现的次 ...

- vue实现拖拽排序

基于vue实现列表拖拽排序的效果 在日常开发中,特别是管理端,经常会遇到要实现拖拽排序的效果:这里提供一种简单的实现方案. 此例子基于vuecli3 首先,我们先了解一下js原生拖动事件: 在拖动目标 ...

- 北航OO第一单元作业总结(Retake)

前言:当我写这篇博客的时候,我的心情是复杂的,因为这实际上是我第二次写这篇博客--我今年重修的这门课.我对去年的成绩心有不甘--在激烈的竞争下,我虽然尽可能完成了所有作业(仅一次作业未通过弱测),但爆 ...

- OO第二单元——电梯作业总结

前言 本单元作业主要以设计电梯来实现多线程编程.本章主要学习了如何使用多线程以及如何确保多线程安全,从电梯的调度策略中学会了如何简单地使用synchronized锁来控制线程安全. 首先,明确锁的两个 ...

- OO_Unit2总结

OO_Unit2总结 (1) 多线程协同控制设计策略 总体信号通讯策略 本单元作业,我采用的是生产者-消费者模式加类观察者模式. 通过分析指导书给出的需求,我将最终我要实现的程序简化为了"输 ...

- OpenPAL3:仙三开源版的第二个小目标 Accomplish!

去年的时候,OpenPAL3 的第一个版本发布 之后,我给 0.2 版本设定了一个小目标:让景天能跑出永安当.当时的第一个版本还只能算是概念验证的版本,没有音乐支持.输入支持,不能直接读取仙剑三的打包 ...

- electron项目踩坑--A JavaScript error occurred in the main process:document is not defined

前言 记录electron-vue项目开发中遇到的一个错误,运行时报错如图: 控制台报错如下: ReferenceError: document is not defined at Object.&l ...