Python大法之告别脚本小子系列—各类URL采集器编写

系列文章专辑:https://bbs.ichunqiu.com/forum.php?mod=collection&action=view&ctid=137

0×00 前言

URl采集在批量刷洞中也是很重要的

0×01 目录

0×01 前言

0×02 ZoomEyeAPI脚本编写

0×03 ShoDanAPI脚本编写

0×04 简易BaiduURL采集脚本编写

0×05 【彩蛋篇】论坛自动签到脚本

0×02 ZoomEyeAPI脚本编写

ZoomEye是一款针对网络空间的搜索引擎,收录了互联网空间中的设备、网站及其使用的服务或组件等信息。

ZoomEye 拥有两大探测引擎:Xmap 和 Wmap,分别针对网络空间中的设备及网站, 通过 24 小时不间断的探测、识别,标识出互联网设备及网站所使用的服务及组件。 研究人员可以通过 ZoomEye 方便的了解组件的普及率及漏洞的危害范围等信息。

虽然被称为 “黑客友好” 的搜索引擎,但 ZoomEye 并不会主动对网络设备、网站发起攻击,收录的数据也仅用于安全研究。ZoomEye更像是互联网空间的一张航海图。

ZoomEyeAPI参考手册在这:ZoomEye API 参考手册

先登录,然后获取access_token

#-*- coding: UTF-8 -*-

import requests

import json

user = raw_input('[-] PLEASE INPUT YOUR USERNAME:')

passwd = raw_input('[-] PLEASE INPUT YOUR PASSWORD:')

def Login():

data_info = {'username' : user,'password' : passwd}

data_encoded = json.dumps(data_info)

respond = requests.post(url = 'https://api.zoomeye.org/user/login',data = data_encoded)

try:

r_decoded = json.loads(respond.text)

access_token = r_decoded['access_token']

except KeyError:

return '[-] INFO : USERNAME OR PASSWORD IS WRONG, PLEASE TRY AGAIN'

return access_token

if __name__ == '__main__':

print Login()

然后,API手册是这么写的,根据这个,咱们先写一个HOST的单页面采集的….

#-*- coding: UTF-8 -*-

import requests

import json

user = raw_input('[-] PLEASE INPUT YOUR USERNAME:')

passwd = raw_input('[-] PLEASE INPUT YOUR PASSWORD:')

def Login():

data_info = {'username' : user,'password' : passwd}

data_encoded = json.dumps(data_info)

respond = requests.post(url = 'https://api.zoomeye.org/user/login',data = data_encoded)

try:

r_decoded = json.loads(respond.text)

access_token = r_decoded['access_token']

except KeyError:

return '[-] INFO : USERNAME OR PASSWORD IS WRONG, PLEASE TRY AGAIN'

return access_token

def search():

headers = {'Authorization': 'JWT ' + Login()}

r = requests.get(url = 'https://api.zoomeye.org/host/search?query=tomcat&page=1',

headers = headers)

response = json.loads(r.text)

print response

if __name__ == '__main__':

search()

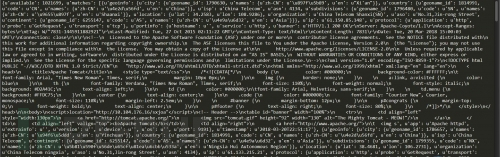

返回的信息量极大啊,但它也是个JSON数据,SO,我们可以取出IP部分…

for x in response['matches']:

print x['ip']

之后,HOST的单页面采集也就OK了,WEB的也五五开,留着你们自己分析,其实差不多,后文会贴的

接下来,就是用FOR循环….获取多页的IP

#-*- coding: UTF-8 -*-

import requests

import json

def Login():

data_info = {'username' : user,'password' : passwd}

data_encoded = json.dumps(data_info)

respond = requests.post(url = 'https://api.zoomeye.org/user/login',data = data_encoded)

try:

r_decoded = json.loads(respond.text)

access_token = r_decoded['access_token']

except KeyError:

return '[-] INFO : USERNAME OR PASSWORD IS WRONG, PLEASE TRY AGAIN'

return access_token

def search():

headers = {'Authorization': 'JWT ' + Login()}

for i in range(1,int(PAGECOUNT)):

r = requests.get(url = 'https://api.zoomeye.org/host/search?query=tomcat&page='+str(i),

headers = headers)

response = json.loads(r.text)

for x in response['matches']:

print x['ip']

if __name__ == '__main__':

user = raw_input('[-] PLEASE INPUT YOUR USERNAME:')

passwd = raw_input('[-] PLEASE INPUT YOUR PASSWORD:')

PAGECOUNT = raw_input('[-] PLEASE INPUT YOUR SEARCH_PAGE_COUNT(eg:10):')

search()

这样就取出了你想要的页码的数据,然后就是完善+美观代码了…..

#-*- coding: UTF-8 -*-

import requests

import json

def Login(user,passwd):

data_info = {'username' : user,'password' : passwd}

data_encoded = json.dumps(data_info)

respond = requests.post(url = 'https://api.zoomeye.org/user/login',data = data_encoded)

try:

r_decoded = json.loads(respond.text)

access_token = r_decoded['access_token']

except KeyError:

return '[-] INFO : USERNAME OR PASSWORD IS WRONG, PLEASE TRY AGAIN'

return access_token

def search(queryType,queryStr,PAGECOUNT,user,passwd):

headers = {'Authorization': 'JWT ' + Login(user,passwd)}

for i in range(1,int(PAGECOUNT)):

r = requests.get(url = 'https://api.zoomeye.org/'+ queryType +'/search?query='+queryStr+'&page=' + str(i),

headers = headers)

response = json.loads(r.text)

try:

if queryType == "host":

for x in response['matches']:

print x['ip']

if queryType == "web":

for x in response['matches']:

print x['ip'][0]

except KeyError:

print "[ERROR] No hosts found"

def main():

print " _____ _____ ____ "

print "|__ /___ ___ _ __ ___ | ____| _ ___/ ___| ___ __ _ _ __"

print " / // _ \ / _ \| '_ ` _ \| _|| | | |/ _ \___ \ / __/ _` | '_ \ "

print " / /| (_) | (_) | | | | | | |__| |_| | __/___) | (_| (_| | | | |"

print "/____\___/ \___/|_| |_| |_|_____\__, |\___|____/ \___\__,_|_| |_|"

print " |___/ "

user = raw_input('[-] PLEASE INPUT YOUR USERNAME:')

passwd = raw_input('[-] PLEASE INPUT YOUR PASSWORD:')

PAGECOUNT = raw_input('[-] PLEASE INPUT YOUR SEARCH_PAGE_COUNT(eg:10):')

queryType = raw_input('[-] PLEASE INPUT YOUR SEARCH_TYPE(eg:web/host):')

queryStr = raw_input('[-] PLEASE INPUT YOUR KEYWORD(eg:tomcat):')

Login(user,passwd)

search(queryType,queryStr,PAGECOUNT,user,passwd)

if __name__ == '__main__':

main()

0×03 ShoDanAPI脚本编写

Shodan是互联网上最可怕的搜索引擎。

CNNMoney的一篇文章写道,虽然目前人们都认为谷歌是最强劲的搜索引擎,但Shodan才是互联网上最可怕的搜索引擎。

与谷歌不同的是,Shodan不是在网上搜索网址,而是直接进入互联网的背后通道。Shodan可以说是一款“黑暗”谷歌,一刻不停的在寻找着所有和互联网关联的服务器、摄像头、打印机、路由器等等。每个月Shodan都会在大约5亿个服务器上日夜不停地搜集信息。

Shodan所搜集到的信息是极其惊人的。凡是链接到互联网的红绿灯、安全摄像头、家庭自动化设备以及加热系统等等都会被轻易的搜索到。Shodan的使用者曾发现过一个水上公园的控制系统,一个加油站,甚至一个酒店的葡萄酒冷却器。而网站的研究者也曾使用Shodan定位到了核电站的指挥和控制系统及一个粒子回旋加速器。

Shodan真正值得注意的能力就是能找到几乎所有和互联网相关联的东西。而Shodan真正的可怕之处就是这些设备几乎都没有安装安全防御措施,其可以随意进入。

浅安dalao写过,介绍的也很详细…..

地址传送门:基于ShodanApi接口的调用python版

先说基于API查询。。。官方文档:http://shodan.readthedocs.io/en/latest/tutorial.html

每次查询要扣除1积分…..,而用shodan库模块不需要….

写个简单的,他跟Zoomeye的五五开,就不细写了…

#-*- coding: UTF-8 -*-

import requests

import json

def getip():

API_KEY = *************

url = 'https://api.shodan.io/shodan/host/search?key='+API_KEY+'&query=apache'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87'}

req = requests.get(url=url,headers=headers)

content = json.loads(req.text)

for i in content['matches']:

print i['ip_str']

if __name__ == '__main__':

getip()

接下来,就是基于shodan模块的…直接引用浅安dalao的。。。我懒得写….

安装:pip install shodan

#-*- coding: UTF-8 -*-

import shodan

import sys

API_KEY = ‘YOU_API_KEY’ #调用shodan api

FACETS = [

('country',100), # 匹配出前一百位的国家数量,100可自定义

]

FACET_TITLES = {

'country': 'Top 100 Countries',

}

#输入判断

if len(sys.argv) == 1:

print 'Search Method:Input the %s and then the keyword' % sys.argv[0]

sys.exit()

try:

api = shodan.Shodan(API_KEY)

query = ' '.join(sys.argv[1:])

print "You Search is:" + query

result = api.count(query, facets=FACETS) # 使用count比search快

for facet in result['facets']:

print FACET_TITLES[facet]

for key in result['facets'][facet]:

countrie = '%s : %s' % (key['value'], key['count'])

print countrie

with open(u"搜索" + " " + query + " " + u"关键字" +'.txt','a+') as f:

f.write(countrie +"\n")

f.close()

print " "

print "save is coutures.txt"

print "Search is Complete."

except Exception, e:

print 'Error: %s' % e

0×04 简易BaiduURL采集脚本编写

先是爬去单页的URL,举个栗子是爬去阿甫哥哥这个关键字的URL

#-*- coding: UTF-8 -*-

import requests

from bs4 import BeautifulSoup as bs

import re

def getfromBaidu(word):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87'}

url = 'https://www.baidu.com.cn/s?wd=' + word + '&pn=1'

html = requests.get(url=url,headers=headers,timeout=5)

soup = bs(html.content, 'lxml', from_encoding='utf-8')

bqs = soup.find_all(name='a', attrs={'data-click':re.compile(r'.'), 'class':None})

for i in bqs:

r = requests.get(i['href'], headers=headers, timeout=5)

print r.url

if __name__ == '__main__':

getfromBaidu('阿甫哥哥')

然后是多页的爬取,比如爬取前20页的

#-*- coding: UTF-8 -*-

import requests

from bs4 import BeautifulSoup as bs

import re

def getfromBaidu(word,pageout):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87'}

for k in range(0,(pageout-1)*10,10):

url = 'https://www.baidu.com.cn/s?wd=' + word + '&pn=' + str(k)

html = requests.get(url=url,headers=headers,timeout=5)

soup = bs(html.content, 'lxml', from_encoding='utf-8')

bqs = soup.find_all(name='a', attrs={'data-click':re.compile(r'.'), 'class':None})

for i in bqs:

r = requests.get(i['href'], headers=headers, timeout=5)

print r.url

if __name__ == '__main__':

getfromBaidu('阿甫哥哥',10)

0×05 【彩蛋篇】论坛自动签到脚本

之前其实贴出来了,只是怕有些人没看到….在分享一次….

签到可以获取大量魔法币….他的多种获取方法,请戳:

https://bbs.ichunqiu.com/thread-36007-1-1.html

实现方法只需要将COOKIE修改为你的即可

实现功能是每天24点自动签到…挂在服务器上即可….

#-*- coding: UTF-8 -*-

import requests

import datetime

import time

import re

def sign():

url = 'https://bbs.ichunqiu.com/plugin.php?id=dsu_paulsign:sign'

cookie = {'__jsluid':'3e29e6c**********8966d9e0a481220',' UM_distinctid':'1605f635c78159************016-5d4e211f-1fa400-1605f635c7ac0',' pgv_pvi':'4680553472',******...........}

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87'}

r = requests.get(url=url,cookies=cookie,headers=headers)

rows = re.findall(r'<input type=\"hidden\" name=\"formhash\" value=\"(.*?)\" />', r.content)

if len(rows)!=0:

formhash = rows[0]

print '[-]Formhash is: ' + formhash

else:

print '[-]None formhash!'

if '您今天已经签到过了或者签到时间还未开始' in r.text:

print '[-]Already signed!!'

else:

sign_url = 'https://bbs.ichunqiu.com/plugin.php?id=dsu_paulsign:sign&operation=qiandao&infloat=1&inajax=1'

sign_payload = {

'formhash':formhash,

'qdxq':'fd',

'qdmode':'2',

'todaysay':'',

'fastreply':0,

}

sign_req = requests.post(url=sign_url,data=sign_payload,headers=headers,cookies=cookie)

if '签到成功' in sign_req.text:

print '[-]Sign success!!'

else:

print '[-]Something error...'

time.sleep(60)

def main(h=0, m=0):

while True:

while True:

now = datetime.datetime.now()

if now.hour==h and now.minute==m:

break

time.sleep(20)

sign()

if __name__ == '__main__':

main()

>>>>>> 黑客入门必备技能 带你入坑和逗比表哥们一起聊聊黑客的事儿,他们说高精尖的技术比农药都好玩~

Python大法之告别脚本小子系列—各类URL采集器编写的更多相关文章

- Python大法之告别脚本小子系列—信息资产收集类脚本编写(下)

作者:阿甫哥哥 原文来自:https://bbs.ichunqiu.com/article-1618-1.html 系列文章专辑:Python大法之告别脚本小子系列目录: 0×05 高精度字典生成脚本 ...

- 5. Python大法之告别脚本小子--各类URL采集器编写

在i春秋上面,有很多不错的脚本: https://bbs.ichunqiu.com/forum.php?mod=collection&action=view&ctid=137 http ...

- Python大黑阔—url采集+exp验证,带你批量测试

i春秋作家:大木瓜 前言: 最近几天在整理从各处收集来的各种工具包,大大小小的塞满了十几个G的硬盘,无意间发现了一个好几年前的0day.心血来潮就拿去试了一下,没想到真的还可以用,不过那些站点都已经老 ...

- [Python] 利用Django进行Web开发系列(二)

1 编写第一个静态页面——Hello world页面 在上一篇博客<[Python] 利用Django进行Web开发系列(一)>中,我们创建了自己的目录mysite. Step1:创建视图 ...

- 第二弹:超全Python学习资源整理(进阶系列)

造一个草原要一株三叶草加一只蜜蜂.一株三叶草,一只蜂,再加一个梦.要是蜜蜂少,光靠梦也行. - 狄金森 "成为编程大牛要一门好语言加一点点天分.一门好语言,一点点天分,再加一份坚持.要是天分 ...

- $《利用Python进行数据分析》学习笔记系列——IPython

本文主要介绍IPython这样一个交互工具的基本用法. 1. 简介 IPython是<利用Python进行数据分析>一书中主要用到的Python开发环境,简单来说是对原生python交互环 ...

- 脚本小子学习--vulnhub靶机DC8

@ 目录 前言 一.环境搭建 二.目标和思路 三.实际操作 1.信息收集 2.getshell 总结 前言 通过一些靶机实战练习,学习使用现有的工具来成为脚本小子. 一.环境搭建 靶机:Linux虚拟 ...

- leetcode-Spiral Matrix II 螺旋矩阵2之python大法好,四行就搞定,你敢信?

Spiral Matrix II 螺旋矩阵 Given an integer n, generate a square matrix filled with elements from 1 to n2 ...

- python 暴力破解密码脚本

python 暴力破解密码脚本 以下,仅为个人测试代码,环境也是测试环境,暴力破解原理都是一样的, 假设要暴力破解登陆网站www.a.com 用户 testUser的密码, 首先,该网站登陆的验证要支 ...

随机推荐

- 【Web】前端文件上传,带进度条

最近做项目发现,在文件上传的过程中,增加进度条,能大大改善用户体验.本例介绍带进度条的文件上传 环境搭建 参考:[Java]JavaWeb文件上传和下载. 原生ajax上传带进度条 <%@ pa ...

- Github 快速上手实战教程

一.实验介绍 1.1 实验内容 本次课程讲的是在实验楼的在线环境中,如何使用 Github 去管理在在线环境中使用的代码.配置.资源等实验相关文件,怎样去添加.同步和下拉在远程仓库中的实验文件,以此来 ...

- 2018.10.29 bzoj4564: [Haoi2016]地图(仙人掌+莫队)

传送门 根据原图建一棵新的树. 把原图每一个环上除了深度最浅的点以外的点全部向深度最浅的点连边. 然后可以搞出来一个dfsdfsdfs. 这个时候我们就成功把问题转换成了对子树的询问. 然后就可以对权 ...

- 2018.06.27 NOIP模拟 节目(支配树+可持久化线段树)

题目背景 SOURCE:NOIP2015-GDZSJNZX(难) 题目描述 学校一年一度的学生艺术节开始啦!在这次的艺术节上总共有 N 个节目,并且总共也有 N 个舞台供大家表演.其中第 i 个节目的 ...

- zookeeper 单机集成部署

概述 ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,它包含一个简单的原语集,分布式应用程序可以基于它实现同步服务,配置维护和命名服务等,是很多分布式的基础设置,比如dubbo,k ...

- vue的过渡和动画

简单过渡 .fade-enter-active, .fade-leave-active { transition: all .5s; } /*.fade-enter, .fade-leave-to { ...

- HBase thrift2 TIOError

如果HBase thrift2报:"TIOError exception: Default TException", 这个可能是因为操作的表不存在,不一定是网络或磁盘操作异常. H ...

- app.json

APP.JSON 文件来对微信小程序进行全局配置,决定页面文件的路径.窗口表现.设置网络超时时间.设置多 TAB 等.相当于iOS开发中的AppDelegate 注意该文件不可添加任何注释. { ...

- C#-.Net Framework和.Net Compact Framework-摘

.Net Compact Framework 一种独立于硬件的环境,用于在资源受限制的计算设备上运行程序.它继承了公共语言运行时的完整 .NET Framework 结构,支持 .NET Framew ...

- c语言:辗转相除法求最大公约数、最小公倍数

辗转相除法,又称欧几里得算法.两个正整数a和b(a>b),它们的最大公约数等于余数c和较小的数b之间的最大公约数.最小公倍数=两数之积/最大公约数 #include <stdio.h> ...