transformers---BERT

transformers---BERT

BERT模型主要包括两个部分,encoder和decoder,encoder可以理解为一个加强版的word2vec模型,以下是对于encoder部分的内容

预训练任务

- MLM任务

MLM任务通过单词表示来表示上下文关系 - NSP任务

NSP任务通过句子向量表示句间的关系

1. BERT模型的输入

- wordpiece embedding 单词向量

- position embedding 位置编码向量

两种生成方式:- 相对位置编码

\[PE_{(pos,2i)}=sin(\frac{pos}{10000^{\frac{2i}{model}}})

\]\[PE_{(pos,2i+1)}=cos(\frac{pos}{10000^{\frac{2i}{model}}})

\] - 通过模型学习生成

- 相对位置编码

- segment embedding 区分文中的上下句,应用在问答匹配中

2. self-attention

句子向量

\(\downarrow \ \ \ \ \downarrow\)Input Embedding + Position Embedding

\(\downarrow\)- \[X_{embedding}\in R^{batch size\ *\ seq len\ *\ embed dim}

\]\(\downarrow\) 线性映射(学到多重含义,分配三个权重(\(W_Q,W_k,W_v\))

\(Q=Linear(X_{embedding})=X_{embedding}W_Q\)

\(K=Linear(K_{embedding})=K_{embedding}W_K\)

\(V=Linear(V_{embedding})=V_{embedding}W_V\)

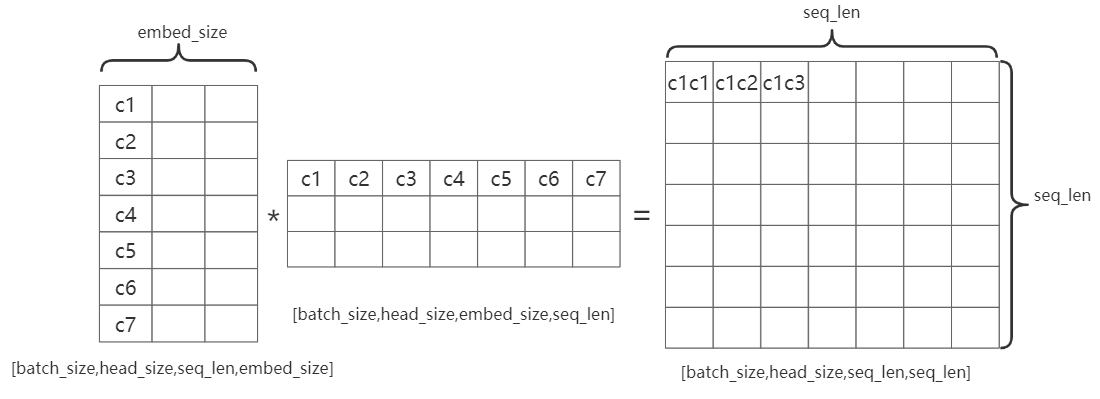

\(\downarrow\) multi head atention(\(head size=embed dim/head size\))\(Q,K,V \rightarrow[batch size,seq len,head size,embed dim/h\)

\((Q,K,V)^T \rightarrow[batch size,head size,

seq len,embed dim/h]\)head_size:即多头注意力机制中的head, \(head size=embed dim/head num\)

embed_size:句子中每个字的编码向量的长度

seq_len:句子的长度

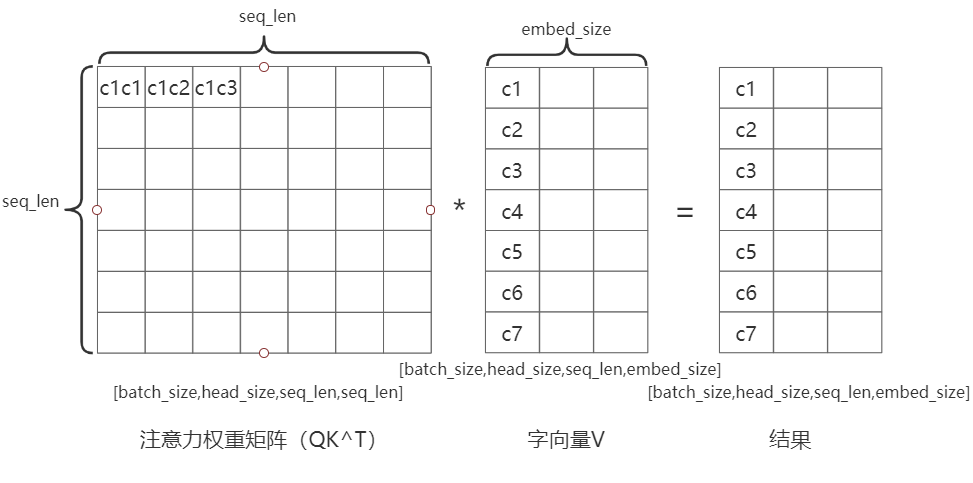

如图:C1C2表示第一个字和第二个字的注意力机制结果

\(Attention(Q,K,V)=softmax(\frac{QK^T}{\sqrt{d_k}})V\)

\(\frac{QK^T}{\sqrt{d_k}}\)的第一列和\(V\)的第一行决定了结果中的第一个值,这样保证了结果向量中每个元素包含了该句中所有字的特征note:

Attention mask

在encoder的过程中,输入句子的\(seq len\)是不等长的,此时需要对句子进行补全,如果使用0补全,使用softmax函数\(softmax=\sigma(z)=\frac{e^{z_i}}{\sum^{k}_{j=1}e^{z_j}}\),e=0时,将导致补0的部分参与到运算中

解决办法:给补0的部分添加偏置\(Z_{illeagl}=Z_{illeagl}+bias ,\ bias\rightarrow -\infty\)

此时,\(e^{-\infty}=0 ,\ e^{Z_{illegal}}=0\),便面了无效区参与运算。

3. Layer Normalization 残差连接

- \(X=X_{embedding}+Attention(Q,K,V)\)

transformers---BERT的更多相关文章

- BERT论文解读

本文尽量贴合BERT的原论文,但考虑到要易于理解,所以并非逐句翻译,而是根据笔者的个人理解进行翻译,其中有一些论文没有解释清楚或者笔者未能深入理解的地方,都有放出原文,如有不当之处,请各位多多包含,并 ...

- (转) Using the latest advancements in AI to predict stock market movements

Using the latest advancements in AI to predict stock market movements 2019-01-13 21:31:18 This blog ...

- BERT(Bidirectional Encoder Representations from Transformers)

BERT的新语言表示模型,它代表Transformer的双向编码器表示.与最近的其他语言表示模型不同,BERT旨在通过联合调节所有层中的上下文来预先训练深度双向表示.因此,预训练的BERT表示可以通过 ...

- BERT(Bidirectional Encoder Representations from Transformers)理解

BERT的新语言表示模型,它代表Transformer的双向编码器表示.与最近的其他语言表示模型不同,BERT旨在通过联合调节所有层中的上下文来预先训练深度双向表示.因此,预训练的BERT表示可以通过 ...

- 文本分类实战(十)—— BERT 预训练模型

1 大纲概述 文本分类这个系列将会有十篇左右,包括基于word2vec预训练的文本分类,与及基于最新的预训练模型(ELMo,BERT等)的文本分类.总共有以下系列: word2vec预训练词向量 te ...

- 【译】BERT表示的可解释性分析

目录 从词袋模型到BERT 分析BERT表示 不考虑上下文的方法 考虑语境的方法 结论 本文翻译自Are BERT Features InterBERTible? 从词袋模型到BERT Mikol ...

- 【译】为什么BERT有3个嵌入层,它们都是如何实现的

目录 引言 概览 Token Embeddings 作用 实现 Segment Embeddings 作用 实现 Position Embeddings 作用 实现 合成表示 结论 参考文献 本文翻译 ...

- 深入理解BERT Transformer ,不仅仅是注意力机制

来源商业新知网,原标题:深入理解BERT Transformer ,不仅仅是注意力机制 BERT是google最近提出的一个自然语言处理模型,它在许多任务 检测上表现非常好. 如:问答.自然语言推断和 ...

- 采用Google预训bert实现中文NER任务

本博文介绍用Google pre-training的bert(Bidirectional Encoder Representational from Transformers)做中文NER(Name ...

- 【中文版 | 论文原文】BERT:语言理解的深度双向变换器预训练

BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding 谷歌AI语言组论文<BERT:语言 ...

随机推荐

- 2020年秋游戏开发-Gluttonous Snake

此作业要求参考https://edu.cnblogs.com/campus/nenu/2020Fall/homework/11577 GitHub地址为https://github.com/15011 ...

- jekins

上面是:maven配置 git安装: 容器安装: 容器配置与发布: 添加安全认证(如果tomcat没有设置密码这里也不需要设置:) 访问尝试:本地测试前置practice_war的影响 Jekins实 ...

- rabbitMq内存与磁盘分配问题

在服务器上也可以改变配置文件修改内存 也可以使用命令进行分配: 相对内存:rabbitmqctl set_vm_memory_hgih_waterwmark 0.4 使用时可以把这个0.4替 ...

- element-ui 用 el-checkbox-group 做权限管理

template <el-checkbox-group v-model="menu_ide" v-for="(item,index) in menu_idss&qu ...

- kubernetes 使用 PV 和 PVC 管理数据存储

文章链接 容器磁盘上的文件的生命周期是短暂的,这就使得在容器中运行重要应用时会出现一些问题.首先,当容器崩溃时,kubelet 会重启它,但是容器中的文件将丢失--容器以干净的状态(镜像最初的状态)重 ...

- Spring Cloud Eureka 实践(二)

接上一篇的内容,Eureka服务已经启动成功后,可以尝试开发服务的提供者与消费者,并注册到Eureka来实现服务的发现与调用. 首先,在父工程中继续创建服务提供者的Module,最新的目录结构如下图所 ...

- JS001. antd vue遍历setFieldsValue表单键值对无效 ( {} -> new Object() )

问题代码: const tempFieldsValue = this.form.getFieldsValue() Object.keys(tempFieldsValue).map((k) => ...

- 'Specifying a namespace in include() without providing an app_name '报错解决

需要在每个ap下面的url.py 加入一个指定app的名字 比如 user app 下的 url.py 文件加入: urlpatterns = []app_name = "user& ...

- 个人作业——CVPR顶会论文爬取

main.py #保存单个界面数据 def getInfo(url): # url='https://openaccess.thecvf.com/WACV2021' header={ 'User-Ag ...

- 【死磕NIO】— 阻塞、非阻塞、同步、异步,傻傻分不清楚

万事从最基本的开始. 要想完全掌握 NIO,并不是掌握上面文章([死磕NIO]- NIO基础详解)中的三大组件就可以了,我们还需要掌握一些基本概念,如什么是 IO,5 种IO模型的区别,什么是阻塞&a ...