python爬取疫情数据存入MySQL数据库

import requests

from bs4 import BeautifulSoup

import json

import time

from pymysql import * def mes():

url = 'https://ncov.dxy.cn/ncovh5/view/pneumonia?from=timeline&isappinstalled=0' #请求地址

headers = {'user-agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.87 Safari/537.36 SLBrowser/6.0.1.6181'}#创建头部信息

resp = requests.get(url,headers = headers) #发送网络请求

content=resp.content.decode('utf-8')

soup = BeautifulSoup(content, 'html.parser')

listA = soup.find_all(name='script',attrs={"id":"getAreaStat"})

account =str(listA)

mes = account.replace('[<script id="getAreaStat">try { window.getAreaStat = ', '')

mes=mes.replace('}catch(e){}</script>]','')

#mes=account[52:-21]

messages_json = json.loads(mes)

print(messages_json)

times=time.strftime('%Y-%m-%d %H:%M:%S', time.localtime(time.time()))

print(times)

provinceList=[]

cityList=[]

lenth=total()

con=len(messages_json)+lenth#算出数据库已有的条数+今天省份的条数,才是城市的开始id

for item in messages_json:

lenth+=1

provinceName=item['provinceName']

confirmedCount=item['confirmedCount']

suspectedCount=item['suspectedCount']

curedCount=item['curedCount']

deadCount=item['deadCount']

cities=item['cities']

provinceList.append((lenth,times,provinceName,None,confirmedCount,suspectedCount,curedCount,deadCount))

for i in cities:

con+=1

provinceName = item['provinceName']

cityName=i['cityName']

confirmedCount = i['confirmedCount']

suspectedCount = item['suspectedCount']

curedCount = i['curedCount']

deadCount = i['deadCount']

cityList.append((con,times,provinceName,cityName,confirmedCount,suspectedCount,curedCount,deadCount))

insert(provinceList,cityList) def insert(provinceList, cityList):

provinceTuple=tuple(provinceList)

cityTuple=tuple(cityList)

cursor = db.cursor()

sql = "insert into info_new values (%s,%s,%s,%s,%s,%s,%s,%s) "

try:

cursor.executemany(sql,provinceTuple)

print("插入成功")

db.commit()

except Exception as e:

print(e)

db.rollback()

try:

cursor.executemany(sql,cityTuple)

print("插入成功")

db.commit()

except Exception as e:

print(e)

db.rollback()

cursor.close()

def total():

sql= "select * from info_new"

cursor = db.cursor()

try:

cursor.execute(sql)

results = cursor.fetchall()

lenth = len(results)

db.commit()

return lenth

except:

print('执行失败,进入回调1')

db.rollback() # 连接数据库的方法

def connectDB():

try:

db = connect(host='localhost', port=3306, user='root', password='password', db='virus',charset='utf8')

print("数据库连接成功")

return db

except Exception as e:

print(e)

return NULL

if __name__ == '__main__':

db=connectDB()

mes()

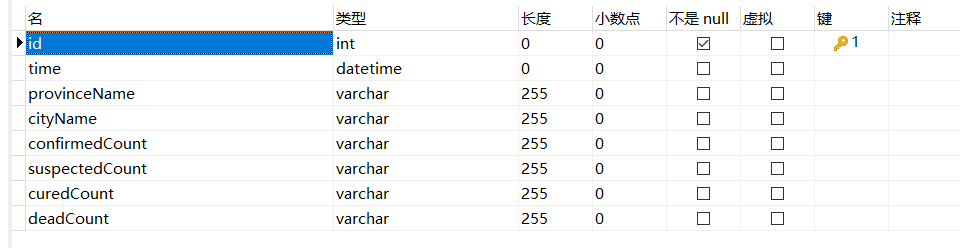

数据库结构:

python爬取疫情数据存入MySQL数据库的更多相关文章

- python爬取疫情数据详解

首先逐步分析每行代码的意思: 这是要引入的东西: from os import path import requests from bs4 import BeautifulSoup import js ...

- 利用Python爬取疫情数据并使用可视化工具展示

import requests, json from pyecharts.charts import Map, Page, Pie, Bar from pyecharts import options ...

- Python爬取豆瓣音乐存储MongoDB数据库(Python爬虫实战1)

1. 爬虫设计的技术 1)数据获取,通过http获取网站的数据,如urllib,urllib2,requests等模块: 2)数据提取,将web站点所获取的数据进行处理,获取所需要的数据,常使用的技 ...

- 如何使用Python爬取基金数据,并可视化显示

本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理 以下文章来源于Will的大食堂,作者打饭大叔 前言 美国疫情越来越严峻,大选也进入 ...

- 毕设之Python爬取天气数据及可视化分析

写在前面的一些P话:(https://jq.qq.com/?_wv=1027&k=RFkfeU8j) 天气预报我们每天都会关注,我们可以根据未来的天气增减衣物.安排出行,每天的气温.风速风向. ...

- 使用selenium再次爬取疫情数据(链接数据库)

爬取网页地址: 丁香医生 数据库连接代码: def db_connect(): try: db=pymysql.connect('localhost','root','zzm666','payiqin ...

- 用Python爬取股票数据,绘制K线和均线并用机器学习预测股价(来自我出的书)

最近我出了一本书,<基于股票大数据分析的Python入门实战 视频教学版>,京东链接:https://item.jd.com/69241653952.html,在其中用股票范例讲述Pyth ...

- python爬取网站数据

开学前接了一个任务,内容是从网上爬取特定属性的数据.正好之前学了python,练练手. 编码问题 因为涉及到中文,所以必然地涉及到了编码的问题,这一次借这个机会算是彻底搞清楚了. 问题要从文字的编码讲 ...

- Python爬取房产数据,在地图上展现!

小伙伴,我又来了,这次我们写的是用python爬虫爬取乌鲁木齐的房产数据并展示在地图上,地图工具我用的是 BDP个人版-免费在线数据分析软件,数据可视化软件 ,这个可以导入csv或者excel数据. ...

随机推荐

- shell脚本——awk

目录 一.awk 1.1.awk简介 1.2.基本格式 1.3.工作原理 1.4.常见的内建变量(可直接用) 按字段输出文本 1.5.awk和getline 有重定向符 无重定向符 1.6.指定分隔符 ...

- 【笔记】numpy.array基础(1)

numpy.array基础 使用numpy.__version__可以检查numpy的版本 当然也可以直接使用命令行检查numpy版本 也可以用来简化引用,使用as python list特点 num ...

- K8S日志接入sls配置

背景 原有日志方案查询日志很不方便且效率低,而且也不支持基于日志的高级操作.如:聚合,图形展示,关键字检测等. 方案 接入阿里云的sls日志服务. 实施 1.通过环境变量进行日志接入 配置如下: 字段 ...

- netty系列之:netty中的懒人编码解码器

目录 简介 netty中的内置编码器 使用codec要注意的问题 netty内置的基本codec base64 bytes compression json marshalling protobuf ...

- 我这三年被kafka坑惨了

前言 我的上家公司是做餐饮系统的,每天中午和晚上用餐高峰期,系统的并发量不容小觑.为了保险起见,公司规定各部门都要在吃饭的时间轮流值班,防止出现线上问题时能够及时处理. 我当时在后厨显示系统团队,该系 ...

- selenium处理:您的连接不是私密连接的网站(https ssl 证书)

当前我们遇到这样的问题,就要通过代码的层面去解决 requests的话verify参数设置为False selenium的话添加参数:--ignore-certificate-errors 测试代码: ...

- Java Slf4j日志配置输出到文件中

1.概述 新项目需要增加日志需求,所以网上找了下日志配置,需求是将日志保存到指定文件中.网上找了下文章,发现没有特别完整的文章,下面自己整理下. 1.Java日志概述 对于一个应用程序来说日志记录是必 ...

- 《深入理解java虚拟机》第3版笔记3

第3章 垃圾收集器与内存分配策略 可达性分析算法 在Java技术体系里面,固定可作为GC Roots的对象包括以下几种: 在虚拟机栈(栈帧中的本地变量表)中引用的对象,譬如各个线程被调用的方法堆栈中使 ...

- 刷题-力扣-230. 二叉搜索树中第K小的元素

230. 二叉搜索树中第K小的元素 题目链接 来源:力扣(LeetCode) 链接:https://leetcode-cn.com/problems/kth-smallest-element-in-a ...

- VSCode中相对路径设置问题

使用的版本 对于import xxx操作,相对路径为sys.path 对于open("test.txt",'r')文件打开操作,相对路径为os.getcwd() 对于termina ...