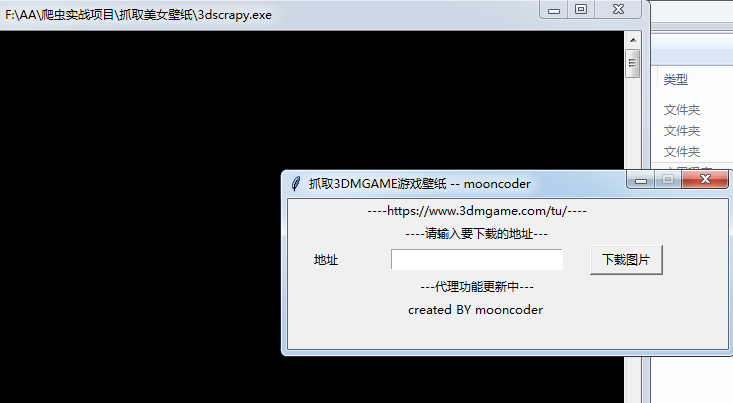

python(29)Tinker+BeautifulSoup+Request抓取美女壁纸

原文链接:http://www.limerence2017.com/2019/10/22/python29/

抓取准备

今天是10月24日,祝所有程序员节日快乐。今天打算写个爬虫抓取3DMGAME论坛美女cosplay壁纸。

论坛首页网址为https://www.3dmgame.com/tu_53_1/

我们点击其中一个图集,然后网页跳转,看下源码

<div class="dg-wrapper">

<a data-src = "/uploads/images/thumbpicfirst/20190730/1564452665_126346.jpg">

<div class="img"><img src="https://img.3dmgame.com/uploads/images/thumbpicfirst/20190730/1564452665_126346.jpg"></div>

<div class="miaoshu">

<p></p>

<div class="num"><i></i> /<u></u></div>

</div>

</a>

<a data-src = "/uploads/images/thumbpicfirst/20190730/1564452665_242197.jpg">

<div class="img"><img src="https://img.3dmgame.com/uploads/images/thumbpicfirst/20190730/1564452665_242197.jpg"></div>

<div class="miaoshu">

<p></p>

<div class="num"><i></i> /<u></u></div>

</div>

</a>

网址是静态的,我们直接提取其中的图片链接再下载即可。

抓取网页采用的是python的requests库,直接发送http请求即可。收到回包后,通过BeautifulSoup提炼其中图片地址再次下载即可。

另外我们的界面用的是python自带的Tinker编写的。

代码实现

实现线程装饰器

def thread_run(func):

def wraper(*args, **kwargs):

t = threading.Thread(target=func, args=args, kwargs=kwargs)

t.daemon = True

t.start() return wraper

我们实现了DownloadFrame类封装了一个装饰器,启动线程并调用传入的函数。

类里实现如下方法

def prepare(self, downloadlinks):

self.flag = True

self.downloadlinks = downloadlinks

self.base_url = self.downloadlinks fail = 0 try:

url = self.base_url

result = requests.get(url, headers=HEADERS,timeout=10)

restxt = result.content.decode('UTF-8')

soup = BeautifulSoup(restxt,'lxml')

titles = soup.select('div .bt')

if titles is None or len(titles)==0:

print("html page res not found ! \n")

return

title = re.split(r'[;,\s]',titles[0].text)[0]

curdir = os.path.dirname(os.path.abspath(__file__))

picpath = os.path.join(curdir,title)

if not os.path.exists(picpath):

os.mkdir(picpath)

print(picpath)

imglist = soup.select('.dg-wrapper img')

if imglist is None or len(imglist)==0:

print("html page res not found ! \n")

return

self.downloadPic(imglist,picpath)

except Exception as e:

print(e)

time.sleep(3)

prpare函数实现了请求指定网页,并用BeautifulSoup处理回包的功能。

@thread_run

def download(self, url, path):

try:

if lock.acquire():

self.name += 1

imgname = str(self.name)+'.'+url.split('.')[-1]

filename = os.path.join(path,imgname)

lock.release()

print(url)

print(filename)

# res = requests.get(url, headers=header )

res = requests.get(url, headers=HEADERS,timeout=10 )

with open(filename, 'wb') as f:

f.write(res.content)

# 下载完后检查是否完成下载

if lock.acquire():

if self.flag:

self.flag = False

messagebox.showinfo("提示", "下载完成")

lock.release() except Exception as e:

print(e)

效果展示download传给了我们之前封装的装饰器thread_fun, download实现了下载指定图片的功能。

下载图片

感谢关注我的公众号

源码下载

python(29)Tinker+BeautifulSoup+Request抓取美女壁纸的更多相关文章

- Python爬虫实战六之抓取爱问知识人问题并保存至数据库

大家好,本次为大家带来的是抓取爱问知识人的问题并将问题和答案保存到数据库的方法,涉及的内容包括: Urllib的用法及异常处理 Beautiful Soup的简单应用 MySQLdb的基础用法 正则表 ...

- python爬虫beta版之抓取知乎单页面回答(low 逼版)

闲着无聊,逛知乎.发现想找点有意思的回答也不容易,就想说要不写个爬虫帮我把点赞数最多的给我搞下来方便阅读,也许还能做做数据分析(意淫中--) 鉴于之前用python写爬虫,帮运营人员抓取过京东的商品品 ...

- Python爬虫实战四之抓取淘宝MM照片

原文:Python爬虫实战四之抓取淘宝MM照片其实还有好多,大家可以看 Python爬虫学习系列教程 福利啊福利,本次为大家带来的项目是抓取淘宝MM照片并保存起来,大家有没有很激动呢? 本篇目标 1. ...

- 一次Python爬虫的修改,抓取淘宝MM照片

这篇文章是2016-3-2写的,时隔一年了,淘宝的验证机制也有了改变.代码不一定有效,保留着作为一种代码学习. 崔大哥这有篇>>小白爬虫第一弹之抓取妹子图 不失为学python爬虫的绝佳教 ...

- 利用python脚本(xpath)抓取数据

有人会问re和xpath是什么关系?如果你了解js与jquery,那么这个就很好理解了. 上一篇:利用python脚本(re)抓取美空mm图片 # -*- coding:utf-8 -*- from ...

- 利用Nodejs & Cheerio & Request抓取Lofter美女图片

还是参考了这篇文章: http://cnodejs.org/topic/54bdaac4514ea9146862abee 另外有上面文章 nodejs抓取网易公开课的一些经验. 代码如下,注意其中用到 ...

- Python爬虫 —— 抓取美女图片

代码如下: #coding:utf-8 # import datetime import requests import os import sys from lxml import etree im ...

- python:利用asyncio进行快速抓取

web数据抓取是一个经常在python的讨论中出现的主题.有很多方法可以用来进行web数据抓取,然而其中好像并没有一个最好的办法.有一些如scrapy这样十分成熟的框架,更多的则是像mechanize ...

- Python实现简单的网页抓取

现在开源的网页抓取程序有很多,各种语言应有尽有. 这里分享一下Python从零开始的网页抓取过程 第一步:安装Python 点击下载适合的版本https://www.python.org/ 我这里选择 ...

随机推荐

- 最全的PHP正则表达式

一.校验数字的表达式 1 数字:^[0-9]*$2 n位的数字:^\d{n}$3 至少n位的数字:^\d{n,}$4 m-n位的数字:^\d{m,n}$5 零和非零开头的数字:^(0|[1-9][0- ...

- C#工具:ASP.net 调用SQLserver帮助类

一.正常调用 1.创建DBHelper帮助类 2.复制以下代码到类中 using System; using System.Collections.Generic; using System.Data ...

- Java-生成缩略图工具类

import java.awt.Color; import java.awt.Graphics2D; import java.awt.Image; import java.awt.RenderingH ...

- robotframework 获取坐标

Get Horizontal Position 获取X轴坐标 Get Vertical Position 获取Y轴坐标 Get Element Size 获取整个图表的高 ...

- css百分比值到底参考谁?

一.元素宽高设置百分比 (1)width / min-width / max-width 参考块级父元素的宽度 (2)height / min-height / max-height 参考块级父元素的 ...

- C/C++ - malloc/free和new/delete的区分

new/delete与malloc/free的区别主要表现在以下几个方面: 注意:最主要的区别,new/delete是运算符,而malloc/free是函数 (1).new能够自动计算需要分配的内存空 ...

- 一步一步理解线段树——转载自JustDoIT

一步一步理解线段树 目录 一.概述 二.从一个例子理解线段树 创建线段树 线段树区间查询 单节点更新 区间更新 三.线段树实战 -------------------------- 一 概述 线段 ...

- Centos 7禁止ftdi_sio模块

$ dmesg[ 3305.097301] usb 1-1: USB disconnect, device number 7[ 3306.883704] usb 1-1: new high-speed ...

- Java集合框架之简述

Java集合框架简述 Java中的集合类是一种工具类,就像是容器,存储任意数量的具有共同属性的对象,集合框架是一个用来代表和操纵集合的统一架构,包含如下部分: 1.接口: 接口是代表集合的抽象数据类型 ...

- HDU 5115 Dire Wolf ——(区间DP)

比赛的时候以为很难,其实就是一个区间DP= =..思路见:点我. 区间DP一定要记住先枚举区间长度啊= =~!因为区间dp都是由短的区间更新长的区间的,所以先把短的区间更新完.. 代码如下: #inc ...