sqoop导出数据

export是HDFS里的文件导出到RDBMS的工具,不能从hive、hbase导出数据,且HDFS文件只能是文本格式。如果要把hive表数据导出到RDBMS,可以先把hive表通过查询写入到一个临时表,临时用文本格式,然后再从该临时表目录里export数据。

HDFS导出数据到MySQL

说明:

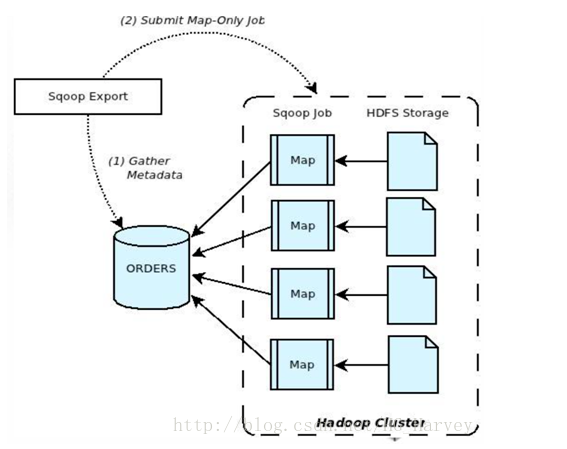

(1).Sqoop与数据库通信,获取数据库表的元数据信息;

(2).将Hadoop上的文件划分成若干个Split,每个Split由一个Map Task进行数据导出操作;

参数

--columns:指定插入目标数据库的字段,sqoop直接读取hdfs文件并把记录解析成多个字段,此时解析后的记录是没有字段名的

是通过位置和columns列表对应的,数据库插入的sql类似于:

insert into _table (c1,c2...) value(v1,v2...)

--export-dir:指定HDFS输入文件的目录

--input-fields-terminated-by:字段之间分隔符

--input-lines-terminated-by:行分隔符

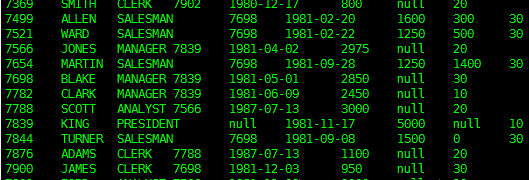

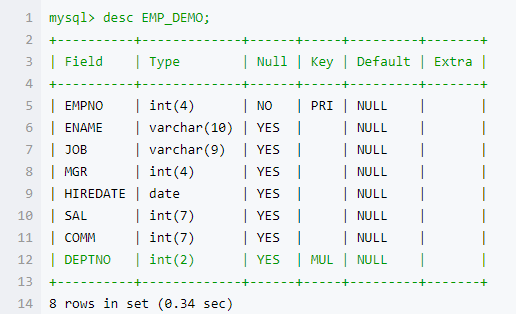

sqoop不会在mysql中自动创建表,在mysql中创建表EMP_DEMO

CREATE TABLE EMP_DEMO(

EMPNO int() PRIMARY KEY,

ENAME VARCHAR(),

JOB VARCHAR(),

MGR int(),

HIREDATE DATE,

SAL int(),

COMM int(),

DEPTNO int(),

foreign key(deptno) references DEPT(DEPTNO)

);

导出数据到mysql

sqoop export \

--connect jdbc:mysql://localhost:3306/sqoop \

--username root --password P@ssw0rd \

--table EMP_DEMO \

--export-dir /user/hadoop/EMP \

-m

导出指定的列(–columns)

sqoop export \

--connect jdbc:mysql://localhost:3306/sqoop \

--username root --password P@ssw0rd \

--table EMP_DEMO \

--columns "EMPNO,ENAME,JOB,SAL,COMM" \

--export-dir /user/hadoop/EMP_COLUMN \

-m

导出数据时设置字段与字段、行与行之间的分隔符

hdfs中/user/hadoop下EMP_SPLIT文件中的数据是我们前面通过mysql导入的,使用了分隔符,所以在导出时也需要指定分隔符,否则导出不成功。EMP_SPLIT文件内容如下

sqoop export \

--connect jdbc:mysql://localhost:3306/sqoop \

--username root --password P@ssw0rd \

--table EMP_DEMO \

--fields-terminated-by '\t' \

--lines-terminated-by '\n' \

--export-dir /user/hadoop/EMP_SPLIT \

-m

Hive 导出数据到 MySQL

实现需求:将hive 表 emp_import 中的数据导出到 Mysql 表 EMP_DEMO

hive 表 emp_import对应hdfs路径:/user/hive/warehouse/db_test.db/emp_import

mysql 中 EMP_DEMO 表结构如下

注意:mysql中日期为date类型,hive中对应的字段为字符串类型,其存储格式必须为:yyyy-mm-dd

导出时指定null字段的填充符,如果不指定会报一个异常NumberFormatException

–input-null-string:如果没有这个选项,那么在字符串类型列中,字符串”null”会被转换成空字符串,所以最好写上这个,指定为’\N’

–input-null-non-string:如果没有这个选项,那么在非字符串类型的列中,空串和”null”都会被看作是null

sqoop export \

--connect jdbc:mysql://localhost:3306/sqoop \

--username root --password P@ssw0rd \

--table EMP_DEMO \

--export-dir /user/hive/warehouse/db_test.db/emp_import \

--input-fields-terminated-by '\001' \

--input-null-string '\\N' \

--input-null-non-string '\\N' \

-m

sqoop导出数据的更多相关文章

- 1.131.15 Sqoop导出数据Export使用

一.export 1.export概述 export工具将一组文件从HDFS导入到RDBMS.目标表必须已经存在于数据库中.根据用户指定的分隔符读取输入文件并将其解析为一组记录, 只有map: [ro ...

- sqoop导出数据|Hive|HDFS和脚本编写

导出数据 在Sqoop中,“导出”概念指:从大数据集群(HDFS,HIVE,HBASE)向非大数据集群(RDBMS)中传输数据,叫做:导出,即使用export关键字. HIVE/HDFS到RDBMS ...

- 大数据学习——sqoop导出数据

把数据从hadoop导出到关系型数据库 将数据从HDFS导出到RDBMS数据库 导出前,目标表必须存在于目标数据库中. u 默认操作是从将文件中的数据使用INSERT语句插入到表中 u 更新模式下 ...

- 大数据学习之路又之从小白到用sqoop导出数据

写这篇文章的目的是总结自己学习大数据的经验,以为自己走了很多弯路,从迷茫到清晰,真的花费了很多时间,希望这篇文章能帮助到后面学习的人. 一.配置思路 安装linux虚拟机--->创建三台虚拟机- ...

- 利用sqoop将hive数据导入导出数据到mysql

一.导入导出数据库常用命令语句 1)列出mysql数据库中的所有数据库命令 # sqoop list-databases --connect jdbc:mysql://localhost:3306 ...

- Sqooop- 使用Sqoop进行数据的导入导出

Sqoop是Apache旗下的一个开源框架,专门用来做数据的导入和导出. 官网:https://sqoop.apache.org/ Sqoop的安装非常简单,只需要把下载下来的tar包解压设置两个环境 ...

- sqoop与PG库导入导出数据

导入数据到Hive sqoop import --connect jdbc:postgresql://172.66.6.666/radar5g4h --username postgres --pass ...

- sqoop与hbase导入导出数据

环境:sqoop1.4.6+hadoop2.6+hbase1.1+mysql5.7 说明: 1.文中的导入导出的表结构借鉴了网上的某篇博客 2.mysql导入hbase可以直接通过sqoop进行 3. ...

- 第3节 sqoop:6、sqoop的数据增量导入和数据导出

增量导入 在实际工作当中,数据的导入,很多时候都是只需要导入增量数据即可,并不需要将表中的数据全部导入到hive或者hdfs当中去,肯定会出现重复的数据的状况,所以我们一般都是选用一些字段进行增量的导 ...

随机推荐

- WOJ 10 精英选拔

神仙dp,膜Claris 题意:给一个长度为$n$的数列,求出不超过k次交换后的最大连续子区间和. 发现交换后的最优答案一定是这样的(0和2的长度可以为0) 0 ...

- 数据结构 hbb(汉堡包)

数据结构 hbb(汉堡包) 问题描述 汉堡包有收集汉犇犇的癖好,它喜欢把汉犇犇一个叠一个的放置. 因为它有强迫症,所以每当它想放一个新的汉犇犇进去的时候并不一定想直接叠在最上面,简单的说,当他想放第 ...

- 带有通配符的字符串匹配算法-C/C++

日前某君给我出了这样一道题目:两个字符串,一个是普通字符串,另一个含有*和?通配符,*代表零个到多个任意字符,?代表一个任意字符,通配符可能多次出现.写一个算法,比较两个字符串是否相等. 我花了四个小 ...

- Python-第三方库requests详解(附requests中文官方教程)

转自http://blog.csdn.net/cyjs1988/article/details/73294774 Python+requests中文官方教程: http://www.python-re ...

- .net core 2.0 jwt身份认证系统

经历了很久,.net core 2.0 终于发布了! 之前一直用的core 1.1,升级了2.0后发现认证的机制(Auth)发生了比较大的变化,在1.1中认证配置是在Configure中完成,而在2. ...

- Powershell Deploy Service Fabric Application To Local Cluster

之前写过一篇用 Powershell 部署 Service Fabric Application 到本地集群的随笔,感觉过程有点复杂,这次将流程简化,只需要将应用程序打包,加上配置文件就可以了. ...

- 正经学C#_表达式与其运算符[赋值运算符]:《c#入门经典》

上一节中介绍了算术运算符,算术运算符的优先级. 今天说说赋值运算符,不陌生,=[等号]就是赋值运算符的一种. 除此之外还有好多种的.见下图. 运算符 类别 描述 实例 = 二元 简单的赋值运算符,把右 ...

- Android源码树中C代码的编译

侯 Sir说:“源码之下,了无秘密.” 但有些秘密还是要搞起来了看得更真切,仅从静态代码的体位很难体会到运动时的妙处.因此环境搭好了,下一步就是调试.gdbserver搭配gdb的调试环境走得很顺利, ...

- 818. Race Car

Your car starts at position 0 and speed +1 on an infinite number line. (Your car can go into negati ...

- soj 131 找题

soj 131 找题 给出两个长度为n,都含k个1的字符串A,B.现在令\(a_1,a_2,\dots,a_k\)是A中1的下标,\(b_1,b_2,\dots,b_k\)是B中1的下表,然后将a,b ...