人工神经网络(Artificial Neural Networks)

人工神经网络的产生一定程度上受生物学的启发,因为生物的学习系统是由相互连接的神经元相互连接的神经元组成的复杂网络。而人工神经网络跟这个差不多,它是一系列简单的单元相互密集连接而成的。其中每个单元有一定数量的输入(可能是其他单元的输出),并产生单一的实数值输出(可能成为其他单元的输入)。

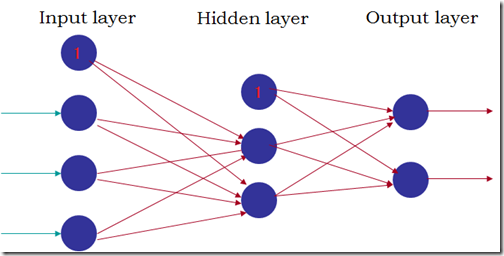

常见的人工神经网络结果如下图:

(1) 网络由三部分组成,输入层、隐藏层和输出层,往往隐藏层只有1层或2层;

(2) 每层由若干个单元组成,所有单元分层互连形成一个无环的前馈网络;

(3) 下一层的某个单元的输入由上一层的所有单元的输出组成,每个输入的权重由相连的边的权值决定。

不同类型的单元对输入的处理方式不同,比较常用是sigmoid单元。sigmoid单元首先对所有输入进行线性组合,然后将线性组合的结果通过sigmoid函数(F(x) = 1/(1+power(e,-x)))映射为0跟1之间的某个值作为输出(sigmoid函数有一个比较有用的特征就是F’(x) = F(x)*( 1-F(x)))。这样,sigmoid单元的输出是输入的非线性函数,并且输出是输入的可微函数。

人工神经网络的学习训练就是为每一条边选取一个合适的权值,使网络输出层的输出和目标值之间的误差平方和最小化。而像反向传播(BackPropagation)这样的算法,就是使用梯度下降来调节各条表的权重,来最佳拟合输入-输出组成的训练数据。

实验:人脸朝向识别

实验数据是具有不同朝向的600多张人脸图片,每个图片的像素是30*32。分为训练集、验证集和测试集,大致图像张数比为6:2:2。训练集用来训练人工神经网络,验证集用来选取在验证集上具有最好性能的网络,而测试集对选中的网络进行最后的评估。

输入:每个像素对应一个网络输入,并且把范围是0-255的亮度值按比例缩放到0-1之间。

输出:使用4个不同的输出单元,每个单元对应一个脸的朝向,取具有最高值的输出作为人脸朝向的预测值。另外,使用0.1和0.9,而不是0和1,例如(0.9,0.1,0.1,01.)表示脸朝向正前方。

网络结构:使用一个隐藏层,隐藏层的单元个数为3个。

其他参数:学习速率设定为0.3,输入单元的权值被设定为0.0,输出单元的权值被初始化为一个较小的随机值。

Python版反向传播算法(随机梯度下降版本)

1.把输入沿网络前向传播

def feedForward(self):

for j in xrange(1,self.hidNum):

sum = 0.0

for i in xrange(self.inNum):

sum += self.inOutput[i]*self.wIn2Hid[i][j]

self.hidOutput[j] = self.sigmoid(sum) for k in xrange(self.outNum):

sum = 0.0

for j in xrange(self.hidNum):

sum += self.hidOutput[j] * self.wHid2Out[j][k]

self.outOutput[k] = self.sigmoid(sum)

2.把误差沿网络反向传播

def backPropagate(self,N=0.3):

# calculate errors for output

for k in xrange(self.outNum):

error = self.targets[k]-self.outOutput[k]

self.outOutputError[k] = self.outOutput[k]*(1-self.outOutput[k])*error # calculate errors for hidden layer

for j in xrange(self.hidNum):

error = 0.0

for k in xrange(self.outNum):

error += self.outOutputError[k]*self.wHid2Out[j][k]

self.hidOutputError[j] = self.hidOutput[j]*(1-self.hidOutput[j])*error # update hid-output weights

for j in xrange(self.hidNum):

for k in xrange(self.outNum):

change = N*self.outOutputError[k]*self.hidOutput[j]

self.wHid2Out[j][k] += change # update input-hid weights

for i in xrange(self.inNum):

for j in xrange(1,self.hidNum):

change = N*self.hidOutputError[j]*self.inOutput[i]

self.wIn2Hid[i][j] += change

实验结果:通过调整输入层、隐藏层中各个单元的权重,网络在验证集上最高的预测准确率是0.892,对应在测试集上的准确率为0.844。

转自本人博客:http://www.datalab.sinaapp.com/

.csharpcode, .csharpcode pre

{

font-size: small;

color: black;

font-family: consolas, "Courier New", courier, monospace;

background-color: #ffffff;

/*white-space: pre;*/

}

.csharpcode pre { margin: 0em; }

.csharpcode .rem { color: #008000; }

.csharpcode .kwrd { color: #0000ff; }

.csharpcode .str { color: #006080; }

.csharpcode .op { color: #0000c0; }

.csharpcode .preproc { color: #cc6633; }

.csharpcode .asp { background-color: #ffff00; }

.csharpcode .html { color: #800000; }

.csharpcode .attr { color: #ff0000; }

.csharpcode .alt

{

background-color: #f4f4f4;

width: 100%;

margin: 0em;

}

.csharpcode .lnum { color: #606060; }

人工神经网络(Artificial Neural Networks)的更多相关文章

- 人工神经网络 Artificial Neural Network

2017-12-18 23:42:33 一.什么是深度学习 深度学习(deep neural network)是机器学习的分支,是一种试图使用包含复杂结构或由多重非线性变换构成的多个处理层对数据进行高 ...

- 吴恩达深度学习第1课第4周-任意层人工神经网络(Artificial Neural Network,即ANN)(向量化)手写推导过程(我觉得已经很详细了)

学习了吴恩达老师深度学习工程师第一门课,受益匪浅,尤其是吴老师所用的符号系统,准确且易区分. 遵循吴老师的符号系统,我对任意层神经网络模型进行了详细的推导,形成笔记. 有人说推导任意层MLP很容易,我 ...

- 循环神经网络(Recurrent Neural Networks, RNN)介绍

目录 1 什么是RNNs 2 RNNs能干什么 2.1 语言模型与文本生成Language Modeling and Generating Text 2.2 机器翻译Machine Translati ...

- 机器学习之Artificial Neural Networks

人类通过模仿自然界中的生物,已经发明了很多东西,比如飞机,就是模仿鸟翼,但最终,这些东西会和原来的东西有些许差异,artificial neural networks (ANNs)就是模仿动物大脑的神 ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第四周:深层神经网络(Deep Neural Networks)-课程笔记

第四周:深层神经网络(Deep Neural Networks) 4.1 深层神经网络(Deep L-layer neural network) 有一些函数,只有非常深的神经网络能学会,而更浅的模型则 ...

- 卷积神经网络Convolutional Neural Networks

Convolutional Neural Networks NOTE: This tutorial is intended for advanced users of TensorFlow and a ...

- Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)

3.1 神经网络概述(Neural Network Overview ) (神经网络中,我们要反复计算a和z,最终得到最后的loss function) 3.2 神经网络的表示(Neural Netw ...

- Ng第八课:神经网络表述(Neural Networks: Representation)

8.1 非线性假设 8.2 神经元和大脑 8.3 模型表示 1 8.4 模型表示 2 8.5 特征和直观理解 1 8.6 样本和直观理解 II 8.7 多类分类 8.1 非线性假设 无 ...

随机推荐

- Windows下使用cmd启动Oracle EM和sql命令使用+主机身份认证

(1)cmd命令下使用sql命令 >sqlplus / as sysdba sql>select * from v$version; (2)cmd命令下启动Oracle EM 安装完ora ...

- HBASE的安装

HBASE的安装: 安装的软件版本:hbase-0.98.4-hadoop2.tar.gz 下载链接:http://www.apache.org/dist/hbase/hbase-0.98.4/ 1. ...

- CGRectOffset与CGRectInset的计算公式

(1)CGRectInset CGRect CGRectInset ( CGRect rect, CGFloat dx, CGFloat dy ); 该结构体的应用是以原rect为中心,再参考dx,d ...

- 肾果手机App Store切换区域(无需Visa或者万事达)

8月份在肾果官网买了个touch6,有时候需要换区去墙外下载app,然而一个个国家都要输入Visa或者万事达卡...今天终于找到一个不用输入信用卡号的区域:Canada!!! 办法(适用于8.X,7. ...

- 简单方法打包.net程序集脱离framework

最近业余捣鼓monogame,自然而然就关注到了.net程序脱离framework发布的问题上了, 度娘,谷歌娘 都经过一番查找,无非分为如下几类方法: 1.直接使用mono运行时,附带 bin.li ...

- zoj 3761

很简单但很虐心的一道题: 我感觉自己的算法没错,但是老是过不了:= = 但是还是把代码贴出来: 我的方法,用并查集的方式做一课树,然后对树进行遍历: 有多少棵树就有多少个点剩余: #include&l ...

- UIWebView 与 JS 交互(1):Objective-C 调用 Javascript

众所周知,随着硬件水平的发展,HTML5 与原生 APP 性能差距不断缩小,正在互联网科技领域扮演者越来越重要的角色.作为一种能很大程度上节约成本的技术方案,通过 HTML5 及 JS 实现的跨平台技 ...

- hdu 4878 ZCC loves words AC自动机+中国剩余定理+快速幂

题意就不说了. 分析:折腾好几天自己写的代码还是看了别人代码后发现几乎没什么复杂度的差别,可是就是一直超时,后来干脆照着别人写啊,一直WA,就在准备放弃干脆先写这篇博客的时候,又看了一眼WA的代码,发 ...

- CPU Benchmarks

http://www.cpubenchmark.net/high_end_cpus.html 非常清楚~~~

- win8.1中如何获得管理员权限步骤

按WIN+R,运行对话框中输入gpedit.msc,开启组策略, 然后一步步地在"计算机配置"-"Windows 设置"-"安全设置"-&q ...