Spark Tachyon的命令行使用

Tachyon命令行使用

Tachyon接口说明

接口操作示例

copyFromLocal

copyToLocal

ls和lsr

count

cat

mkdir、rm、rmr和touch

pin和unpin

1、Tachyon命令行使用

Tachyon的命令行界面让用户可以对文件系统进行基本的操作。调用命令行工具使用以下脚本:

$./tachyon tfs

文件系统访问的路径格式如下:

tachyon://<master node address>:<master node port>/<path>

在Tachyon命令行使用中tachyon://<master node address>:<master node port>前缀可以省略,该信息从配置文件中读取。

1.1 接口说明

可以通过如下命令查看Tachyon所有接口命令

$cd /app/hadoop/tachyon-0.5./bin

$./tachyon tfs -help

其中大部分的命令含义可以参考Linux下同名命令,命令含义:

|

命令 |

含义 |

|

cat |

将文件内容输出到控制台 |

|

count |

显示匹配指定的前缀“路径”的文件夹和文件的数量。 |

|

ls |

列出指定路径下所有的文件和目录信息,如大小等。 |

|

lsr |

递归地列出指定路径下所有的文件和目录信息,如大小等。 |

|

mkdir |

在给定的路径创建一个目录,以及任何必要的父目录。如果路径已经存在将会失败。 |

|

rm |

删除一个文件。如果是一个目录的路径将会失败。 |

|

rmr(0.5.0版本不包含) |

删除一个文件或目录,以及该目录下的所有文件夹和文件 |

|

tail |

输出指定文件的最后1 kb到控制台。 |

|

touch |

在指定的路径创建一个0字节的文件。 |

|

mv |

移动指定的源文件或源目录到一个目的路径。如果目的路径已经存在将会失败。 |

|

copyFromLocal |

将本地指定的路径复制到Tachyon中指定的路径。如果Tachyon中指定的路径已经存在将会失败。 |

|

copyToLocal |

从Tachyon中指定的路径复制本地指定的路径。 |

|

fileinfo |

输出指定文件的块信息。 |

|

location |

输出存放指定文件的所在节点列表信息。 |

|

report |

向master报告文件丢失 |

|

request |

根据指定的dependency ID,请求文件。 |

|

pin |

将指定的路径常驻在内存中。如果指定的是一个文件夹,会递归地包含所有文件以及任何在这个文件夹中新创建的文件。 |

|

unpin |

撤销指定路径的常驻内存状态。如果指定的是一个文件夹,会递归地包含所有文件以及任何在这个文件夹中新创建的文件。 |

|

Free(0.5.0版本不包含) |

释放一个文件或一个文件夹下的所有文件的内存。文件/文件夹在underfs仍然是可用的。 |

1.2 接口操作示例

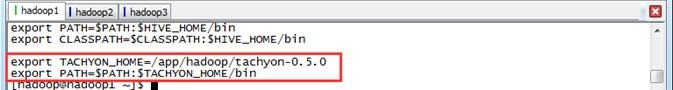

在操作之前需要把$TACHYON_HOME/bin配置到/etc/profile 配置文件的PATH中,并通过source /etc/profile生效

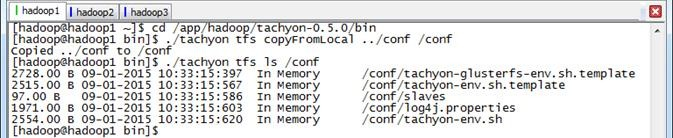

1.2.1 copyFromLocal

将本地$TACHYON_HOME/conf目录拷贝到Tachyon文件系统的根目录下的conf子目录

$cd /app/hadoop/tachyon-0.5./bin $./tachyon tfs copyFromLocal ../conf /conf $./tachyon tfs ls /conf

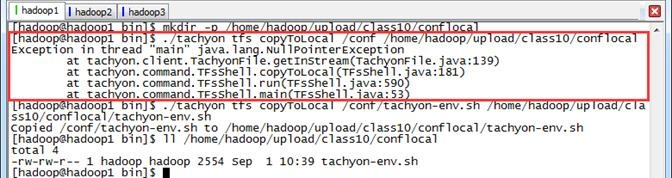

1.2.2 copyToLocal

把Tachyon文件系统文件复制到本地,需要注意的是命令中的src必须是Tachyon文件系统中的文件不支持目录拷贝,否则报错无法复制

$mkdir -p /home/hadoop/upload/class10/conflocal

$./tachyon tfs copyToLocal /conf /home/hadoop/upload/class10/conflocal

$./tachyon tfs copyToLocal /conf/tachyon-env.sh /home/hadoop/upload/class10/conflocal/tachyon-env.sh

$ll /home/hadoop/upload/class10/conflocal

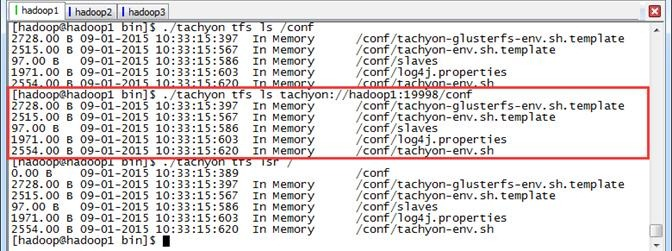

1.2.3 ls和lsr

使用ls和lsr命令查看Tachyon文件系统下的文件信息,其中lsr命令可以递归地查看子目录。

$./tachyon tfs ls /conf

$./tachyon tfs ls tachyon://hadoop1:19998/conf

$./tachyon tfs lsr /

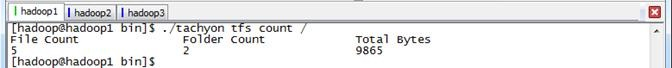

1.2.4 count

统计当前路径下的目录、文件信息,包括文件数、目录树以及总的大小

$./tachyon tfs count /

1.2.5 cat

查看指定文件的内容

$./tachyon tfs cat /conf/slaves

$./tachyon tfs cat tachyon://hadoop1:19998/conf/slaves

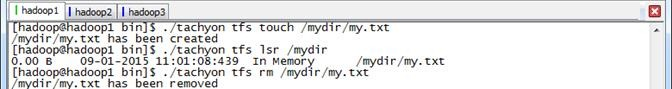

1.2.6 mkdir、rm、rmr和touch

(1)mkdir:创建目录,支持自动创建不存在的父目录;

(2)rm:删除文件,不能删除目录,注意,递归删除根目录是无效的

(3)rmr:删除目录,支持递归,包含子目录和文件,其中0.5.0版本不提供该命令

(4)touch:创建文件,不能创建已经存在的文件。

$./tachyon tfs mkdir /mydir

$./tachyon tfs ls /

$./tachyon tfs rm /mydir

$./tachyon tfs touch /mydir/my.txt

$./tachyon tfs lsr /mydir

$./tachyon tfs rm /mydir/my.txt

$./tachyon tfs touch /mydir2///my.txt

$./tachyon tfs lsr /mydir2

$./tachyon tfs rm /mydir2

$./tachyon tfs rm /

$./tachyon tfs ls /

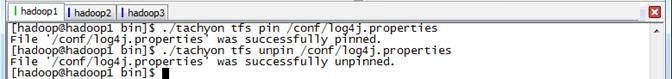

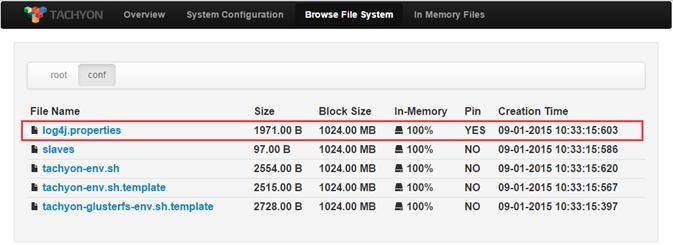

1.2.7 pin和unpin

pin命令将指定的路径常驻在内存中,如果指定的是一个文件夹会递归地包含所有文件以及任何在这个文件夹中新创建的文件。unpin命令撤销指定路径的常驻内存状态。

pin执行前或unpin执行后的Web Interface界面

$./tachyon tfs pin /conf/log4j.properties

$./tachyon tfs unpin /conf/log4j.properties

Spark Tachyon的命令行使用的更多相关文章

- [Spark][Hive]Hive的命令行客户端启动:

[Spark][Hive]Hive的命令行客户端启动: [training@localhost Desktop]$ chkconfig | grep hive hive-metastore 0:off ...

- Phoenix |安装配置| 命令行操作| 与hbase的映射| spark对其读写

Phoenix Phoenix是HBase的开源SQL皮肤.可以使用标准JDBC API代替HBase客户端API来创建表,插入数据和查询HBase数据. 1.特点 1) 容易集成:如Spark,Hi ...

- CDH spark 命令行测试

一. 参考 https://www.cnblogs.com/bovenson/p/5801536.html [root@node- test]# chown hdfs:hdfs /root/test/ ...

- 《SPARK/TACHYON:基于内存的分布式存储系统》-史鸣飞(英特尔亚太研发有限公司大数据软件部工程师)

史鸣飞:大家好,我是叫史鸣飞,来自英特尔公司,接下来我向大家介绍一下Tachyon.我事先想了解一下大家有没有听说过Tachyon,或者是对Tachyon有没有一些了解?对Spark呢? 首先做一个介 ...

- Spark Tachyon实战应用(配置启动环境、运行spark和运行mapreduce)

Tachyon实战应用 配置及启动环境 修改spark-env.sh 启动HDFS 启动Tachyon Tachyon上运行Spark 添加core-site.xml 启动Spark集群 读取文件并保 ...

- 在Yarn上运行spark-shell和spark-sql命令行

转载自:http://lxw1234.com/archives/2015/08/448.htm 如果你已经有一个正常运行的Hadoop Yarn环境,那么只需要下载相应版本的Spark,解压之后做为S ...

- kafka工作流程| 命令行操作

1. 概述 数据层:结构化数据+非结构化数据+日志信息(大部分为结构化) 传输层:flume(采集日志--->存储性框架(如HDFS.kafka.Hive.Hbase))+sqoop(关系型数 ...

- Spark-Unit2-Spark交互式命令行与SparkWordCount

一.Spark交互式命令行 启动脚本:spark-shell 先启动spark:./start-all.sh 本地模式启动命令:/bin/spark-shell 集群模式启动命令:/bin/spark ...

- linux设置命令行启动

做spark,内存大的话运行很快,否则运行很慢,主节点用界面,其他用命令行,然后scp,或者ssh 去其他主机最访问 1, 关闭图形界面: [root@bogon ~]# init 3 // 关闭 ...

随机推荐

- FLUME KAFKA SOURCE 和 SINK 使用同一个 TOPIC

FLUME KAFKA SOURCE 和 SINK 使用同一个 TOPIC 最近做了一个事情,过滤下kakfa中的数据后,做这个就用到了flume,直接使用flume source 和 flume s ...

- input元素和display:inline-block的元素不在一行的解决办法

每次用到了<input/> 元素 和inline-block的<span></span>(不一定是span,其他一些inline的元素也是一样)元素,他们总是会不在 ...

- 为什么在input中加了display:inline;再加宽,还有作用?

以前一直一位input是个行内元素,但是,行内元素的特性就是没有宽高的概念,元素多高,多宽,全凭内容撑起来的. 但是今天写了个demo,用chrome控制台显示:display:inline-bloc ...

- UI Framework-1: Aura Multi-desktop

Multi-desktop Aura now makes it possible for the same browser process to render to multiple desktops ...

- 栈 <stack> F - 宋飞正传

I’m out of stories. For years I’ve been writing stories, some rather silly, just to make simple prob ...

- cmd 操作命令

1)cd 操作文件目录的 cd path #进入path cd / #返回到当前盘符的根目录 cd .. #返回到上级目录 2)dir 显示当前目录 dir #显示当前目录下的文件夹 dir path ...

- js中数组增删查改unshift、push、pop、shift、slice、indexOf、concat、join

js中数组增删查改unshift.push.pop.shift.slice.indexOf.concat.join

- 【Codeforces Round #422 (Div. 2) C】Hacker, pack your bags!(二分写法)

[题目链接]:http://codeforces.com/contest/822/problem/C [题意] 有n个旅行计划, 每个旅行计划以开始日期li,结束日期ri,以及花费金钱costi描述; ...

- Android输入法扩展之远程输入法

近年来,互联网电视開始火热,乐视TV,小米TV,近期爱奇艺也在大肆的招人做爱奇艺电视.当然还有更被关注的苹果电视.事实上,这个趋势非常正常,也非常合理,传统单纯的接收电视节目的电视已经太传统了.是该被 ...

- 网页加速之Chromium 预载入 Prerendering

前一篇博文已经介绍通过prefetch预先载入网页的资源来提升网页载入速度,以下我们一起来看一下网页加速之chromium prerendering.在介绍prerendering之前,先介绍两个概念 ...