Windows下基于python3使用word2vec训练中文维基百科语料(一)

在进行自然语言处理之前,首先需要一个语料,这里选择维基百科中文语料,由于维基百科是 .xml.bz2文件,所以要将其转换成.txt文件,下面就是相关步骤:

步骤一:下载维基百科中文语料

https://dumps.wikimedia.org/zhwiki/latest/zhwiki-latest-pages-articles.xml.bz2

然后解压文件

文件夹里是一个这个文件

步骤二:安装依赖库

我们需要安装一些依赖库,有numpy、scipy以及gensim,安装gensim依赖于scipy,安装scipy依赖于numpy。我们直接用pip安装numpy,在windows命令行下使用命令:

pip install numpy

pip install scipy

pip install gensim

步骤三:将xml.bz2文件转换成.text文件

注意:我在网上找的代码,通常说会因为python2和python3的版本不同在使用python3进行解压会在output.write(space.join(text) + "\n")这一句出现提示关于byte或str的错误,

但是我用了python3修改的代码,反而出现错误,其实现在下载的语料直接用python2的代码也可以。

*********不过为了有些人可能采用下面代码会出现byte和str的错误,我将之前网上找的对于python3代码的修改依然保留(32-40行)***********************

(1)写代码 命名为process_wiki.py

# -*- coding:utf-8 -*-

# Author:Gao

import logging

import os.path

import six

import sys

import warnings warnings.filterwarnings(action='ignore', category=UserWarning, module='gensim')

from gensim.corpora import WikiCorpus if __name__ == '__main__':

program = os.path.basename(sys.argv[0])

logger = logging.getLogger(program) logging.basicConfig(format='%(asctime)s: %(levelname)s: %(message)s')

logging.root.setLevel(level=logging.INFO)

logger.info("running %s" % ' '.join(sys.argv)) # check and process input arguments

if len(sys.argv) != 3:

print("Using: python process_wiki.py enwiki.xxx.xml.bz2 wiki.en.text")

sys.exit(1)

inp, outp = sys.argv[1:3]

space = " "

i = 0 output = open(outp, 'w',encoding='utf-8')

wiki = WikiCorpus(inp, lemmatize=False, dictionary={})

for text in wiki.get_texts():

# if six.PY3:

# output.write(b' '.join(text).decode('utf-8') + '\n') # else:

# output.write(space.join(text) + "\n")

output.write(space.join(text) + "\n")

i=i+1

if (i%10000==0):

logger.info("Saved " + str(i) + " articles") output.close()

logger.info("Finished Saved " + str(i) + " articles")

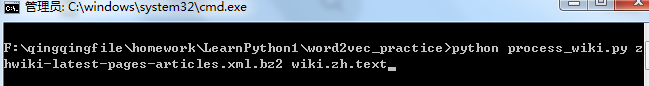

(2)运行代码(在cmd中运行)

首先到自己下载的中文维基百科预料的文件夹下,将自己的语料库和执行文件放在同一个文件夹下,这样方便执行,然后进入放置这两个文件的文件夹下(我的在f盘)

python process_wiki.py zhwiki-latest-pages-articles.xml.bz2 wiki.zh.text

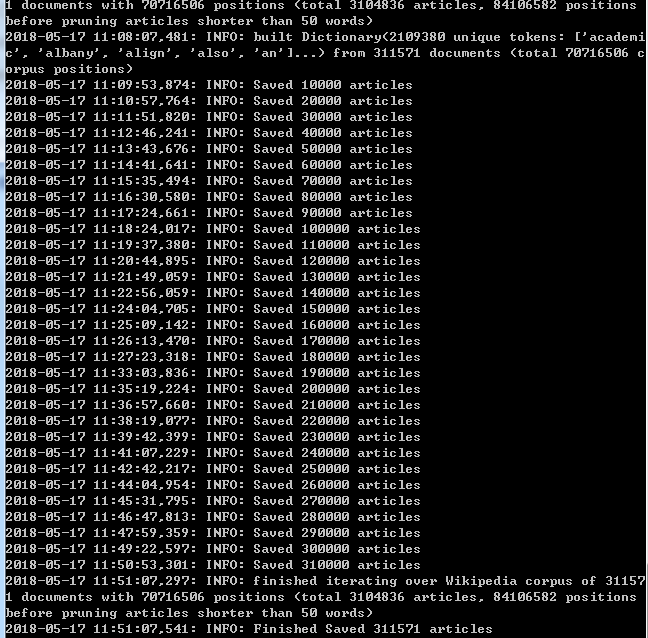

(3)运行结果(运行时间比较长,耐心等待,后面就出结果啦)

现在我们就得到了处理后的中文维基百科.txt文档,下一篇我们将进一步对文档进行处理

相关参考:https://www.jianshu.com/p/98d84854f7a3

Windows下基于python3使用word2vec训练中文维基百科语料(一)的更多相关文章

- Windows下基于python3使用word2vec训练中文维基百科语料(二)

在上一篇对中文维基百科语料处理将其转换成.txt的文本文档的基础上,我们要将为文本转换成向量,首先都要对文本进行预处理 步骤四:由于得到的中文维基百科中有许多繁体字,所以我们现在就是将繁体字转换成简体 ...

- Windows下基于python3使用word2vec训练中文维基百科语料(三)

对前两篇获取到的词向量模型进行使用: 代码如下: import gensim model = gensim.models.Word2Vec.load('wiki.zh.text.model') fla ...

- 使用word2vec对中文维基百科数据进行处理

一.下载中文维基百科数据https://dumps.wikimedia.org/zhwiki/并使用gensim中的wikicorpus解析提取xml中的内容 二.利用opencc繁体转简体 三.利用 ...

- Windows下基于Python3安装Ipython Notebook(即Jupyter)。python –m pip install XXX

1.安装Python3.x,注意修改环境变量path(追加上python安装目录,如:D:\Program Files\Python\Python36-32) 2.查看当前安装的第三方包:python ...

- windows下基于sublime text3的nodejs环境搭建

第一步:先安装sublime text3.详细教程可自行百度,这边不具体介绍了. 第二步.安装nodejs插件,有两种方式 第一种方式:直接下载https://github.com/tanepiper ...

- Windows下安装Python3.4.2

一.Windows下安装Python3.4.2 1.下载Windows下的Python3.4.2.exe 2.指定一个目录安装,然后下一步 3.配置环境变量包括Python.exe的文件.目录如下图所 ...

- 环境搭建文档——Windows下的Python3环境搭建

前言 背景介绍: 自己用Python开发了一些安卓性能自动化测试的脚本, 但是想要运行这些脚本的话, 本地需要Python的环境. 测试组的同事基本都没有安装Python环境, 于是乎, 我就想直接在 ...

- word2vec训练中文模型

-- 这篇文章是一个学习.分析的博客 --- 1.准备数据与预处理 首先需要一份比较大的中文语料数据,可以考虑中文的维基百科(也可以试试搜狗的新闻语料库).中文维基百科的打包文件地址为 https: ...

- Windows下基于http的git服务器搭建-gitstack

版权声明:若无来源注明,Techie亮博客文章均为原创. 转载请以链接形式标明本文标题和地址: 本文标题:Windows下基于http的git服务器搭建-gitstack 本文地址:http: ...

随机推荐

- 什么是RESTFUL协议?

1,restful是Representational State Transfer的缩写,翻译过来是表现层状态转移.我的理解是去掉访问文件的格式,比如去掉文件为html的.html,而是采用路径的方式 ...

- LINUX硬件查看命令

1.查看系统PCI设备 lspci lspci -v 显示更详细的PCI设备信息 2.查看CPU信息 more / proc /cpuinfo 3.查看系统内存信息 more /proc /mem ...

- [OS] 死锁相关知识点以及银行家算法详解

因此我们先来介绍一下死锁: 死锁特征 当出现死锁时,进程永远不能完成,并且系统资源被阻碍使用,阻止了其他作业开始执行.在讨论处理死锁问题的各种方法之前,先深入讨论一下死锁的特征. ·必要条件 (1)互 ...

- matlab edge

edge在matlab中用来进行边缘检测BW = edge(I) 采用灰度或一个二值化图像I作为它的输入,并返回一个与I相同大小的二值化图像BW,在函数检测到边缘的地方为1,其他地方为0. BW = ...

- codeforces 981 C.Useful Decomposition

C. Useful Decomposition time limit per test 1 second memory limit per test 256 megabytes input stand ...

- bzoj2676 Contra

题意: 给定N,R,Q,S 有N个关卡,初始有Q条命,且任意时刻最多只能有Q条命 每通过一个关卡,会得到u分和1条命,其中u=min(最近一次连续通过的关数,R) 若没有通过这个关卡,将失去一条命,并 ...

- BZOJ4770 图样(概率期望+动态规划)

考虑求出所有MST的权值和再除以方案数,方案数显然是2mn. 按位考虑,显然应该让MST里的边高位尽量为0.那么根据最高位是0还是1将点集划分成两部分,整张图的MST就是由两部分各自的MST之间连一条 ...

- Linux特殊字符含义

文件名以 ' . ' 开头的都是隐藏文件或目录,只需要在文件或目录名前添加 ' . ' 就可以隐藏它 ~ 表示主目录 . 当前目录 . . ...

- CentOS LVM逻辑卷管理

在CentOS 挂载(U盘NTFS格式,新硬盘,增加交换分区,扩展根分区等)中扩展根分区部分用的就是LVM逻辑卷管理来进行扩展的. 1.为什么会有逻辑卷管理 传统磁盘管理是直接对硬盘分区进行访问,你如 ...

- [CH弱省胡策R2]TATT

description 洛谷 data range \[ n\le 5\times 10^4\] solution 这就是四维偏序了... 好象时间复杂度是\(O(n^{\frac{5}{3}})\) ...