下载nltk数据包报错

安装nltk需要两步:安装nltk和安装nltk_data数据包

安装nltk

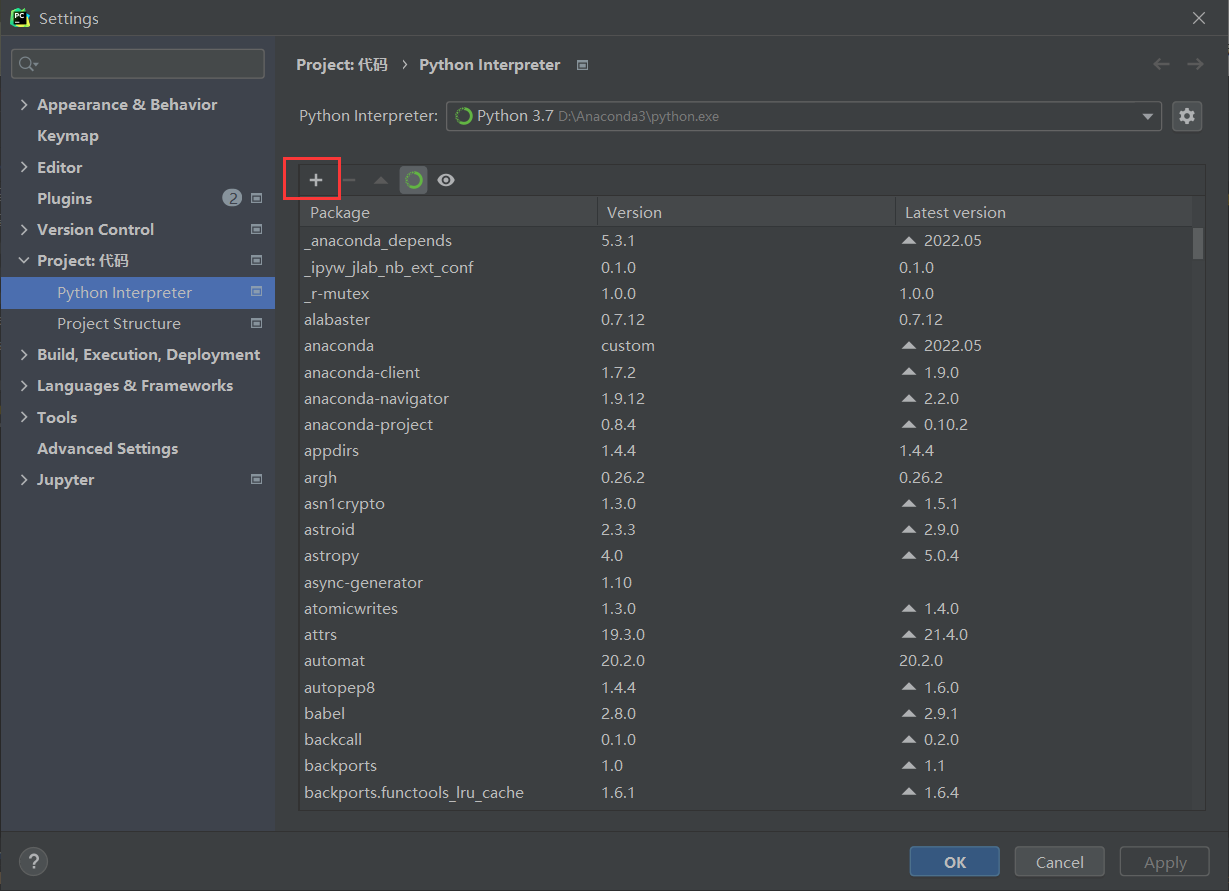

安装nltk很简单,可以直接在pycharm环境中安装,flie —> settings—> Python Interpreter —> 点击+ —> 搜索nltk —> intall Package

接下来需要安装nltk_data数据包才能使用nltk

手动安装nltk

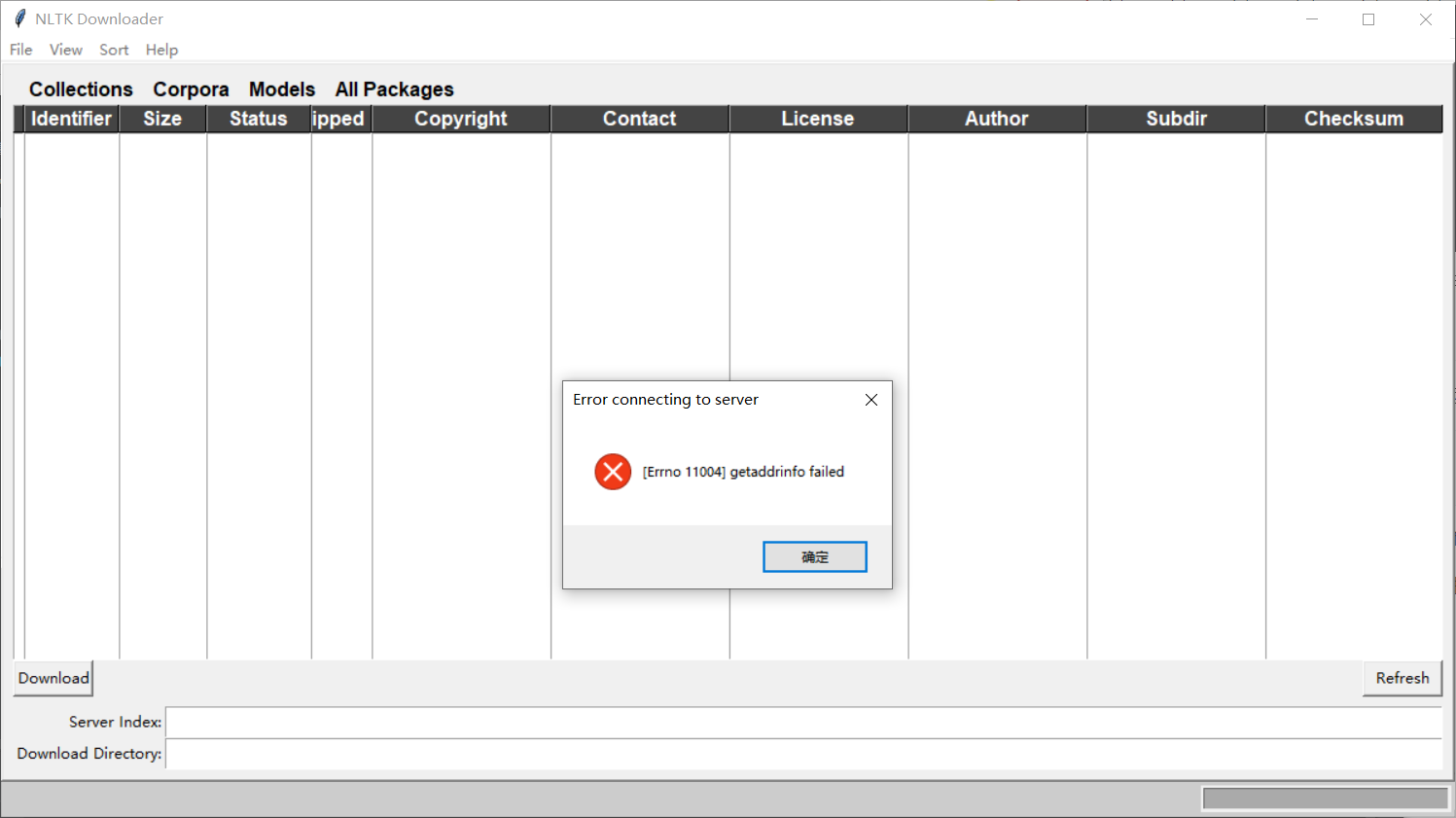

最简单的办法:在pychram里使用下面两行代码安装:

1 import nltk

2 nltk.download()

但通常这样安装都会提示:getaddrinfo failed

这是因为这里自动弹出的server index里提供的网址找不到对应的IP

可见,直接代码安装不行

因为其他方法我都试过了,都没有成功,这里推荐我试了之后成功的方法

先进入这个网站:https://github.com/nltk/nltk_data/tree/gh-pages

依次点击Code—>Download Zip下载压缩包

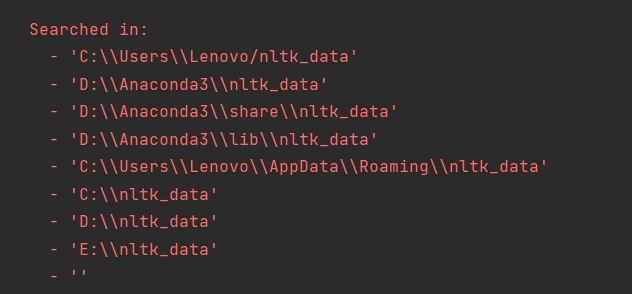

接着执行以下代码:

1 import nltk

2 from nltk_book import *

因为此时还没有安装nltk_data安装包,它会提示找不到数据,并且提示他找数据时的默认路径:

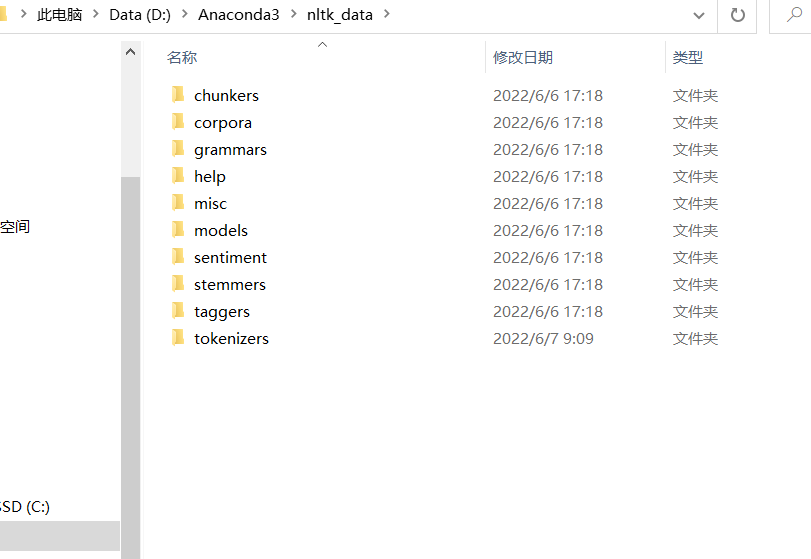

所以我们把nltk_data安装包里packages里的这些文件解压到上述任意路径,重命名为nltk_data即可,我解压到D:\Anaconda3

注意:下载下来的压缩包中,除了packages还有其他文件,这里只需要把packages中的文件就行。我之前就是因为直接把下载下来的压缩包全部解压到Aconda3中,导致后面验证的时候还是一直报错找不到数据!!!

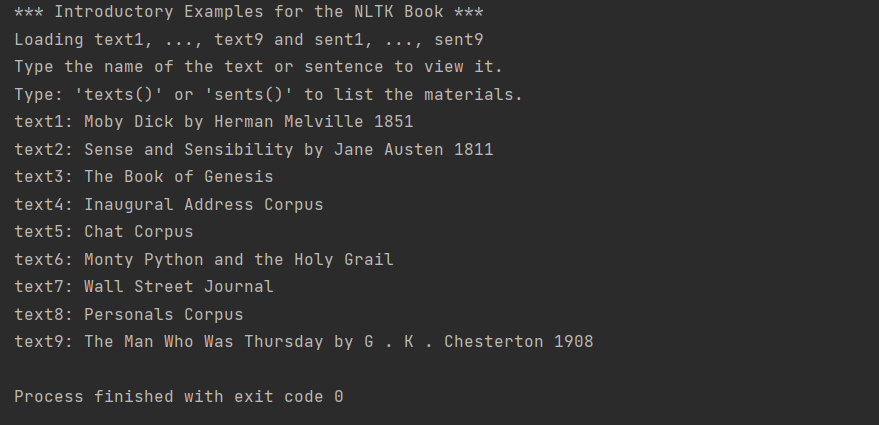

完后以上步骤,执行下面代码试验一下有没有安装成功

1 import nltk

2 from nltk.book import *

出现以下内容,即成功!

注意:在Github上下载的这个压缩数据包,里面的一些子文件夹下还有压缩内容,例如,如果调用nltk进行句子分割,会用到这个函数: word_tokenize():

1 import nltk

2

3 sen = 'hello, how are you?'

4 res = nltk.word_tokenize(sen)

5 print(res)

会提示 Resource punkt not found. Please use the NLTK Downloader to obtain the resource: 即punkt数据未找到:

类似这样的错误,其实如果找到查找的路径,也就是上面我们放数据包的地方,是可以在tokenizers文件夹下找到这个punkt的,原因就在于没有解压,那么,把punkt.zip解压到文件夹中,再运行分割句子的代码就没问题了。如果有其他的一些数据也是这样的,如果遇到显示没有找到某个数据包,不妨试一试。(如果打开其他的文件夹,发现里面也有未解压的那些文件,我们可以手动将其解压)

下载nltk数据包报错的更多相关文章

- maven 导包报错

作为初学者本应当是持之以恒的但是很长时间没有冒泡了这次冒个泡写maven项目的时候遇到了很多的bug,今天给大家分享一下解决的办法(常见的错误就是导不进来自己想要的包)要么就是导包报错以下是解决方法 ...

- 解决windows下rstudio安装playwith包报错问题

一.playwith包简介 playwith包提供了一个GTK+图形用户界面(GUI),使得用户可以编辑R图形并与其交互.playwith()函数允许用户识别和标注点.查看一个观测所有的变量值.缩放和 ...

- flask+sqlite3+echarts2+ajax数据可视化报错:UnicodeDecodeError: 'utf8' codec can't decode byte解决方法

flask+sqlite3+echarts2+ajax数据可视化报错: UnicodeDecodeError: 'utf8' codec can't decode byte 解决方法: 将 py文件和 ...

- 关于Spring运用过程中jar包报错问题

使用Spring进行web开发时,第一步就是导入jar包,今天使用SPring Task开发定时器时,导入了好多次jar包,都是报错,不知道是因为jar包版本不同还是因为需要依赖的jar包没加入,反正 ...

- 编译APR包报错 rm: cannot remove `libtoolT': No such file or directory

centos 6 编译APR包报错 在当前apr 目录 : #Vi configure +31880 ,注释掉此行 再次编译即可.

- eclispe集成Scalas环境后,导入外部Spark包报错:object apache is not a member of package org

在Eclipse中集成scala环境后,发现导入的Spark包报错,提示是:object apache is not a member of package org,网上说了一大推,其实问题很简单: ...

- 数据导入报错:Got a packet bigger than‘max_allowed_packet’bytes的问题

数据导入报错:Got a packet bigger than‘max_allowed_packet’bytes的问题 2个解决方法: 1.临时修改:mysql>set global max_a ...

- PyCharm导入tensorflow包报错的问题

[注]PyCharm导入tensorflow包报错的问题 若是你也遇到这个问题,说明你也没有理解tensorflow到底在哪里. 当安装了anaconda3.6后,在PyCharm中设置interpr ...

- 数据导入报错 Got a packet bigger than‘max_allowed_packet’bytes

数据导入报错:Got a packet bigger than‘max_allowed_packet’bytes的问题 2个解决方法: 1.临时修改:mysql>set global max_a ...

随机推荐

- LC-26

class Solution { public int removeDuplicates(int[] nums) { int slowIndex = 0, fastIndex = 1; if (num ...

- 序列化之Serializer类与ModelSerializer类的使用

序列化之Serializer类的使用(5星) 作用: 序列化,序列化器会把模型对象转换成字典,经过response以后变成json字符串 反序列化,把客户端发送过来的数据,经过request以后变成字 ...

- RTSP可用网络流

推荐个音视频学习的网站 https://www.zzsin.com,里面有音视频学习资料和测试视频提供下载B站搜乔红 rtsp://wowzaec2demo.streamlock.net/vod/mp ...

- 【大话云原生】煮饺子与docker、kubernetes之间的关系

云原生的概念最近非常火爆,企业落地云原生的愿望也越发强烈.看过很多关于云原生的文章,要么云山雾罩,要么曲高和寡. 所以笔者就有了写<大话云原生>系列文章的想法,期望用最通俗.简单的语言说明 ...

- 【面试普通人VS高手系列】Spring Boot中自动装配机制的原理

最近一个粉丝说,他面试了4个公司,有三个公司问他:"Spring Boot 中自动装配机制的原理" 他回答了,感觉没回答错误,但是怎么就没给offer呢? 对于这个问题,看看普通人 ...

- XCTF练习题---MISC---小小的PDF

XCTF练习题---MISC---小小的PDF flag:SYC{so_so_so_easy} 解题步骤: 1.观察题目,下载附件 2.下载完发现是一个PDF文件,经过转Word,查看属性,十六进制查 ...

- FreeRTOS --(2)内存管理 heap1

转载自https://blog.csdn.net/zhoutaopower/article/details/106631237 FreeRTOS 提供了5种内存堆管理方案,分别对应heap1/heap ...

- 全场景AI推理引擎MindSpore Lite, 助力HMS Core视频编辑服务打造更智能的剪辑体验

移动互联网的发展给人们的社交和娱乐方式带来了很大的改变,以vlog.短视频等为代表的新兴文化样态正受到越来越多人的青睐.同时,随着AI智能.美颜修图等功能在图像视频编辑App中的应用,促使视频编辑效率 ...

- psexec.py规避杀软

前言 在内网渗透中,当获取到一个账号密码后,经常会使用impacket套件中的psexec.py进行远程连接并执行命令,但是因为用的人多了,杀软也对psexec.py特征进行了拦截,也就导致了如果使用 ...

- 用 Python 远程控制 Windows 服务器,太好用了!

在很多企业会使用闲置的 Windows 机器作为临时服务器,有时候我们想远程调用里面的程序或查看日志文件 Windows 内置的服务「 winrm 」可以满足我们的需求 它是一种基于标准简单对象访问协 ...