Spark Streamming 基本输入流I(-) :File/Hdfs

Spark Streamming 基本输入流I(-):从文件中进行读取

文件读取1:本地文件读取

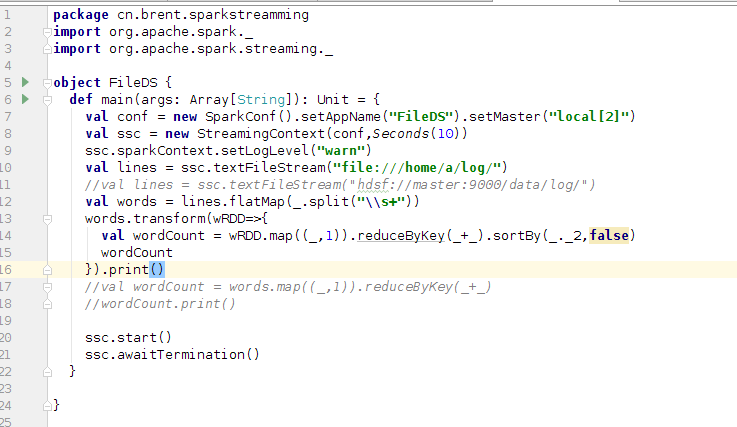

这里我只给出实现代码及操作步骤

1、在本地目录下创建目录,这里我们创建目录为~/log/

2、然后手动在~/目录下创建两个文件夹。t1.dat ,t2.dat

t1.dat 格式如下:

hello hadoop

hello spark

hello Java

hellp hbase

hello scala

t2.dat格式如下:

My name is Brent,

how are you

nice to meet you

3、编写spark streamming程序,并将其运行起来。

4、使用命令cp ~/t*.dat ./log/ 将t1.dat ,t2.dat移动到~/log目录下,

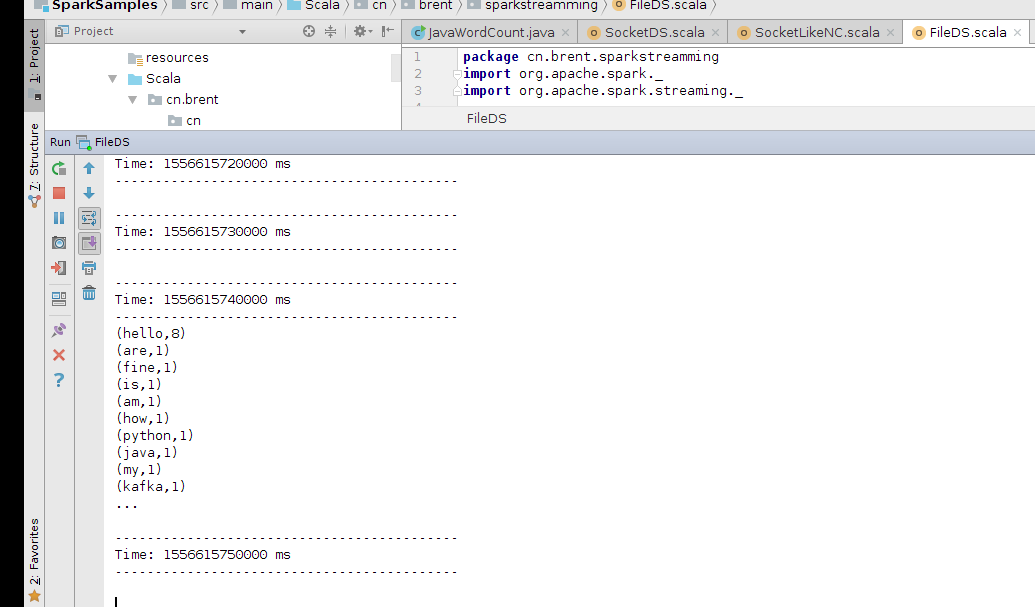

5、查看spark Streamming程序的运行情况。

文件读取2:HDFS文件读取

HDFS文件读取和本地是相差无几的,

不同之处如下

程序中修改文件引入路径//val lines = ssc.textFileStream("hdsf://master:9000/data/log/")

本地文件t1.dat 和 t2.dat 需要上传到hdfs://master:9000/data/log下

hdfs dfs -mkdir data/log 创建目录。

hdfs dfs -put t*.dat data/log/

注意点:

文件作为输入流容易出错的一点就是,目录下面的文件一定要是cp进来,而不是mv进来了,因为cp进行的文件时间戳是改变的,而mv进来的时间戳没有改变,spark Streamming就不会进行处理。

Spark Streamming 基本输入流I(-) :File/Hdfs的更多相关文章

- Spark Streamming 基本输入流(二) :Socket

Spark Streamming 可以通过socket 进行数据监听. socket的输入方可以通过nc 或者自己开发nc功能的程序. 1.系统自带的nc su root a yum install ...

- Spark2.x(五十五):在spark structured streaming下sink file(parquet,csv等),正常运行一段时间后:清理掉checkpoint,重新启动app,无法sink记录(file)到hdfs。

场景: 在spark structured streaming读取kafka上的topic,然后将统计结果写入到hdfs,hdfs保存目录按照month,day,hour进行分区: 1)程序放到spa ...

- ParquetDecodingException: Can not read value at 0 in block -1 in file hdfs:...

: jdbc:hive2://master01.hadoop.dtmobile.cn:1> select * from cell_random_grid_tmp2 limit 1; INFO : ...

- kettle在本地执行向远程hdfs执行转换错误"Couldn't open file hdfs"

kettle在本地执行向远程hdfs执行转换时,会出现以下错误: ToHDFS.0 - ERROR (version 7.1.0.0-12, build 1 from 2017-05-16 17.18 ...

- ERROR: Found lingering reference file hdfs

Found lingering reference异常 ERROR: Found lingering reference file hdfs://jiujiang1:9000/hbase/month_ ...

- Spark No FileSystem for scheme file 解决方法

在给代码带包成jar后,放到环境中运行出现如下错误: Exception in thread "main" java.io.IOException: No FileSystem f ...

- 通过Spark SQL关联查询两个HDFS上的文件操作

order_created.txt 订单编号 订单创建时间 -- :: -- :: -- :: -- :: -- :: order_picked.txt 订单编号 订单提取时间 -- :: ...

- MapReduce 踩坑 - hadoop No FileSystem for scheme: file/hdfs

一.场景 hadoop-3.0.2 + hbase-2.0.0 一个mapreduce任务,在IDEA下本地提交到hadoop集群可以正常运行. 现在需要将IDEA本地项目通过maven打成jar包, ...

- Spark设置自定义的InputFormat读取HDFS文件

本文通过MetaWeblog自动发布,原文及更新链接:https://extendswind.top/posts/technical/problem_spark_reading_hdfs_serial ...

随机推荐

- spark第十八篇:Tuning Spark 调优

由于大多数Spark应用都是在内存中计算的,所以,Spark程序的瓶颈可能是集群中的任何资源,比如CPU,网络带宽或者内存等.本指南主要涵盖两个主题: 1.数据序列化.这对于良好的网络性能至关重要,还 ...

- MySQL 常用show 语句

1. show tables或show tables from database_name; -- 显示当前数据库中所有表的名称. 2. show databases; -- 显示mysql中所有数据 ...

- JavaScript 浮点数及运算精度调整总结

JavaScript 浮点数及运算精度调整总结 JavaScript 只有一种数字类型 Number,而且在Javascript中所有的数字都是以IEEE-754标准格式表示的.浮点数的精度问题不是J ...

- (转)DB2 db2diag.log 日志分析

DB2 db2diag.log 日志分析 原文:http://blog.csdn.net/lyjiau/article/details/52129997 db2diag.log是用来记录DB2数据库运 ...

- hibernate框架配置文件详解

1 orm元数据配置文件(映射文件) <?xml version="1.0" encoding="UTF-8"?> <!DOCTYPE hib ...

- Linux 上安装 weblogic12C (远程图形界面安装) (二)

上一篇Linux 上安装 weblogic12C (静默安装)介绍了静默方式安装weblogic12C的方式,这一篇主要介绍在windows主机上通过远程图形界面的方式安装weblogic的方式 一. ...

- matlab中如何根据t检验参数查找t检验值

这个问题花了一些时间.先看图 这个是t检验里面的公式,但是如何在matlab中找到该式子对应的值,我现在才知道. 就是这样:x=tinv(1-α/2,n-1)----t(n)分布的上侧α分位数 ...

- 坐标深圳 | Kubernetes!我要用这样的姿势拥抱你

欢迎大家前往腾讯云+社区,获取更多腾讯海量技术实践干货哦~ 从去年至今,容器.Kubernetes话题的热度就持续不减,有人说基于容器 +Kubernetes 的新型 PaaS 将会成为云计算的主流: ...

- 数据挖掘:提取百度知道QA中的影视信息

1. 背景 网站上爬取了部分关于影视的百度知道QA,为了后续提高影视的搜索效果,需要基于百度知道QA的答案抽取相关的影视信息. 2. 流程 目前已有基础的媒资视频库信息,基于媒资视频库中的视频名称,构 ...

- React.js 小书 Lesson8 - 组件的组合、嵌套和组件树

作者:胡子大哈 原文链接:http://huziketang.com/books/react/lesson8 转载请注明出处,保留原文链接和作者信息. 继续拓展前面的例子,现在我们已经有了 Heade ...