spark学习2-1(hive1.2安装)

由于前面安装版本过老,导致学习过程中出现了很多问题,今天安装了一个新一点的版本。安装结束启动时遇到一点问题,记录在这里。

第一步:hive-1.2安装

通过WinSCP将apache-hive-1.2.1-bin.tar.gz上传到/usr/hive/目录下

[root@spark1 hive]# chmod u+x apache-hive-1.2.1-bin.tar.gz #增加执行权限

[root@spark1 hive]# tar -zxvf apache-hive-1.2.1-bin.tar.gz #解压

[root@spark1 hive]# mv apache-hive-1.2.1-bin hive-1.2

[root@spark1 hive]# vi /etc/profile #配置环境变量

export HIVE_HOME=/usr/hive/hive-1.2

export PATH=$HIVE_HOME/bin

[root@spark1 hive]# source /etc/profile #是环境变量生效

[root@spark1 hive]# which hive #查看安装路径

第二步:安装mysql

[root@spark1 hive]# yum install -y mysql-server #下载安装

[root@spark1 hive]# service mysqld start #启动mysql

[root@spark1 hive]# chkconfig mysqld on #设置开机自动启动

[root@spark1 hive]# yum install -y mysql-connector-java #yum安装mysql connector

[root@spark1 hive]# cp /usr/share/java/mysql-connector-java-5.1.17.jar /usr/hive/hive-0.13/lib #拷贝到hive中的lib目录下

第三步:在mysql上创建hive元数据库,并对hive进行授权

mysql> create database if not exists hive_metadata;

mysql> grant all privileges on hive_metadata.* to 'hive'@'%' identified by 'hive';

mysql> grant all privileges on hive_metadata.* to 'hive'@'localhost' identified by 'hive';

mysql> grant all privileges on hive_metadata.* to 'hive'@'spark1' identified by 'hive';

mysql> flush privileges;

mysql> use hive_metadata;

mysql> exit

第四步:配置文件

[root@spark1 hive]# cd /usr/hive/hive-1.2/conf #进入到conf目录

[root@spark1 conf]# mv hive-default.xml.template hive-site.xml #重命名

[root@spark1 conf]# vi hive-site.xml

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://spark1:3306/hive_metadata?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

<description>location of default database for the warehouse</description>

</property>

[root@spark1 conf]# mv hive-env.sh.template hive-env.sh #重命名

[root@spark1 ~]# vi /usr/hive/hive-1.2/bin/hive-config.sh #加入java、hive、hadoop 路径

export JAVA_HOME=/usr/java/jdk1.8

export HIVE_HOME=/usr/hive/hive-1.2

export HADOOP_HOME=/usr/hadoop/hadoop-2.6.0

[hadoop@spark1 hive]$ cd hive-1.2

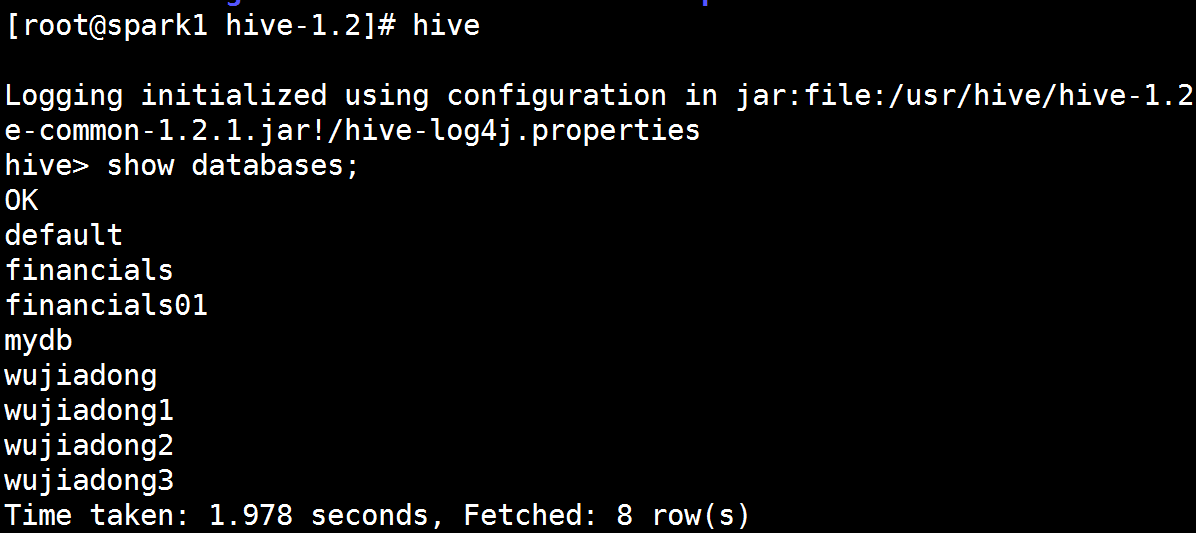

[hadoop@spark1 hive-1.2]$ hive #进入hive开始使用

测试hive

hive> hive;

启动报错

Exception in thread "main" java.lang.RuntimeException: java.lang.IllegalArgumentException: java.net.URISyntaxException: Relative path in absolute URI: \({system:java.io.tmpdir%7D/\)%7Bsystem:user.name%7D

启动hive-1.2报错1

Exception in thread "main" java.lang.RuntimeException: java.lang.IllegalArgumentException: java.net.URISyntaxException: Relative path in absolute URI: \({system:java.io.tmpdir%7D/\)%7Bsystem:user.name%7D

解决办法

将hive-site.xml中三个含有system:java.io.tmpdir配置项的值修改为 $HIVE_HOME/iotmp 即:

/usr/hive/hive-1.2/iotmp

<property>

<name>hive.exec.local.scratchdir</name>

<value>/usr/hive/hive-1.2/iotmp</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/usr/hive/hive-1.2/iotmp</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/usr/hive/hive-1.2/iotmp</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

搞定1之后报错2

[ERROR] Terminal initialization failed; falling back to unsupported

原因是hadoop目录下存在老版本jline:

/usr/hadoop/hadoop-2.6.0/share/hadoop/yarn/lib/jline-0.9.94.jar

解决方法:

将hive目录/usr/hive/hive-1.2/lib下的新版本jline的JAR包拷贝到hadoop下:

cp jline-2.12.jar /usr/hadoop/hadoop-2.6.0/share/hadoop/yarn/lib

结果如下图

spark学习2-1(hive1.2安装)的更多相关文章

- spark学习(2)--hadoop安装、配置

环境: 三台机器 ubuntu14.04 hadoop2.7.5 jdk-8u161-linux-x64.tar.gz (jdk1.8) 架构: machine101 :名称节点.数据节点.Secon ...

- spark学习2(hive0.13安装)

第一步:hive安装 通过WinSCP将apache-hive-0.13.1-bin.tar.gz上传到/usr/hive/目录下 [root@spark1 hive]# chmod u+x apac ...

- Spark学习(一) -- Spark安装及简介

标签(空格分隔): Spark 学习中的知识点:函数式编程.泛型编程.面向对象.并行编程. 任何工具的产生都会涉及这几个问题: 现实问题是什么? 理论模型的提出. 工程实现. 思考: 数据规模达到一台 ...

- Spark学习笔记--Linux安装Spark集群详解

本文主要讲解如何在Linux环境下安装Spark集群,安装之前我们需要Linux已经安装了JDK和Scala,因为Spark集群依赖这些.下面就如何安装Spark进行讲解说明. 一.安装环境 操作系统 ...

- 用Spark学习FP Tree算法和PrefixSpan算法

在FP Tree算法原理总结和PrefixSpan算法原理总结中,我们对FP Tree和PrefixSpan这两种关联算法的原理做了总结,这里就从实践的角度介绍如何使用这两个算法.由于scikit-l ...

- 用Spark学习矩阵分解推荐算法

在矩阵分解在协同过滤推荐算法中的应用中,我们对矩阵分解在推荐算法中的应用原理做了总结,这里我们就从实践的角度来用Spark学习矩阵分解推荐算法. 1. Spark推荐算法概述 在Spark MLlib ...

- Spark学习笔记2(spark所需环境配置

Spark学习笔记2 配置spark所需环境 1.首先先把本地的maven的压缩包解压到本地文件夹中,安装好本地的maven客户端程序,版本没有什么要求 不需要最新版的maven客户端. 解压完成之后 ...

- spark 学习路线及参考课程

一.Scala编程详解: 第1讲-Spark的前世今生 第2讲-课程介绍.特色与价值 第3讲-Scala编程详解:基础语法 第4讲-Scala编程详解:条件控制与循环 第5讲-Scala编程详解:函数 ...

- spark学习及环境配置

http://dblab.xmu.edu.cn/blog/spark/ 厦大数据库实验室博客 总结.分享.收获 实验室主页 首页 大数据 数据库 数据挖掘 其他 子雨大数据之Spark入门教程 林子 ...

随机推荐

- NGUI Checkbox与PlayerPrefs

UICheckboxPrefs.cs 1,bool isChecked:false 为“初始”状态,true为“选中”: 2,bool startsChecked:true,一运行,就显示UISpri ...

- Android开发:《Gradle Recipes for Android》阅读笔记1.4

在android studio下可以使用gradle视图运行gradle. gradle任务被分别组织在不同目录下,如android,build,install. 需要执行特定的任务只要双击任务名称. ...

- 基于Boost无锁队列实现的内存池

- hfut 1287

http://acm.hfut.edu.cn/OnlineJudge/ 中文题. 区间线段树,需要剪枝.n的大小有问题. #include <iostream> #include < ...

- 《从零开始学Swift》学习笔记(Day 18)——有几个分支语句?

原创文章,欢迎转载.转载请注明:关东升的博客 分支语句又称条件语句,Swift编程语言提供了if.switch和guard三种分支语句. if语句 由if语句引导的选择结构有if结构.if ...

- 160816、webpack 入门指南

什么是 webpack? webpack是近期最火的一款模块加载器兼打包工具,它能把各种资源,例如JS(含JSX).coffee.样式(含less/sass).图片等都作为模块来使用和处理. 我们可以 ...

- 【转】mysql利用init-connect增加访问审计功能

mysql的连接首先都是要通过init-connect初始化,然后连接到实例. 我们利用这一点,通过在init-connect的时候记录下用户的thread_id,用户名和用户地址实现db的访问审计功 ...

- 【转】 通过VMLibrary在client partition上安装AIX全程实录

现场实录,应该对新手有所帮助,因为本人就是新手...最近一段时间跟Linux无缘,都是在和PowerVM打交道,博文更新慢,不赖我,哈哈本文参考链接:AIX Migration with File-B ...

- Unity字体文件放Resources和打成ab对比

情况一:公共字体打成ab的时候,加载A界面的时候加载了font的ab,卸载A和font的ab后,接着加载B界面,加载了font的ab,卸载B和font的ab,这时候字体对应的asset会在内存里有两份 ...

- Linux下Ngnix及PHP重启命令

INT, TERM 立刻终止 QUIT 平滑终止 USR1 重新打开日志文件 USR2 平滑重载所有worker进程并重新载入配置和二进制模块 php-fpm 关闭: kill -INT `cat / ...