win10+pyspark+pycharm+anaconda单机环境搭建

一、工具准备

1. jdk1.8

2. scala

3. anaconda3

4. spark-2.3.1-bin-hadoop2.7

5. hadoop-2.8.3

6. winutils

7. pycharm

二、安装

1. jdk安装

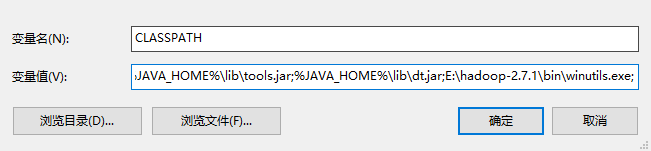

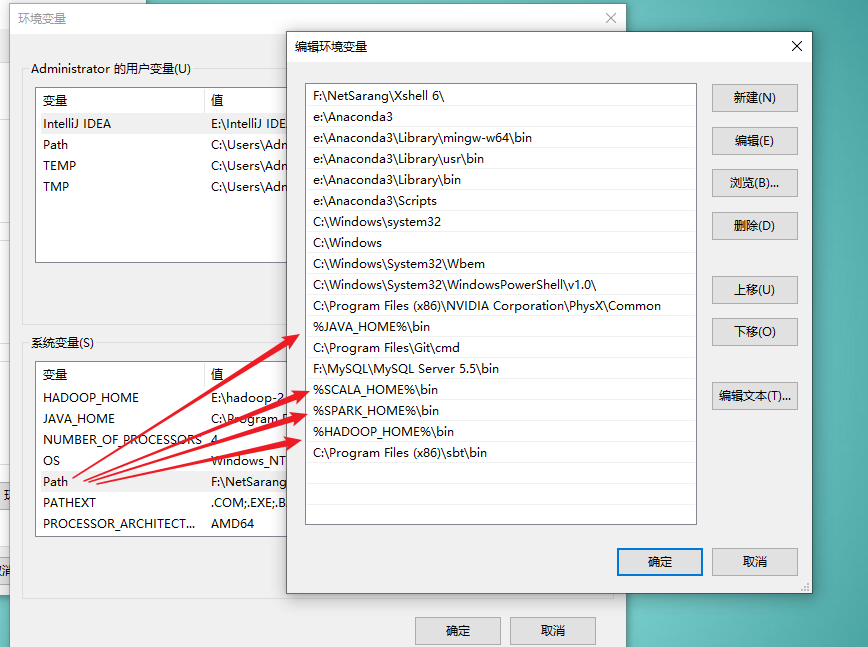

oracle官网下载,安装后配置JAVA_HOME、CLASS_PATH,bin目录追加到PATH,注意:win10环境下PATH最好使用绝对路径!下同!

2. scala安装

官网下载,安装后配置SCALA_HOME,bin目录追加到PATH(上图包含)

3. anaconda3安装

官网下载,安装时注意在“追加到PATH”复选框打钩

4. spark安装

官网下载压缩包,解压缩后配置SPARK_HOME,bin目录追加到PATH(上图包含)

5. hadoop安装

官网下载版本>=spark对应hadoop版本,解压缩后配置HADOOP_HOME,bin目录追加到PATH(上图包含)

6. winutils安装

下载地址:https://github.com/steveloughran/winutils,按hadoop版本对应下载

7. pycharm安装

下载付费版本,使用lanyu注册码激活,注意按照提示添加域名解析到hosts文件

三、处理python相关

- 将pyspark文件夹(在spark-2.3.1-bin-hadoop2.7\python目录)复制到anaconda3\Lib\site-packages目录下

- 将winutils解压缩后用对应版本的bin目录替换hadoop下的bin目录

- conda install py4j

- 进入hadoop\bin目录下,以管理员方式打开cmd,输入命令:winutils.exe chmod 777 c:\tmp\Hive,若提示错误,检查Hive目录是否存在,若不存在,则手动创建,再重新执行命令

四、验证

打开pycharm,使用anaconda中的python作为解释器,输入以下代码并运行:

from pyspark import SparkContext

sc = SparkContext('local')

doc = sc.parallelize([['a', 'b', 'c'], ['b', 'd', 'd']])

words = doc.flatMap(lambda d: d).distinct().collect()

word_dict = {w: i for w, i in zip(words, range(len(words)))}

word_dict_b = sc.broadcast(word_dict)

def wordCountPerDoc(d):

dict = {}

wd = word_dict_b.value

for w in d:

if wd[w] in dict:

dict[wd[w]] += 1

else:

dict[wd[w]] = 1

return dict

print(doc.map(wordCountPerDoc).collect())

print("successful!")

运行结果:

[{0: 1, 1: 1, 2: 1}, {1: 1, 3: 2}]

successful!

本文为win10+pyspark+pycharm+anaconda的单机测试环境搭建。

win10+pyspark+pycharm+anaconda单机环境搭建的更多相关文章

- windows7 spark单机环境搭建及pycharm访问spark

windows7 spark单机环境搭建 follow this link how to run apache spark on windows7 pycharm 访问本机 spark 安装py4j ...

- [转载] Hadoop和Hive单机环境搭建

转载自http://blog.csdn.net/yfkiss/article/details/7715476和http://blog.csdn.net/yfkiss/article/details/7 ...

- win10子系统linux.ubuntu开发环境搭建

移步新博客... win10子系统linux.ubuntu开发环境搭建

- Kafka 0.7.2 单机环境搭建

Kafka 0.7.2 单机环境搭建当下载完Kafka后,进行解压,其目录结构如下: bin config contrib core DISCLAIMER examples lib lib_manag ...

- kafka单机环境搭建及其基本使用

最近在搞kettle整合kafka producer插件,于是自己搭建了一套单机的kafka环境,以便用于测试.现整理如下的笔记,发上来和大家分享.后续还会有kafka的研究笔记,依然会与大家分享! ...

- HBase单机环境搭建

在搭建HBase单机环境之前,首先你要保证你已经搭建好Java环境: $ java -version java version "1.8.0_51" Java(TM) SE Run ...

- Hadoop —— 单机环境搭建

一.前置条件 Hadoop的运行依赖JDK,需要预先安装,安装步骤见: Linux下JDK的安装 二.配置免密登录 Hadoop组件之间需要基于SSH进行通讯. 2.1 配置映射 配置ip地址和主机名 ...

- Solr单机环境搭建及部署

一.定义 官网的定义: Solr是基于Lucene构建的流行,快速,开放源代码的企业搜索平台.它具有高度的可靠性,可伸缩性和容错能力,可提供分布式索引,复制和负载平衡查询,自动故障转移和恢复,集中式配 ...

- hadoop单机环境搭建

[在此处输入文章标题] Hadoop单机搭建 1. 工具准备 1) Hadoop Linux安装包 2) VMware虚拟机 3) Java Linux安装包 4) Window 电脑一台 2. 开始 ...

随机推荐

- linux: 右键添加打开终端

安装一个包,即可在右键里面添加一个“打开终端”的菜单. sudo apt-get install nautilus-open-terminal 注销用户重启,然后再进入就可以右键->在终端打开选 ...

- Docs-.NET-C#-指南-语言参考-关键字-值类型:可以 null 的值类型

ylbtech-Docs-.NET-C#-指南-语言参考-关键字-值类型:可以 null 的值类型 1.返回顶部 1. Nullable value types (C# reference) 2019 ...

- 泡泡一分钟:Visual Odometry Using a Homography Formulation with Decoupled Rotation and Translation Estimation Using Minimal Solutions

张宁 Visual Odometry Using a Homography Formulation with Decoupled Rotation and Translation Estimation ...

- RHEL7 的注册

RHEL7 的注册 2016年09月12日 20:37:19 wojiushiwoba 阅读数 13002更多 分类专栏: 嵌入式linux 版权声明:本文为博主原创文章,遵循CC 4.0 BY- ...

- 面向对象(实际就像python跳用自己写的库那样)

被调用的对象(库) FanFa.java 文件 package com.BM; public class FanFa { #变量值 int r=4 #方法 public static void uui ...

- matlab基本数据结构struct

一起来学演化计算-matlab基本数据结构struct 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献 http://blog.sina.com.cn/s/blog_46865140 ...

- Spring Boot 使用YAML配置

YAML是JSON的一个超集,可以非常方便地将外部配置以层次结构形式存储起来.当项目的类路径中有SnakeYAML库(spring-boot-starter中已经被包含)时,SpringApplica ...

- nginx client_body_buffer_size

http://www.bubuko.com/infodetail-1760832.html 上传文件过大时,nginx会报链接里面的warn,请求body写磁盘到缓存文件,导致性能降低,可适当调大该参 ...

- 如何在Windows Server 2008 R2中更改桌面图标

如何在Windows Server 2008 R2中更改桌面图标 Windows Server 2008 R2 已经在 MSDN 和 TechNet Plus 订阅上公布,gOxiA 在第一时间下载并 ...

- CSS控制元素背景透明度总结

方法一:CSS3的background rgba filter:progid:DXImageTransform.Microsoft.gradient(enabled='true',startColor ...