【大数据系列】基于MapReduce的数据处理 SequenceFile序列化文件

为键值对提供持久的数据结构

1、txt纯文本格式,若干行记录

2、SequenceFile

key-value格式,若干行记录,类似于map

3、编写写入和读取的文件

package com.slp; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.SequenceFile;

import org.apache.hadoop.io.SequenceFile.Reader;

import org.apache.hadoop.io.SequenceFile.Writer;

import org.apache.hadoop.io.Text;

import org.junit.Test;

public class TestSequenceFile { @Test

public void write() throws IOException{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://www.node1.com:9000/");

FileSystem fs = FileSystem.get(conf);

Path path = new Path("hdfs://www.node1.com:9000/home/hadoop/seq.seq");

Writer writer = SequenceFile.createWriter(fs, conf, path, IntWritable.class, Text.class);

writer.append(new IntWritable(1), new Text("tom1"));

writer.append(new IntWritable(2), new Text("tom2"));

writer.append(new IntWritable(3), new Text("tom3"));

writer.append(new IntWritable(4), new Text("tom4"));

writer.close();

System.out.println("over");

} @Test

public void readSeq() throws IOException{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://www.node1.com:9000/");

FileSystem fs = FileSystem.get(conf);

Path path = new Path("hdfs://www.node1.com:9000/home/hadoop/seq.seq");

Reader reader = new SequenceFile.Reader(fs, path, conf);

IntWritable key = new IntWritable();

Text value = new Text();

while(reader.next(key, value)){

System.out.println(key+"="+value);

}

reader.close();

}

}测试方法的输出为:

1=tom1

2=tom2

3=tom3

4=tom4

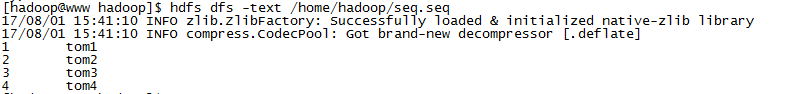

4、查看文件

【大数据系列】基于MapReduce的数据处理 SequenceFile序列化文件的更多相关文章

- 【大数据系列】MapReduce详解

MapReduce是hadoop中的一个计算框架,用来处理大数据.所谓大数据处理,即以价值为导向,对大数据加工,挖掘和优化等各种处理. MapReduce擅长处理大数据,这是由MapReduce的设计 ...

- 【大数据系列】MapReduce示例好友推荐

package org.slp; import org.apache.hadoop.io.LongWritable; import org.apache.hadoop.io.Text; import ...

- 【大数据系列】MapReduce示例一年之内的最高气温

一.项目采用maven构建,如下为pom.xml中引入的jar包 <project xmlns="http://maven.apache.org/POM/4.0.0" xml ...

- 大数据系列之分布式计算批处理引擎MapReduce实践-排序

清明刚过,该来学习点新的知识点了. 上次说到关于MapReduce对于文本中词频的统计使用WordCount.如果还有同学不熟悉的可以参考博文大数据系列之分布式计算批处理引擎MapReduce实践. ...

- 大数据系列之分布式计算批处理引擎MapReduce实践

关于MR的工作原理不做过多叙述,本文将对MapReduce的实例WordCount(单词计数程序)做实践,从而理解MapReduce的工作机制. WordCount: 1.应用场景,在大量文件中存储了 ...

- 大数据系列4:Yarn以及MapReduce 2

系列文章: 大数据系列:一文初识Hdfs 大数据系列2:Hdfs的读写操作 大数据谢列3:Hdfs的HA实现 通过前文,我们对Hdfs的已经有了一定的了解,本文将继续之前的内容,介绍Yarn与Yarn ...

- 大数据系列之并行计算引擎Spark介绍

相关博文:大数据系列之并行计算引擎Spark部署及应用 Spark: Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎. Spark是UC Berkeley AMP lab ( ...

- 大数据系列(2)——Hadoop集群坏境CentOS安装

前言 前面我们主要分析了搭建Hadoop集群所需要准备的内容和一些提前规划好的项,本篇我们主要来分析如何安装CentOS操作系统,以及一些基础的设置,闲言少叙,我们进入本篇的正题. 技术准备 VMwa ...

- 大数据实时处理-基于Spark的大数据实时处理及应用技术培训

随着互联网.移动互联网和物联网的发展,我们已经切实地迎来了一个大数据 的时代.大数据是指无法在一定时间内用常规软件工具对其内容进行抓取.管理和处理的数据集合,对大数据的分析已经成为一个非常重要且紧迫的 ...

随机推荐

- 转载: IM系统架构设计之浅见

出处:http://yaocoder.blog.51cto.com/2668309/1412029 背 景:除去大名鼎鼎的QQ这款即时聊天工具,还有许多细分行业的IM,比如淘宝阿里旺旺.网易泡泡.YY ...

- 系统中hosts文件有哪些作用

hosts文件位于系统盘C:\Windows\System32\drivers\etc中,hosts是一个没有扩展名的系统文件,其基本作用就是将一些常用的网址域名与其对应的IP地址建立一个关联“数据库 ...

- Oracle高级查询之CONNECT BY

为了方便大家学习和测试,所有的例子都是在Oracle自带用户Scott下建立的. Oracle中的select语句可以用start with ... connect by prior ...子句实现递 ...

- Android 布局学习之——LinearLayout属性baselineAligned的作用及baseline

相信大家对LinearLayout已经相当熟悉,但你们是否了解它的属性baselineAligned呢? Android官方文档是这么描述的:

- Android Studio配置设置

文章来源:http://www.cnblogs.com/smyhvae/p/4390905.html

- 检出商品详情中的图片并替换url

原有的批量导入是按照系统本身的功能导入商品,现在需要用接口将图片上传图片服务器 所以需要将批量导入的商品图片取出来,上传后替换掉原来的url (1)检出详情中的图片,用文件名做key private ...

- ActiveMq持久化数据

A:持久化为文件 这个你装ActiveMQ时默认就是这种,只要你设置消息为持久化就可以了.涉及到的配置和代码有 <persistenceAdapter> <kahaDB direct ...

- Android跑指定包Monkey脚本

Android跑指定包Monkey脚本 adb shell monkey –p com.android.mms --throttle 1000 -v -v -v -s 1 --ignore-secur ...

- SpringMVC-----使用Maven创建Web项目

1.创建一个Maven的project 2.不使用骨架,去掉勾 3.这里的Packing 选择 war的形式 由于packing是war包,那么下面也就多出了webapp的目录 4.由于我们的项目要使 ...

- SpringMVC由浅入深day02_8json数据交互

8 json数据交互 8.1 为什么要进行json数据交互 json数据格式在接口调用中.html页面中较常用,json格式比较简单,解析还比较方便. 比如:webservice接口,传输json数据 ...