Storm编程入门API系列之Storm的Topology多个tasks数目控制实现

前期博客

Storm编程入门API系列之Storm的Topology默认Workers、默认executors和默认tasks数目

Storm编程入门API系列之Storm的Topology多个Workers数目控制实现

继续编写

StormTopologyMoreTask.java

package zhouls.bigdata.stormDemo; import java.util.Map; import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.StormSubmitter;

import org.apache.storm.generated.AlreadyAliveException;

import org.apache.storm.generated.AuthorizationException;

import org.apache.storm.generated.InvalidTopologyException;

import org.apache.storm.spout.SpoutOutputCollector;

import org.apache.storm.task.OutputCollector;

import org.apache.storm.task.TopologyContext;

import org.apache.storm.topology.OutputFieldsDeclarer;

import org.apache.storm.topology.TopologyBuilder;

import org.apache.storm.topology.base.BaseRichBolt;

import org.apache.storm.topology.base.BaseRichSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Tuple;

import org.apache.storm.tuple.Values;

import org.apache.storm.utils.Utils; public class StormTopologyMoreTask { public static class MySpout extends BaseRichSpout{

private Map conf;

private TopologyContext context;

private SpoutOutputCollector collector;

public void open(Map conf, TopologyContext context,

SpoutOutputCollector collector) {

this.conf = conf;

this.collector = collector;

this.context = context;

} int num = ;

public void nextTuple() {

num++;

System.out.println("spout:"+num);

this.collector.emit(new Values(num));

Utils.sleep();

} public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("num"));

} } public static class MyBolt extends BaseRichBolt{ private Map stormConf;

private TopologyContext context;

private OutputCollector collector;

public void prepare(Map stormConf, TopologyContext context,

OutputCollector collector) {

this.stormConf = stormConf;

this.context = context;

this.collector = collector;

} public void execute(Tuple input) {

Integer num = input.getIntegerByField("num");

System.out.println("线程id:"+Thread.currentThread().getId()+",接收的值为:"+num);

} public void declareOutputFields(OutputFieldsDeclarer declarer) { } } public static void main(String[] args) {

TopologyBuilder topologyBuilder = new TopologyBuilder();

String spout_id = MySpout.class.getSimpleName();

String bolt_id = MyBolt.class.getSimpleName(); topologyBuilder.setSpout(spout_id, new MySpout());

topologyBuilder.setBolt(bolt_id, new MyBolt()).setNumTasks().shuffleGrouping(spout_id); Config config = new Config();

String topology_name = StormTopologyMoreTask.class.getSimpleName();

if(args.length==){

//在本地运行

LocalCluster localCluster = new LocalCluster();

localCluster.submitTopology(topology_name, config, topologyBuilder.createTopology());

}else{

//在集群运行

try {

StormSubmitter.submitTopology(topology_name, config, topologyBuilder.createTopology());

} catch (AlreadyAliveException e) {

e.printStackTrace();

} catch (InvalidTopologyException e) {

e.printStackTrace();

} catch (AuthorizationException e) {

e.printStackTrace();

}

} } }

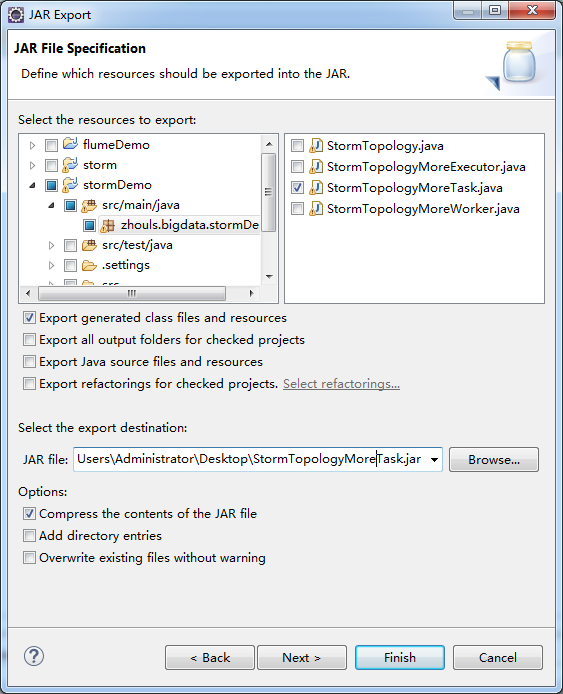

打jar包

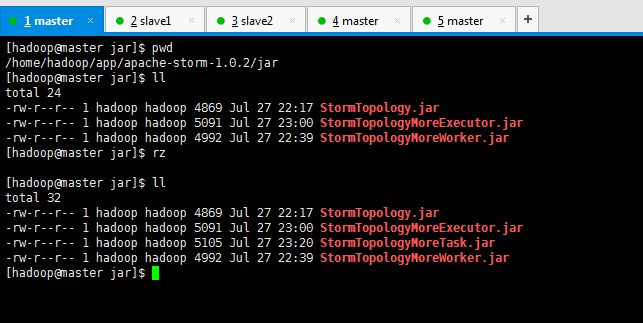

[hadoop@master jar]$ pwd

/home/hadoop/app/apache-storm-1.0./jar

[hadoop@master jar]$ ll

total

-rw-r--r-- hadoop hadoop Jul : StormTopology.jar

-rw-r--r-- hadoop hadoop Jul : StormTopologyMoreExecutor.jar

-rw-r--r-- hadoop hadoop Jul : StormTopologyMoreWorker.jar

[hadoop@master jar]$ rz [hadoop@master jar]$ ll

total

-rw-r--r-- hadoop hadoop Jul : StormTopology.jar

-rw-r--r-- hadoop hadoop Jul : StormTopologyMoreExecutor.jar

-rw-r--r-- hadoop hadoop Jul : StormTopologyMoreTask.jar

-rw-r--r-- hadoop hadoop Jul : StormTopologyMoreWorker.jar

[hadoop@master jar]$

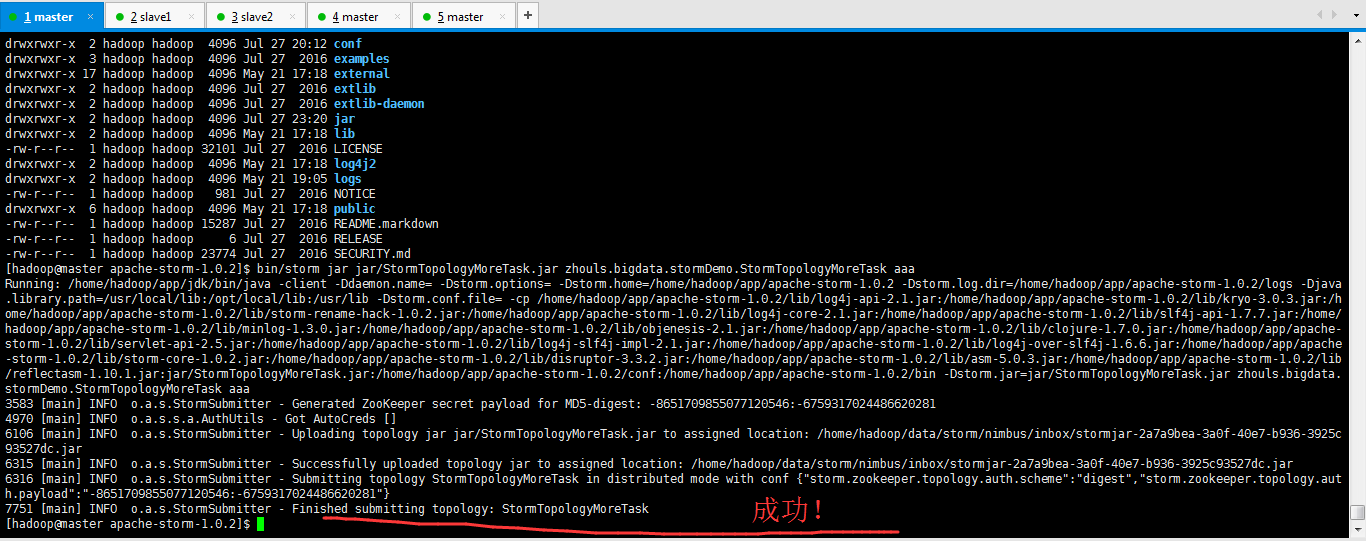

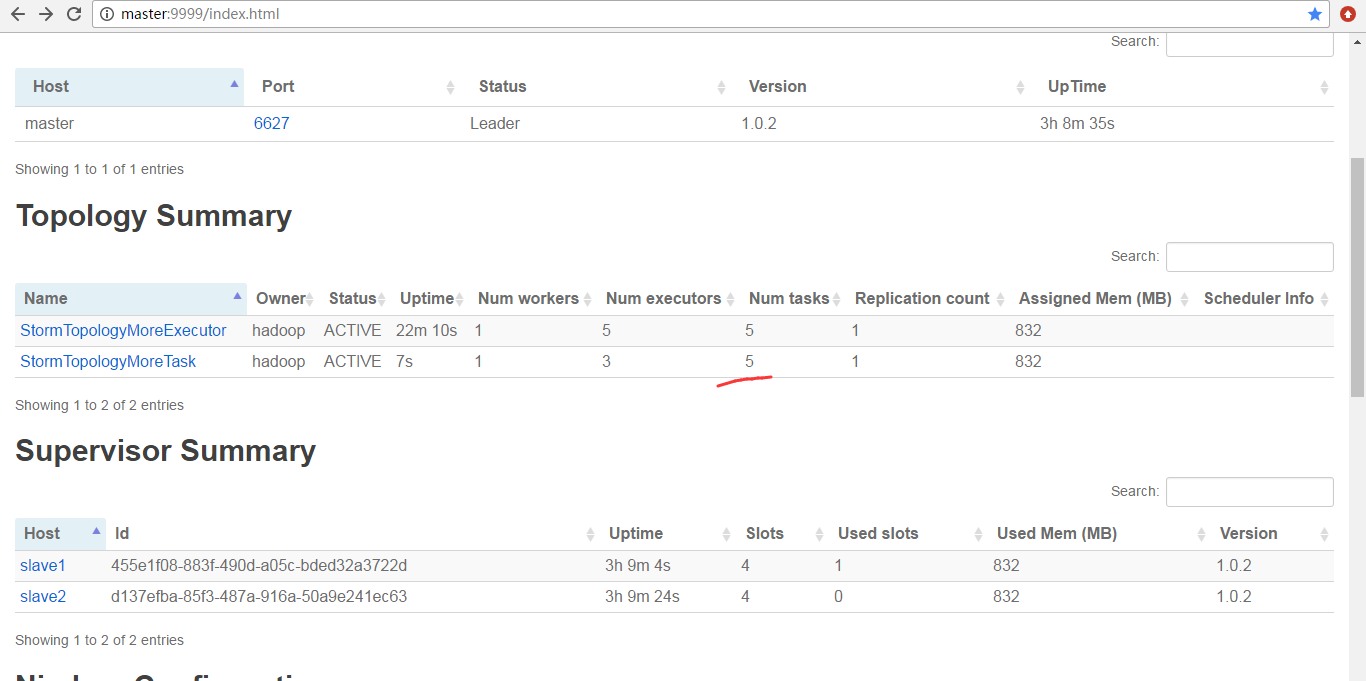

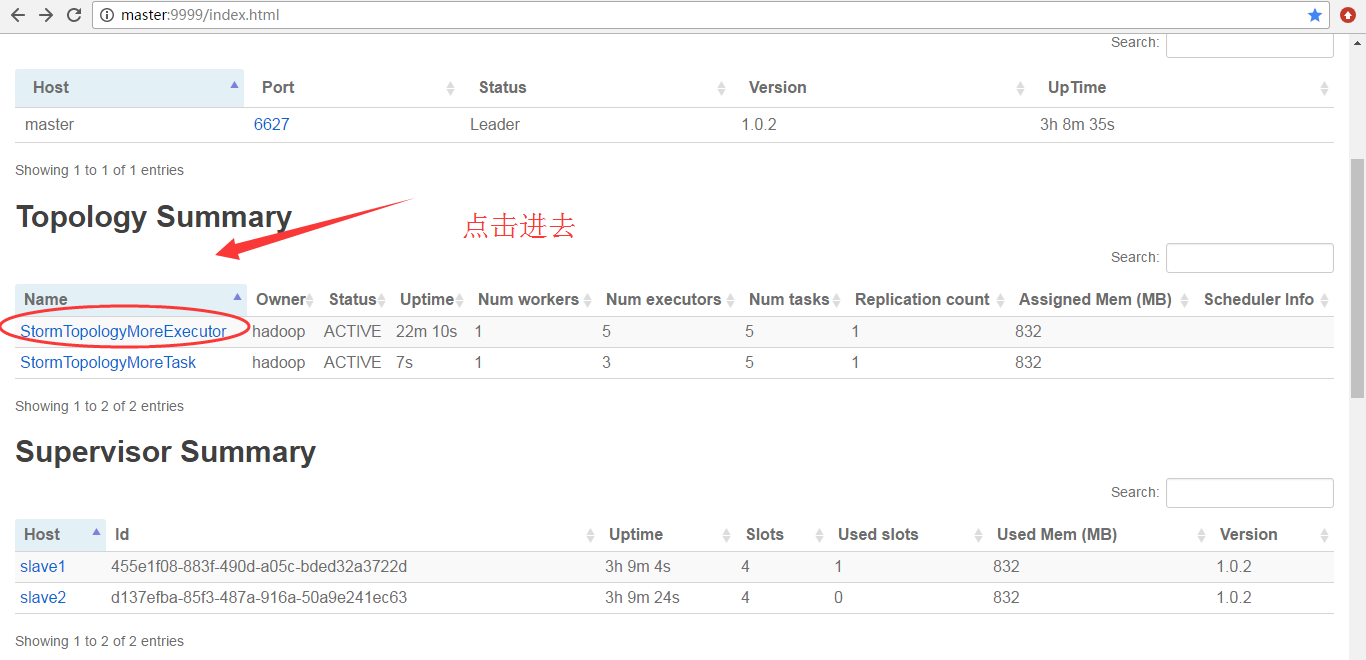

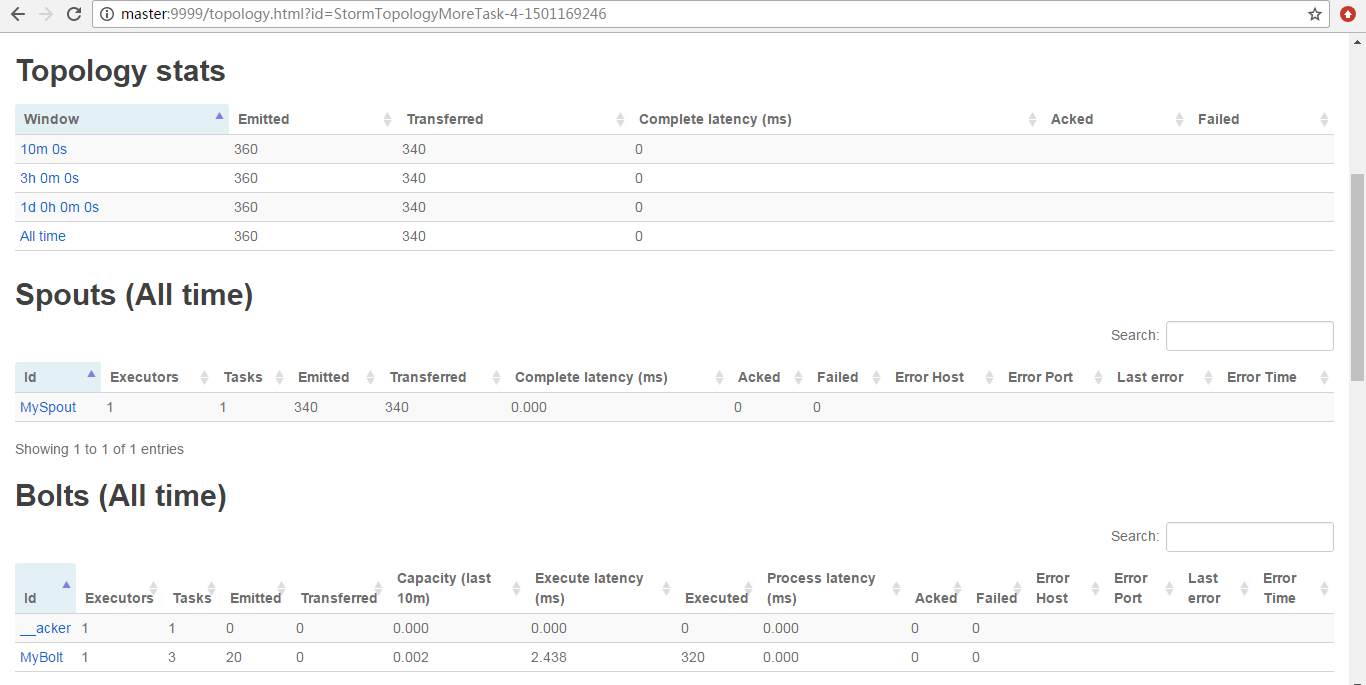

提交作业之前

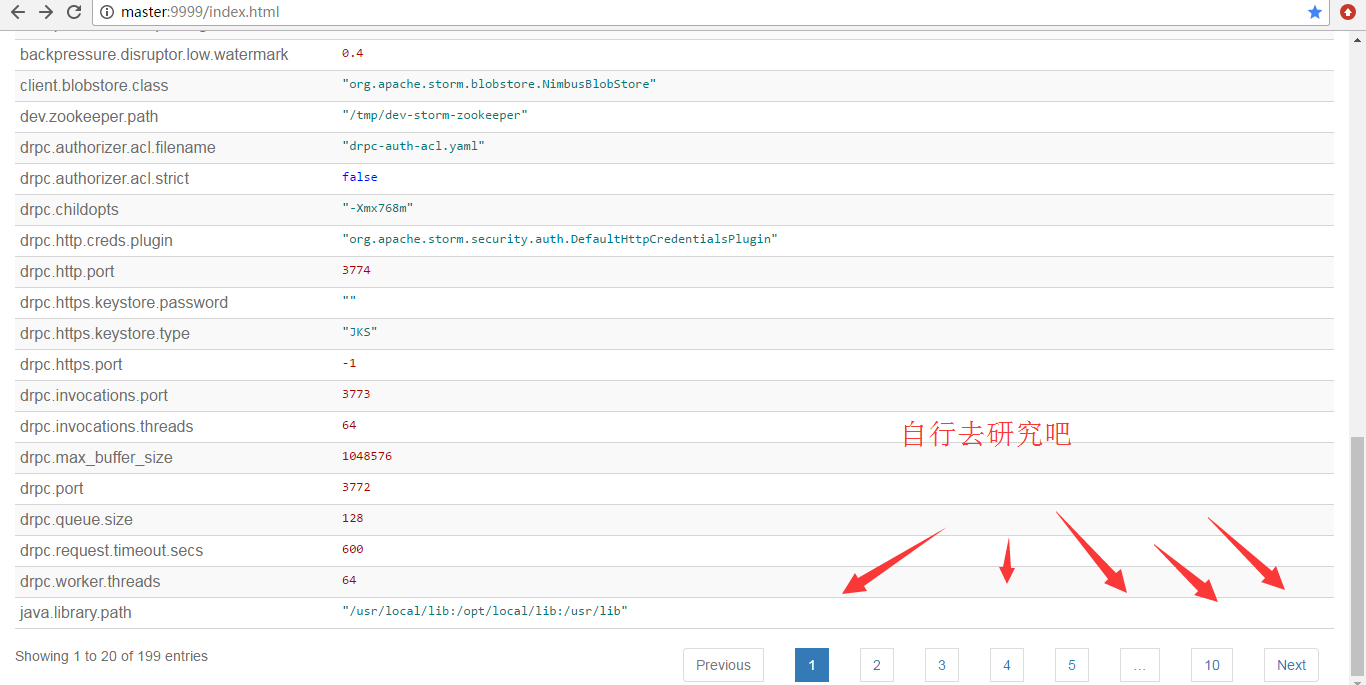

为什么,会是如上的数字呢?大家要学,就要深入去学和理解。

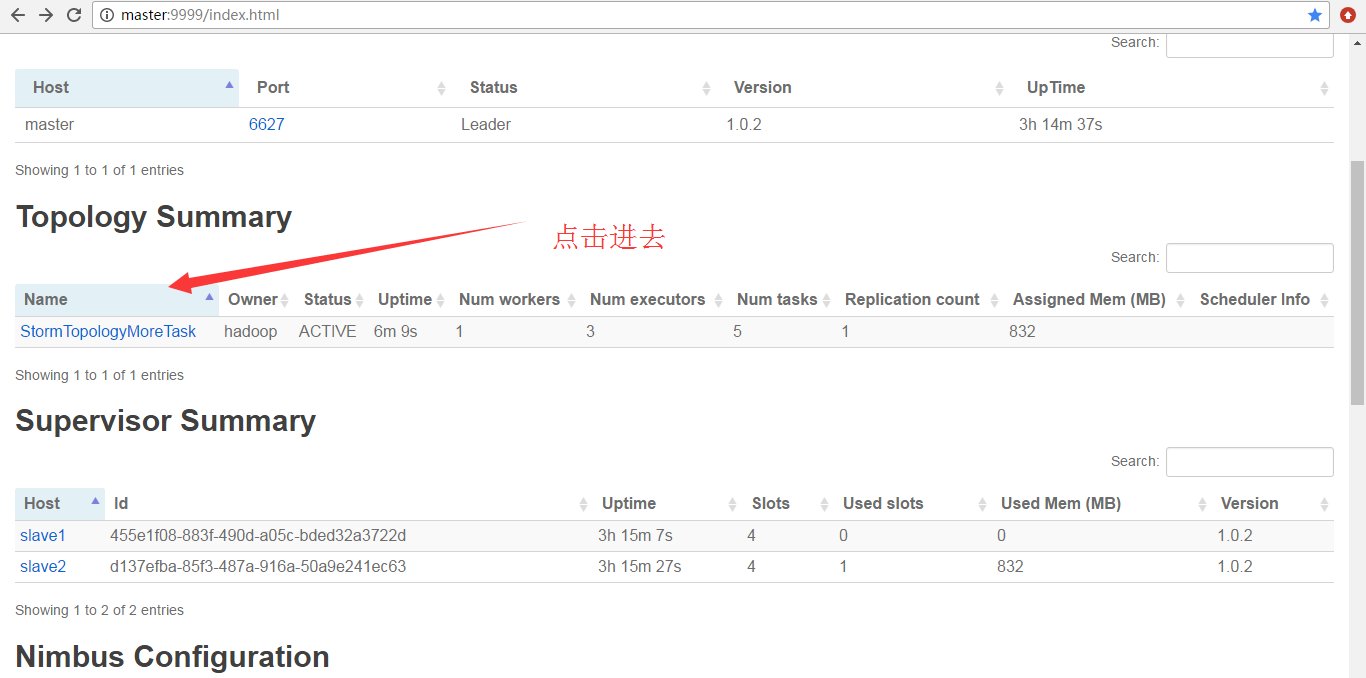

因为,我之前运行的StormTopologyMoreExecutor没有停掉

为什么,会是如上的数字呢?大家要学,就要深入去学和理解。

Storm编程入门API系列之Storm的Topology多个tasks数目控制实现的更多相关文章

- Storm编程入门API系列之Storm的Topology多个Workers数目控制实现

前期博客 Storm编程入门API系列之Storm的Topology默认Workers.默认executors和默认tasks数目 继续编写 StormTopologyMoreWorker.java ...

- Storm编程入门API系列之Storm的Topology多个Executors数目控制实现

前期博客 Storm编程入门API系列之Storm的Topology默认Workers.默认executors和默认tasks数目 Storm编程入门API系列之Storm的Topology多个Wor ...

- Storm编程入门API系列之Storm的定时任务实现

概念,见博客 Storm概念学习系列之storm的定时任务 Storm的定时任务,分为两种实现方式,都是可以达到目的的. 我这里,分为StormTopologyTimer1.java 和 Sto ...

- Storm编程入门API系列之Storm的Topology的stream grouping

概念,见博客 Storm概念学习系列之stream grouping(流分组) Storm的stream grouping的Shuffle Grouping 它是随机分组,随机派发stream里面的t ...

- Storm编程入门API系列之Storm的可靠性的ACK消息确认机制

概念,见博客 Storm概念学习系列之storm的可靠性 什么业务场景需要storm可靠性的ACK确认机制? 答:想要保住数据不丢,或者保住数据总是被处理.即若没被处理的,得让我们知道. publi ...

- Storm编程入门API系列之Storm的Topology默认Workers、默认executors和默认tasks数目

关于,storm的启动我这里不多说了. 见博客 storm的3节点集群详细启动步骤(非HA和HA)(图文详解) 建立stormDemo项目 Group Id : zhouls.bigdata Art ...

- Storm概念学习系列之storm的定时任务

不多说,直接上干货! 至于为什么,有storm的定时任务.这个很简单.但是,这个在工作中非常重要! 假设有如下的业务场景 这个spoult源源不断地发送数据,boilt呢会进行处理.然后呢,处理后的结 ...

- Storm概念学习系列之storm的可靠性

这个概念,对于理解storm很有必要. 1.worker进程死掉 worker是真实存在的.可以jps查看. 正是因为有了storm的可靠性,所以storm会重新启动一个新的worker进程. 2.s ...

- 第1节 storm编程:2、storm的基本介绍

课程大纲: 1.storm的基本介绍 2.storm的架构模型 3.storm的安装 4.storm的UI管理界面 5.storm的编程模型 6.storm的入门程序 7.storm的并行度 8.st ...

随机推荐

- java连接oracle的几种方式

jdbc连接(驱动包ojdbc6.jar)String driver = "oracle.jdbc.OracleDriver"; //驱动标识符 String url = &quo ...

- zoj 2315 New Year Bonus Grant 解题报告

题目链接:http://acm.zju.edu.cn/onlinejudge/showProblem.do?problemId=1315 题目意思:Bill Hates 是公司的老总,她管辖着很多程序 ...

- Log4j输出格式控制--log4j的PatternLayout参数含义

参数 说明 例子 %c 列出logger名字空间的全称,如果加上{<层数>}表示列出从最内层算起的指定层数的名字空间 log4j配置文件参数举例 输出显示媒介 假设当前logger名字 ...

- reactjs的一些笔记

1.使用虚拟DOM作为其不同的实现.同时可以由服务器node.js渲染,从而不需要过重的浏览器DOM支持. 2.虚拟DOM:在浏览器端用javascript实现了一套DOM API.用react开 ...

- hdu-4990 Reading comprehension(快速幂+乘法逆元)

题目链接: Reading comprehension Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 32768/32768 K ( ...

- 动态链接库的ELF头分析

ELF(Executable and Linking Format)用于存储Linux程序. ELF文件分三种类型: 1.目标文件(通常是.o); 2.可执行文件(我们的运行文件) 3.动态库(. ...

- python 基础之第十天(闭包,装饰器,生成器,tarfile与hashlib模块使用)

局部变量与全局变量 局部变量:在函数里面定义的,只有当函数活动时才生效 全局变量:不在函数里面的 In [1]: x=10 In [2]: def bar(): ...: x=20 ...: prin ...

- Java并发之synchronized

Java多线程同步关键词是常用的多线程同步手段.它可以修饰静态类方法,实例方法,或代码块.修饰static静态方法时是对整个类加锁. 一.实现原理 在JVM中对象内存分三块区域,对象头.实例数据.对齐 ...

- ubuntu解决挂起后不能唤醒

安装 laptop-mode 如果你不缺认自已是否安装了laptop-mode-tools工具包,可以在终端中输入下列命令来确认是否安装. dpkg -l | grep laptop-mode-too ...

- 获取当前正在运行的activity

adb shell dumpsys activity activities | findstr "Run"