Qt音视频开发39-海康sdk回调拿到数据GPU绘制的实现

一、前言

采用海康的sdk做开发,最简单最容易的方式就是传入句柄(windows和linux都支持/很多人以为只有windows才支持)即可,这种方式不用自己处理绘制,全部交给了sdk去处理,所以cpu的占用是最低的;还有一种方式是回调函数拿到视频帧数据转成qimage绘制,这种方式优点很明显,能够拿到一张张图片数据,可以任意用来做人工智能算法处理等,缺点是如果采用qpainter绘制,那走的是cpu运算,在低配置的硬件上很耗费cpu,所以需要第三种方式来折中一下,既能拿到每一张图片,又能采用gpu绘制,这下思路出来了,意味着如果qopenglwidget可以直接绘制qimage就好,当然是支持的,qopenglwidget肯定支持rgb数据的绘制,于是只需要将qimage.data的数据传出来交给qopenglwidget绘制就好。亲测下来cpu占用比纯painter绘制下降不少,但是还是比句柄方式要高一些,毕竟回调拿到数据是yv12格式,需要转换成yuv格式,这个转换运算走的是cpu运算。

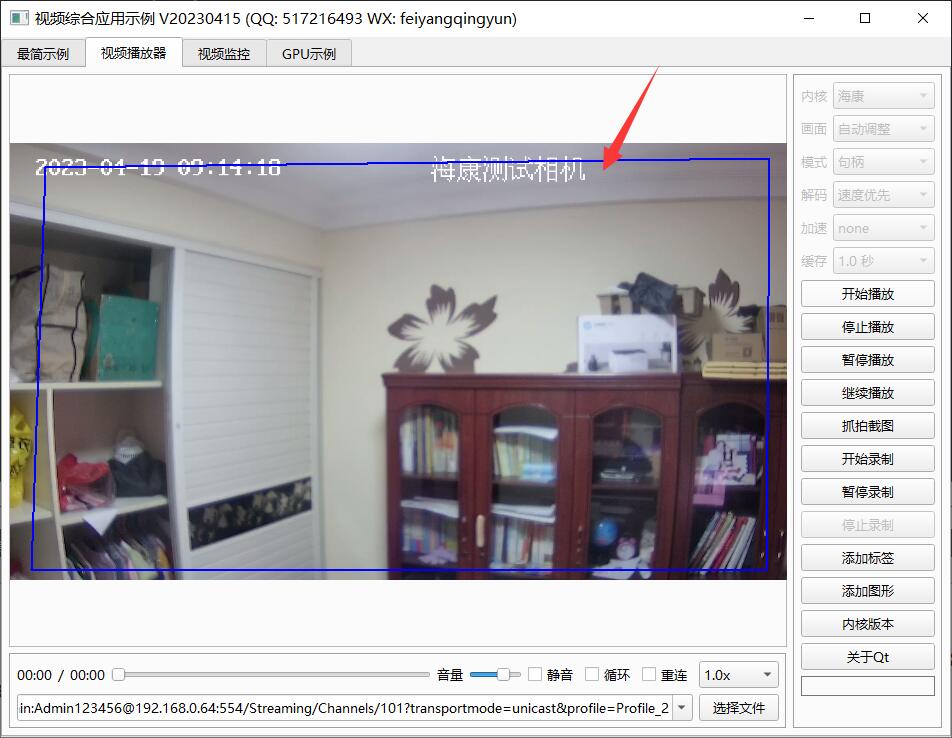

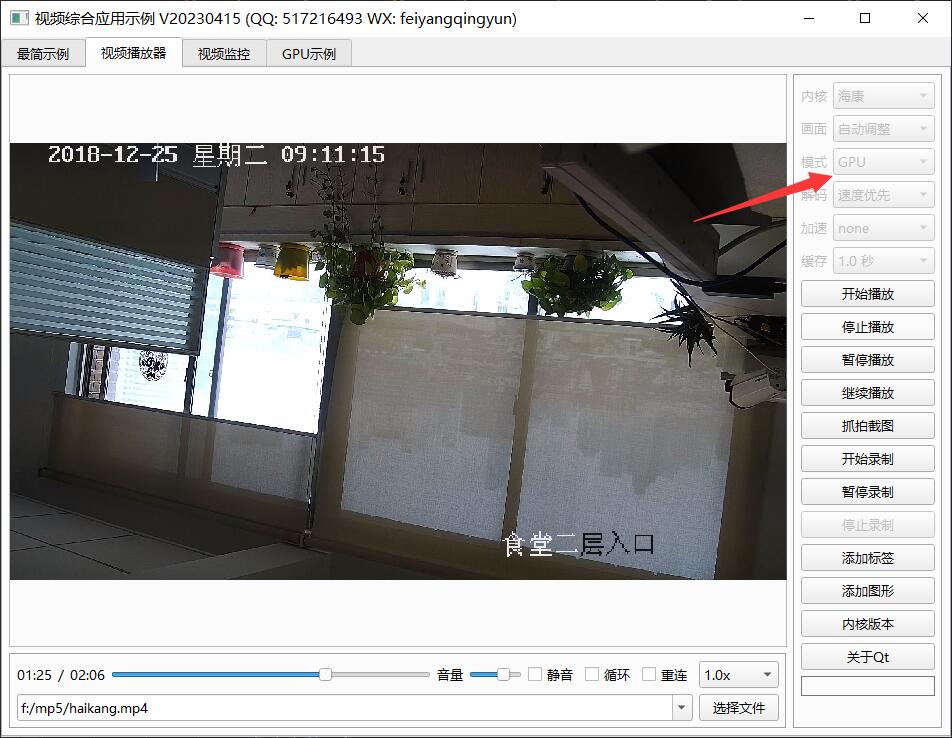

二、效果图

三、体验地址

- 国内站点:https://gitee.com/feiyangqingyun

- 国际站点:https://github.com/feiyangqingyun

- 个人作品:https://blog.csdn.net/feiyangqingyun/article/details/97565652

- 体验地址:https://pan.baidu.com/s/1d7TH_GEYl5nOecuNlWJJ7g 提取码:01jf 文件名:bin_video_demo/bin_linux_video。

四、相关代码

void HaiKangHelper::yv12toYuv(const quint8 *yuv420, quint8 *y, quint8 *u, quint8 *v, int width, int height)

{

//Y分量的长度

int yLen = width * height;

//U和V分量的长度

int uvLen = width / 2 * height / 2;

//海康的uv是反的需要反过来否则颜色发蓝

memcpy((quint8 *)y, yuv420, yLen);

memcpy((quint8 *)v, yuv420 + yLen, uvLen);

memcpy((quint8 *)u, yuv420 + yLen + uvLen, uvLen);

}

void HaiKangHelper::yv12toYuv(const quint8 *yv12, quint8 *yuv, int width, int height, int widthStep)

{

int col, row;

int tmp, idx;

uint y, u, v;

for (row = 0; row < height; row++) {

idx = row * widthStep;

for (col = 0; col < width; col++) {

tmp = (row / 2) * (width / 2) + (col / 2);

y = (uint)yv12[row * width + col];

u = (uint)yv12[width * height + width * height / 4 + tmp];

v = (uint)yv12[width * height + tmp];

yuv[idx + col * 3] = y;

yuv[idx + col * 3 + 1] = u;

yuv[idx + col * 3 + 2] = v;

}

}

}

void HaiKangHelper::ExceptionCallBack(DWORD dwType, LONG lUserID, LONG lHandle, void *pUser)

{

//具体类型含义看头文件或者手册即可

HaiKangThread *thread = (HaiKangThread *)pUser;

thread->debug("异常回调", "");

switch (dwType) {

case EXCEPTION_RECONNECT:

thread->debug("超时重连", "");

break;

default:

break;

}

}

void HaiKangHelper::RealDataCallBack(LONG lRealHandle, DWORD dwDataType, BYTE *pBuffer, DWORD dwBufSize, void *pUser)

{

//每个类都对应自己的port

HaiKangCallbackData *callbackData = (HaiKangCallbackData *)pUser;

HaiKangThread *thread = callbackData->thread;

LONG nPort = thread->port;

DWORD dRet;

switch (dwDataType) {

case NET_DVR_SYSHEAD:

//获取播放库未使用的通道号

if (!PlayM4_GetPort(&nPort)) {

break;

}

if (dwBufSize > 0) {

thread->port = nPort;

if (!PlayM4_OpenStream(nPort, pBuffer, dwBufSize, 1024 * 1024)) {

dRet = PlayM4_GetLastError(nPort);

break;

}

//设置解码回调函数,只解码不显示

bool result = PlayM4_SetDecCallBackMend(nPort, DecCallBack, pUser);

if (!result) {

dRet = PlayM4_GetLastError(nPort);

break;

}

//打开视频解码

if (!PlayM4_Play(nPort, NULL)) {

dRet = PlayM4_GetLastError(nPort);

break;

}

//打开音频解码,需要码流是复合流

if (!PlayM4_PlaySound(nPort)) {

dRet = PlayM4_GetLastError(nPort);

break;

}

}

break;

case NET_DVR_STREAMDATA:

//解码数据

if (dwBufSize > 0 && nPort != -1) {

BOOL inData = PlayM4_InputData(nPort, pBuffer, dwBufSize);

while (!inData) {

//sleep(10);

qApp->processEvents();

inData = PlayM4_InputData(nPort, pBuffer, dwBufSize);

}

}

break;

}

}

void HaiKangHelper::FileEndCallback(LONG nPort, void *pUser)

{

HaiKangThread *thread = (HaiKangThread *)pUser;

thread->stop2();

}

//void HaiKangHelper::DecCallBack(LONG nPort, char *pBuf, LONG nSize, FRAME_INFO *pFrameInfo, LONG pUser, LONG nReserved2)

#ifdef Q_OS_WIN

void HaiKangHelper::DecCallBack(LONG nPort, char *pBuf, LONG nSize, FRAME_INFO *pFrameInfo, void *pUser, void *nReserved2)

#else

void HaiKangHelper::DecCallBack(LONG nPort, char *pBuf, LONG nSize, FRAME_INFO *pFrameInfo, void *pUser, LONG nReserved2)

#endif

{

HaiKangCallbackData *callbackData = (HaiKangCallbackData *)pUser;

HaiKangThread *thread = callbackData->thread;

if (thread->getIsPause()) {

return;

}

quint8 *data = (quint8 *)pBuf;

long frameType = pFrameInfo->nType;

//编码时产生的图像帧率(如果是音频数据则为采样率)

long frameRate = pFrameInfo->nFrameRate;

//视频数据是 T_YV12 音频数据是 T_AUDIO16

if (frameType == T_YV12) {

long width = pFrameInfo->nWidth;

long height = pFrameInfo->nHeight;

//识别尺寸发生变化

thread->checkVideoSize(width, height);

//thread->debug("回调视频", QString("宽高: %1x%2").arg(width).arg(height));

//如果处于截图标志位则立即将图片保存

if (thread->getIsSnap()) {

QImage image(width, height, QImage::Format_RGB888);

yv12ToRgb888(data, image.bits(), width, height);

image.save(thread->getSnapName(), "jpg");

QMetaObject::invokeMethod(thread, "snapFinsh");

}

//如果是绘制则转成图片否则转成yuv用opengl绘制

if (thread->getVideoMode() == VideoMode_Opengl) {

yv12toYuv(data, callbackData->dataY, callbackData->dataU, callbackData->dataV, width, height);

thread->setYuv(width, height, callbackData->dataY, callbackData->dataU, callbackData->dataV);

} else {

QImage image(width, height, QImage::Format_RGB888);

yv12ToRgb888(data, image.bits(), width, height);

thread->setImage(image);

}

} else if (frameType == T_AUDIO16) {

//thread->debug("回调音频", QString("采样: %1").arg(frameRate));

}

}

五、功能特点

5.1 基础功能

- 支持各种音频视频文件格式,比如mp3、wav、mp4、asf、rm、rmvb、mkv等。

- 支持本地摄像头设备,可指定分辨率、帧率。

- 支持各种视频流格式,比如rtp、rtsp、rtmp、http等。

- 本地音视频文件和网络音视频文件,自动识别文件长度、播放进度、音量大小、静音状态等。

- 文件可以指定播放位置、调节音量大小、设置静音状态等。

- 支持倍速播放文件,可选0.5倍、1.0倍、2.5倍、5.0倍等速度,相当于慢放和快放。

- 支持开始播放、停止播放、暂停播放、继续播放。

- 支持抓拍截图,可指定文件路径,可选抓拍完成是否自动显示预览。

- 支持录像存储,手动开始录像、停止录像,部分内核支持暂停录像后继续录像,跳过不需要录像的部分。

- 支持无感知切换循环播放、自动重连等机制。

- 提供播放成功、播放完成、收到解码图片、收到抓拍图片、视频尺寸变化、录像状态变化等信号。

- 多线程处理,一个解码一个线程,不卡主界面。

5.2 特色功能

- 同时支持多种解码内核,包括qmedia内核(Qt4/Qt5/Qt6)、ffmpeg内核(ffmpeg2/ffmpeg3/ffmpeg4/ffmpeg5)、vlc内核(vlc2/vlc3)、mpv内核(mpv1/mp2)、海康sdk、easyplayer内核等。

- 非常完善的多重基类设计,新增一种解码内核只需要实现极少的代码量,就可以应用整套机制。

- 同时支持多种画面显示策略,自动调整(原始分辨率小于显示控件尺寸则按照原始分辨率大小显示,否则等比例缩放)、等比例缩放(永远等比例缩放)、拉伸填充(永远拉伸填充)。所有内核和所有视频显示模式下都支持三种画面显示策略。

- 同时支持多种视频显示模式,句柄模式(传入控件句柄交给对方绘制控制)、绘制模式(回调拿到数据后转成QImage用QPainter绘制)、GPU模式(回调拿到数据后转成yuv用QOpenglWidget绘制)。

- 支持多种硬件加速类型,ffmpeg可选dxva2、d3d11va等,mpv可选auto、dxva2、d3d11va,vlc可选any、dxva2、d3d11va。不同的系统环境有不同的类型选择,比如linux系统有vaapi、vdpau,macos系统有videotoolbox。

- 解码线程和显示窗体分离,可指定任意解码内核挂载到任意显示窗体,动态切换。

- 支持共享解码线程,默认开启并且自动处理,当识别到相同的视频地址,共享一个解码线程,在网络视频环境中可以大大节约网络流量以及对方设备的推流压力。国内顶尖视频厂商均采用此策略。这样只要拉一路视频流就可以共享到几十个几百个通道展示。

- 自动识别视频旋转角度并绘制,比如手机上拍摄的视频一般是旋转了90度的,播放的时候要自动旋转处理,不然默认是倒着的。

- 自动识别视频流播放过程中分辨率的变化,在视频控件上自动调整尺寸。比如摄像机可以在使用过程中动态配置分辨率,当分辨率改动后对应视频控件也要做出同步反应。

- 音视频文件无感知自动切换循环播放,不会出现切换期间黑屏等肉眼可见的切换痕迹。

- 视频控件同时支持任意解码内核、任意画面显示策略、任意视频显示模式。

- 视频控件悬浮条同时支持句柄、绘制、GPU三种模式,非绝对坐标移来移去。

- 本地摄像头设备支持指定设备名称、分辨率、帧率进行播放。

- 录像文件同时支持打开的视频文件、本地摄像头、网络视频流等。

- 瞬间响应打开和关闭,无论是打开不存在的视频或者网络流,探测设备是否存在,读取中的超时等待,收到关闭指令立即中断之前的操作并响应。

- 支持打开各种图片文件,支持本地音视频文件拖曳播放。

- 视频控件悬浮条自带开始和停止录像切换、声音静音切换、抓拍截图、关闭视频等功能。

- 音频组件支持声音波形值数据解析,可以根据该值绘制波形曲线和柱状声音条,默认提供了声音振幅信号。

- 各组件中极其详细的打印信息提示,尤其是报错信息提示,封装的统一打印格式。针对现场复杂的设备环境测试极其方便有用,相当于精确定位到具体哪个通道哪个步骤出错。

- 代码框架和结构优化到最优,性能强悍,持续迭代更新升级。

- 源码支持Qt4、Qt5、Qt6,兼容所有版本。

5.3 视频控件

- 可动态添加任意多个osd标签信息,标签信息包括名字、是否可见、字号大小、文本文字、文本颜色、标签图片、标签坐标、标签格式(文本、日期、时间、日期时间、图片)、标签位置(左上角、左下角、右上角、右下角、居中、自定义坐标)。

- 可动态添加任意多个图形信息,这个非常有用,比如人工智能算法解析后的图形区域信息直接发给视频控件即可。图形信息支持任意形状,直接绘制在原始图片上,采用绝对坐标。

- 图形信息包括名字、边框大小、边框颜色、背景颜色、矩形区域、路径集合、点坐标集合等。

- 每个图形信息都可指定三种区域中的一种或者多种,指定了的都会绘制。

- 内置悬浮条控件,悬浮条位置支持顶部、底部、左侧、右侧。

- 悬浮条控件参数包括边距、间距、背景透明度、背景颜色、文本颜色、按下颜色、位置、按钮图标代码集合、按钮名称标识集合、按钮提示信息集合。

- 悬浮条控件一排工具按钮可自定义,通过结构体参数设置,图标可选图形字体还是自定义图片。

- 悬浮条按钮内部实现了录像切换、抓拍截图、静音切换、关闭视频等功能,也可以自行在源码中增加自己对应的功能。

- 悬浮条按钮对应实现了功能的按钮,有对应图标切换处理,比如录像按钮按下后会切换到正在录像中的图标,声音按钮切换后变成静音图标,再次切换还原。

- 悬浮条按钮单击后都用名称唯一标识作为信号发出,可以自行关联响应处理。

- 悬浮条空白区域可以显示提示信息,默认显示当前视频分辨率大小,可以增加帧率、码流大小等信息。

- 视频控件参数包括边框大小、边框颜色、焦点颜色、背景颜色(默认透明)、文字颜色(默认全局文字颜色)、填充颜色(视频外的空白处填充黑色)、背景文字、背景图片(如果设置了图片优先取图片)、是否拷贝图片、缩放显示模式(自动调整、等比例缩放、拉伸填充)、视频显示模式(句柄、绘制、GPU)、启用悬浮条、悬浮条尺寸(横向为高度、纵向为宽度)、悬浮条位置(顶部、底部、左侧、右侧)。

Qt音视频开发39-海康sdk回调拿到数据GPU绘制的实现的更多相关文章

- 海康SDK编程指南(C#二次开发版本)

海康SDK编程指南 目前使用的海康SDK包括IPC_SDK(硬件设备),Plat_SDK(平台),其中两套SDK都需单独调用海康播放库PlayCtrl.dll来解码视频流,返回视频信息和角度信息.本文 ...

- 使用golang对海康sdk进行业务开发

目录 准备工作 开发环境信息 改写HCNetSDK.h头文件 开发过程 基本数据类型转换 业务开发 参考 项目最近需要改造升级:操作海康摄像头(包括登录,拍照,录像)等基本功能.经过一段时间研究后,发 ...

- 海康SDK编程指南

转至心澄欲遣 目前使用的海康SDK包括IPC_SDK(硬件设备),Plat_SDK(平台),其中两套SDK都需单独调用海康播放库PlayCtrl.dll来解码视频流,返回视频信息和角度信息.本文仅对视 ...

- Android IOS WebRTC 音视频开发总结(四六)-- 从另一个角度看国内首届WebRTC大会

文章主要从开发者角度谈国内首届WebRTC大会,支持原创,文章来自博客园RTC.Blacker,支持原创,转载必须说明出处,更多详见www.rtc.help. -------------------- ...

- WebRTC 音视频开发

WebRTC 音视频开发 webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译 ...

- 转:Android IOS WebRTC 音视频开发总结 (系列文章集合)

随笔分类 - webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译和整理的,译 ...

- 海康SDK JAVA版本调用步骤及问题介绍

一.前言 本文为海康SDK JAVA版本Demo的介绍,采用Eclipse运行,以及一些问题记录. 海康SDK版本:SDK_Win32 Eclipse版本:Mars2.0 JDK版本:1.8.0_15 ...

- Python音视频开发:消除抖音短视频Logo的图形化工具实现

☞ ░ 前往老猿Python博文目录 ░ 一.引言 在<Python音视频开发:消除抖音短视频Logo和去电视台标的实现详解>节介绍了怎么通过Python+Moviepy+OpenCV实现 ...

- Moviepy音视频开发:视频转gif动画或jpg图片exe图形化工具开发案例

☞ ░ 前往老猿Python博文目录 ░ 一.引言 老猿之所以学习和研究Moviepy的使用,是因为需要一个将视频转成动画的工具,当时在网上到处搜索查找免费使用工具,结果找了很多自称免费的工具,但转完 ...

- 【秒懂音视频开发】02_Windows开发环境搭建

音视频开发库的选择 每个主流平台基本都有自己的音视频开发库(API),用以处理音视频数据,比如: iOS:AVFoundation.AudioUnit等 Android:MediaPlayer.Med ...

随机推荐

- SaaS架构:中央库存系统架构设计

大家好,我是汤师爷~ 近年来,越来越多的零售企业大力发展全渠道业务.在销售额增长上,通过线上的小程序.直播.平台渠道等方式,拓展流量变现渠道.在会员增长方面,通过多样的互动方式,全渠道触达消费者,扩大 ...

- 云原生周刊:Kubernetes v1.29 正式发布 | 2023.12.18

开源项目推荐 Robusta KRR Robusta KRR(Kubernetes Resource Recommender)是一个用于优化 Kubernetes 集群中资源分配的 CLI 工具.它从 ...

- GaussDB: db2->gaussdb 函数转换

一.db2->gaussdb函数转换 问题描述:使用GaussDB替代DB2的方案,使用起来还是有些差别,做一下函数的映射转换. DB2写法 GaussDB改写语法 日期函数 days(OU ...

- idea高效实用快捷键【待补充】

1.快捷键 ctrl+alt+L代码格式化 2.快捷键 ctrl+h查看hierarchy,只能查看向上向下继承关系,而不能看实现了哪些接口. 3,选中右键--Diagram可以查看实现了哪些接口 4 ...

- 【FAQ】HarmonyOS SDK 闭源开放能力 —Push Kit(4)

1.问题描述: 目前华为推送API使用的是v2或者v1版本,请问目前最新的鸿蒙next使用v3版本是否兼容v2或者v1,反过来将v2或者v1的api可以推送鸿蒙next的设备吗? 解决方案: v3接口 ...

- cmu15545-数据存储(Database Storage)

蓝图 数据库自己管理磁盘数据和缓冲区,而不是通过操作系统管理(Os is not your friend.). 三层视图 数据库以页(page)为存储数据的基本单位,文件(file)是一系列页的集合, ...

- 🎉TinyVue v3.19.0 正式发布!Tree 组件终于支持虚拟滚动啦!UI 也升级啦,更更符合现代审美~

你好,我是 Kagol,个人公众号:前端开源星球. 我们非常高兴地宣布,2024年10月28日,TinyVue 发布了 v3.19.0 . 本次 3.19.0 版本主要有以下重大变更: 所有组件全面升 ...

- aiflow部署文档

aiflow部署文档 一.简介 本文档用来进行aiflow项目的完全部署 二.安装环境 2.1 安装系统镜像版本 使用Centos镜像文件:CentOS-7-x86_64-DVD-1908.iso c ...

- NSTableView 中 NSTextField无法输入

NSTableView 中的 NSTextField 即使设置为Editable状态也无法编辑,需要生成一个NSTableView的子类并重载validateProposedFirstResponde ...

- 基于C#开源、功能强大、灵活的跨平台开发框架 - Uno Platform

前言 今天大姚给大家分享一个基于C#开源.功能强大.灵活的跨平台开发框架:Uno Platform.通过 Uno Platform,开发者可以利用单一代码库实现多平台兼容,极大地提高了开发效率和代码复 ...