云原生之旅 - 6)不能错过的一款 Kubernetes 应用编排管理神器 Kustomize

前言

相信经过前一篇文章的学习,大家已经对Helm有所了解,本篇文章介绍另一款工具 Kustomize,为什么Helm如此流行,还会出现 Kustomize?而且 Kustomize 自 kubectl 1.14以来早已内置到其中,说明官方对其很认可。

我认为还是Helm 参数化模板方式来自定义配置需要学习复杂的DSL语法,难上手,易出错,而 kustomize 是使用 Kubernetes 原生概念帮助用户创作并复用声明式配置。

认识 Kustomize

安装

brew install kustomize示例解析

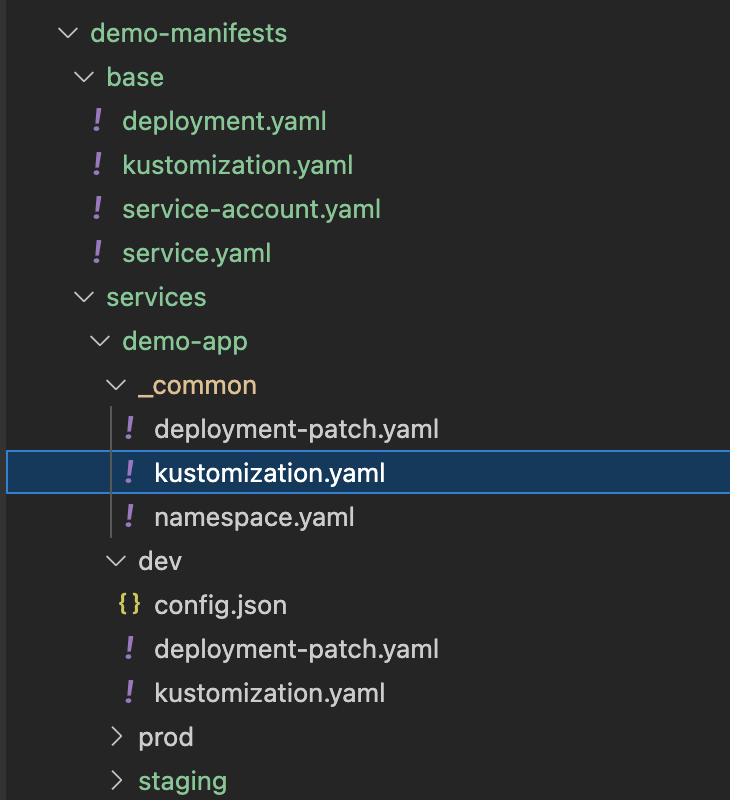

demo-manifests

├── base

│ ├── deployment.yaml

│ ├── kustomization.yaml

│ ├── service-account.yaml

│ └── service.yaml

└── services

├── demo-app

│ ├── _common

│ │ ├── deployment-patch.yaml

│ │ ├── kustomization.yaml

│ │ └── namespace.yaml

│ ├── dev

│ │ ├── config.json

│ │ ├── deployment-patch.yaml

│ │ └── kustomization.yaml

│ ├── staging

│ │ ├── config.json

│ │ ├── deployment-patch.yaml

│ │ └── kustomization.yaml

│ └── prod

│ │ ├── config.json

│ │ ├── deployment-patch.yaml

│ │ └── kustomization.yaml

└── demo-app2

└── xxx

先看base 目录,有几个常见的deployment/service/service-account YAML 资源文件

还有个 kustomization.yaml 配置文件

这里面包含了刚才的几个resource文件以及要应用于它们的一些自定义,如添加一个通用的标签Common Labels

这时候也可以通过 kustomize build 命令来生成完整的YAML进行查看

kustomize build demo-manifests/base > base.yaml

base.yaml

base.yamlbuild 出来的 YAML 每个资源对象上都会存在通用的标签 managed-by: Kustomize

接下来看 Service目录,此目录存放所有的服务项目,比如demo-app , 里面的YAML就是来覆盖base 也就是官方说的 Overlays

只需要把不同的资源描述通过Patch方式覆盖掉base中的就行了。这边我又将三个环境 dev/staging/prod 公共的部分抽取出来放入 common文件夹。

_common/kustomization.yaml文件如下

apiVersion: kustomize.config.k8s.io/v1beta1

kind: Kustomization

resources:

- ../../../base

- namespace.yaml

patchesStrategicMerge:

- deployment-patch.yaml

我这个demo-app 需要configMap,另外心跳接口也不一样, 所以 deployment-patch.yaml 需要写出这些不一样的,然后去覆盖base中的。

apiVersion: apps/v1

kind: Deployment

metadata:

name: NAME_PLACEHOLDER

spec:

template:

spec:

serviceAccountName: NAME_PLACEHOLDER

containers:

- name: app

image: wadexu007/demo:IMG_TAG_PLACEHOLDER

livenessProbe:

failureThreshold: 5

httpGet:

path: /pizzas

port: 8080

initialDelaySeconds: 10

periodSeconds: 40

timeoutSeconds: 1

readinessProbe:

failureThreshold: 5

httpGet:

path: /pizzas

port: 8080

initialDelaySeconds: 10

periodSeconds: 20

timeoutSeconds: 1

volumeMounts:

- name: config-volume

mountPath: /app/conf/config.json

subPath: config.json

volumes:

- name: config-volume

configMap:

name: demo-app-config

deployment-patch.yaml

---

apiVersion: v1

kind: Namespace

metadata:

name: demo

namespace.yaml

### 文章首发于博客园 https://www.cnblogs.com/wade-xu/p/16839829.html

最后我们看 dev/kustomization.yaml

apiVersion: kustomize.config.k8s.io/v1beta1

kind: Kustomization

resources:

- ../_common

namespace: demo

commonLabels:

app: demo-app

replicas:

- count: 1

name: demo-app

configMapGenerator:

- files:

- config.json

name: demo-app-config

patches:

- patch: |-

- op: replace

path: /metadata/name

value: demo-app

target:

name: NAME_PLACEHOLDER

patchesStrategicMerge:

- deployment-patch.yaml

images:

- name: wadexu007/demo

newTag: 1.0.0

dev env 里面将replicas设置成1, 用config.json 生成 configMap

{

"SOME_CONFIG": "/demo/path"

}

config.json

deployment-patch.yaml 里面也将container resource request/limit 配置设置小一点, 采用 patchesStrategicMerge 与 common 和 base里面的deployment资源合并。

apiVersion: apps/v1

kind: Deployment

metadata:

name: NAME_PLACEHOLDER

spec:

template:

spec:

containers:

- name: app

resources:

limits:

cpu: 1

memory: 1Gi

requests:

cpu: 200m

memory: 256Mi

deployment-patch.yaml

另外还采用了 patch 的方式,改了每个资源的name --> demo-app

以及images 替换了原来的 image name and tag.

kustomize 命令如下

kustomize build demo-manifests/services/demo-app/dev > demo-app.yaml

如果用 kubectl 命令的话,示例如下

kubectl kustomize services/demo-app/dev/ > demo-app.yaml

最终结果

apiVersion: v1

kind: Namespace

metadata:

labels:

app: demo-app

name: demo

---

apiVersion: v1

kind: ServiceAccount

metadata:

labels:

app: demo-app

managed-by: Kustomize

name: demo-app

namespace: demo

---

apiVersion: v1

data:

config.json: |-

{

"SOME_CONFIG": "/demo/path"

}

kind: ConfigMap

metadata:

labels:

app: demo-app

name: demo-app-config-t7c64mbtt2

namespace: demo

---

apiVersion: v1

kind: Service

metadata:

labels:

app: demo-app

managed-by: Kustomize

name: demo-app

namespace: demo

spec:

ports:

- port: 8080

protocol: TCP

targetPort: http

selector:

app: demo-app

managed-by: Kustomize

type: ClusterIP

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: demo-app

managed-by: Kustomize

name: demo-app

namespace: demo

spec:

replicas: 1

selector:

matchLabels:

app: demo-app

managed-by: Kustomize

template:

metadata:

labels:

app: demo-app

managed-by: Kustomize

spec:

containers:

- image: wadexu007/demo:1.0.0

imagePullPolicy: IfNotPresent

livenessProbe:

failureThreshold: 5

httpGet:

path: /pizzas

port: 8080

initialDelaySeconds: 10

periodSeconds: 40

timeoutSeconds: 1

name: app

ports:

- containerPort: 8080

name: http

readinessProbe:

failureThreshold: 5

httpGet:

path: /pizzas

port: 8080

initialDelaySeconds: 10

periodSeconds: 20

timeoutSeconds: 1

resources:

limits:

cpu: 1

memory: 1Gi

requests:

cpu: 200m

memory: 256Mi

securityContext:

allowPrivilegeEscalation: false

volumeMounts:

- mountPath: /app/conf/config.json

name: config-volume

subPath: config.json

serviceAccountName: demo-app

volumes:

- configMap:

name: demo-app-config-t7c64mbtt2

name: config-volume

demo-app.yaml

### https://www.cnblogs.com/wade-xu/p/16839829.html

staging/prod 文件夹也是类似dev的文件,环境不一样,config.json 以及资源配置,image tag 不一样,显示申明就行了。

完整代码请参考我的 Github

涵盖 Kustomize 知识点

- commonLabels

- patchesStrategicMerge

- patches

- configMapGenerator

- replicas

- images

总结

经过本篇文章的学习,以及上一篇 [云原生之旅 - 5)Kubernetes时代的包管理工具 Helm ]关于Helm的学习,您已经能体会到两款工具的不同之处。

总的来说,Helm 有自己一套体系来管理应用,而 kustomize 更轻量级,也更灵活。另外,Kustomize也有 Terraform provider 通过TF来安装。

云原生之旅 - 6)不能错过的一款 Kubernetes 应用编排管理神器 Kustomize的更多相关文章

- 云原生之旅 - 8)云原生时代的网关 Ingress Nginx

前言 当我们在Kubernetes部署的服务需要暴露给外部用户使用时,有三种选择:LoadBalancer,NodePort, Ingress. LoadBalancer类型得结合各个Cloud Pr ...

- 云原生之旅 - 11)基于 Kubernetes 动态伸缩 Jenkins Build Agents

前言 上一篇文章 云原生之旅 - 10)手把手教你安装 Jenkins on Kubernetes 我们介绍了在 Kubernetes 上安装 Jenkins,本文介绍下如何设置k8s pod作为Je ...

- 云原生之旅 - 9)云原生时代网关的后起之秀Envoy Proxy 和基于Envoy 的 Emissary Ingress

前言 前一篇文章讲述了基于Nginx代理的Kuberenetes Ingress Nginx[云原生时代的网关 Ingress Nginx]这次给大家介绍下基于Envoy的 Emissary Ingr ...

- 云原生之旅 - 5)Kubernetes时代的包管理工具 Helm

前言 上一篇文章 [基础设施即代码 使用 Terraform 创建 Kubernetes] 教会了你如何在Cloud上面建Kubernetes资源,那么本篇来讲一下如何在Kubernetes上面部署应 ...

- 云原生之旅 - 7)部署Terrform基础设施代码的自动化利器 Atlantis

前言 前面有几篇文章讲述了如何使用Terraform创建资源 (基础设施即代码 Terraform 快速入门, 使用 Terraform 创建 Kubernetes) 以及 Kubernetes时代的 ...

- 云原生之旅 - 10)手把手教你安装 Jenkins on Kubernetes

前言 谈到持续集成工具就离不开众所周知的Jenkins,本文带你了解如何在 Kubernetes 上安装 Jenkins,后续文章会带你深入了解如何使用k8s pod 作为 Jenkins的build ...

- 云原生之旅 - 2)Docker 容器化你的应用

前言 上文中我们用Golang写了一个HTTP server,本篇文章我们讲述如何容器化这个应用,为后续部署到kubernetes 做准备. 关键词:Docker, Containerization, ...

- 云原生之旅 - 4)基础设施即代码 使用 Terraform 创建 Kubernetes

前言 上一篇文章我们已经简单的入门Terraform, 本篇介绍如何使用Terraform在GCP和AWS 创建Kubernetes 资源. Kubernetes 在云原生时代的重要性不言而喻,等于这 ...

- 云原生之旅 - 3)Terraform - Create and Maintain Infrastructure as Code

前言 工欲善其事,必先利其器.本篇文章我们介绍下 Terraform,为后续创建各种云资源做准备,比如Kubernetes 关键词:IaC, Infrastructure as Code, Terra ...

随机推荐

- HCIA-Datacom 2.1 实验一:IPv4编址及IPv4路由基础实验

实验目的 掌握接口IPv4地址的配置方法 理解LoopBack接口的作用与含义 理解直连路由的产生原则 掌握静态路由的配置方法并理解其生效的条件 掌握通过PING工具测试网络层联通性 掌握 ...

- Word 分栏符怎么使用

如果你使用栏来设置文档格式(如在某些新闻稿布局中),则文本将自动从一栏排列到另一栏.可以插入你自己的分栏符,以更好地控制文档格式. 单击"布局"选项卡--"页面设置&qu ...

- flutter系列之:构建Widget的上下文环境BuildContext详解

目录 简介 BuildContext的本质 BuildContext和InheritedWidget BuildContext的层级关系 总结 简介 我们知道Flutter中有两种Widget,分别是 ...

- 【java】学习路径27-HashSet、TreeSet,HashMap

学习路径20-27的所有源代码都可以在此下载 https://www.aliyundrive.com/s/cg8jTRbg6vy HashSet.TreeSet中,Set表示集合,特性在于:无序的.不 ...

- 【java】学习路线12-内部类的使用事项

//内部类只能在其外部类当中使用//局部内部类:定义在方法里面//如果内部类和外部类有重名,就近原则在内部类中优先访问内部类.//如果想访问宿主类的同名成员,使用OuterClass.this.xxx ...

- 使用STM32控制TMC5160驱动步进电机

首先先来了解一下TMC5160的3种工作模式 TMC5160通过两个引脚来控制它的工作模式:SD_MODE和SPI_MODE. 1.当SD_MODE接地,SPI_MODE拉高,TMC5160即工作在模 ...

- kingbaseES V8R6集群备份恢复案例之---备库作为repo主机执行物理备份

案例说明: 此案例是在KingbaseES V8R6集群环境下,当主库磁盘空间不足时,执行sys_rman备份,将集群的备库节点作为repo主机,执行备份,并将备份存储在备库的磁盘空间. 集群架构 ...

- Cluster table 与性能

用户数据行存储在文件系统中的堆文件中,而这些行以不确定的顺序存储.如果表最初以插入/复制的顺序加载,那么以后的插入.更新和删除将导致在堆文件中以不可预测的顺序添加行.创建索引创建一个指向堆行的辅助文件 ...

- Servlet小结

1.sevlet的生命周期 用户在发送第一次请求的时候Servlet对象被实例化(AServlet的构造方法被执行了.并且执行的是无参数构造方法.) AServlet对象被创建出来之后,Tomcat服 ...

- day37-IO流04

JavaIO流04 4.常用的类03 4.4节点流和处理流02 4.4.5对象处理流-ObjectInputStream和ObjectOutputStream 1.序列化和反序列化 例子1: 看一个需 ...