Hadoop之Flume 记录

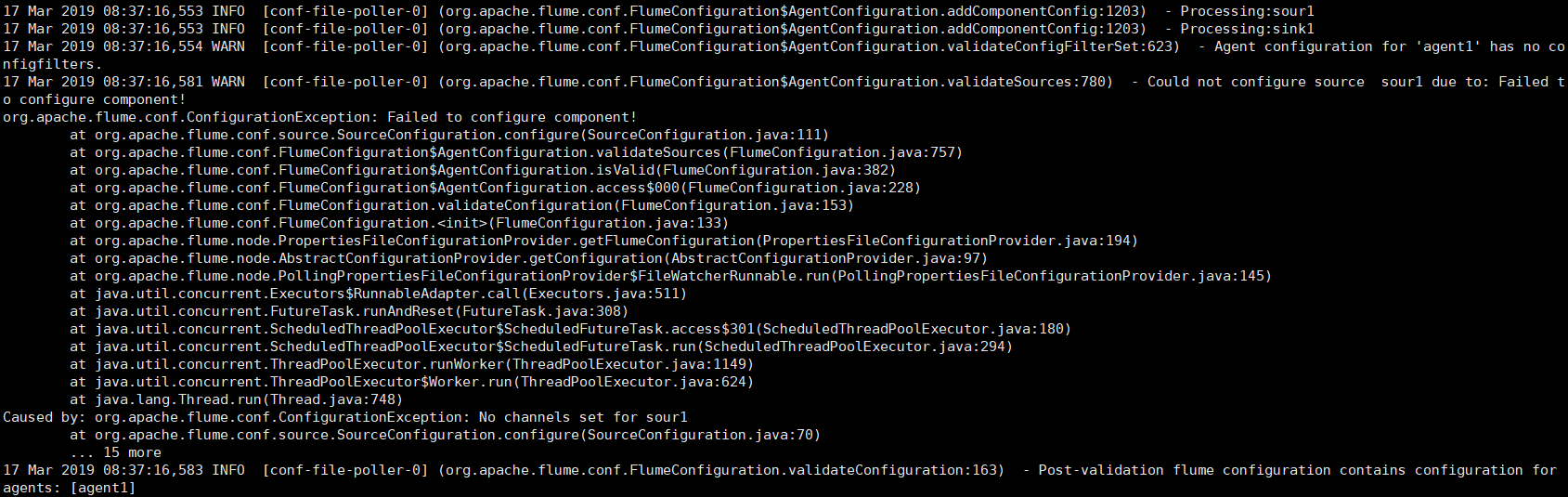

出现这个错误是自己的粗心大意,解决:

在配置flume-conf.properties文件时,source和channel的对应关系是:

myAgentName.sources.mySourceName.channels = myChannelName

myAgentName.sinks.mySinkName.channel = myChannelName

注意其中的后缀,带s和不带s后缀。

这也恰好说明

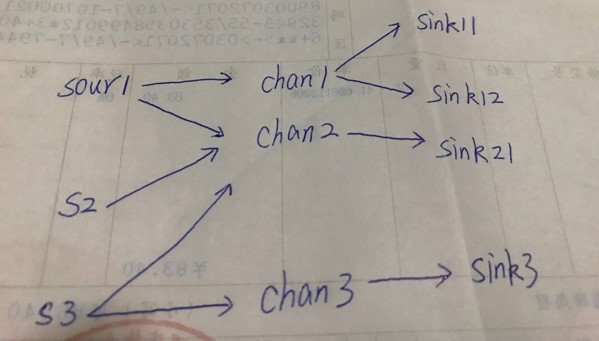

source可以“流向”多个channel,而sink只能接收一个channel的“流入”。

从channel的角度看:channel既可以接收多个source的“流入”,又可以“流向”多个sink

例如多对多关系:

对应的配置如下:

# example.conf: A single-node Flume configuration # Name the components on this agent

agent1.sources=sour1 s2 s3

agent1.sinks=sink1 sink12 sink21 sink3

agent1.channels=chan1 chan2 chan3 # Describe/configure the source

agent1.sources.sour1.type=netcat

agent1.sources.sour1.bind=localhost

agent1.sources.sour1.port=44444 agent1.sources.s2.type=netcat

agent1.sources.s2.bind=localhost

agent1.sources.s2.port=44445 agent1.sources.s3.type=netcat

agent1.sources.s3.bind=localhost

agent1.sources.s3.port=44446 # Describe the sink

agent1.sinks.sink1.type=logger

agent1.sinks.sink12.type=logger

agent1.sinks.sink21.type=logger

agent1.sinks.sink3.type=logger # Use a channel which buffers events in memory

agent1.channels.chan1.type=memory

agent1.channels.chan1.capacity=1000

#agent1.channels.chan1.transactionCapacity=100 agent1.channels.chan2.type=memory

agent1.channels.chan2.capacity=1000 agent1.channels.chan3.type=memory

agent1.channels.chan3.capacity=1000 # Bind the source and sink to the channel

agent1.sources.sour1.channels=chan1 chan2

agent1.sources.s2.channels=chan2

agent1.sources.s3.channels=chan2 chan3 agent1.sinks.sink1.channel=chan1

agent1.sinks.sink12.channel=chan1

agent1.sinks.sink21.channel=chan2

agent1.sinks.sink3.channel=chan3

Hadoop之Flume 记录的更多相关文章

- Hadoop生态圈-Flume的主流source源配置

Hadoop生态圈-Flume的主流source源配置 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客只是配置的是Flume主流的Source,想要了解更详细的配置信息请参 ...

- Hadoop生态圈-Flume的组件之自定义拦截器(interceptor)

Hadoop生态圈-Flume的组件之自定义拦截器(interceptor) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客只是举例了一个自定义拦截器的方法,测试字节传输速 ...

- Hadoop生态圈-Flume的组件之自定义Sink

Hadoop生态圈-Flume的组件之自定义Sink 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客主要介绍sink相关的API使用两个小案例,想要了解更多关于API的小技 ...

- Hadoop生态圈-Flume的组件之sink处理器

Hadoop生态圈-Flume的组件之sink处理器 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一. 二.

- Hadoop生态圈-Flume的组件之拦截器与选择器

Hadoop生态圈-Flume的组件之拦截器与选择器 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客只是配置的是Flume主流的Interceptors,想要了解更详细 ...

- Hadoop生态圈-Flume的主流Channel源配置

Hadoop生态圈-Flume的主流Channel源配置 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一. 二. 三.

- Hadoop生态圈-Flume的主流Sinks源配置

Hadoop生态圈-Flume的主流Sinks源配置 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客只是配置的是Flume主流的Sinks,想要了解更详细的配置信息请参考官 ...

- Hadoop生态圈-flume日志收集工具完全分布式部署

Hadoop生态圈-flume日志收集工具完全分布式部署 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 目前为止,Hadoop的一个主流应用就是对于大规模web日志的分析和处理 ...

- Hadoop运维记录系列

http://slaytanic.blog.51cto.com/2057708/1038676 Hadoop运维记录系列(一) Hadoop运维记录系列(二) Hadoop运维记录系列(三) Hado ...

随机推荐

- 存储类&作用域&生命周期&链接属性

链接属性 (1)大家知道程序从源代码到最终可执行程序,经历的过程:编译.链接. (2)编译阶段就是把源代码搞成.o目标文件,目标文件里面有很多符号和代码段.数据段.bss段等分段.符号就是编程中的变量 ...

- 【XSY3370】道路建设 最短路

题目大意 有一个完全图,边有边权. 对于每个 \(i\),求一棵生成树,使得( \(\sum_{j=1,j\neq i}^n\) \(j\) 到 \(i\) 的路径上边权最小值) 最小. \(n\le ...

- git学习02 - log查看&版本回退

1.查看更新记录 git log / git log --pretty=oneline D:\learn\git_test>git log commit a915e7b12076673d778 ...

- Linux环境配置错误记录

1. pip install --special_version pip10. 版本. 使用命令: python -m pip install pip== 其中, -m 参数的意思是将库中的pyt ...

- 【Linux】Jenkins安装

安装环境准备 操作系统:Linux(CentOS7) 软件:jdk,安装及配置步骤见Linux安装jdk 软件:tomcat,安装及配置见Linux安装tomcat Jenkins安装 由于Jenki ...

- Java:文件字符流和字节流的输入和输出

最近在学习Java,所以就总结一篇文件字节流和字符流的输入和输出. 总的来说,IO流分类如下: 输入输出方向: 输入流(从外设读取到内存)和输出流(从内存输出到外设) 数据的操作方式: 字节流 ...

- 2017-12-20python全栈9期第五天第一节之昨日内容回顾和作业讲解之字母变大写

#!/user/bin/python# -*- coding:utf-8 -*-lis = [2,3,'k',['qwe',20,['k1',['tt','3','1']],89],'ab','adv ...

- html5+hbuilder+夜神模拟器+webview

HTML5 Plus应用概述 首先新建一个移动App项目,文件-->新建-->移动APP HTML5 Plus移动App,简称5+App,是一种基于HTML.JS.CSS编写的运行于手机端 ...

- Android项目打包遇com.android.builder.internal.aapt.v2.Aapt2Exception: AAPT2 error: check logs for details

查了网上很多处理都是在项目的gradle.properties中添加下面的配置,再编译就通过了: android.enableAapt2=false

- python中元组/列表/字典/集合

转自:https://blog.csdn.net/lobo_seeworld/article/details/79404566