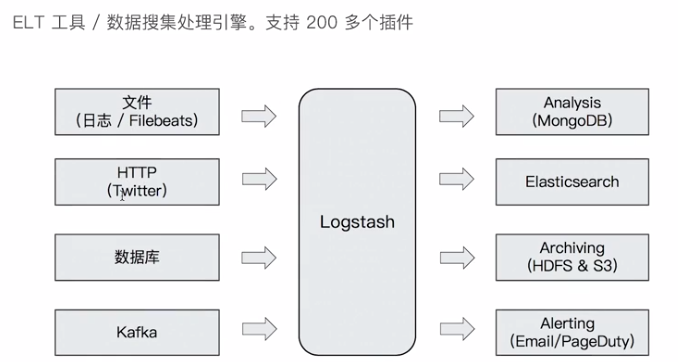

使用LOGSTASH 将数据导入到ES

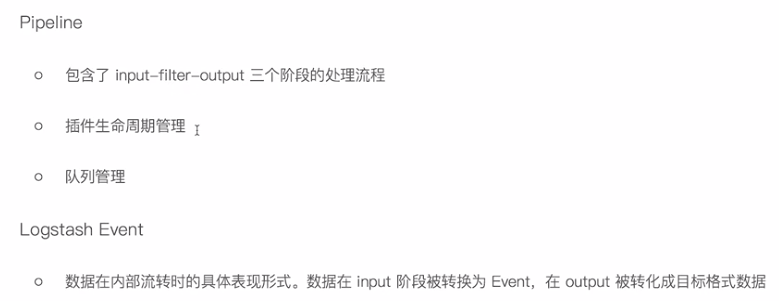

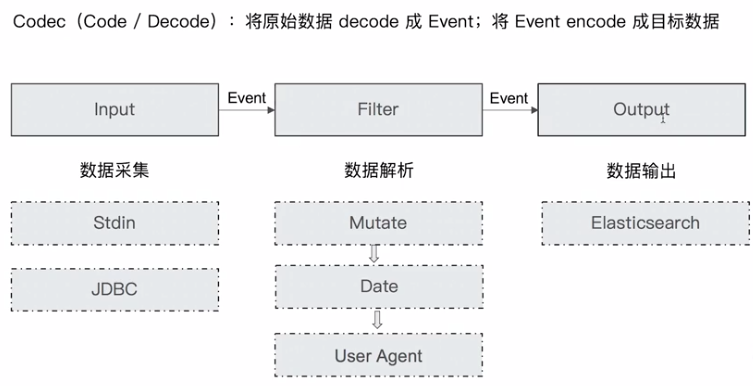

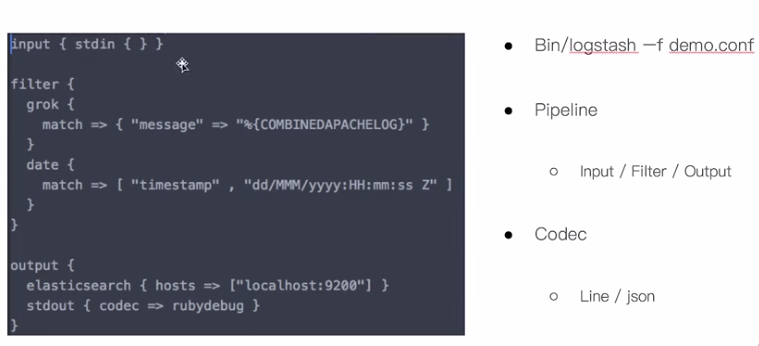

logstash 执行过程

input -->filter -->output

filter 可以对数据进行处理

输出插件

codec plugin

使用脚本将数据导入到ES

input {

jdbc {

jdbc_driver_class => "com.mysql.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://localhost:3306/db_example"

jdbc_user => root

jdbc_password => ymruan123

#启用追踪,如果为true,则需要指定tracking_column

use_column_value => true

#指定追踪的字段,

tracking_column => "last_updated"

#追踪字段的类型,目前只有数字(numeric)和时间类型(timestamp),默认是数字类型

tracking_column_type => "numeric"

#记录最后一次运行的结果

record_last_run => true

#上面运行结果的保存位置

last_run_metadata_path => "jdbc-position.txt"

statement => "SELECT * FROM user where last_updated >:sql_last_value;"

schedule => " * * * * * *"

}

}

output {

elasticsearch {

document_id => "%{id}"

document_type => "_doc"

index => "users"

hosts => ["http://localhost:9200"]

}

stdout{

codec => rubydebug

}

}

使用 logstash 执行

logstash -f mysqltoes.conf

使用别名查询索引

POST /_aliases

{

"actions": [

{

"add": {

"index": "users",

"alias": "view_users",

"filter" : { "term" : { "is_deleted" : false } }

}

}

]

}

创建一个索引别名,过滤掉 只显示 is_deleted 为未删除的数据。

通过别名查询数据

POST view_users/_search

{

"query": {

"term": {

"name.keyword": {

"value": "Jack"

}

}

}

}

使用LOGSTASH 将数据导入到ES的更多相关文章

- Logstash学习之路(四)使用Logstash将mysql数据导入elasticsearch(单表同步、多表同步、全量同步、增量同步)

一.使用Logstash将mysql数据导入elasticsearch 1.在mysql中准备数据: mysql> show tables; +----------------+ | Table ...

- Logstash:把MySQL数据导入到Elasticsearch中

Logstash:把MySQL数据导入到Elasticsearch中 前提条件 需要安装好Elasticsearch及Kibana. MySQL安装 根据不同的操作系统我们分别对MySQL进行安装.我 ...

- ES数据导入导出

ES数据导入导出 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 ...

- 使用Logstash把MySQL数据导入到Elasticsearch中

总结:这种适合把已有的MySQL数据导入到Elasticsearch中 有一个csv文件,把里面的数据通过Navicat Premium 软件导入到数据表中,共有998条数据 文件下载地址:https ...

- 使用logstash拉取MySQL数据存储到es中的再次操作

使用情况说明: 已经使用logstash拉取MySQL数据存储到es中,es中也创建了相应的索引,也存储了数据.假若把这个索引给删除了,再次进行同步操作的话要咋做,从最开始的数据进行同步,而不是新增的 ...

- 通过logstash-input-mongodb插件将mongodb数据导入ElasticSearch

目的很简单,就是将mongodb数据导入es建立相应索引.数据是从特定的网站扒下来,然后进行二次处理,也就是数据去重.清洗,接着再保存到mongodb里,那么如何将数据搞到ElasticSearch中 ...

- MongoDB-Elasticsearch 实时数据导入

时间 2017-09-18 栏目 MongoDB 原文 http://blog.csdn.net/liangxw1/article/details/78019356 5 ways to sync ...

- 用logstash 作数据的聚合统计

用logstash 作数据的聚合统计 以spark-streaming 处理消费数据,统计日志经spark sql存储在mysql中 日志写入方式为append val wordsDataFrame ...

- 日志收集之--将Kafka数据导入elasticsearch

最近需要搭建一套日志监控平台,结合系统本身的特性总结一句话也就是:需要将Kafka中的数据导入到elasticsearch中.那么如何将Kafka中的数据导入到elasticsearch中去呢,总结起 ...

- 使用ES-Hadoop 6.5.4编写MR将数据索引到ES

目录 1. 开发环境 2. 下载地址 3. 使用示例 4. 参考文献 1. 开发环境 Elasticsearch 6.5.4 ES-Hadoop 6.5.4 Hadoop 2.0.0 2. 下载地址 ...

随机推荐

- Google – Cloud Translation API

前言 通常网站内容翻译,我们都不推荐使用 Google Translate.但网站中一些不那么重要的内容确实可以用 Google Translate.比如 Customer Reviews. 这篇是续 ...

- Facebook – Reviews (Graph API)

前言 企业网站经常需要放 customer reviews 来增加 conversion. 常见的 Reviews 平台有 Facebook Reviews 和 Google Reviews. 这篇, ...

- ASP.NET Core Library – MailKit SMTP Client

前言 以前写的 SMTP Client 相关文章: Asp.net core 学习笔记 ( Smtp and Razor template 电子邮件和 Razor 模板 ) ASP.NET Email ...

- 系统编程-文件IO-fcntl系统调用

原型: #include <unistd.h> #include <fcntl.h> int fcntl(int fd, int cmd, ... /* arg */ ); 功 ...

- 大模型应用开发初探 : 快速直观感受RAG

大家好,我是Edison. 上一篇,我们了解了什么如何让一些开源小参数量模型具有函数调用的能力.这一篇,我们来快速了解下RAG(检索增强生成)并通过一个简单的DEMO来直观感受一下它的作用. RAG是 ...

- HDK Include Header File (1.7)

Download 1.7 | 1.7.1 | 1.7.2 1.7.1 使用方法:编译选项->目录->C++包含文件->添加 [解压目录]\include 1.7.2 使用方法:编译选 ...

- [TK] BLO

初步分析 此题描述让我们想到Tarjan求割点,因此我们从割点的角度来探讨一下这道题. 假如我们去掉的不是一个割点,那么它实际上不会对连通性造成影响,但是根据样例可以看出来,删去这个点导致了其余点与当 ...

- 课时05:Linux必备系统命令

- linux内核调试痛点之函数参数抓捕记

1.linux内核调试工具crash并不能直接显示函数参数,而这个对调试又非常重要 下面是工作中一个实际的问题,我们的进程hang在如下一个内核栈中了,通过栈回溯可知是打开了一个nfs3的网盘文件或者 ...

- git 设置代理和取消代理

1.设置代理 git config --global http.proxy "127.0.0.1:1080" 2.取消代理 git config --global --unset ...