Hadoop MapReduce编程 API入门系列之小文件合并(二十九)

不多说,直接上代码。

Hadoop 自身提供了几种机制来解决相关的问题,包括HAR,SequeueFile和CombineFileInputFormat。

Hadoop 自身提供的几种小文件合并机制

Hadoop HAR

将众多小文件打包成一个大文件进行存储,并且打包后原来的文件仍然可以通过Map-reduce进行操作,打包后的文件由索引和存储两大部分组成

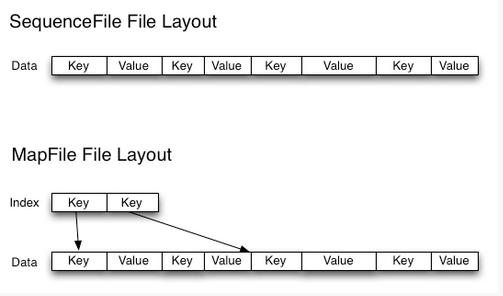

SequeuesFile

Sequence file由一系列的二进制key/value组成,如果key为小文件名,value为文件内容,则可以将大批小文件合并成一个大文件。

CombineFileInputFormat

CombineFileInputFormat是一种新的inputformat,用于将多个文件合并成一个单独的split作为输入,而不是通常使用一个文件作为输入。另外,它会考虑数据的存储位置。

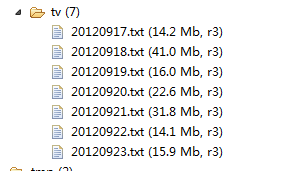

目前很多公司采用的方法就是在数据进入 Hadoop 的 HDFS 系统之前进行合并(也是本博文这方法),一般效果较上述三种方法明显。

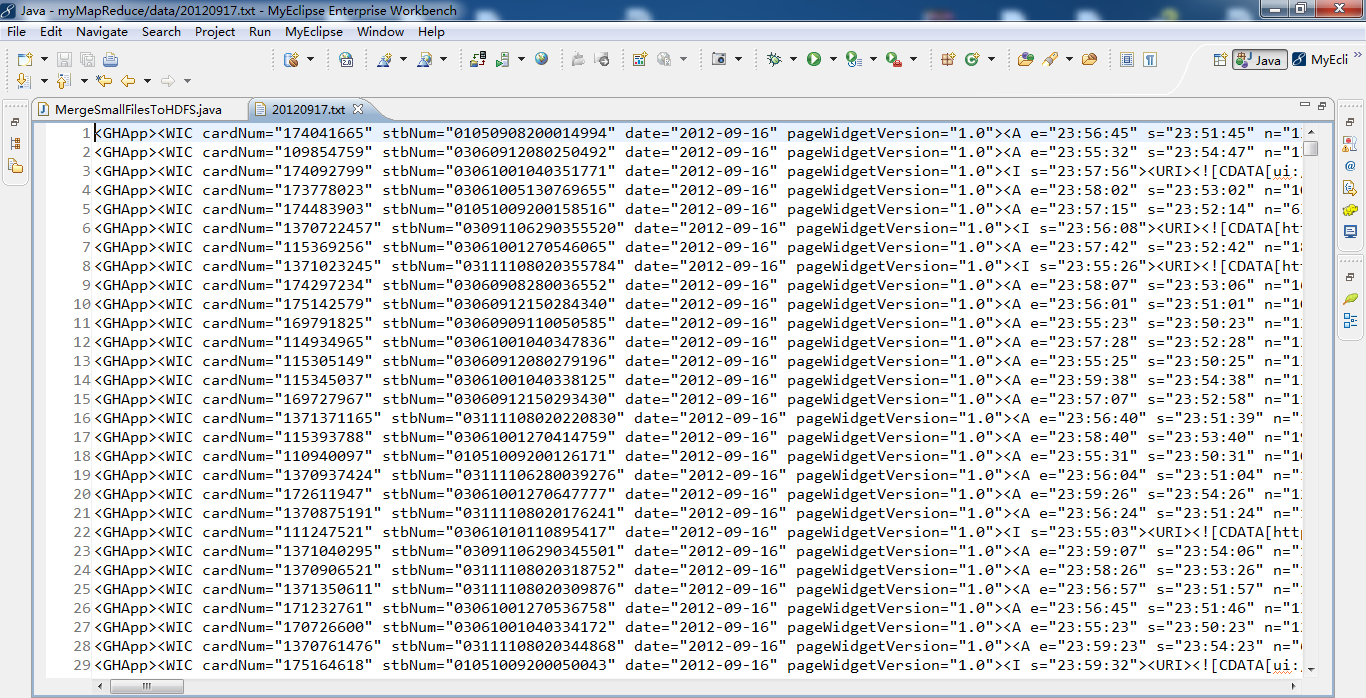

代码

package zhouls.bigdata.myMapReduce.MergeSmallFiles;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.FileUtil;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.PathFilter;

import org.apache.hadoop.io.IOUtils;

/**

* function 合并小文件至 HDFS

*

*

*/

public class MergeSmallFilesToHDFS {

private static FileSystem fs = null;

private static FileSystem local = null;

/**

* @function main

* @param args

* @throws IOException

* @throws URISyntaxException

*/

public static void main(String[] args) throws IOException,

URISyntaxException {

list();

}

/**

*

* @throws IOException

* @throws URISyntaxException

*/

public static void list() throws IOException, URISyntaxException {

// 读取hadoop文件系统的配置

Configuration conf = new Configuration();

//文件系统访问接口

URI uri = new URI("hdfs://HadoopMaster:9000");

//创建FileSystem对象aa

fs = FileSystem.get(uri, conf);

// 获得本地文件系统

local = FileSystem.getLocal(conf);

//过滤目录下的 svn 文件

FileStatus[] dirstatus = local.globStatus(new Path("./data/mergeSmallFiles/*"),new RegexExcludePathFilter("^.*svn$"));

//获取73目录下的所有文件路径

Path[] dirs = FileUtil.stat2Paths(dirstatus);

FSDataOutputStream out = null;

FSDataInputStream in = null;

for (Path dir : dirs) {

String fileName = dir.getName().replace("-", "");//文件名称

//只接受日期目录下的.txt文件a

FileStatus[] localStatus = local.globStatus(new Path(dir+"/*"),new RegexAcceptPathFilter("^.*txt$"));

// 获得日期目录下的所有文件

Path[] listedPaths = FileUtil.stat2Paths(localStatus);

//输出路径

Path block = new Path("hdfs://HadoopMaster:9000/tv/"+ fileName + ".txt");

// 打开输出流

out = fs.create(block);

for (Path p : listedPaths) {

in = local.open(p);// 打开输入流

IOUtils.copyBytes(in, out, 4096, false); // 复制数据

// 关闭输入流

in.close();

}

if (out != null) {

// 关闭输出流a

out.close();

}

}

}

/**

*

* @function 过滤 regex 格式的文件

*

*/

public static class RegexExcludePathFilter implements PathFilter {

private final String regex;

public RegexExcludePathFilter(String regex) {

this.regex = regex;

}

@Override

public boolean accept(Path path) {

// TODO Auto-generated method stub

boolean flag = path.toString().matches(regex);

return !flag;

}

}

/**

*

* @function 接受 regex 格式的文件

*

*/

public static class RegexAcceptPathFilter implements PathFilter {

private final String regex;

public RegexAcceptPathFilter(String regex) {

this.regex = regex;

}

@Override

public boolean accept(Path path) {

// TODO Auto-generated method stub

boolean flag = path.toString().matches(regex);

return flag;

}

}

}

Hadoop MapReduce编程 API入门系列之小文件合并(二十九)的更多相关文章

- Hadoop MapReduce编程 API入门系列之分区和合并(十四)

不多说,直接上代码. 代码 package zhouls.bigdata.myMapReduce.Star; import java.io.IOException; import org.apache ...

- Hadoop MapReduce编程 API入门系列之Crime数据分析(二十五)(未完)

不多说,直接上代码. 一共12列,我们只需提取有用的列:第二列(犯罪类型).第四列(一周的哪一天).第五列(具体时间)和第七列(犯罪场所). 思路分析 基于项目的需求,我们通过以下几步完成: 1.首先 ...

- Hadoop MapReduce编程 API入门系列之网页排序(二十八)

不多说,直接上代码. Map output bytes=247 Map output materialized bytes=275 Input split bytes=139 Combine inpu ...

- Hadoop MapReduce编程 API入门系列之压缩和计数器(三十)

不多说,直接上代码. Hadoop MapReduce编程 API入门系列之小文件合并(二十九) 生成的结果,作为输入源. 代码 package zhouls.bigdata.myMapReduce. ...

- Hadoop MapReduce编程 API入门系列之挖掘气象数据版本3(九)

不多说,直接上干货! 下面,是版本1. Hadoop MapReduce编程 API入门系列之挖掘气象数据版本1(一) 下面是版本2. Hadoop MapReduce编程 API入门系列之挖掘气象数 ...

- Hadoop MapReduce编程 API入门系列之挖掘气象数据版本2(十)

下面,是版本1. Hadoop MapReduce编程 API入门系列之挖掘气象数据版本1(一) 这篇博文,包括了,实际生产开发非常重要的,单元测试和调试代码.这里不多赘述,直接送上代码. MRUni ...

- Hadoop MapReduce编程 API入门系列之join(二十六)(未完)

不多说,直接上代码. 天气记录数据库 Station ID Timestamp Temperature 气象站数据库 Station ID Station Name 气象站和天气记录合并之后的示意图如 ...

- Hadoop MapReduce编程 API入门系列之MapReduce多种输入格式(十七)

不多说,直接上代码. 代码 package zhouls.bigdata.myMapReduce.ScoreCount; import java.io.DataInput; import java.i ...

- Hadoop MapReduce编程 API入门系列之自定义多种输入格式数据类型和排序多种输出格式(十一)

推荐 MapReduce分析明星微博数据 http://git.oschina.net/ljc520313/codeexample/tree/master/bigdata/hadoop/mapredu ...

随机推荐

- HDU 5234 DP背包

题意:给一个n*m的矩阵,每个点是一个蛋糕的的重量,然后小明只能向右,向下走,求在不超过K千克的情况下,小明最终能吃得最大重量的蛋糕. 思路:类似背包DP: 状态转移方程:dp[i][j][k]--- ...

- Sublime Text 配置

Sublime Text 配置 1.键盘映射 映射成emacs的键盘方式: Preferences --> Key Bounding - user:然后复制如下配置信息(注意取消前缀“...-- ...

- 网络数据包收发流程(三):e1000网卡和DMA

一.硬件布局每个网卡(MAC)都有自己的专用DMA Engine,如上图的 TSEC 和 e1000 网卡intel82546.上图中的红色线就是以太网数据流,DMA与DDR打交道需要其他模块的协助, ...

- 开发问题(C#)

1. 重新引入dll文件之后,显示黄色感叹号,可能的原因:dll文件受损或者dll版本与工程Framework版本不一致. 2. 错误 232 无法将文件“..\SES.Common\bin\Debu ...

- 关于 MAXScript 中文路径返回上级目录(精简版)

之前写过一个 关于 MAXScript 中文路径返回上级目录 的博文 今天无意中发现了一个更简单的方法 代码如下: fn newfile filepath = ( nf = getfilenamepa ...

- 数迹学——Asp.Net MVC4入门指南(4):添加一个模型

一.添加模型类 二.添加MovieDBContext类,连接数据库 DbContext类继承自 System.Data.Entity; 负责在数据库中获取,存储,更新,处理实例 MovieDBCont ...

- bootstrap模态框Esc键不关闭

项目开发时很多时候会需要用到弹出框,而且很多框架都有自己的弹出框,比较现在很流行的bootstrap就有模态框(model). 很多时候这东西用起来非常方便,可以为开发省去很多自己定义的时间!最近项目 ...

- jq+jsonp+ajax解决跨域问题

Jsonp(JSON with Padding)是资料格式 json 的一种“使用模式”,可以让网页从别的网域获取资料. 关于Jsonp更详细的资料请参考http://baike.baidu.com/ ...

- 监听器和普通类获取springContext和context,从而获取springbean和application范围的对象

1.定义一个监听器[MyContextListener],此类里最主要获取springContext和context package my.request; import javax.servlet. ...

- Android OpenCV 图像识别

最近打算写一个android 平台opencv 的小程序,着手查找了一下资料.网络上的资料参差不齐,有一些都比较老旧,我参考了前面的方法找到了一个简单的搭建方法,分享给大家. 0,环境的搭建: jav ...