用keras作CNN卷积网络书本分类(书本、非书本)

本文介绍如何使用keras作图片分类(2分类与多分类,其实就一个参数的区别。。。呵呵)

先来看看解决的问题:从一堆图片中分出是不是书本,也就是最终给图片标签上:“书本“、“非书本”,简单吧。

先来看看网络模型,用到了卷积和全连接层,最后套上SOFTMAX算出各自概率,输出ONE-HOT码,主要部件就是这些,下面的nb_classes就是用来控制分类数的,本文是2分类:

from keras.models import Sequential

from keras.layers.core import Dense, Dropout, Activation, Flatten

from keras.layers.convolutional import Convolution2D, MaxPooling2D

from keras.optimizers import SGD def Net_model(nb_classes, lr=0.001,decay=1e-6,momentum=0.9):

model = Sequential()

model.add(Convolution2D(filters=10, kernel_size=(5,5),

padding='valid',

input_shape=(200, 200, 3)))

model.add(Activation('tanh'))

model.add(MaxPooling2D(pool_size=(2, 2))) model.add(Convolution2D(filters=20, kernel_size=(10,10)))

model.add(Activation('tanh'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25)) model.add(Flatten())

model.add(Dense(1000))

model.add(Activation('tanh'))

model.add(Dropout(0.5))

model.add(Dense(nb_classes))

model.add(Activation('softmax')) sgd = SGD(lr=lr, decay=decay, momentum=momentum, nesterov=True)

model.compile(loss='categorical_crossentropy', optimizer=sgd) return model

上面的input_shape=(200, 200, 3)代表图片像素大小为宽高为200,200,并且包含RGB 3通道的图片,不是灰度图片(只要1个通道)

也就是说送入此网络的图片宽高必须200*200*3;如果不是这个shape就需要resize到这个shape

下面来看看训练程序,首先肯定是要收集些照片,书本、非书本的照片,我是分别放在了0文件夹和1文件夹下了,再带个验证用途的文件夹validate:

训练程序涉及到几个地方:照片文件的读取、模型加载训练与保存、可视化训练过程中的损失函数value

照片文件的读取

import cv2

import os

import numpy as np

import keras def loadImages():

imageList=[]

labelList=[] rootdir="d:\\books\\0"

list =os.listdir(rootdir)

for item in list:

path=os.path.join(rootdir,item)

if(os.path.isfile(path)):

f=cv2.imread(path)

f=cv2.resize(f, (200, 200))#resize到网络input的shape

imageList.append(f)

labelList.append(0)#类别0 rootdir="d:\\books\\1"

list =os.listdir(rootdir)

for item in list:

path=os.path.join(rootdir,item)

if(os.path.isfile(path)):

f=cv2.imread(path)

f=cv2.resize(f, (200, 200))#resize到网络input的shape

imageList.append(f)

labelList.append(1)#类别1 return np.asarray(imageList), keras.utils.to_categorical(labelList, 2)

关于(200,200)这个shape怎么得来的,只是几月前开始玩opencv时随便写了个数值,后来想利用那些图片,就适应到这个shape了

keras.utils.to_categorical函数类似numpy.onehot、tf.one_hot这些,只是one hot的keras封装

模型加载训练与保存

nb_classes = 2

nb_epoch = 30

nb_step = 6

batch_size = 3 x,y=loadImages() from keras.preprocessing.image import ImageDataGenerator

dataGenerator=ImageDataGenerator()

dataGenerator.fit(x)

data_generator=dataGenerator.flow(x, y, batch_size, True)#generator函数,用来生成批处理数据(从loadImages中) model=NetModule.Net_model(nb_classes=nb_classes, lr=0.0001) #加载网络模型 history=model.fit_generator(data_generator, epochs=nb_epoch, steps_per_epoch=nb_step, shuffle=True)#训练网络,并且返回每次epoch的损失value model.save_weights('D:\\Documents\\Visual Studio 2017\\Projects\\ConsoleApp9\\PythonApplication1\\书本识别\\trained_model_weights.h5')#保存权重

print("DONE, model saved in path-->D:\\Documents\\Visual Studio 2017\\Projects\\ConsoleApp9\\PythonApplication1\\书本识别\\trained_model_weights.h5")

ImageDataGenerator构造函数有很多参数,主要用来提升数据质量,比如要不要标准化数字

lr=0.001这个参数要看经验,大了会导致不收敛,训练的时候经常由于这个参数的问题导致重复训练,这在没有GPU的情况下很是痛苦。。痛苦。。。痛苦。。。

model.save_weights是保存权重,但是不保存网络模型 ,对应的是model.load_weights方法

model.save是保存网络+权重,只是。。。。此例中用save_weights保存的h5文件是125M,但用save方法保存后,h5文件就增大为280M了。。。

上面2个save方法都能finetune,只是灵活度不一样。

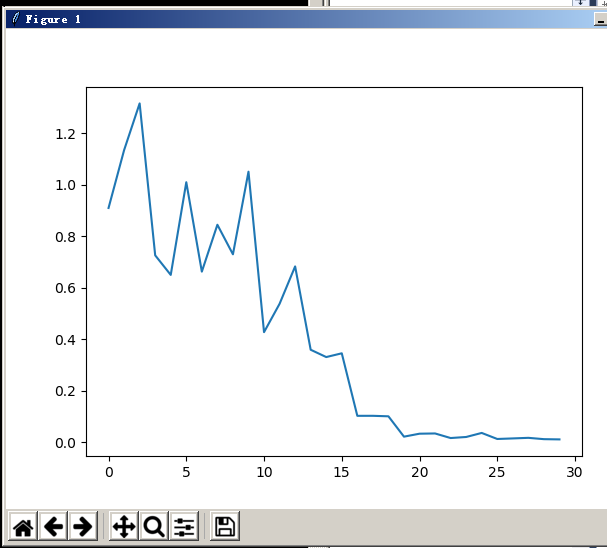

可视化训练过程中的损失函数value

import matplotlib.pyplot as plt plt.plot(history.history['loss'])

plt.show()

貌似没啥好补充的。。。

AND。。。。看看预测部分吧,这部分加载图片、加载模型,似乎都和训练部分雷同:

def loadImages():

imageList=[] rootdir="d:\\books\\validate"

list =os.listdir(rootdir)

for item in list:

path=os.path.join(rootdir,item)

if(os.path.isfile(path)):

f=cv2.imread(path)

f=cv2.resize(f, (200, 200))

imageList.append(f) return np.asarray(imageList) x=loadImages() x=np.asarray(x) model=NetModule.Net_model(nb_classes=2, lr=0.0001)

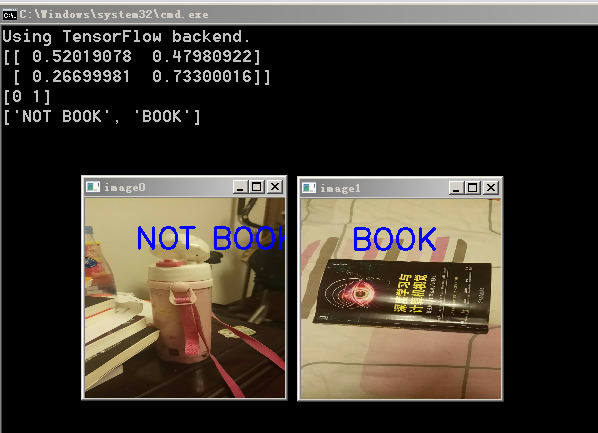

model.load_weights('D:\\Documents\\Visual Studio 2017\\Projects\\ConsoleApp9\\PythonApplication1\\书本识别\\trained_model_weights.h5') print(model.predict(x))

print(model.predict_classes(x))

y=convert2label(model.predict_classes(x))

print(y)

predict的返回其实是softmax层返回的概率数值,是<=1的float

predict_classes返回的是经过one-hot处理后的数值,此时只有0、1两种数值(最大的value会被返回称为1,其他都为0)

convert2label:

def convert2label(vector):

string_array=[]

for v in vector:

if v==1:

string_array.append('BOOK')

else:

string_array.append('NOT BOOK')

return string_array

这个函数是用来把0、1转换成文本的,小插曲:

本来这里是中文的“书本”、“非书本”,后来和女儿一起调试时发现都显示成了问号,应该是中文字符问题,就改成了英文显示,和女儿一起写代码是种乐趣啊!

本来只是显示文本,感觉太无聊了,因此加上了opencv显示图片+分类文本的代码段:

for i in range(len(x)):

cv2.putText(x[i], y[i], (50,50), cv2.FONT_HERSHEY_SIMPLEX, 1, 255, 2)

cv2.imshow('image'+str(i), x[i]) cv2.waitKey(-1)

OK, 2018年继续学习,继续科学信仰。

用keras作CNN卷积网络书本分类(书本、非书本)的更多相关文章

- 1. CNN卷积网络-初识

1. CNN卷积网络-初识 2. CNN卷积网络-前向传播算法 3. CNN卷积网络-反向更新 1. 前言 卷积神经网络是一种特殊的深层的神经网络模型,它的特殊性体现在两个方面, 它的神经元间的连接是 ...

- 3. CNN卷积网络-反向更新

1. CNN卷积网络-初识 2. CNN卷积网络-前向传播算法 3. CNN卷积网络-反向更新 1. 前言 如果读者详细的了解了DNN神经网络的反向更新,那对我们今天的学习会有很大的帮助.我们的CNN ...

- 2. CNN卷积网络-前向传播算法

1. CNN卷积网络-初识 2. CNN卷积网络-前向传播算法 3. CNN卷积网络-反向更新 1. 前言 我们已经了解了CNN的结构,CNN主要结构有输入层,一些卷积层和池化层,后面是DNN全连接层 ...

- Deeplearning 两层cnn卷积网络详解

https://blog.csdn.net/u013203733/article/details/79074452 转载地址: https://www.cnblogs.com/sunshineatno ...

- 用keras的cnn做人脸分类

keras介绍 Keras是一个简约,高度模块化的神经网络库.采用Python / Theano开发. 使用Keras如果你需要一个深度学习库: 可以很容易和快速实现原型(通过总模块化,极简主义,和可 ...

- keras搭建密集连接网络/卷积网络/循环网络

输入模式与网络架构间的对应关系: 向量数据:密集连接网络(Dense层) 图像数据:二维卷积神经网络 声音数据(比如波形):一维卷积神经网络(首选)或循环神经网络 文本数据:一维卷积神经网络(首选)或 ...

- 用Keras搭建神经网络 简单模版(三)—— CNN 卷积神经网络(手写数字图片识别)

# -*- coding: utf-8 -*- import numpy as np np.random.seed(1337) #for reproducibility再现性 from keras.d ...

- Keras(四)CNN 卷积神经网络 RNN 循环神经网络 原理及实例

CNN 卷积神经网络 卷积 池化 https://www.cnblogs.com/peng8098/p/nlp_16.html 中有介绍 以数据集MNIST构建一个卷积神经网路 from keras. ...

- 机器学习-计算机视觉和卷积网络CNN

概述 对于计算机视觉的应用现在是非常广泛的,但是它背后的原理其实非常简单,就是将每一个像素的值pixel输入到一个DNN中,然后让这个神经网络去学习这个模型,最后去应用这个模型就可以了.听起来是不是很 ...

随机推荐

- ASP.NET异常处理机制

try{ //获取并使用资源,可能出现异常}catch(DivideByZeroException de){}catch(ArithmeticException ae){}catch(Exceptio ...

- HTML5学习指导路线

HTML5是现在热门的技术,经过8年的艰苦努力,该标准规范终于制定完成,在这里为想要学习HTML5初级程序员详细划分一下学习内容和步骤,让大家清楚的知道HTML5需要学什么?能够快速掌握HTML5开发 ...

- CDH5.11..0安装

1.参考: http://www.cnblogs.com/codedevelop/p/6762555.html grant all privileges on *.* to 'root'@'hostn ...

- PHP使用api的两种方法

1.用file_get_contents()函数 $params = array('key' => '8d284859d04cfeeea6b0771f754adb49', 'location' ...

- Play-With-Docker在chrome上的插件

一键使用PWD 在chrome扩展中,找到"Play With Docker"插件,并安装在chrome浏览器中 进入hub.docker.com网站,搜索熟悉的docker镜像. ...

- Servlet,JSP 中的中文乱码问题以及解决方案

问题描述: 在Servlet,JSP 传递数据中,英文无影响,而中文有时候就会出现乱码. 解决方案: 相同的编码: 同一个项目中的每个文件应当设置和保存相同的编码方式,如: html中 <met ...

- 关于磁盘冗余阵列、热备、群集、负载均衡、云计算、F5、Nginx等的概念和基本原理

在系统部署实施过程中,客户往往会关注系统的可用性方面的指标. 对于一个具备高可用性的系统来说, 多机部署方案是必不可少的. 我们这个知识分享,就从多个不同层面来介绍多机部署方案. ---------- ...

- php使用rc4加密算法

/** * rc4加密算法,解密方法直接再一次加密就是解密 * @param [type] $data 要加密的数据 * @param [type] $pwd 加密使用的key * @retur ...

- webMagic解析淘宝cookie 提示Invalid cookie header

webMagic解析淘宝cookie 提示Invalid cookie header 在使用webMagic框架做爬虫爬取淘宝极又家页面时候一直提醒cookie设置不可用如下图 淘宝的验证特别严重,c ...

- Vue单页面骨架屏实践

github 地址: VV-UI/VV-UI 演示地址: vv-ui 文档地址:skeleton 关于骨架屏介绍 骨架屏的作用主要是在网络请求较慢时,提供基础占位,当数据加载完成,恢复数据展示.这样给 ...