IDEA 创建HDFS项目 JAVA api

1.创建quickMaven

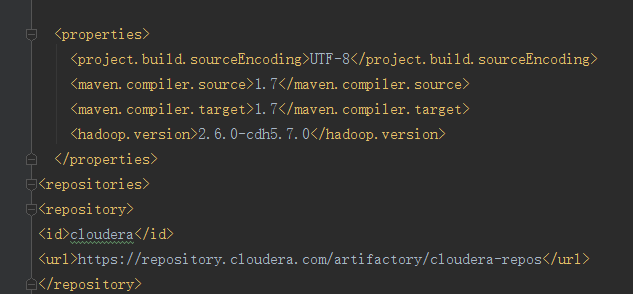

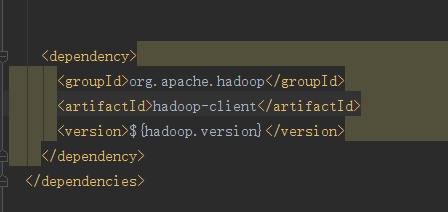

1.在properties中写hadoop 的版本号并且通过EL表达式的方式映射到dependency中

2.写一个repostory将依赖加载到本地仓库中

这是加载完成的页面

这是开发代码

package com.kevin.hadoop; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.util.Progressable;

import org.junit.After;

import org.junit.Before;

import org.junit.Test; import java.io.BufferedInputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.InputStream;

import java.net.URI; /**

* Created by Administrator on 2018/7/21 0021.

* Hadoop HDFS java API 操作

*/

public class HDFSApp {

public static final String HDFS_PATH = "hdfs://hadoop000:8020";

//文件系统

FileSystem fileSystem = null;

//配置类

Configuration configuration = null; //Before适用于类加载之前

@Test

/**

* 创建HDFS系统

*/

public void mkdir() throws Exception {

fileSystem.mkdirs(new Path("/hdfsapi/test"));

} @Test

public void create() throws Exception {

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/a.txt"));

output.write("hello hadoop".getBytes());

output.flush();

output.close();

} @Test

/**

* 查看HDFS文件上的内容

*/

public void cat() throws Exception {

FSDataInputStream in = fileSystem.open(new Path("/hdfsapi/test/a.txt"));

IOUtils.copyBytes(in, System.out, 1024);

in.close();

} @Before

public void setUp() throws Exception {

System.out.printf("HDFSapp.setup");

configuration = new Configuration();

//拿到文件系统

fileSystem = FileSystem.get(new URI(HDFS_PATH), configuration, "hadoop");

} //关闭资源用的这个

@After

public void tearDown() throws Exception {

//释放资源

configuration = null;

fileSystem = null;

System.out.printf("HDFSAPP.tearDown");

} /**

* 重命名文件

*/

@Test

public void rename() throws Exception {

Path oldPath = new Path("/hdfsapi/test/a.txt");

Path newPath = new Path("/hdfsapi/test/b.txt");

fileSystem.rename(oldPath, newPath);

} /**

* 上传一个文件

*

* @throws Exception

*/

@Test

public void copyFromLocalFile() throws Exception {

Path localPath = new Path(" //c//hello.txt");

Path hdfsPath = new Path("/hdfsapi/test");

fileSystem.copyFromLocalFile(localPath, hdfsPath);

} /**

* 上传一个大文件

*

* @throws Exception

*/

@Test

public void copyFromLocalBigFile() throws Exception {

InputStream in = new BufferedInputStream(

new FileInputStream(

new File("C:\\mmall-fe\\all.zip"))); FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/all.zip"),

new Progressable() {

public void progress() {

System.out.print("."); //带进度提醒信息

}

}); IOUtils.copyBytes(in, output, 4096);

}

/**

* 下载HDFS文件

*/

@Test

public void copyTOLocalFile() throws Exception{

Path localPath = new Path("C:\\test\\b.txt");

Path hdfsPath = new Path("/hdfsapi/test/hello.txt");

fileSystem.copyToLocalFile(false,hdfsPath,localPath,true);

}

@Test

public void listFiles() throws Exception {

FileStatus[] fileStatuses = fileSystem.listStatus(new Path("/hdfsapi/test")); for (FileStatus fileStatus : fileStatuses) {

String isDir = fileStatus.isDirectory() ? "文件夹" : "文件";

//副本

short replication = fileStatus.getReplication();

//大小

long len = fileStatus.getLen();

//路径

String path = fileStatus.getPath().toString(); System.out.println(isDir + "\t" + replication + "\t" + len + "\t" + path);

}

}

@Test

public void delete() throws Exception{

fileSystem.delete(new Path("hdfsapi/test/"),true);

}

} 注意在查询文件的副本系数时如果是通过hadoop sell put上去的文件副本系数在伪分布式中是1,如果说是通过java api put上去的则副本系数是1,因为我们并没有在本地设置自己的副本系数,所以hadoop采用自己的副本系数

IDEA 创建HDFS项目 JAVA api的更多相关文章

- HDFS中JAVA API的使用

HDFS中JAVA API的使用 HDFS是一个分布式文件系统,既然是文件系统,就可以对其文件进行操作,比如说新建文件.删除文件.读取文件内容等操作.下面记录一下使用JAVA API对HDFS中的 ...

- HDFS的Java API

HDFS Java API 可以用于任何Java程序与HDFS交互,该API使我们能够从其他Java程序中利用到存储在HDFS中的数据,也能够使用其他非Hadoop的计算框架处理该数据 为了以编程方式 ...

- Hadoop之HDFS(三)HDFS的JAVA API操作

HDFS的JAVA API操作 HDFS 在生产应用中主要是客户端的开发,其核心步骤是从 HDFS 提供的 api中构造一个 HDFS 的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS ...

- Hadoop(五):HDFS的JAVA API基本操作

HDFS的JAVA API操作 HDFS在生产应用中主要是客户端的开发,其核心步骤是从HDFS提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件. 主 ...

- HDFS的java api操作

hdfs在生产应用中主要是针对客户端的开发,从hdfs提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件. 搭建开发环境 方式一(windows环境下 ...

- [转]HDFS中JAVA API的使用

HDFS是一个分布式文件系统,既然是文件系统,就可以对其文件进行操作,比如说新建文件.删除文件.读取文件内容等操作.下面记录一下使用JAVA API对HDFS中的文件进行操作的过程. 对分HDFS中的 ...

- 熟练掌握HDFS的Java API接口访问

HDFS设计的主要目的是对海量数据进行存储,也就是说在其上能够存储很大量文件(可以存储TB级的文件).HDFS将这些文件分割之后,存储在不同的DataNode上, HDFS 提供了两种访问接口:She ...

- 掌握HDFS的Java API接口访问

HDFS设计的主要目的是对海量数据进行存储,也就是说在其上能够存储很大量文件(可以存储TB级的文件).HDFS将这些文件分割之后,存储在不同的DataNode上, HDFS 提供了两种访问接口:She ...

- Sample: Write And Read data from HDFS with java API

HDFS: hadoop distributed file system 它抽象了整个集群的存储资源,可以存放大文件. 文件采用分块存储复制的设计.块的默认大小是64M. 流式数据访问,一次写入(现支 ...

随机推荐

- 在Windows系统上一批可以下载但是需要经过编译再安装的第三方的直接编译后的版本(UCI页面)

在Windows系统上一批可以下载但是需要经过编译再安装的第三方的直接编译后的版本(UCI页面) (https://www.lfd.uci.edu/~gohlke/pythonlibs/) win10 ...

- docker 2 容器数据卷

docker 启动tomcat docker run -it -p 8888:8080 tomcat 提交一个容器使之成为一个镜像 docker commit -a=“作者” -m=“提交信息” 模板 ...

- jsfl 将库中声音放置到时间轴上

setBrokenFrames("cz1.mp3",2); /**/ /*<--------------将库中声音放置到时间轴上------------->*/ /** ...

- ConcurrentModificationException原因及排除

如何产生,一边遍历一边修改元素,产生iter后再修改原结构,如下,无论是for中或iter都会产生ConcurrentModificationException import java.util.Ar ...

- 函数mmap()的使用

函数mmap是linux的一个系统函数.如下: 函数原型:void *mmap(void *addr, size_t length, int prot, int flags,int fd, off_t ...

- linux 自定义模块来缓存skb的意义

linux中,管理网卡收发报文的结构是sk_buff,这个结构比freebsd中的m_buf复杂的多,这个也是为什么现在用户态协议栈大多采用bsd为基础来实现的一个原因. struct sk_buff ...

- ReactiveX 学习笔记(5)合并数据流

Combining Observables 本文的主题为合并 Observable 的操作符. 这里的 Observable 实质上是可观察的数据流. RxJava操作符(四)Combining An ...

- JAVAWEB 一一 框架整合(SSH,Spring+Struts2+Hibernate IOC/DI AOP声明式事务处理 定时任务)

package org.springframework.orm.hibernate3; import java.io.Serializable; import java.util.List; impo ...

- mysql 5.7.3.0-m13安装教程

安装mysql百度经验地址:(默认安装,除了选择不更新和选择保存路径,其它基本是下一步下一步) http://jingyan.baidu.com/article/7e440953d6f0702fc1e ...

- java axis2 webservice

http://clq9761.iteye.com/blog/976029/ 这篇文章写的是最全的,也是最好的.无须下一步下一步操作来操作去,写类直接调试,非常好!