java爬虫学习

java尝试爬取一些简单的数据,比python复杂点

示例:爬取网站中的所有古风网名:http://www.oicq88.com/gufeng/,并储存入数据库(mysql)

jdk版本:jdk1.8

编辑器:idea

项目构建:maven

所需jar包:http://jsoup.org/packages/jsoup-1.8.1.jar

或maven依赖如下:

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.7.3</version>

</dependency>

具体代码如下:

package com.ssm.web.timed; import java.io.IOException;

import java.util.ArrayList;

import java.util.List; import com.ssm.commons.JsonResp;

import com.ssm.utils.ExportExcel;

import org.apache.log4j.Logger;

import org.jsoup.*;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController; import javax.servlet.http.HttpServletResponse; @RequestMapping

@RestController

public class TestCrawlerTime {

private Logger log = Logger.getLogger(this.getClass()); //根据url从网络获取网页文本

public static Document getHtmlTextByUrl(String url, String page) {

Document doc = null;

try {

//doc = Jsoup.connect(url).timeout(5000000).get();

int i = (int) (Math.random() * 1000); //做一个随机延时,防止网站屏蔽

while (i != 0) {

i--;

}

doc = Jsoup.connect(url + page).data("query", "Java")

.userAgent("Mozilla").cookie("auth", "token")

.timeout(300000).get();

} catch (IOException e) {

/*try {

doc = Jsoup.connect(url).timeout(5000000).get();

} catch (IOException e1) {

e1.printStackTrace();

}*/

System.out.println("error: 第一次获取出错");

}

return doc;

} //递归查找所有的名字

public static List getAllNames(List<String> names, String url, String page){

Document doc = getHtmlTextByUrl(url, page);

Elements nameTags = doc.select("div[class=listfix] li p"); //名字标签

for (Element name : nameTags){

names.add(name.text());

}

Elements aTags = doc.select("div[class=page] a[class=next]"); //页数跳转标签

for (Element aTag : aTags){

if ("下一页".equals(aTag.text())){ //是下一页则继续爬取

String newUrl = aTag.attr("href");

getAllNames(names, url, newUrl);

}

}

return names;

} /**

* @Description: 导出爬取到的所有网名

* @Param:

* @return:

* @Author: mufeng

* @Date: 2018/12/11

*/

@RequestMapping(value = "/exportNames")

public JsonResp export(HttpServletResponse response){

log.info("导出爬取到的所有网名");

String target = "http://www.oicq88.com/";

String page = "/gufeng/1.htm";

List names = new ArrayList();

getAllNames(names, target, page);

System.out.println(names.size());

List<Object[]> lists = new ArrayList<>();

Integer i = 1;

for (Object name : names){

lists.add(new Object[]{i, name});

i ++;

}

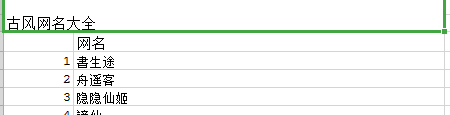

String[] rowName = new String[]{ "", "网名"};

ExportExcel exportExcel = new ExportExcel("古风网名大全", rowName, lists);

try {

exportExcel.export(response);

} catch (Exception e) {

e.printStackTrace();

}

return JsonResp.ok();

} public static void main(String[] args) {

String target = "http://www.oicq88.com/";

String page = "/gufeng/1.htm";

List names = new ArrayList();

getAllNames(names, target, page);

System.out.println(names.size());

System.out.println(names.get(0));

System.out.println(names.get(names.size()-1));

} }

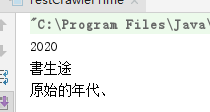

运行结果如下:

参考教程:https://www.cnblogs.com/Jims2016/p/5877300.html

https://www.cnblogs.com/qdhxhz/p/9338834.html

https://www.cnblogs.com/sanmubird/p/7857474.html

java爬虫学习的更多相关文章

- Java 爬虫学习

Java爬虫领域最强大的框架是JSoup:可直接解析具体的URL地址(即解析对应的HTML),提供了一套强大的API,包括可以通过DOM.CSS选择器,即类似jQuery方式来取出和操作数据.主要功能 ...

- 半途而废的Java爬虫学习经历

最近在面试,发现Java爬虫对于小数据量数据的爬取的应用还是比较广,抽空周末学习一手,留下学习笔记 Java网络爬虫 简单介绍 爬虫我相信大家都应该知道什么,有什么用,主要的用途就是通过程序自动的去获 ...

- Java爬虫学习(3)之用对象保存新浪微博博文

package com.mieba; import us.codecraft.webmagic.Page; import us.codecraft.webmagic.Site; import us.c ...

- Java爬虫学习(1)之爬取新浪微博博文

本次学习采用了webmagic框架,完成的是一个简单的小demo package com.mieba.spiader; import us.codecraft.webmagic.Page; impor ...

- Java爬虫学习(2)之用对象保存文件demo(1)

package com.mieba.spider; import java.util.ArrayList; import java.util.List; import java.util.Vector ...

- java爬虫案例学习

最近几天很无聊,学习了一下java的爬虫,写一些自己在做这个案例的过程中遇到的问题和一些体会1.学习目标 练习爬取京东的数据,图片+价格+标题等等 2.学习过程 1·开发工具 ...

- (java)Jsoup爬虫学习--获取智联招聘(老网站)的全国java职位信息,爬取10页

Jsoup爬虫学习--获取智联招聘(老网站)的全国java职位信息,爬取10页,输出 职位名称*****公司名称*****职位月薪*****工作地点*****发布日期 import java.io.I ...

- (java)Jsoup爬虫学习--获取网页所有的图片,链接和其他信息,并检查url和文本信息

Jsoup爬虫学习--获取网页所有的图片,链接和其他信息,并检查url和文本信息 此例将页面图片和url全部输出,重点不太明确,可根据自己的需要输出和截取: import org.jsoup.Jsou ...

- 学习Java爬虫文档的学习顺序整理

1.认识正则表达式(Java语言基础) https://www.toutiao.com/i6796233686455943693/ 2.正则表达式学习之简单手机号和邮箱练习 https://www.t ...

随机推荐

- Python10/23--继承/派生

(继承)1. 什么是继承? 在程序中继承是一种新建子类的方式,新创建的类称之为子类\派生类,被继承的类称之为父类\基类\超类 继承描述的是一种遗传关系,子类可以重用父类的属性 2. 为何用继承? 减少 ...

- oracle undo表空间

查询undo表空间状态 "Bytes(M)" FROM dba_undo_extents GROUP BY tablespace_name, status; Undo表空间的状态( ...

- Tomcat架构解析(六)-----BIO、NIO、NIO2、APR

对于应用服务器来说,性能是非常重要的,基本可以说决定着这款应用服务器的未来.通常从软件角度来说,应用服务器性能包括如下几个方面: 1.请求处理的并发程度,当前主流服务器均采用异步的方式处理客户端的请求 ...

- (6)How language shapes the way we think

https://www.ted.com/talks/lera_boroditsky_how_language_shapes_the_way_we_think/transcript 00:12So, I ...

- Codeforces Round #544 (Div. 3) dp + 双指针

https://codeforces.com/contest/1133/problem/E 题意 给你n个数(n<=5000),你需要对其挑选并进行分组,总组数不能超过k(k<=5000) ...

- INtellJ IDEA 2017 创建Annotation注解类

1.建立一个文件夹 java ------->new ---->Package--->输入名字 2.New ---->java class --->如图修改红圈位置的下拉 ...

- PI3HDX1204B

PI3HDX1204B用于HDMI2.0 6Gpbs的中继器,它有可编程的高均衡,输出摆幅和去加重控制模式.当传输为6Gpbs时,最大的EQ是22dB. PI3HDX1240B的EQ,SW和去加重可以 ...

- http基本概念

- codeforces820B Mister B and Angle in Polygon 2017-06-28 09:42 123人阅读 评论(0) 收藏

B. Mister B and Angle in Polygon time limit per test 2 seconds memory limit per test 256 megabytes i ...

- Stringbuffer与substring

1. Stringbuffer 有append()方法 Stringbuffer 其实是动态字符串数组 append()是往动态字符串数组添加,跟“xxxx”+“yyyy”相当那个‘+’号 跟Stri ...