Docker部署ELK

这里不采用逐个docker镜像的方式,而是直接使用elk三者聚合在一起的镜像。

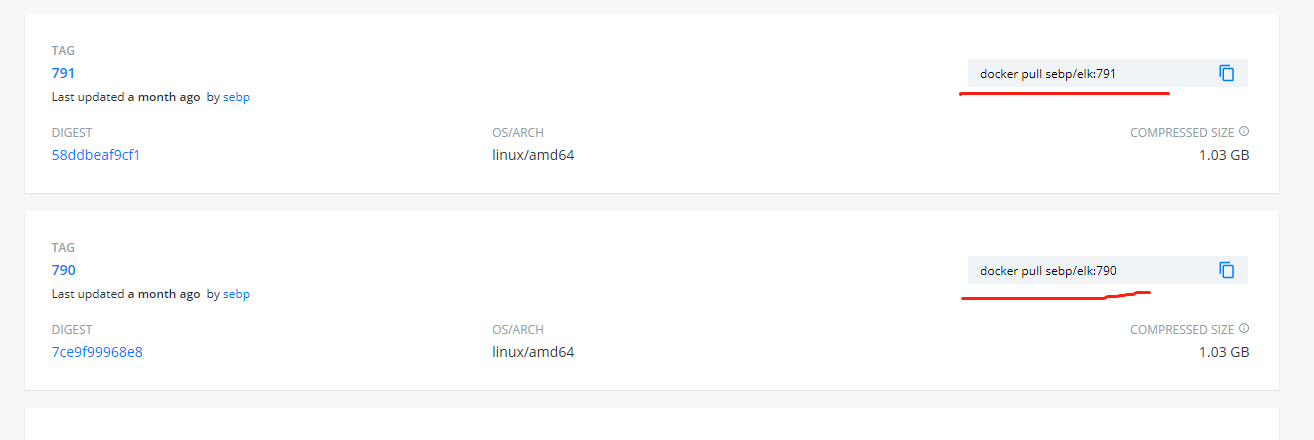

镜像地址:https://hub.docker.com/r/sebp/elk

前提操作:

$ vim /etc/sysctl.conf

vm.max_map_count = 655360

$ sysctl -p

# 拉取镜像

docker pull sebp/elk:792

# 创建挂载目录,用来保存es存储的nodes数据

mkdir -p /opt/elk

# 运行容器

docker run -d -p 5601:5601 -p 9200:9200 -p 5044:5044 -v /opt/elk:/var/lib/elasticsearch -it --name elk sebp/elk:792

# 查看容器

# docker ps root@Test-Linux

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

8b009ec6168d sebp/elk:792 "/usr/local/bin/star…" About a minute ago Up About a minute 0.0.0.0:5044->5044/tcp, 0.0.0.0:5601->5601/tcp, 9300/tcp, 0.0.0.0:9200->9200/tcp, 9600/tcp elk

使用浏览器访问:http://宿主机ip:9200,http://宿主机ip:5601

具体使用:

# 登录进容器中

docker exec -it elk /bin/bash

# 找到elk各组件安装路径

root@8b009ec6168d:~# cd /opt/

root@8b009ec6168d:/opt# ls

elasticsearch kibana logstash

# kibana设置中文界面

root@8b009ec6168d:/# ls /opt/kibana/x-pack/plugins/translations/translations/zh-CN.json

root@8b009ec6168d:/# vim /opt/kibana/config/kibana.yml # 修改或新增配置文件

i18n.locale: "zh-CN"

# 在容器内重启kibana

root@8b009ec6168d:/# service kibana status

* kibana is running

root@8b009ec6168d:/# service kibana restart

* Stopping Kibana5 [ OK ]

* Starting Kibana5

# 参看上一步,其他组件的管理操作

root@8b009ec6168d:/# service elasticsearch status

* elasticsearch is running

root@8b009ec6168d:/# service logstash status

logstash is running

Dockerfile文件

地址:https://hub.docker.com/r/sebp/elk/dockerfile

# Dockerfile for ELK stack

# Elasticsearch, Logstash, Kibana OSS 7.9.2

# Build with:

# docker build -t <repo-user>/elk .

# Run with:

# docker run -p 5601:5601 -p 9200:9200 -p 5044:5044 -it --name elk <repo-user>/elk

# replace with master-arm64 for ARM64

ARG IMAGE=18.04-1.0.0

FROM phusion/baseimage:${IMAGE}

MAINTAINER Sebastien Pujadas http://pujadas.net

ENV \

REFRESHED_AT=2020-06-20

###############################################################################

# INSTALLATION

###############################################################################

### install prerequisites (cURL, gosu, tzdata, JDK for Logstash)

RUN set -x \

&& apt update -qq \

&& apt install -qqy --no-install-recommends ca-certificates curl gosu tzdata openjdk-11-jdk-headless \

&& apt clean \

&& rm -rf /var/lib/apt/lists/* \

&& gosu nobody true \

&& set +x

### set current package version

ARG ELK_VERSION=oss-7.9.2

# replace with aarch64 for ARM64 systems

ARG ARCH=x86_64

### install Elasticsearch

# predefine env vars, as you can't define an env var that references another one in the same block

ENV \

ES_VERSION=${ELK_VERSION} \

ES_HOME=/opt/elasticsearch

ENV \

ES_PACKAGE=elasticsearch-${ES_VERSION}-linux-${ARCH}.tar.gz \

ES_GID=991 \

ES_UID=991 \

ES_PATH_CONF=/etc/elasticsearch \

ES_PATH_BACKUP=/var/backups \

KIBANA_VERSION=${ELK_VERSION}

RUN DEBIAN_FRONTEND=noninteractive \

&& mkdir ${ES_HOME} \

&& curl -O https://artifacts.elastic.co/downloads/elasticsearch/${ES_PACKAGE} \

&& tar xzf ${ES_PACKAGE} -C ${ES_HOME} --strip-components=1 \

&& rm -f ${ES_PACKAGE} \

&& groupadd -r elasticsearch -g ${ES_GID} \

&& useradd -r -s /usr/sbin/nologin -M -c "Elasticsearch service user" -u ${ES_UID} -g elasticsearch elasticsearch \

&& mkdir -p /var/log/elasticsearch ${ES_PATH_CONF} ${ES_PATH_CONF}/scripts /var/lib/elasticsearch ${ES_PATH_BACKUP} \

&& chown -R elasticsearch:elasticsearch ${ES_HOME} /var/log/elasticsearch /var/lib/elasticsearch ${ES_PATH_CONF} ${ES_PATH_BACKUP}

### install Logstash

ENV \

LOGSTASH_VERSION=${ELK_VERSION} \

LOGSTASH_HOME=/opt/logstash

ENV \

LOGSTASH_PACKAGE=logstash-${LOGSTASH_VERSION}.tar.gz \

LOGSTASH_GID=992 \

LOGSTASH_UID=992 \

LOGSTASH_PATH_CONF=/etc/logstash \

LOGSTASH_PATH_SETTINGS=${LOGSTASH_HOME}/config

RUN mkdir ${LOGSTASH_HOME} \

&& curl -O https://artifacts.elastic.co/downloads/logstash/${LOGSTASH_PACKAGE} \

&& tar xzf ${LOGSTASH_PACKAGE} -C ${LOGSTASH_HOME} --strip-components=1 \

&& rm -f ${LOGSTASH_PACKAGE} \

&& groupadd -r logstash -g ${LOGSTASH_GID} \

&& useradd -r -s /usr/sbin/nologin -d ${LOGSTASH_HOME} -c "Logstash service user" -u ${LOGSTASH_UID} -g logstash logstash \

&& mkdir -p /var/log/logstash ${LOGSTASH_PATH_CONF}/conf.d \

&& chown -R logstash:logstash ${LOGSTASH_HOME} /var/log/logstash ${LOGSTASH_PATH_CONF}

### install Kibana

ENV \

KIBANA_HOME=/opt/kibana \

KIBANA_PACKAGE=kibana-${KIBANA_VERSION}-linux-${ARCH}.tar.gz \

KIBANA_GID=993 \

KIBANA_UID=993

RUN mkdir ${KIBANA_HOME} \

&& curl -O https://artifacts.elastic.co/downloads/kibana/${KIBANA_PACKAGE} \

&& tar xzf ${KIBANA_PACKAGE} -C ${KIBANA_HOME} --strip-components=1 \

&& rm -f ${KIBANA_PACKAGE} \

&& groupadd -r kibana -g ${KIBANA_GID} \

&& useradd -r -s /usr/sbin/nologin -d ${KIBANA_HOME} -c "Kibana service user" -u ${KIBANA_UID} -g kibana kibana \

&& mkdir -p /var/log/kibana \

&& chown -R kibana:kibana ${KIBANA_HOME} /var/log/kibana

###############################################################################

# START-UP SCRIPTS

###############################################################################

### Elasticsearch

ADD ./elasticsearch-init /etc/init.d/elasticsearch

RUN sed -i -e 's#^ES_HOME=$#ES_HOME='$ES_HOME'#' /etc/init.d/elasticsearch \

&& chmod +x /etc/init.d/elasticsearch

### Logstash

ADD ./logstash-init /etc/init.d/logstash

RUN sed -i -e 's#^LS_HOME=$#LS_HOME='$LOGSTASH_HOME'#' /etc/init.d/logstash \

&& chmod +x /etc/init.d/logstash

### Kibana

ADD ./kibana-init /etc/init.d/kibana

RUN sed -i -e 's#^KIBANA_HOME=$#KIBANA_HOME='$KIBANA_HOME'#' /etc/init.d/kibana \

&& chmod +x /etc/init.d/kibana

###############################################################################

# CONFIGURATION

###############################################################################

### configure Elasticsearch

ADD ./elasticsearch.yml ${ES_PATH_CONF}/elasticsearch.yml

ADD ./elasticsearch-default /etc/default/elasticsearch

RUN cp ${ES_HOME}/config/log4j2.properties ${ES_HOME}/config/jvm.options \

${ES_PATH_CONF} \

&& chown -R elasticsearch:elasticsearch ${ES_PATH_CONF} \

&& chmod -R +r ${ES_PATH_CONF}

### configure Logstash

# certs/keys for Beats and Lumberjack input

RUN mkdir -p /etc/pki/tls/{certs,private}

ADD ./logstash-beats.crt /etc/pki/tls/certs/logstash-beats.crt

ADD ./logstash-beats.key /etc/pki/tls/private/logstash-beats.key

# pipelines

ADD pipelines.yml ${LOGSTASH_PATH_SETTINGS}/pipelines.yml

# filters

ADD ./logstash-conf/*.conf ${LOGSTASH_PATH_CONF}/conf.d/

# patterns

ADD ./nginx.pattern ${LOGSTASH_HOME}/patterns/nginx

RUN chown -R logstash:logstash ${LOGSTASH_HOME}/patterns

# Fix permissions

RUN chmod -R +r ${LOGSTASH_PATH_CONF} ${LOGSTASH_PATH_SETTINGS} \

&& chown -R logstash:logstash ${LOGSTASH_PATH_SETTINGS}

### configure logrotate

ADD ./elasticsearch-logrotate /etc/logrotate.d/elasticsearch

ADD ./logstash-logrotate /etc/logrotate.d/logstash

ADD ./kibana-logrotate /etc/logrotate.d/kibana

RUN chmod 644 /etc/logrotate.d/elasticsearch \

&& chmod 644 /etc/logrotate.d/logstash \

&& chmod 644 /etc/logrotate.d/kibana

### configure Kibana

ADD ./kibana.yml ${KIBANA_HOME}/config/kibana.yml

###############################################################################

# START

###############################################################################

ADD ./start.sh /usr/local/bin/start.sh

RUN chmod +x /usr/local/bin/start.sh

EXPOSE 5601 9200 9300 9600 5044

VOLUME /var/lib/elasticsearch

CMD [ "/usr/local/bin/start.sh" ]

Docker部署ELK的更多相关文章

- Docker 部署 elk + filebeat

Docker 部署 elk + filebeat kibana 开源的分析与可视化平台logstash 日志收集工具 logstash-forwarder(原名lubmberjack)elastics ...

- Docker 部署ELK之Sentinl日志报警

前篇文章简单介绍了Docker 部署ELK,以及使用filebeat收集java日志.这篇我们介绍下日志报警配置,这里我们使用Sentinl插件. 1.修改kibana参数 进入elk容器,修改对应参 ...

- 利用docker部署elk交换机日志分析

今天我们来聊一下利用docker部署elk日志分析系统,这里解析一下elk是啥东西.elk分别是Elasticsearch,Logstash和Kibana的首字母缩写. Elasticsearch是一 ...

- 被一位读者赶超,手摸手 Docker 部署 ELK Stack

被一位读者赶超,容器化部署 ELK Stack 你好,我是悟空. 被奇幻"催更" 最近有个读者,他叫"老王",外号"茴香豆泡酒",找我崔更 ...

- Docker 部署ELK

1.安装docker前安装pip sudo yum -y install epel-release sudo yum install python-pip 2.安装docker #安装依赖包 yum ...

- Linux实战(20):非docker部署ELK

部署环境: Elasticsearch:7.5.2 Kibana:7.5.2 Logstash:7.5.2 filebeat:7.5.2 redis:最新版 部署方式:rpm+二进制包 使用架构 软件 ...

- Docker部署ELK之部署filebeat7.6.0(3)

1. filebeat介绍 Filebeat是用于转发和集中日志数据的轻量级传送工具.Filebeat监视您指定的日志文件或位置,收集日志事件,并将它们转发到Elasticsearch或 Logsta ...

- docker部署ELK日志处理

docker环境下部署的ELK系统,日志处理,保留最近五个小时的日志 dockerlog.sh #!/bin/bash logs=`find /var/lib/docker/containers/ - ...

- Docker部署ELK 日志归集

ELK ELK是Elasticsearch.Logstash.Kibana的缩写,使用ELK的原因是因为公司使用Spring cloud部署了多个微服务,不同的微服务有不同的日志文件,当生产上出现问题 ...

- Docker部署ELK 7.0.1集群之Logstash安装介绍

1.下载镜像 [root@vanje-dev01 ~]# docker pull logstash: 2.安装部署 2.1 创建宿主映射目录 [root@vanje-dev01 ~]# mkdir ...

随机推荐

- Winsock Client Code

以下代码来自MSDN:https://msdn.microsoft.com/en-us/library/windows/desktop/ms737591(v=vs.85).aspx #define W ...

- Solution -「Local 11145」诗意狗

0x01 前置芝士 树形结构?贪心?思维?眼睛? 好有趣... link 0x02 题目大意:给你一颗有 \(n\) 个节点的树,你需要尽可能多的删掉边,使得剩下的图中有 \(k\) 个点满足互相能走 ...

- elastsearch整合springboot

文档地址: https://www.baeldung.com/elasticsearch-java

- 对象的反序列化流_ObjectInputStream和transient关键字瞬态关键字

对象的反序列化流_ObjectInputStream package com.yang.Test.ObjectStreamStudy; import java.io.FileInputStream; ...

- Apache DolphinScheduler新一代分布式工作流任务调度平台实战-上

概述 定义 dolphinscheduler 官网地址 https://dolphinscheduler.apache.org/ dolphinscheduler GitHub地址 https://g ...

- JavaWeb--基本概念、Web服务器与Tomcat

前言 Java Web 其实就是一个技术的总和,把Web看成一个容器而已主要使用JavaEE技术来实现.在加上各种中间件. 整个javaWeb阶段的内容通过实际的案例贯穿学习, 所涉及到的技术知识点会 ...

- linux 安装Apache php mysql注意事项

由于apache的php组件 php.so是由php安装生成的,故需在Apache安装之后才安装php比较合适 libphp5.so是php5提供的,你还需要编译php5才能生成这个文件 你在PHP的 ...

- 如何有效地开发 Jmix 扩展组件

扩展组件的概念在使用 Jmix 框架开发中扮演着非常重要的角色.我们将在本文探索什么是扩展组件以及 Jmix Studio 在扩展组件开发和应用程序模块化方面能给开发者带来什么帮助. Jmix 中的扩 ...

- 2. 组复制技术架构 | 深入浅出MGR

GreatSQL社区原创内容未经授权不得随意使用,转载请联系小编并注明来源. 1. 传统主从复制技术架构 传统主从复制的方式是在master节点上执行数据更新事务,而后记录这些事务到binlog中,再 ...

- 彻底弄懂JS中的this

首先,用一句话解释this,就是:指向执行当前函数的对象. 当前执行,理解一下,也就是说this的指向在函数定义的时候是确定不了的,只有函数执行的时候才能确定.this到底指向谁?this的最终指向的 ...