spark 怎么读写 elasticsearch

参考文章:

- https://www.bmc.com/blogs/spark-elasticsearch-hadoop/

- https://blog.pythian.com/updating-elasticsearch-indexes-spark/

- https://qbox.io/blog/elasticsearch-in-apache-spark-python 这里有 RDD level 的写法,有些操作比如count, aggregation 在 DataFrame/DataSet level 不支持pushdown, 所有需要用到RDD level 的写法

Pre-requisite:

先装上 elasticsearch-hadoop 包

Step-by-Step guide

1. 先在ES创建3个document

[mshuai@node1 ~]$ curl -XPUT --header 'Content-Type: application/json' http://your_ip:your_port/school/doc/1 -d '{

"school" : "Clemson"

}'

[mshuai@node1 ~]$ curl -XPUT --header 'Content-Type: application/json' http://your_ip:your_port/school/doc/2 -d '{

"school" : "Harvard"

}'

2. Spark 里面去读,这里是pyspark 代码

reader = spark.read.format("org.elasticsearch.spark.sql").option("es.read.metadata", "true").option("es.nodes.wan.only","true").option("es.port","your_port").option("es.net.ssl","false").option("es.nodes", "your_ip")

df = reader.load("school")

df.show()

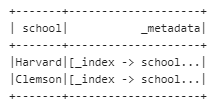

输出这个格式的信息

3. 接下来尝试update 一个记录,先得到一个要改的id

hot = df.filter(df["school"] == 'Harvard') \

.select(expr("_metadata._id as id")).withColumn('hot', lit(True))

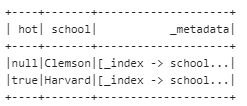

hot.show()

4. 先来加一列

esconf={}

esconf["es.mapping.id"] = "id"

esconf["es.mapping.exclude"]='id'

esconf["es.nodes"] = "your_ip"

esconf["es.port"] = "your_port"

esconf["es.write.operation"] = "update"

esconf["es.nodes.discovery"] = "false"

esconf["es.nodes.wan.only"] = "true"

hot.write.format("org.elasticsearch.spark.sql").options(**esconf).mode("append").save("school/doc")

看,成功加了 hot 列,满足条件的记录赋了对应的值

5. 又来update已经存在的信息

esconf={}

esconf["es.mapping.id"] = "id"

esconf["es.nodes"] = "your_ip"

esconf["es.port"] = "your_port"

esconf["es.update.script.inline"] = "ctx._source.school = params.school"

esconf["es.update.script.params"] = "school:<SCU>"

esconf["es.write.operation"] = "update"

esconf["es.nodes.discovery"] = "false"

esconf["es.nodes.wan.only"] = "true"

hot.write.format("org.elasticsearch.spark.sql").options(**esconf).mode("append").save("school/doc")

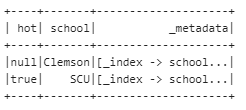

reader.load("school").show()

嗯。。。成功把Harvard改成了川大

另外,怎么upload attachment 到ES呢?可以用这个plugin Ingest Attachment Processor Plugin

END

spark 怎么读写 elasticsearch的更多相关文章

- 如何在spark中读写cassandra数据 ---- 分布式计算框架spark学习之六

由于预处理的数据都存储在cassandra里面,所以想要用spark进行数据分析的话,需要读取cassandra数据,并把分析结果也一并存回到cassandra:因此需要研究一下spark如何读写ca ...

- 【原创】大叔经验分享(26)hive通过外部表读写elasticsearch数据

hive通过外部表读写elasticsearch数据,和读写hbase数据差不多,差别是需要下载elasticsearch-hadoop-hive-6.6.2.jar,然后使用其中的EsStorage ...

- spark DataFrame 读写和保存数据

一.读写Parquet(DataFrame) Spark SQL可以支持Parquet.JSON.Hive等数据源,并且可以通过JDBC连接外部数据源.前面的介绍中,我们已经涉及到了JSON.文本格式 ...

- spark block读写流程分析

之前分析了spark任务提交以及计算的流程,本文将分析在计算过程中数据的读写过程.我们知道:spark抽象出了RDD,在物理上RDD通常由多个Partition组成,一个partition对应一个bl ...

- 6.3 使用Spark SQL读写数据库

Spark SQL可以支持Parquet.JSON.Hive等数据源,并且可以通过JDBC连接外部数据源 一.通过JDBC连接数据库 1.准备工作 ubuntu安装mysql教程 在Linux中启动M ...

- kafka spark steam 写入elasticsearch的部分问题

应用版本 elasticsearch 5.5 spark 2.2.0 hadoop 2.7 依赖包版本 docker cp /Users/cclient/.ivy2/cache/org.elastic ...

- Spark SQL读写方法

一.DataFrame:有列名的RDD 首先,我们知道SparkSQL的目的是用sql语句去操作RDD,和Hive类似.SparkSQL的核心结构是DataFrame,如果我们知道RDD里面的字段,也 ...

- Spark如何读写hive

原文引自:http://blog.csdn.net/zongzhiyuan/article/details/78076842 hive数据表建立可以在hive上建立,或者使用hiveContext.s ...

- spark mysql读写

val data2Mysql2 = (iterator: Iterator[(String, Int)]) => { var conn: Connection = null; var ps: P ...

- spark 集成elasticsearch

pyspark读写elasticsearch依赖elasticsearch-hadoop包,需要首先在这里下载,版本号可以通过自行修改url解决. """ write d ...

随机推荐

- Spring PropertySource,获取指定application.properties文件

@PropertySource注解的使用 @PropeertySource,指定加载配置文件 配置文件映射到实体类 使用@Value映射到具体的java属性 CustomConfig.java pac ...

- 免费CDN使用整理

免费CDN使用整理 最近在使用web优化的时候,需要用到cdn,遇到了一些问题,比如某些cdn在特定的条件下访问不同,整理一波免费的CDN,任君采撷 名称 国家 链接 测速 特色 UNPKG 国外 h ...

- node sass

registry=https://registry.npmmirror.com/ sass_binary_site=https://cdn.npmmirror.com/mirrors/node-sas ...

- [oeasy]python0070_动态类型_静态类型_编译_运行_匈牙利命名法

动态类型_静态类型 回忆上次内容 上次了解了 帮助文档的 生成 开头的三引号注释 可以生成 帮助文档 文档 可以写成网页 python3 本身 也有 在线的帮助手册 目前的程序 提高了 可 ...

- [oeasy]python0022_框架标题的制作_banner_结尾字符串_end

结尾字符串(end) 回忆上次内容 python3 的程序是一个 5.3M 的可执行文件 python3 里面存的是 cpu 指令 可以执行的那种 我们可以把指令对应的汇编找到 ...

- 很呆的一个问题:我的新项目又找不到mapper这个bean了

1.选springboot版本 <properties> <java.version>8</java.version> <project.build.sour ...

- Qt+OpenCascade开发笔记(二):windows开发环境搭建(二):Qt引入occ库,搭建基础工程模板Demo和发布Demo

前言 Open CASCADE是由Open Cascade SAS公司开发和支持的开源软件开发平台,旨在为特定领域快速开发程序而设计.它是一个面向对象的C++类库,提供了丰富的几何造型.数据交换和 ...

- ArcGIS for Android入门(Java):ViewPage + Fragment 底部导航栏添加地图

修改为ViewPage + Fragment 可以参考里面runoob的教程:我也是参考这个修改的:这前面的网上都有很多相应的教程,我觉得这一部分的难点主要是在Fragment里面加载地图: 在fra ...

- 4、SpringMVC之获取请求参数

4.1 环境搭建 创建名为spring_mvc_demo2的新module,过程参考3.1节 4.1.1.创建请求控制器 package org.rain.controller; import org ...

- 数字人 —— 虚拟人 —— Inworld AI用生成式AI——生成式游戏NPC

相关: https://www.ithome.com/0/756/603.htm https://baijiahao.baidu.com/s?id=1774732295233220838 https: ...