使用selenium再次爬取疫情数据(链接数据库)

爬取网页地址:

数据库连接代码:

def db_connect():

try:

db=pymysql.connect('localhost','root','zzm666','payiqing')

print('database connect success')

return db

except Exception as e:

raise e

return 0

爬取代码:

def pa_website(db):

driver = webdriver.Chrome()

driver.get('https://ncov.dxy.cn/ncovh5/view/pneumonia?from=timeline&isappinstalled=0')

time.sleep(5)#页面渲染等待,保证数据完整性

driver.find_element_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[21]').click()#点击更多数据,页面数据未加载完

divs=driver.find_elements_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[@class="fold___85nCd"]')#找到要爬取的数据上一次代码路径

cursor = db.cursor()

for div in divs:

address=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[1]').text)

confirm_issue=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[2]').text)

all_confirm=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[3]').text)

dead=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[4]').text)

cure=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[5]').text)

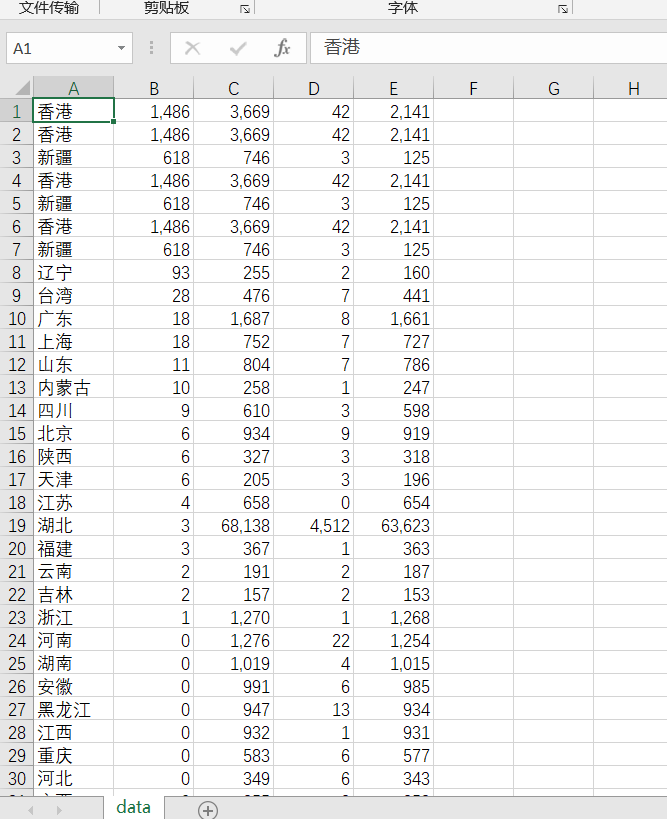

with open('data.csv','a',newline="") as csvfile:#创建data.csv文件,(推荐采用这种方式)

writer=csv.writer(csvfile,delimiter=',')

writer.writerow([address,confirm_issue,all_confirm,dead,cure])

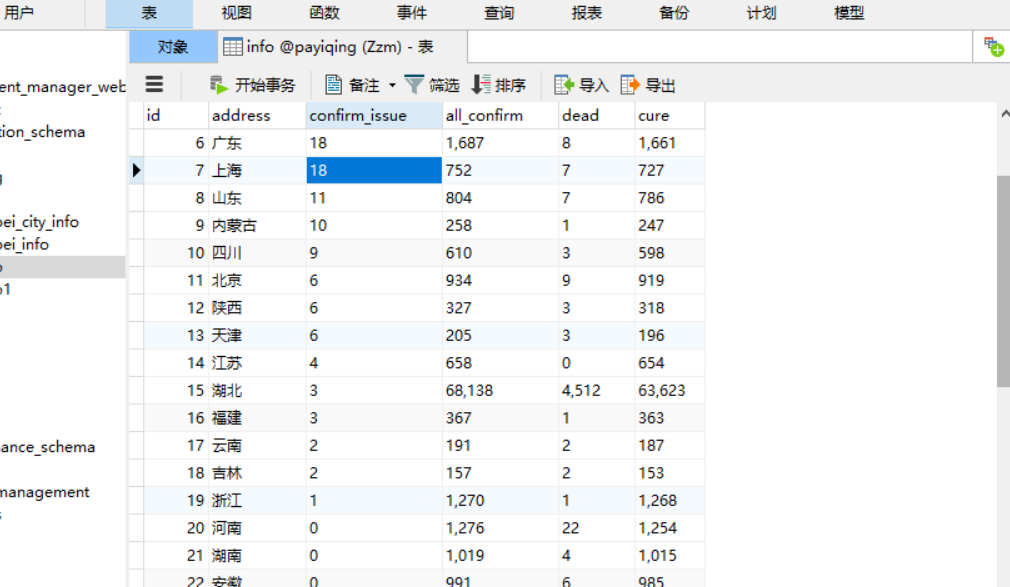

sql="insert into info(id,address,confirm_issue,all_confirm,dead,cure)values ('%d','%s','%s','%s','%s','%s')"%(0,address,confirm_issue,all_confirm,dead,cure)

try:

cursor.execute(sql)

db.commit()

print('数据插入成功')

except Exception as e:

raise e

db.close()

爬取流程:

1.获取目标网址

2.获取上一级目标路径

3.遍历路径下的目标

4.获取数据信息

5.生存csv文件展示(可以省略)

6.插入数据库

7.当数据全部插入后,关闭数据库

附(总源码+程序截图):

import csv import requests

from selenium import webdriver

import pymysql

import time

from selenium.webdriver import ActionChains #动作链,滑动验证码登录

def db_connect():

try:

db=pymysql.connect('localhost','root','zzm666','payiqing')

print('database connect success')

return db

except Exception as e:

raise e

return 0

def pa_website(db):

driver = webdriver.Chrome()

driver.get('https://ncov.dxy.cn/ncovh5/view/pneumonia?from=timeline&isappinstalled=0')

time.sleep(5)

driver.find_element_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[21]').click()

divs=driver.find_elements_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[@class="fold___85nCd"]')

cursor = db.cursor()

for div in divs:

address=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[1]').text)

confirm_issue=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[2]').text)

all_confirm=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[3]').text)

dead=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[4]').text)

cure=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[5]').text)

with open('data.csv','a',newline="") as csvfile:

writer=csv.writer(csvfile,delimiter=',')

writer.writerow([address,confirm_issue,all_confirm,dead,cure])

sql="insert into info(id,address,confirm_issue,all_confirm,dead,cure)values ('%d','%s','%s','%s','%s','%s')"%(0,address,confirm_issue,all_confirm,dead,cure)

try:

cursor.execute(sql)

db.commit()

print('数据插入成功')

except Exception as e:

raise e

db.close()

def main():

db = db_connect()

pa_website(db)

if __name__=="__main__":

main()

使用selenium再次爬取疫情数据(链接数据库)的更多相关文章

- 爬取疫情数据,以django+pyecharts实现数据可视化web网页

在家呆着也是呆着,不如做点什么消磨时间呗~ 试试用django+pyecharts实现疫情数据可视化web页面 这里要爬疫情数据 来自丁香园.搜狗及百度的疫情实时动态展示页 先看看劳动成果: 导航栏: ...

- selenium爬虫 | 爬取疫情实时动态(二)

'''@author:Billie更新说明:1-28 17:00 项目开始着手,spider方法抓取到第一条疫情数据,save_data_csv方法将疫情数据保存至csv文件1-29 13:12 目标 ...

- python爬取疫情数据详解

首先逐步分析每行代码的意思: 这是要引入的东西: from os import path import requests from bs4 import BeautifulSoup import js ...

- 利用Python爬取疫情数据并使用可视化工具展示

import requests, json from pyecharts.charts import Map, Page, Pie, Bar from pyecharts import options ...

- selenium爬虫 | 爬取疫情实时动态

import csvimport selenium.webdriverfrom selenium.webdriver.chrome.options import Optionsclass spider ...

- python爬取疫情数据存入MySQL数据库

import requests from bs4 import BeautifulSoup import json import time from pymysql import * def mes( ...

- 使用selenium进行爬取掘金前端小册的数据

Selenium 简介 百度百科介绍: Selenium [1] 是一个用于Web应用程序测试的工具.Selenium测试直接运行在浏览器中,就像真正的用户在操作一样.支持的浏览器包括IE(7, 8, ...

- 使用webdriver+urllib爬取网页数据(模拟登陆,过验证码)

urilib是python的标准库,当我们使用Python爬取网页数据时,往往用的是urllib模块,通过调用urllib模块的urlopen(url)方法返回网页对象,并使用read()方法获得ur ...

- [python爬虫] Selenium定向爬取PubMed生物医学摘要信息

本文主要是自己的在线代码笔记.在生物医学本体Ontology构建过程中,我使用Selenium定向爬取生物医学PubMed数据库的内容. PubMed是一个免费的搜寻引擎,提供生物医学方 ...

随机推荐

- scrapy(一):基础用法

Scrapy 框架 Scrapy 简介 Scray 是用python写的为了爬取网站数据,提取结构性数据的应用框架 Scrapy框架原理图 白话讲解Scrapy 运作流程 代码写好,程序开始运行... ...

- 矩阵的基本性质 之 对称矩阵,Hermite矩阵,正交矩阵,酉矩阵

1.对称矩阵 2.Hermite矩阵 3.正交矩阵 4.酉矩阵

- Linux驱动之I2C总线设备以及驱动

[ 导读] 本文通过阅读内核代码,来梳理一下I2C子系统的整体视图.在开发I2C设备驱动程序时,往往缺乏对于系统整体的认识,导致没有一个清晰的思路.所以从高层级来分析一下I2C系统的设计思路,将有助于 ...

- day8 python 列表,元组,集合,字典的操作及方法 和 深浅拷贝

2.2 list的方法 # 增 list.append() # 追加 list.insert() # 指定索引前增加 list.extend() # 迭代追加(可迭代对象,打散追加) # 删 list ...

- 一、Python系列——函数的应用之名片管理系统

card_list = [] def main_desk(): print('*'*50) print('欢迎使用[名片管理系统]V1.0') print('1.新建名片') print('2.显示全 ...

- 从连接器组件看Tomcat的线程模型——BIO模式

在高版本的Tomcat中,默认的模式都是使用NIO模式,在Tomcat 9中,BIO模式的实现Http11Protocol甚至都已经被删除了.但是了解BIO的工作机制以及其优缺点对学习其他模式有有帮助 ...

- 程序员为什么要使用Markdown

为什么要学习markdown? 一个让你难以拒绝的理由:markdown可以让你养成了记录的习惯. 我自从使用了markdown之后,就喜欢了写文档,记录工作日志,记录周会,记录季度计划,记录学习目标 ...

- 区间dp复习 之 乘积最大

题目描述 今年是国际数学联盟确定的"2000--世界数学年",又恰逢我国著名数学家华罗庚先生诞辰90周年.在华罗庚先生的家乡江苏金坛,组织了一场别开生面的数学智力竞赛的活动,你的一 ...

- centos 构建dns服务 dnsmasq

1 安装yum -y install dnsmasq开放udp tcp 53 端口2,修改配置文件 dnsmasq.conf# grep -Ev "^$|^[#;]" /etc/d ...

- vuex : 模块化改造

我们知道,vuex是vue技术栈中很重要的一部分,是一个很好用的状态管理库. 如果你的项目没有那么复杂,或者对vuex的使用没有那么重度,那么,是用不着modules功能的. 但如果你写着写着就发现你 ...