大数据入门第十一天——hive详解(三)hive函数

一、hive函数

1.内置运算符与内置函数

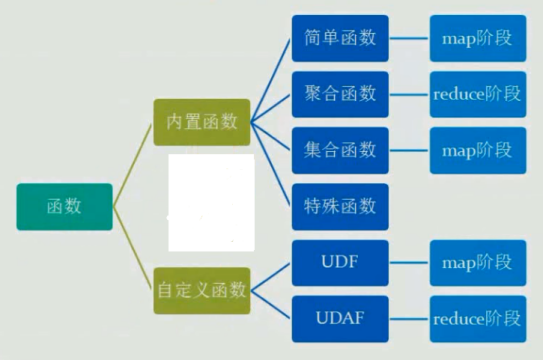

函数分类:

查看函数信息:

DESC FUNCTION concat;

常用的分析函数之rank() row_number(),参考:https://www.cnblogs.com/wujin/p/6051768.html

常用20个内置函数:

https://www.cnblogs.com/kimbo/p/6288516.html

常用函数:https://www.iteblog.com/archives/2258.html

完整参考官方手册:https://www.cnblogs.com/liupengpengg/p/7908274.html

窗口函数推荐教程:http://www.aboutyun.com/thread-22652-1-1.html

结合相关实例:https://blog.csdn.net/dingchangxiu11/article/details/83145151

开窗函数OVER用法介绍:http://blog.csdn.net/sherri_du/article/details/53312085

http://blog.csdn.net/qq_26937525/article/details/54925827

窗口函数理解与实践:http://blog.csdn.net/xiepeifeng/article/details/42676567

窗口函数与分析函数用法:http://www.cnblogs.com/skyEva/p/5730531.html

http://blog.csdn.net/sunnyyoona/article/details/56484919

PARTITON BY 与 ORDER BY语句非常重要:

窗口函数和聚合函数不同的地方在于聚合函数每个分组只产生一条记录,而窗口函数则是每条记录都会生成一条记录

SQL 窗口查询引入了三个新的概念:窗口分区、窗口帧、以及窗口函数。 PARTITION 语句会按照一个或多个指定字段,将查询结果集拆分到不同的 窗口分区 中,并可按照一定规则排序。

如果没有 PARTITION BY,则整个结果集将作为单个窗口分区;

如果没有 ORDER BY,我们则无法定义窗口帧,进而整个分区将作为单个窗口帧进行处理。

行列转换:https://www.cnblogs.com/dongxiucai/p/9784011.html

lateral view的用法参考maxcomputer常用SQL小结

2.自定义函数

分类

UDF 作用于单个数据行,产生一个数据行作为输出。(数学函数,字符串函数)

UDAF(用户定义聚集函数):接收多个输入数据行,并产生一个输出数据行。(count,max)

自定义UDF:

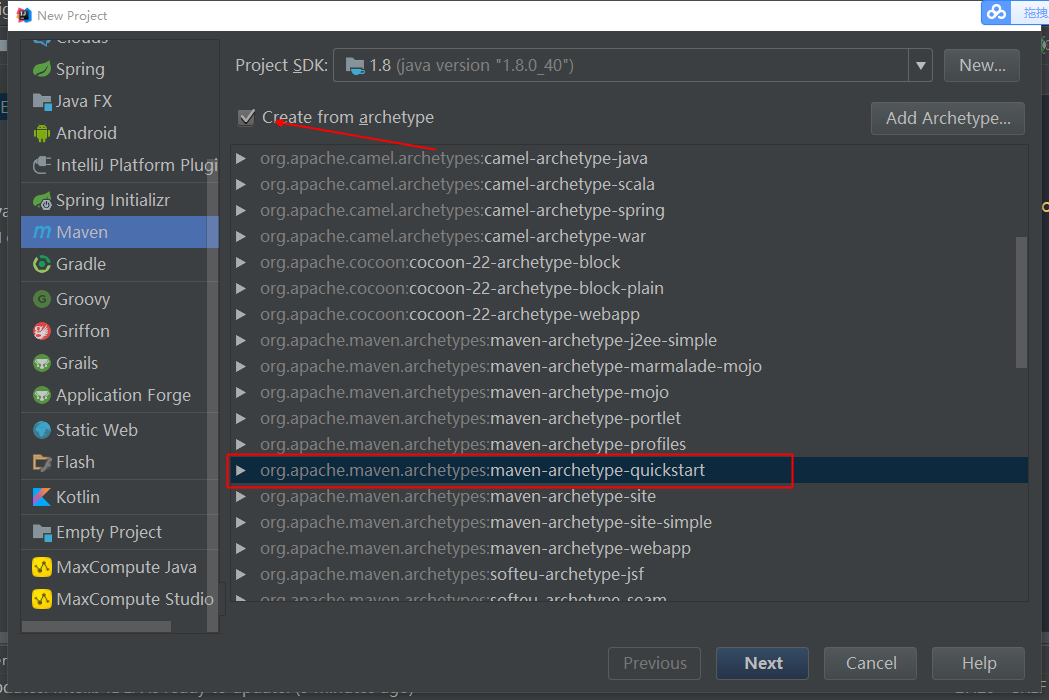

1.新建工程

这里选择IDEA中建立普通的maven工程,如果不使用maven,则导入hive安装包中Lib下除掉php、perl等的jar

2.引入依赖

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>1.2.1</version>

</dependency>

// 推荐保持和hadoop版本一致

3.定义继承于UDF的类,编写evaluate()方法(必须是Public):

public class ToLowerCaseUDF extends UDF {

public String evaluate(String src) {

if (src == null) {

return "";

}

return src.toLowerCase();

}

}

若需要添加函数说明,使得可以通过DESC查看,可以添加以下注解(_FUNC_会替换为函数名)

@Description(name = "deprecation",

value = "_FUNC_(date, price) - from the input date string(yyyyMMdd), " +

"returns the deprecation price by computing price and "

+ "the depreciation rate of the second-hand car.",

extended = "Example:\n" +

" > SELECT _FUNC_(date_string, price) FROM src;")

public class TestUDF extends UDF {

4.打成jar包

使用maven的package打包,如果不使用IDEA的打包,可以切换到项目根目录,手动命令打包:

mvn clean package

5.上传jar包

这里就使用rz上传了

6.使用UDF

临时:

不过这个临时函数, 其生命周期和hive的这个交互session保持一致, 一旦退出, 这个临时函数就消失了.

0: jdbc:hive2://localhost:10000> add JAR /home/hadoop/hiveUDF.jar;

// 在hive中上传jar到hive的classpath

create temporary function toprovince as 'com.jiangbei.ToLowerCaseUDF';

//定义一个函数与UDF对应(as后接类的全路径名),这里手误,函数名应该命令为tolowercase

0: jdbc:hive2://localhost:10000> SELECT toprovince("HELLO");

+--------+--+

| _c0 |

+--------+--+

| hello |

+--------+--+

1 row selected (0.613 seconds)

0: jdbc:hive2://localhost:10000>

hive> DROP TEMPORARY FUNCTION IF EXISTS deprecation;

//删除函数

永久:

1. 把自定义函数的jar上传到hdfs中.

hdfs dfs -put lower.jar 'hdfs:///path/to/hive_func';

2. 创建永久函数

hive> create function xxoo_lower as 'test.ql.LowerUDF' using jar 'hdfs:///path/to/hive_func/lower.jar'

3. 验证

hive> select xxoo_lower("Hello World");

hive> show functions;

4.删除

hive> drop function xxoo_lower;

//补充:处理JSON的内置函数:jason:

hive> select

get_json_object(‘{“store”:{“fruit”:\[{"weight":8,"type":"apple"},{"weight":9,"type":"pear"}], “bicycle”:{“price”:19.95,”color”:”red”}}, “email”:”amy@only_for_json_udf_test.net”, “owner”:”amy” } ‘,’$.owner’)

from dual;

3.Transform

Hive的 TRANSFORM 关键字提供了在SQL中调用自写脚本的功能

适合实现Hive中没有的功能又不想写UDF的情况

实例:

CREATE TABLE u_data_new (

movieid INT,

rating INT,

weekday INT,

userid INT)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'; add FILE weekday_mapper.py; INSERT OVERWRITE TABLE u_data_new

SELECT

TRANSFORM (movieid, rating, unixtime,userid)

USING 'python weekday_mapper.py'

AS (movieid, rating, weekday,userid)

FROM u_data;

#!/bin/python

import sys

import datetime for line in sys.stdin:

line = line.strip()

movieid, rating, unixtime,userid = line.split('\t')

weekday = datetime.datetime.fromtimestamp(float(unixtime)).isoweekday()

print '\t'.join([movieid, rating, str(weekday),userid])

参考:http://blog.csdn.net/tianjun2012/article/details/64500499

大数据入门第十一天——hive详解(三)hive函数的更多相关文章

- 大数据入门第七天——MapReduce详解(一)入门与简单示例

一.概述 1.map-reduce是什么 Hadoop MapReduce is a software framework for easily writing applications which ...

- 大数据入门第七天——MapReduce详解(二)切片源码浅析与自定义patition

一.mapTask并行度的决定机制 1.概述 一个job的map阶段并行度由客户端在提交job时决定 而客户端对map阶段并行度的规划的基本逻辑为: 将待处理数据执行逻辑切片(即按照一个特定切片大小, ...

- 大数据入门第十一天——hive详解(一)入门与安装

一.基本概念 1.什么是hive The Apache Hive ™ data warehouse software facilitates reading, writing, and managin ...

- 大数据入门第十一天——hive详解(二)基本操作与分区分桶

一.基本操作 1.DDL 官网的DDL语法教程:点击查看 建表语句 CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name [(col_name data ...

- 大数据入门第十六天——流式计算之storm详解(一)入门与集群安装

一.概述 今天起就正式进入了流式计算.这里先解释一下流式计算的概念 离线计算 离线计算:批量获取数据.批量传输数据.周期性批量计算数据.数据展示 代表技术:Sqoop批量导入数据.HDFS批量存储数据 ...

- 大数据入门第八天——MapReduce详解(三)MR的shuffer、combiner与Yarn集群分析

/mr的combiner /mr的排序 /mr的shuffle /mr与yarn /mr运行模式 /mr实现join /mr全局图 /mr的压缩 今日提纲 一.流量汇总排序的实现 1.需求 对日志数据 ...

- 大数据入门第十七天——storm上游数据源 之kafka详解(三)其他问题

一.kafka文件存储机制 1.topic存储 在Kafka文件存储中,同一个topic下有多个不同partition,每个partition为一个目录,partiton命名规则为topic名称+有序 ...

- 大数据入门第十七天——storm上游数据源 之kafka详解(一)入门与集群安装

一.概述 1.kafka是什么 根据标题可以有个概念:kafka是storm的上游数据源之一,也是一对经典的组合,就像郭德纲和于谦 根据官网:http://kafka.apache.org/intro ...

- 大数据入门第十七天——storm上游数据源 之kafka详解(二)常用命令

一.kafka常用命令 1.创建topic bin/kafka-topics. --replication-factor --zookeeper mini1: // 如果配置了PATH可以省略相关命令 ...

随机推荐

- gitlab 启用HTTPS

NGINX设置 启用HTTPS 警告 Nginx配置会告诉浏览器和客户端,只需在未来24个月通过安全连接与您的GitLab实例进行通信.通过启用HTTPS,您需要至少在24个月内为您的实例提供安全连接 ...

- 【转】ubuntu右键在当前位置打开终端

ubuntu右键在当前位置打开终端 ubuntu增加右键命令: 在终端中打开 软件中心: 搜索nautilus-open-terminal安装 命令行: sudo apt-ge ...

- [WINCE|VS2008] 用在PC上调试WINCE程序

http://www.danielmoth.com/Blog/deploy-to-my-computer.aspx 作者:The Moth 步骤: 1. 在VS2008中打到 Device Optio ...

- iOS设计模式 - 命令

iOS设计模式 - 命令 原理图 说明 命令对象封装了如何对目标执行指令的信息,因此客户端或调用者不必了解目标的任何细节,却仍可以对他执行任何已有的操作.通过把请求封装成对象,客户端可以把它参数化并置 ...

- [翻译] About Core Image

About Core Image Core Image is an image processing and analysis technology designed to provide near ...

- PHP CLI模式下echo换行

近日在执行导库程序的时候,需要在CLI模式下运行程序进行调试,如下图,这是什么鬼?不是我想要的结果 后经过查资料发现代码中执行的输出为 //错误方法实例 echo '其他-683\n'; //正确打开 ...

- Linux FFmpeg(含x264、lame插件)安装记录

What is FFmpeg? FFmpeg是一套可以用来记录.转换数字音频.视频,并能将其转化为流的开源计算机程序.它提供了录制.转换以及流化音视频的完整解决方案. What is x264? H. ...

- 一段滚动文字的js (jQuery)

function startmarqueeOneSMS() { var t; var to; var ishover = false; var waitone = 3000; var speed = ...

- SDN上机第二次作业

SDN第二次上机作业 1.安装floodlight 参考链接:http://www.sdnlab.com/19189.html 2.生成拓扑并连接控制器floodlight,利用控制器floodlig ...

- idea html热部署

IDEA SpringBoot 热部署+html修改无需make自动刷新 收藏 HeyS1 发表于 3个月前 阅读 310 收藏 2 点赞 0 评论 0 特邀IBM大咖的主题沙龙,5月20日·北京·3 ...