BBN: Bilateral-Branch Network with Cumulative Learning for Long-Tailed Visual Recognition

BBN: Bilateral-Branch Network with Cumulative Learning for Long-Tailed Visual Recognition

概

数据的长短尾效应是当前比较棘手的问题, 本文提出用分支网络来应对这一问题, 并取得了不错的结果.

主要内容

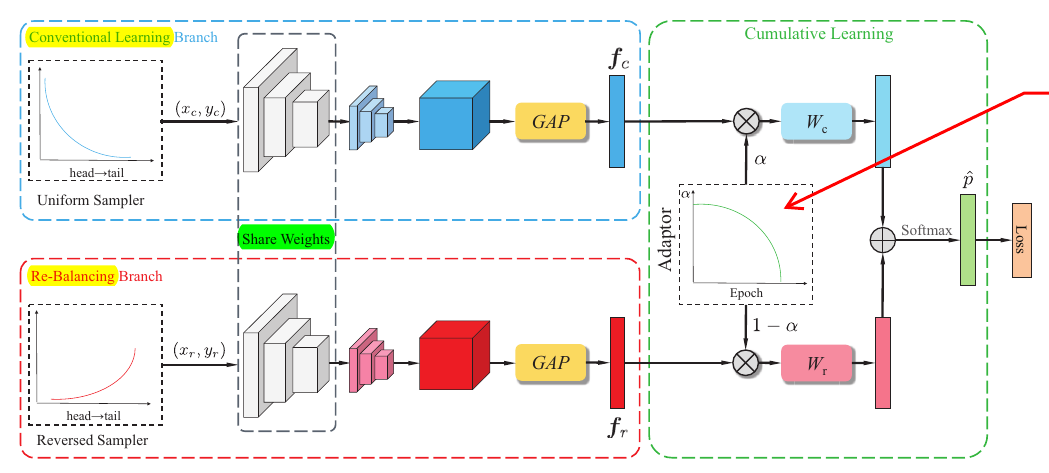

这篇文章的创新点是用两个分支来适应数据的不平衡.

如图所示, 上面的分支用于标准的训练, 而下面的分支则采用适合不平衡数据的训练方式: 即一般的训练是均匀的采样分布, 而非标准训练采用的是一个非均匀的依赖于样本分布的.

通过均匀采样得到\((x_c, y_c)\), 通过非均匀采样得到\((x_r, y_r)\), 分别喂入上下分支得到特征表示\(f_c\)和\(f_r\).

注意到, 上下两个分支是共享部分参数的, 作者实际选择的是残差网络, 设定为除了最后一个residual block外均是共享的.

根据\(f_c\)和\(f_r\)进一步得到

\]

即\([z_1, z_2,\cdots, z_C]^T\).

得到相应的概率向量

\]

最后通过下列损失函数进行训练

\]

实际上, \(\alpha\)就是一个调整标准训练和处理不平衡数据的权重.

采样方式

对于非均匀分布, 作者采取了如下方式构造采样分布, 假设每个类的样本数目为\(N_i, i=1,2,\ldots,C\). 则采样比例为

\]

其中\(w_i=\frac{1}{N_i}\).

权重\(\alpha\)

作者采用的是这样的一种方案

\]

其中\(T\)为当前的epoch, \(T_{max}\)为总的训练epochs.

在实际测试中, 作者也尝试了一些别的方案, 不过别的方案不如此方案理想.

直观上的解释就是, 训练过程会有普通的训练渐渐偏向re-balance的训练.

Inference phase

在推断过程中, 设定\(\alpha=0.5\).

代码

BBN: Bilateral-Branch Network with Cumulative Learning for Long-Tailed Visual Recognition的更多相关文章

- 《Neural Network and Deep Learning》_chapter4

<Neural Network and Deep Learning>_chapter4: A visual proof that neural nets can compute any f ...

- neural network and deep learning笔记(1)

neural network and deep learning 这本书看了陆陆续续看了好几遍了,但每次都会有不一样的收获. DL领域的paper日新月异.每天都会有非常多新的idea出来,我想.深入 ...

- 树卷积神经网络Tree-CNN: A Deep Convolutional Neural Network for Lifelong Learning

树卷积神经网络Tree-CNN: A Deep Convolutional Neural Network for Lifelong Learning 2018-04-17 08:32:39 看_这是一 ...

- 论文笔记:Learning Attribute-Specific Representations for Visual Tracking

Learning Attribute-Specific Representations for Visual Tracking AAAI-2019 Paper:http://faculty.ucmer ...

- [论文阅读] A Discriminative Feature Learning Approach for Deep Face Recognition (Center Loss)

原文: A Discriminative Feature Learning Approach for Deep Face Recognition 用于人脸识别的center loss. 1)同时学习每 ...

- Neural Network Programming - Deep Learning with PyTorch with deeplizard.

PyTorch Prerequisites - Syllabus for Neural Network Programming Series PyTorch先决条件 - 神经网络编程系列教学大纲 每个 ...

- Learning to Compare: Relation Network for Few-Shot Learning 论文笔记

主要原理: 和Siamese Neural Networks一样,将分类问题转换成两个输入的相似性问题. 和Siamese Neural Networks不同的是: Relation Network中 ...

- 【转载】论文笔记系列-Tree-CNN: A Deep Convolutional Neural Network for Lifelong Learning

一. 引出主题¶ 深度学习领域一直存在一个比较严重的问题——“灾难性遗忘”,即一旦使用新的数据集去训练已有的模型,该模型将会失去对原数据集识别的能力.为解决这一问题,本文提出了树卷积神经网络,通过先将 ...

- Neural Network Programming - Deep Learning with PyTorch - YouTube

百度云链接: 链接:https://pan.baidu.com/s/1xU-CxXGCvV6o5Sksryj3fA 提取码:gawn

随机推荐

- Output of C++ Program | Set 6

Predict the output of below C++ programs. Question 1 1 #include<iostream> 2 3 using namespace ...

- Multiple Inheritance in C++

Multiple Inheritance is a feature of C++ where a class can inherit from more than one classes. The c ...

- JS 的三种定义变量 var let const

Let 只在 let 命令所在的代码块内有效,在外就会报错 Let 是块级作用域,函数内部使用let定义后,对函数外部无影响 Let/const 不存在变量提升,使用前一定要声明后,在使用,否则会报错 ...

- 【C/C++】习题3-1 得分/算法竞赛入门经典

[题目]一个由O和X组成的串,O的得分为目前连续出现的O的个数,X的得分为0.要求统计得分. 我一开始以为要输出表达式,结果好像不需要? [代码] #include <stdio.h> # ...

- C/C++ Qt 数据库与Chart历史数据展示

在前面的博文中具体介绍了QChart组件是如何绘制各种通用的二维图形的,本章内容将继续延申一个新的知识点,通过数据库存储某一段时间节点数据的走向,当用户通过编辑框提交查询记录时,程序自动过滤出该时间节 ...

- 【Fastjson】Fastjson反序列化由浅入深

Fastjson真-简-介 fastjson是由alibaba开发并维护的一个json工具,以其特有的算法,号称最快的json库 fastjson的使用 首先先创一个简单的测试类User public ...

- 如何用CodeBlocks调试?

一.简介 这篇文章我主要会介绍CodeBlocks的调试功能,并简单讲述如何使用它. 二.前言 大家好,最近和小伙伴们讨论修改程序的时候,我突然想到,授人以鱼不如授人以渔(指调试),于是这篇文章应运而 ...

- pipeline配置前端项目

vue pipeline { agent { label 'master'} options { timestamps() disableConcurrentBuilds() buildDiscard ...

- 密码学之Hash散列

一.简介 hash(散列.杂凑)函数,是将任意长度的数据映射到有限长度的域上. 直观解释起来,就是对一串数据m进行杂糅,输出另一段固定长度的数据h,作为这段数据的特征(指纹).也就是说,无论数据块m有 ...

- yum的epel源

目录 一.centos7的源 一.centos7的源 以下一个不行,可以试试另一个 rpm -ivh https://mirrors.aliyun.com/epel/epel-release-late ...