FlinkSQL使用自定义UDTF函数行转列-IK分词器

一、背景说明

本文基于IK分词器,自定义一个UDTF(Table Functions),实现类似Hive的explode行转列的效果,以此来简明开发过程。

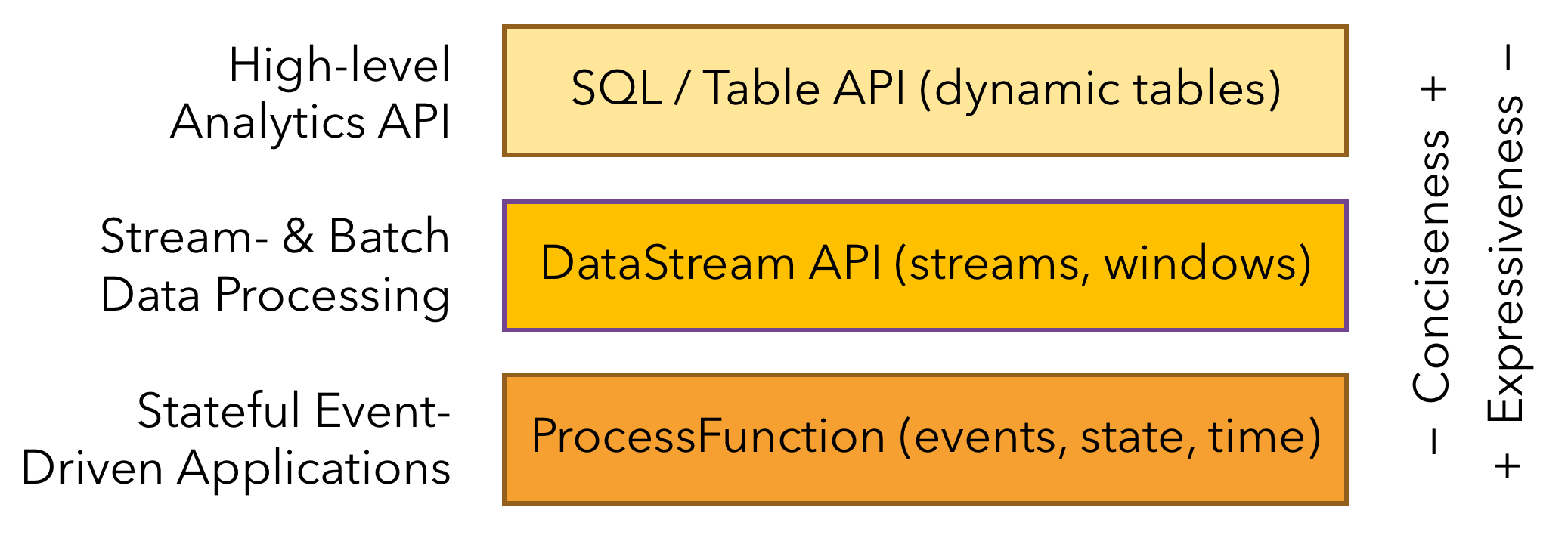

如下图Flink三层API接口中,Table API的接口位于最顶层也是最易用的一层,可以套用SQL语法进行代码编写,对于有SQL基础的能很快上手,但是不足之处在于灵活度有限,自有函数不能满足使用的时候,需要通过自定义函数实现,类似Hive的UDF/UDTF/UDAF自定义函数,在Flink也可以称之为Scalar Functions/Table Functions/Aggregate Functions。

二、效果预览

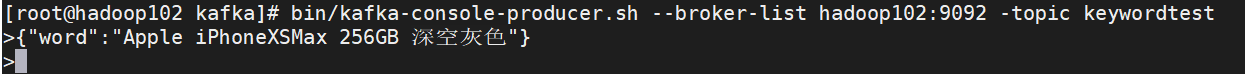

Kafka端建立生产者发送json片段:

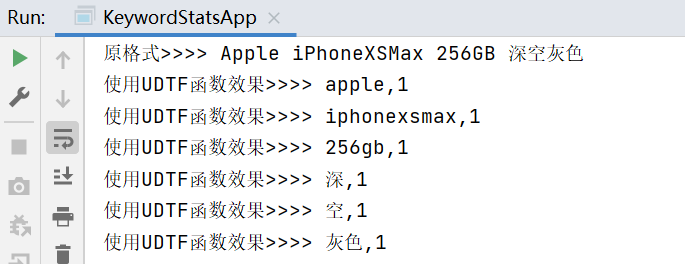

IDEA侧消费数据处理后效果:

如上所示,形成类似Hive的exploed炸裂函数实现行转列的效果,当然也可以不用IK分词器,直接按空格进行split实现逻辑是一样的。

三、代码过程

由于Flink一般在流式环境使用,故这里数据源使用Kafka,并建立动态表的形式实现,以更好的贴近实际的业务环境。

- 工具类:

package com.test.UDTF;

import org.apache.flink.table.annotation.DataTypeHint;

import org.apache.flink.table.annotation.FunctionHint;

import org.apache.flink.table.functions.TableFunction;

import org.apache.flink.types.Row;

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme;

import java.io.IOException;

import java.io.StringReader;

import java.util.ArrayList;

import java.util.List;

/**

* @author: Rango

* @create: 2021-05-04 16:50

* @description: 建立函数,继承TableFunction并建立eval方法

**/

@FunctionHint(output = @DataTypeHint("ROW<word STRING>"))

public class KeywordUDTF extends TableFunction<Row> {

//按官方文档说明,须按eval命名

public void eval(String value){

List<String> stringList = analyze(value);

for (String s : stringList) {

Row row = new Row(1);

row.setField(0,s);

collect(row);

}

}

//自定义分词方式

public List<String> analyze(String text){

//字符串转文件流

StringReader sr = new StringReader(text);

//建立分词器对象

IKSegmenter ik = new IKSegmenter(sr,true);

//ik分词后对象为Lexeme

Lexeme lex = null;

//分词后转入列表

List<String> keywordList = new ArrayList<>();

while(true){

try {

if ((lex = ik.next())!=null){

keywordList.add(lex.getLexemeText());

}else{

break;

}

} catch(IOException e) {

e.printStackTrace();

}

}return keywordList;

}

}

- 实现类

package com.test.UDTF;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.api.Table;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.types.Row;

/**

* @author: Rango

* @create: 2021-05-04 17:11

* @description:

**/

public class KeywordStatsApp {

public static void main(String[] args) throws Exception {

//建立环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

EnvironmentSettings settings = EnvironmentSettings.newInstance().inStreamingMode().build();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env, settings);

//注册函数

tableEnv.createTemporaryFunction("ik_analyze", KeywordUDTF.class);

//建立动态表

tableEnv.executeSql("CREATE TABLE wordtable (" +

"word STRING" +

") WITH ('connector' = 'kafka'," +

"'topic' = 'keywordtest'," +

"'properties.bootstrap.servers' = 'hadoop102:9092'," +

"'properties.group.id' = 'keyword_stats_app'," +

"'format' = 'json')");

//未切分效果

Table wordTable = tableEnv.sqlQuery("select word from wordtable");

//利用自定义函数对文本进行分切,切分后计为1,方便后续统计使用

Table wordTable1 = tableEnv.sqlQuery("select splitword,1 ct from wordtable," +

"LATERAL TABLE(ik_analyze(word)) as T(splitword)");

tableEnv.toAppendStream(wordTable, Row.class).print("原格式>>>");

tableEnv.toAppendStream(wordTable1, Row.class).print("使用UDTF函数效果>>>");

env.execute();

}

}

- 补充下依赖

<properties>

<java.version>1.8</java.version>

<flink.version>1.12.0</flink.version>

<scala.version>2.12</scala.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-api-java-bridge_${scala.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner-blink_${scala.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>com.janeluo</groupId>

<artifactId>ikanalyzer</artifactId>

<version>2012_u6</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_${scala.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-json</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_${scala.version}</artifactId>

<version>${flink.version}</version>

</dependency>

学习交流,有任何问题还请随时评论指出交流。

FlinkSQL使用自定义UDTF函数行转列-IK分词器的更多相关文章

- solr添加中文IK分词器,以及配置自定义词库

Solr是一个基于Lucene的Java搜索引擎服务器.Solr 提供了层面搜索.命中醒目显示并且支持多种输出格式(包括 XML/XSLT 和 JSON 格式).它易于安装和配置,而且附带了一个基于H ...

- hive自定义UDTF函数叉分函数

hive自定义UDTF函数叉分函数 1.介绍 从聚合体日志中需要拆解出来各子日志数据,然后单独插入到各日志子表中.通过表生成函数完成这一过程. 2.定义ForkLogUDTF 2.1 HiveUtil ...

- 在论坛中出现的比较难的sql问题:19(row_number函数 行转列、sql语句记流水)

原文:在论坛中出现的比较难的sql问题:19(row_number函数 行转列.sql语句记流水) 最近,在论坛中,遇到了不少比较难的sql问题,虽然自己都能解决,但发现过几天后,就记不起来了,也忘记 ...

- Spark基于自定义聚合函数实现【列转行、行转列】

一.分析 Spark提供了非常丰富的算子,可以实现大部分的逻辑处理,例如,要实现行转列,可以用hiveContext中支持的concat_ws(',', collect_set('字段'))实现.但是 ...

- 31.IK分词器配置文件讲解以及自定义词库

主要知识点: 知道IK默认的配置文件信息 自定义词库 一.ik配置文件 ik配置文件地址:es/plugins/ik/config目录 IKAnalyzer.cfg.xml:用 ...

- 30.IK分词器配置文件讲解以及自定义词库

主要知识点: 知道IK默认的配置文件信息 自定义词库 一.ik配置文件 ik配置文件地址:es/plugins/ik/config目录 IKAnalyzer.cfg.xml:用 ...

- 利用IK分词器,自定义分词规则

IK分词源码下载地址:https://code.google.com/p/ik-analyzer/downloads/list lucene源码下载地址:http://www.eu.apache.or ...

- SqlServer PIVOT函数快速实现行转列,UNPIVOT实现列转行

我们在写Sql语句的时候没经常会遇到将查询结果行转列,列转行的需求,拼接sql字符串,然后使用sp_executesql执行sql字符串是比较常规的一种做法.但是这样做实现起来非常复杂,而在SqlSe ...

- SqlServer PIVOT函数快速实现行转列,UNPIVOT实现列转行(转)

我们在写Sql语句的时候没经常会遇到将查询结果行转列,列转行的需求,拼接sql字符串,然后使用sp_executesql执行sql字符串是比较常规的一种做法.但是这样做实现起来非常复杂,而在SqlSe ...

随机推荐

- 阿里的Easyexcel读取Excel文件(最新版本)

本篇文章主要介绍一下使用阿里开源的Easyexcel工具处理读取excel文件,因为之前自己想在网上找一下这个简单的立即上手的博客,发现很多文章的教程都针对比较旧的版本的Easyexcel,没有使 ...

- 强化学习导论 课后习题参考 - Chapter 1,2

Reinforcement Learning: An Introduction (second edition) - Chapter 1,2 Chapter 1 1.1 Self-Play Suppo ...

- 使用css3和javascript开发web拾色器实例

本实例中的web拾色器功能使用css3实现页面效果,即在页面上显示的元素用css3样式来实现的.再使用js生成拾色器颜色数据,并控制各元素的鼠标事件.当事件作为反应时,获取到对应的数据并显示颜色值. ...

- nginx安装&负载均衡配置&nginx反爬虫&nginx命令

Nginx安装 wget https://nginx.org/download/nginx-1.14.0.tar.gz tar -zxvf nginx-1.14.0.tar.gz cd nginx-1 ...

- 一招教你写博客,Typora+PicGo+阿里云oss,最好用的Markdown+最好用的图床工具!

博客 写博客的好处 1.使自己变得更善于观察.一旦你养成了记博客的习惯,与此同时你也赋予了一个更好的机会给自己,让自己去更细致地观察生活.一个人的生活经历本就是价值连城的,从中学习到的知识,教训更是异 ...

- IPFS矿池集群方案详解

IPFS作为一项分布式存储技术,可以说是web3.0发展的基石.关于IPFS的产业,如存储.技术.矿机.矿池等也发展得非常迅速. 什么是单机挖矿? 单机挖矿就是一台机器就是一个节点,一台机器就完成挖矿 ...

- PTA 统计二叉树度为2的结点个数

6-4 统计二叉树度为2的结点个数 (11 分) 本题要求实现一个函数,可统计二叉树中度为2的结点个数. 函数接口定义: int NodeCount ( BiTree T); T是二叉树树根指针, ...

- java例题_01 不死神兔!

1 /*1 [程序 1 不死神兔] 2 题目:古典问题:有一对兔子,从出生后第 3 个月起每个月都生一对兔子,小兔子长到第三个月后每个月又生一对兔子,假如兔子都不死,问每个月的兔子对数为多少? 3 程 ...

- 历史性突破:使用 .net core 日处理消息量超过 1.7 万条!

业余时间用 .net core 写了一个在线客服系统.并在博客园写了一个系列的文章,写介绍这个开发过程: .net core 和 WPF 开发升讯威在线客服系统:目录 https://blog.she ...

- windows一些知识

宽字节 1.什么是ASCII码? 一张存储了字母大小写与一些符号的表,用一个字节表示,最高位不使用,最多只能存储128个符号或字母,但世界上有很多种语言,这远远不够 2.什么是扩展ASCII码? 把最 ...