hadoop-2.10.0安装hive-2.3.6

公司建立数仓,hive是必不可少的,hive是建立在hadoop基础上的数据库,前面已经搭建起了hadoop高可用,要学习hive,先从搭建开始,下面梳理一下hive搭建过程

1.下载hive安装包 ,下载地址:https://hive.apache.org/downloads.html

找到自己hadoop对应的版本下载安装,我这里下载的是 apache-hive-2.3.6-bin.tar.gz

2.安装hive,将安装包解压到/opt/soft下,并建立软链接

tar -zxvf apache-hive-2.3.-bin.tar.gz -C /opt/soft/

cd /opt/soft

mv apache-hive-2.3.-bin hive-2.3.

ln -s hive-2.3. hive

3.配置环境变量/etc/profile

vim /etc/profile #hive

export HIVE_HOME=/opt/soft/hive

export PATH=$PATH:$HIVE_HOME/bin

保存后别忘记编译一下

source /etc/profile

4.配置hive配置文件,hive元数据默认存储到derby数据库中,我们这里使用mysql来存储,hive-site.xml配置信息较多建议下载到windows下修改,然后再传上去

首先复制默认的配置文件模板,里面已经包含hive所有的默认配置信息

cp hive-default.xml.template hive-site.xml

修改hive-site.xml配置文件,将元数据存放数据库改为mysql,在hive-site.xml中找到下列属性,修改为:

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://192.168.118.1:3306/hive2</value>

<description>

JDBC connect string for a JDBC metastore.

To use SSL to encrypt/authenticate the connection, provide database-specific SSL flag in the connection URL.

For example, jdbc:postgresql://myhost/db?ssl=true for postgres database.

</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>Username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value></value>

<description>password to use against metastore database</description>

</property>

数据库驱动为mysql驱动com.mysql.jdbc.Driver,URL改为mysql的hive2(自定义)数据库,用户名密码为自己数据库对应的用户名密码

修改hive配置的一些目录,指定到自己选择的目录,搜索以 ${system 开头的 value 替换为自己的目录,我这里替换为:/home/hdfs/hive下相关目录

<property>

<name>hive.exec.local.scratchdir</name>

<value>/home/hdfs/hive</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/home/hdfs/hive/downloads</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

<property>

<name>hive.querylog.location</name>

<value>/home/hdfs/hive/querylog</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.server2.logging.operation.log.location</name>

<value>/home/hdfs/hive/server2_logs</value>

<description>Top level directory where operation logs are stored if logging functionality is enabled</description>

</property>

修改权限验证为false

<property>

<name>hive.server2.enable.doAs</name>

<value>false</value>

<description>

Setting this property to true will have HiveServer2 execute

Hive operations as the user making the calls to it.

</description>

</property>

5.既然修改元数据存放在mysql库里,就需要将mysql驱动包放入到hive/lib中,注意mysql版本和驱动包一致

mv mysql-connector-java-8.0..jar /opt/soft/hive/lib/

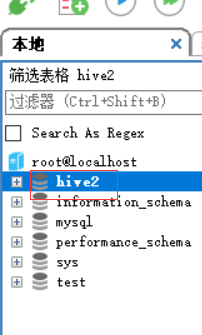

6.在mysql数据库中创建hive2库

7.初始化hive的元数据(表结构)到mysql中。

cd /opt/soft/hive/bin

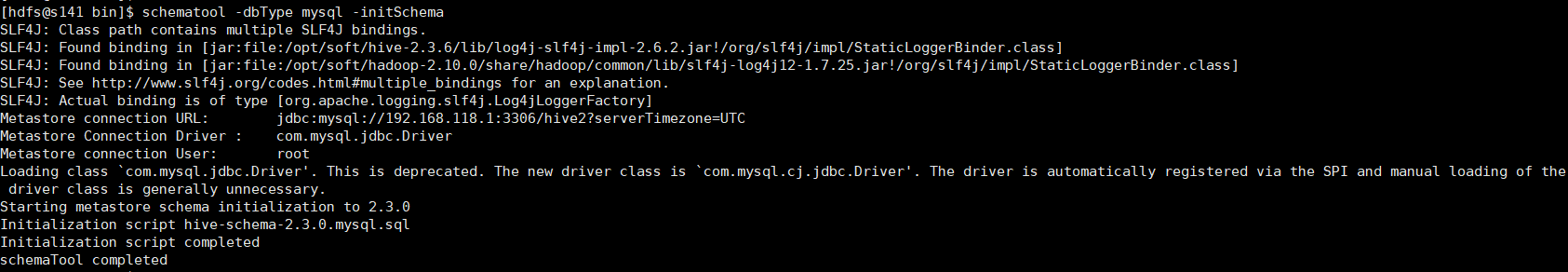

schematool -dbType mysql -initSchema

出现如下信息,代表成功

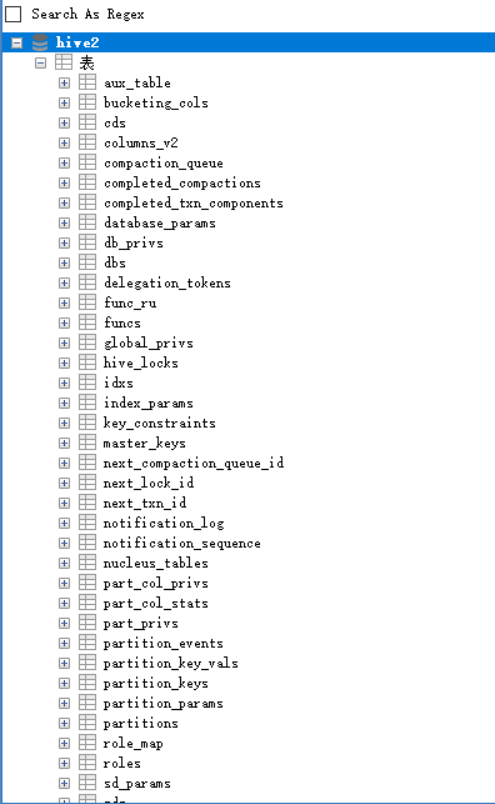

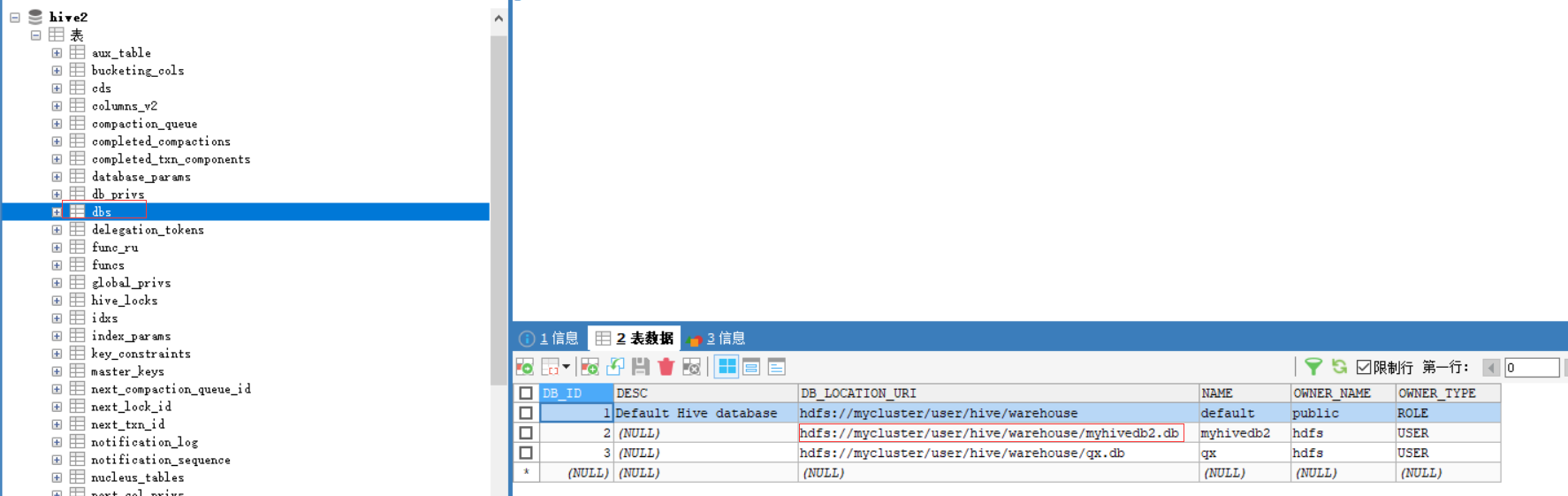

也可以查看mysql中hive2库,所有表初始化完成

8.启动hadoop,如果没有安装可以参考:centos7搭建hadoop2.10高可用(HA)

start-all.sh

9.启动hive

hive

查看目前只有default数据库

创建数据库:

create database myhivedb2;

查看创建的mysqhivedb2已经出来了

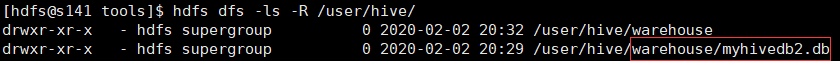

我们查一下hdfs中是否创建了对应的目录

hdfs dfs -ls -R /user/hive/

也可以查看mysql中hive2库的dbs表:

至此hive环境搭建完成

hadoop-2.10.0安装hive-2.3.6的更多相关文章

- vmware 10.0 安装centos6.5 客户系统 几个问题

1. vmware 10.0 安装centos6.5 客户系统 无法修改分辨率 要安装 desktop, KDE, legacy,x 组件 2. NAT 方式网卡无法自行启动 vim /etc/sy ...

- Adobe Audition CC 2017 (10.0)安装教程

Adobe Audition CC 2017 (10.0)安装教程 注:下载地址在文章末尾 第一步:首先请将电脑的网络断开,很简单:禁用本地连接或者拔掉网线,这样就可以免除登录Creative Clo ...

- 【149】ArcGIS Desktop 10.0 & Engine 10.0 安装及破解

写在前面:可能会出现按照此方法无法破解的情况,那请确保您有将 ArcGIS 10.0 已经完全卸载干净,直接通过控制面板进行卸载的时候并不能将其卸载干净,需要进行更深层次的卸载,包括删除注册表,各种文 ...

- Hadoop 2.2.0安装和配置lzo

转自:http://www.iteblog.com/archives/992 Hadoop经常用于处理大量的数据,如果期间的输出数据.中间数据能压缩存储,对系统的I/O性能会有提升.综合考虑压缩.解压 ...

- CDH hive-1.1.0-cdh5.10.0 安装

又重新安装Hive,记录一下吧: hadoop早已经装上了. cdh5的hive下载地址: http://archive.cloudera.com/cdh5/cdh/5/ 下载文件:hive-1.1. ...

- Windows环境下搭建Hadoop(2.6.0)+Hive(2.2.0)环境并连接Kettle(6.0)

前提:配置JDK1.8环境,并配置相应的环境变量,JAVA_HOME 一.Hadoop的安装 1.1 下载Hadoop (2.6.0) http://hadoop.apache.org/release ...

- ArcGIS Server 10.0 安装及使用完整攻略

引言 ArcGIS Server 10.0在使用和安装的过程中,需要进行比较全面的学习,才能正确使用.缺乏正确的指引,用户很容易在安装及使用中遇到问题.所以笔者在此总结Server 10.0的安装及使 ...

- Kafka0.10.0安装配置

1 解压文件 tar -zvxf kafka_2.11-0.10.0.0.tgz 2 修改配置server.properties vim server.properties broker.id=1 z ...

- ActiveMQ 5.10.0 安装与配置

先在官网下载activeMQ,我这里是5.10.0. 然后在解压在一个文件夹下即可. 我这里是:D:\apache-activemq-5.10.0-bin 然后进入bin目录:D:\apache-ac ...

随机推荐

- 牛客训练赛55 E 树

很妙的一个树形DP问题,简单考虑了一下就过了 https://ac.nowcoder.com/acm/contest/2927/E 主要就是推公式(公式有点长呀) 大概就是这样,其实挺简单的. #in ...

- redis 的持久化方式

redis 持久化的两种方式 RDB:RDB 持久化机制,是对 redis 中的数据执行周期性的持久化. AOF:AOF 机制对每条写入命令作为日志,以 append-only 的模式写入一个日志文件 ...

- 【题解】GREWords(AC自动机)

[题解]GREWords(AC自动机) SP9941 GRE - GRE Words 题目大意: 给定一个由字符串构成的序列,不同位置的字符串有自己权值.现在让你选出一个子序列,使得在这个子序列中,前 ...

- JVM探秘:四种引用、对象的生存与死亡

本系列笔记主要基于<深入理解Java虚拟机:JVM高级特性与最佳实践 第2版>,是这本书的读书笔记. Java虚拟机的内存区域中,程序计数器.Java栈和本地方法栈是线程私有的,随线程而生 ...

- DNS服务器红帽5.4搭建图文教程!!!

DNS服务器 挂载光盘 mount 查看光盘所在位置 mount -t iso9660 设备目录 /mnt 表示挂载 软件包安装 所有软件包都在Server目录下 rpm -ivh /mnt/Serv ...

- 1073 多选题常见计分法 (20分)C语言

批改多选题是比较麻烦的事情,有很多不同的计分方法.有一种最常见的计分方法是:如果考生选择了部分正确选项,并且没有选择任何错误选项,则得到 50% 分数:如果考生选择了任何一个错误的选项,则不能得分.本 ...

- 1028 人口普查 (20 分)C语言

题目描述 某城镇进行人口普查,得到了全体居民的生日.现请你写个程序,找出镇上最年长和最年轻的人. 这里确保每个输入的日期都是合法的,但不一定是合理的--假设已知镇上没有超过200岁的老人,而今天是20 ...

- Docker系列-第五篇Docker容器数据卷

1.是什么 在生产环境中使用 Docker,往往需要对数据进行持久化,或者需要在多个容器之间进行数据共享,这必然涉及容器的数据管理操作 . 容器中的管理数据主要有两种方式 : 数据卷 ( Data V ...

- express框架中使用nodemon自启动服务

1.安装nodemon //全局安装 npm install -g nodemon //本地安装 npm install nodemon --save 2.修改package.json配置 " ...

- Mysql中使用mysqldump进行导入导出sql文件

纪念工作中的第一次删库跑路的经历 今天接到一个任务,是将一个测试库数据导到另一个测试库,然而我们公司的数据库是不让直连的,所以只能通过远程连接进行导库操作. 老大布置任务的时候让用dump命令进行操作 ...