Python爬虫连载10-Requests模块、Proxy代理

一、Request模块

1.HTTP for Humans,更简洁更友好

2.继承了urllib所有的特征

3.底层使用的是urllib3

4.开源地址:https://github.com/requests/requests

5.中文文档:https://requests.readthedocs.io/zh_CN/latest/

6.先安装这个包:pip install requests

7.get请求

(1)requests.get()

(2)requests.request("get",url)

(3)可以带有headers和params参数

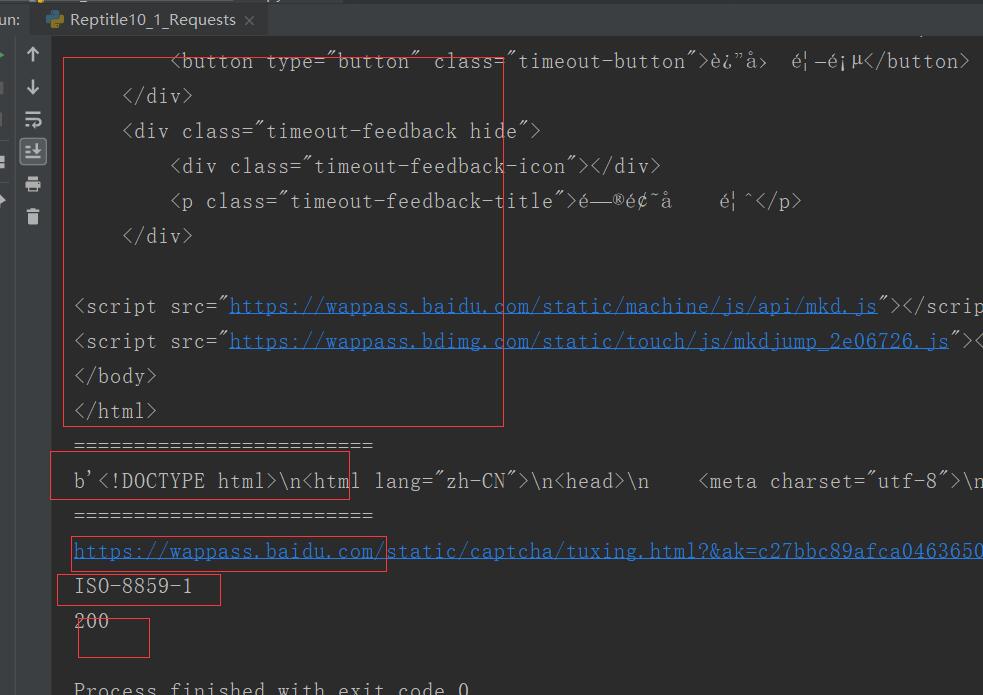

8.get返回内容

import requests

#两种请求

url = "http://www.baidu.com/s?"

rsp = requests.get(url)

# print(rsp.text)

#使用get请求

rsp = requests.request("GET",url)

# print(rsp.text)

#拿到的结果都是一样的

"""

使用参数headers和params来研究返回结果

"""

kw = {

"wd":"python中文文档"

}

headers = {

"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.116 Safari/537.36"

}

rsp=requests.get(url,params=kw,headers=headers)

print(rsp.text)

print("=========================")

print(rsp.content)

print("=========================")

print(rsp.url)

print(rsp.encoding)

print(rsp.status_code)

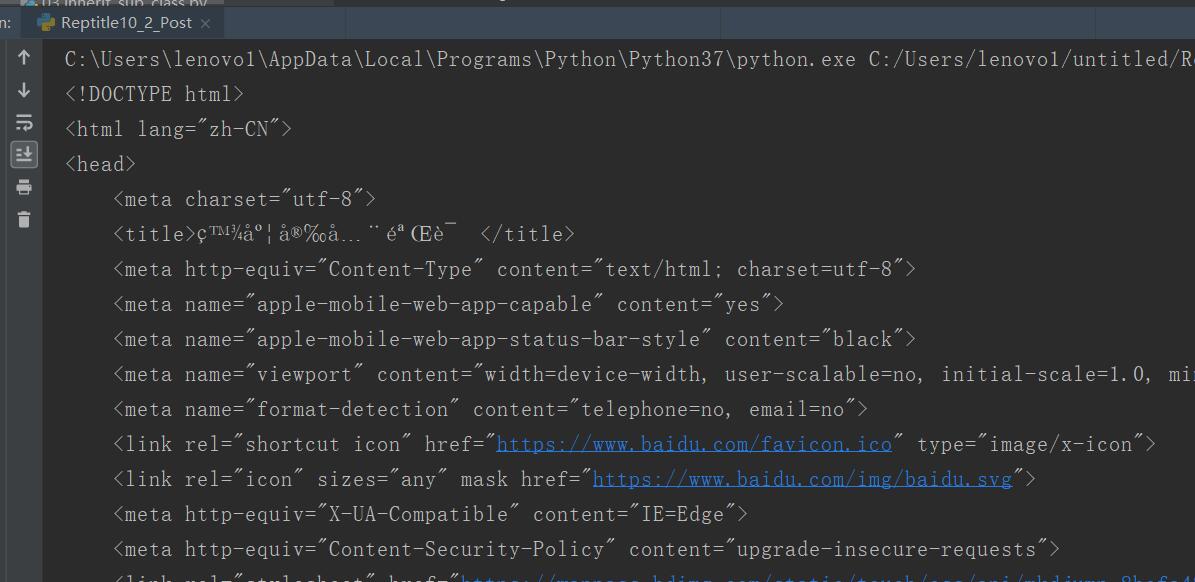

二、post

data,headers要求使用dict

import requests

from urllib import parse

import json

url = "http://www.baidu.com/s?"

data = {

"kw":"girl"

}

# data = parse.urlencode(data).encode("utf-8")

headers = {

"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.116 Safari/537.36"

}

rsp = requests.post(url,data=data,headers=headers)

print(rsp.text)

# print(rsp.json())

三、proxy代理

1.代理有可能会报错,如果使用人数多,考虑到安全问题,可能会被强行关闭

2.用户验证

(1)代理验证:可能需要HTTP basic Auth

proxy = {"http":"china:123456@192.168.1.123:458"}

#格式为 用户名:密码@代理地址:端口地址

rsp = requests.get("http://baidu.com",proxies=proxy)

(2)web客户端验证

如果遇到web客户端验证,需要添加auth=(用户名,密码)

auth = {"test",""}#授权信息

rsp = requests.get("http://www.baidu.com",auth=auth)

四、源码

Reptitle10_1_Requests.py

Reptitle10_2_Post.py

https://github.com/ruigege66/PythonReptile/blob/master/Reptitle10_1_Requests.py

https://github.com/ruigege66/PythonReptile/blob/master/Reptitle10_2_Post.py

2.CSDN:https://blog.csdn.net/weixin_44630050

3.博客园:https://www.cnblogs.com/ruigege0000/

4.欢迎关注微信公众号:傅里叶变换,个人公众号,仅用于学习交流,后台回复”礼包“,获取大数据学习资料

Python爬虫连载10-Requests模块、Proxy代理的更多相关文章

- python爬虫scrapy之downloader_middleware设置proxy代理

一.背景: 小编在爬虫的时候肯定会遇到被封杀的情况,昨天爬了一个网站,刚开始是可以了,在settings的设置DEFAULT_REQUEST_HEADERS伪装自己是chrome浏览器,刚开始是可以的 ...

- Python爬虫学习1: Requests模块的使用

Requests函数库是学习Python爬虫必备之一, 能够帮助我们方便地爬取. Requests: 让HTTP服务人类. 本文主要参考了其官方文档. Requests具有完备的中英文文档, 能完全满 ...

- python爬虫中的requests模块

Requests: 让 HTTP 服务人类 一.简介 虽然Python的标准库中 urllib 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests ...

- 吴裕雄--天生自然python爬虫:使用requests模块的get和post方式抓取中国旅游网站和有道翻译网站翻译内容数据

import requests url = 'http://www.cntour.cn/' strhtml = requests.get(url) print(strhtml.text) URL='h ...

- 爬虫开发5.requests模块的cookie和代理操作

代理和cookie操作 一.基于requests模块的cookie操作 引言:有些时候,我们在使用爬虫程序去爬取一些用户相关信息的数据(爬取张三“人人网”个人主页数据)时,如果使用之前requests ...

- python + seleinum +phantomjs 设置headers和proxy代理

python + seleinum +phantomjs 设置headers和proxy代理 最近因为工作需要使用selenium+phantomjs无头浏览器,其中遇到了一些坑,记录一下,尤 ...

- 爬虫中之Requests 模块的进阶

requests进阶内容 session处理cookie proxies参数设置请求代理ip 基于线程池的数据爬取 引入 有些时候,我们在使用爬虫程序去爬取一些用户相关信息的数据(爬取张三“人人网”个 ...

- 爬虫简介与requests模块

爬虫简介与requests模块 一 爬虫简介 概述 网络爬虫是一种按照一定规则,通过网页的链接地址来寻找网页的,从网站某一个页面(通常是首页)开始,读取网页的内容,找到网页中的其他链接地址,然后通过这 ...

- Python爬虫与数据分析之模块:内置模块、开源模块、自定义模块

专栏目录: Python爬虫与数据分析之python教学视频.python源码分享,python Python爬虫与数据分析之基础教程:Python的语法.字典.元组.列表 Python爬虫与数据分析 ...

随机推荐

- 解决python爬虫requests.exceptions.SSLError: HTTPSConnectionPool(host='XXX', port=443)问题

爬虫时报错如下: requests.exceptions.SSLError: HTTPSConnectionPool(host='某某某网站', port=443): Max retries exce ...

- 美食家App开发日记4

研究了卡片式布局中的Recyclerview的用法,但是调试了很长时间,导入包总是有问题,一到手机上运行就会闪退.还是在网上查了很多方法,很不开心我还是解决不了.

- python模拟鼠标拖动操作的方法

本文实例讲述了python模拟鼠标拖动操作的方法.分享给大家供大家参考.具体如下: pdf中的书签只有页码,准备把现有书签拖到一个目录中,然后添加自己页签.重复的拖动工作实在无趣,还是让程序帮我实现吧 ...

- 个人第4次作业——alpha项目测试

这个作业属于哪个课程 http://edu.cnblogs.com/campus/xnsy/GeographicInformationScience 这个作业的要求在哪里 https://www.cn ...

- 面向初学者的指南:创建时间序列预测 (使用Python)

https://blog.csdn.net/orDream/article/details/100013682 上面这一篇是对 https://www.analyticsvidhya.com/blog ...

- 《即时消息技术剖析与实战》学习笔记9——IM系统如何支持消息的多终端漫游

一.什么是多终端漫游 多终端漫游是指:用户在任意一个设备登录后,都能获取到历史的聊天记录.如:QQ 默认漫游 7 天的聊天记录,开通 VIP 会员可漫游 30 天,开通 SVIP 会员可漫游 2 年. ...

- 数据库及ORM之Mysql

1. 数据库介绍 1.1什么是数据库? 数据库(Database)是按照数据结构来组织.存储和管理数据的仓库,每个数据库都有一个或多个不同的API用于创建,访问,管理,搜索和复制所保存的数据.我们也可 ...

- CentOS7下部署2套Python版本共存

参考地址:https://www.cnblogs.com/xuaijun/p/7985245.html 源码的安装一般由3个步骤组成:配置(configure).编译(make).安装(make in ...

- Linux中inode详解

转自:https://www.cnblogs.com/itech/archive/2012/05/15/2502284.html 一.inode是什么? 理解inode,要从文件储存说起. 文件储存在 ...

- JDBC的学习笔记-手动实现

JDBC是SUN公司提供的一套用于数据库操作的接口,Java程序员只需要面向这套接口编程即可.不同的数据库厂商,需要针对这套接口,提供不同实现. 使用JDBC的好处:1.程序员不需要关注不同数据库的细 ...