Java网络爬虫Hello world实现——Httpclient爬取百度首页

1.创建Maven项目

2.Httpclient Maven地址

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpclient</artifactId>

<version>4.5.5</version>

</dependency>

在pom.xml文件中添加Httpclient jar包

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.gxy.blogs</groupId>

<artifactId>Demo</artifactId>

<version>0.0.1-SNAPSHOT</version> <dependencies>

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpclient</artifactId>

<version>4.5.5</version>

</dependency>

</dependencies> </project>

3.主要代码

package cha01; import java.io.IOException;

import org.apache.http.HttpEntity;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils; public class Test { public static void main(String[] args) throws IOException {

CloseableHttpClient httpclient=HttpClients.createDefault();

HttpGet httpget=new HttpGet("http://www.baidu.com");

CloseableHttpResponse response=httpclient.execute(httpget);

HttpEntity entity=response.getEntity();

System.out.println(entity);

String page=EntityUtils.toString(entity, "utf-8");

System.out.println(page);

response.close();

httpclient.close();

}

}

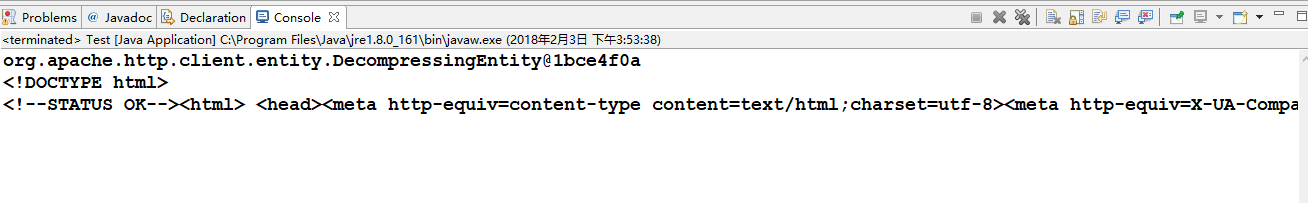

4.运行结果

Java网络爬虫Hello world实现——Httpclient爬取百度首页的更多相关文章

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- Python网络爬虫第三弹《爬取get请求的页面数据》

一.urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib. ...

- 爬虫实战(一) 用Python爬取百度百科

最近博主遇到这样一个需求:当用户输入一个词语时,返回这个词语的解释 我的第一个想法是做一个数据库,把常用的词语和词语的解释放到数据库里面,当用户查询时直接读取数据库结果 但是自己又没有心思做这样一个数 ...

- java爬取百度首页源代码

爬虫感觉挺有意思的,写一个最简单的抓取百度首页html代码的程序.虽然简单了一点,后期会加深的. package test; import java.io.BufferedReader; import ...

- Python 爬虫实例(1)—— 爬取百度图片

爬取百度图片 在Python 2.7上运行 #!/usr/bin/env python # -*- coding: utf-8 -*- # @Author: loveNight import jso ...

- Python爬虫实例(一)爬取百度贴吧帖子中的图片

程序功能说明:爬取百度贴吧帖子中的图片,用户输入贴吧名称和要爬取的起始和终止页数即可进行爬取. 思路分析: 一.指定贴吧url的获取 例如我们进入秦时明月吧,提取并分析其有效url如下 http:// ...

- 【Python网络爬虫四】通过关键字爬取多张百度图片的图片

最近看了女神的新剧<逃避虽然可耻但有用>,同样男主也是一名程序员,所以很有共鸣 被大只萝莉萌的一脸一脸的,我们来爬一爬女神的皂片. 百度搜索结果:新恒结衣 本文主要分为4个部分: 1.下载 ...

- python网络爬虫之使用scrapy自动爬取多个网页

前面介绍的scrapy爬虫只能爬取单个网页.如果我们想爬取多个网页.比如网上的小说该如何如何操作呢.比如下面的这样的结构.是小说的第一篇.可以点击返回目录还是下一页 对应的网页代码: 我们再看进入后面 ...

- 网络爬虫——针对任意主题批量爬取PDF

|本文为博主原创,转载请说明出处 任务需求:要求通过Google针对任意关键字爬取大量PDF文档,如K-means,KNN,SVM等. 环境:Anaconda3--Windows7-64位--Pyth ...

随机推荐

- 新概念英语(1-35)Our village

新概念英语(1-35)Our village Are the children coming out of the park or going into it ? This is a photogra ...

- CentOS 7下安装Chrome浏览器

1. cd /etc/yum.repos.d/ 2. vim google-chrome.repo 在该文件中输入: [google-chrome]name=google-chromebaseurl= ...

- [洛谷P3383][模板]线性筛素数-欧拉筛法

Description 如题,给定一个范围N,你需要处理M个某数字是否为质数的询问(每个数字均在范围1-N内) Input&Output Input 第一行包含两个正整数N.M,分别表示查询的 ...

- python 异常 反射

异常 反射 一.异常处理: AttributeError 试图访问一个对象没有的树形,比如foo.x,但是foo没有属性x IOError 输入/输出异常:基本上是无法打开文件 ImportError ...

- hdu4864 Task贪心好题

题目链接: http://acm.hdu.edu.cn/showproblem.php?pid=4864 题目大意: 有n个机器,m个任务.每个机器至多能完成一个任务.对于每个机器,有一个最大运行时间 ...

- Java内存回收机制.md

1.java的内存 java的内存结构分为 堆 (是gc的主要区域) 线程共享,主要是用于分配实例对象和数组 栈 线程私有,它的生命周期和线程相同,又分成 虚拟机栈和本地方法栈,只有它会报 Stack ...

- Windows下Java开发环境安装与配置

1. 前往Oracle网站下载JDK程序并安装. http://www.oracle.com/technetwork/java/javase/downloads/index.html 目前最新的版本为 ...

- .Net Core 通过依赖注入和动态加载程序集实现宿程序和接口实现类库完全解构

网上很多.Net Core依赖注入的例子代码,例如再宿主程序中要这样写: services.AddTransient<Interface1, Class1>(); 其中Interface1 ...

- 安装 WordPress 时一些常见问题

1)安装 WordPress 时,输入数据库信息后提交之后,却直接弹出一个空白页面 解决方法很简单,打开PHP的配置文件php.ini,查找max_execution_time,将这个参数改为max_ ...

- [LeetCode] Shopping Offers 购物优惠

In LeetCode Store, there are some kinds of items to sell. Each item has a price. However, there are ...