论文笔记——SQUEEZENET ALEXNET-LEVEL ACCURACY WITH 50X FEWER PARAMETERS AND <0.5MB MODEL SIZE

论文地址:https://arxiv.org/abs/1602.07360

模型地址:https://github.com/DeepScale/SqueezeNet

1. 论文思想

提出一种新的卷积组合方式替代原来的3*3的卷积。类似于bottleneck layer减少参数数目。但是不太像MobileNet是提出了一种新的卷积计算方式来减少参数,加速计算。

2. 网络结构设计策略

- 用3*3的替代1*1的filter。 (NiN, GoogLeNet)

- 减少3*3的输入channel数目。 (bottleneck layer)

- 延迟下采样(so that convolution layers have large activation maps. (He & Sun)

3. 组合方式

squeeze中的1*1的卷积为了减少输入到3*3中的channel数目

expand中的1*1和3*3的卷积,也算是一种效果的综合吧。(不能全是3*3的,不然论文就没有什么创新了。不能全是1*1的卷积,估计会影响效果。)

4. 网络结构

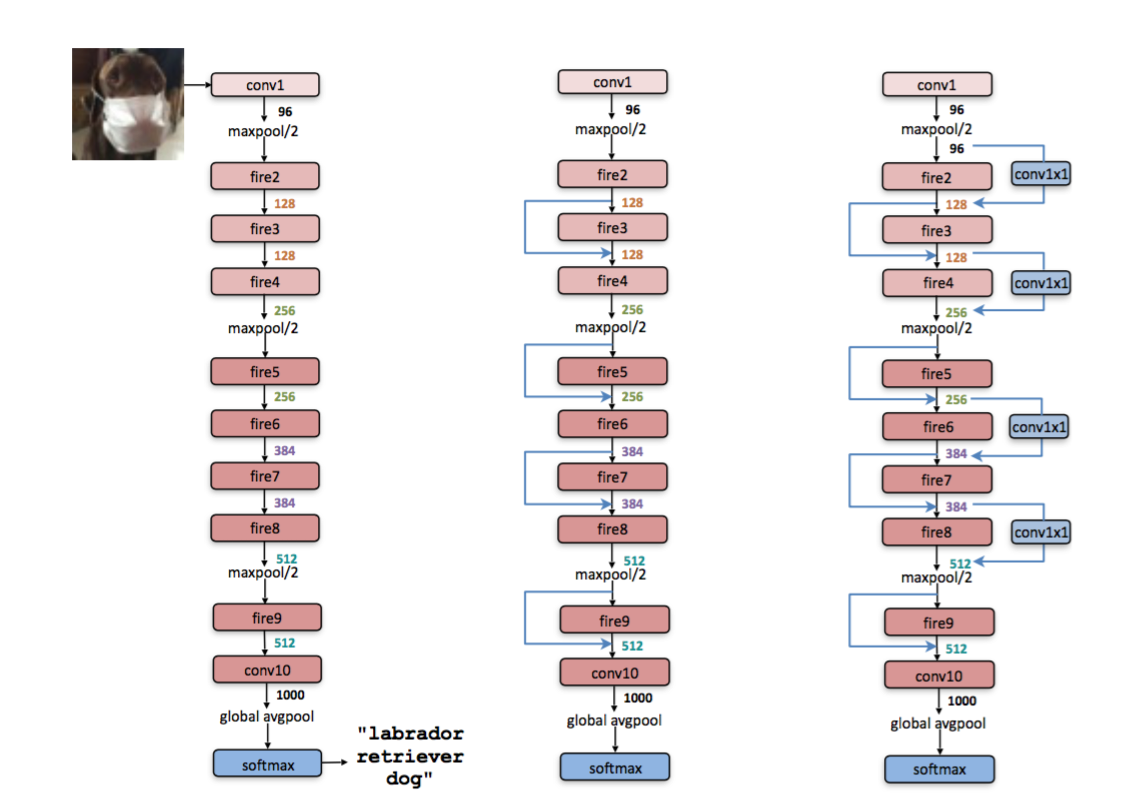

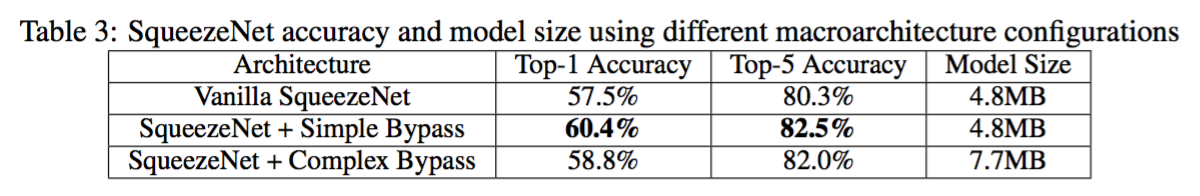

- SqueezeNet

- SqueezeNet with simple bypass(类似于ResNet,因为要做加操作,要求两个输入的channel num一样,所以只能在某些层加bypass)

- SqueezeNet with complex bypass(添加1*1的卷积,打破上面那个限制)

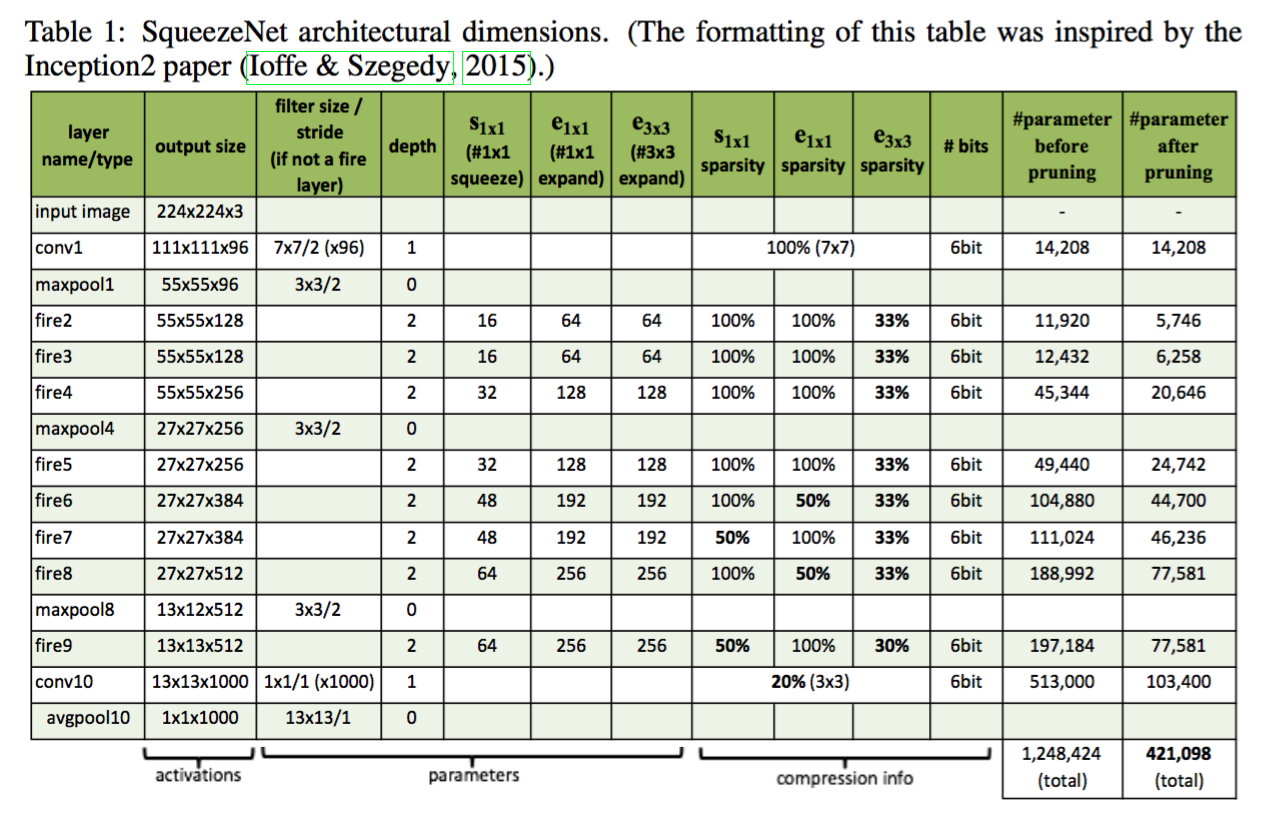

- compression info 应用的是Deep compression里面的稀疏性和量化的方法。

5. 组合方式探索

探索了几个超参数不同组合方式对网络大小以及准确率的影响。

结果

6. 总结

- 在AlexNet上实现了50x的缩减,模型大小小于0.5MB。

- 探索较深网络的时候,可以尝试这种方法。

- 又是一篇在1*1的卷积上做工作的文章。(MobileNet, ShuffleNet)

论文笔记——SQUEEZENET ALEXNET-LEVEL ACCURACY WITH 50X FEWER PARAMETERS AND <0.5MB MODEL SIZE的更多相关文章

- SQUEEZENET: ALEXNET-LEVEL ACCURACY WITH 50X FEWER PARAMETERS AND <0.5MB MODEL SIZE

论文阅读笔记 转载请注明出处: http://www.cnblogs.com/sysuzyq/p/6186518.html By 少侠阿朱

- SqueezeNet:AlexNet-level Accuracy with 50x fewer parameters and less than 0.5Mb model size

- Fire modules consisting of a 'squeeze' layer with 1*1 filters feeding an 'expand' layer with 1*1 a ...

- 论文笔记:CNN经典结构1(AlexNet,ZFNet,OverFeat,VGG,GoogleNet,ResNet)

前言 本文主要介绍2012-2015年的一些经典CNN结构,从AlexNet,ZFNet,OverFeat到VGG,GoogleNetv1-v4,ResNetv1-v2. 在论文笔记:CNN经典结构2 ...

- 论文笔记系列-Auto-DeepLab:Hierarchical Neural Architecture Search for Semantic Image Segmentation

Pytorch实现代码:https://github.com/MenghaoGuo/AutoDeeplab 创新点 cell-level and network-level search 以往的NAS ...

- Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现(转)

Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文, ...

- 论文笔记之:Visual Tracking with Fully Convolutional Networks

论文笔记之:Visual Tracking with Fully Convolutional Networks ICCV 2015 CUHK 本文利用 FCN 来做跟踪问题,但开篇就提到并非将其看做 ...

- Deep Learning论文笔记之(八)Deep Learning最新综述

Deep Learning论文笔记之(八)Deep Learning最新综述 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文,但老感觉看完 ...

- Twitter 新一代流处理利器——Heron 论文笔记之Heron架构

Twitter 新一代流处理利器--Heron 论文笔记之Heron架构 标签(空格分隔): Streaming-process realtime-process Heron Architecture ...

- Deep Learning论文笔记之(六)Multi-Stage多级架构分析

Deep Learning论文笔记之(六)Multi-Stage多级架构分析 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些 ...

随机推荐

- 前端(以Vue为例)webpack打包后dist文件包如何部署到django后台中

由于现在前端使用的三大框架配合webpack可以实现快速打包,为部署到服务端提供了非常大的便利,那么在前端打包后,应该做些什么可以部署到django的后台中呢? 1.打包后文件包dist 进入到 di ...

- LeetCode Top100 Liked Questions

1. TwoSum https://www.cnblogs.com/zhacai/p/10429120.html easy 2. Add Two Numbers https://www.cnblog ...

- python基础班-淘宝-目录.txt

卷 TOSHIBA EXT 的文件夹 PATH 列表卷序列号为 AE86-8E8DF:.│ python基础班-淘宝-目录.txt│ ├─1-1 Linux基础│ ├─01-课程简介│ │ 01-课程 ...

- PHP + Ajax处理大数据查询并导出Excel

思路:使用ajax多次请求服务器,分段生成多个Excel,然后打包压缩成zip,超链接指向下载的文件然后下载. [HTML部分] <input type="button" v ...

- test examples/test scripts

//https://www.getpostman.com/docs/v6/postman/scripts/test_examples //Setting an environment variable ...

- [LeetCode] 252. Meeting Rooms_Easy tag: Sort

Given an array of meeting time intervals consisting of start and end times [[s1,e1],[s2,e2],...] (si ...

- c++四种强制类型转化

c++ 数据类型转换: static_cast dynamic_cast reinterpret_cast const_cast C++ 类型转换(C风格的强制转换): (1)将浮点型数据赋值给整型变 ...

- matlab 绘制条状图形

clear,clc;A=zeros(1080,1920,3);A(:,1:384,:)=0;A(:,385:768,:)=10;A(:,769:1152,:)=20;A(:,1153:1536,:)= ...

- UVM中的regmodel建模(三)

总结一下UVM中的寄存器访问实现: 后门访问通过add_hdl_path命令来添加寄存器路径,并扩展uvm_reg_backdoor基类,定义read与write函数,最后在uvm_reg_block ...

- zw版【转发·台湾nvp系列Delphi例程】HALCON max_connection

zw版[转发·台湾nvp系列Delphi例程]HALCON max_connection procedure TForm1.Button1Click(Sender: TObject);var ho_I ...