含有分类变量(categorical variable)的逻辑回归(logistic regression)中虚拟变量(哑变量,dummy variable)的理解

使用R语言做逻辑回归的时候,当自变量中有分类变量(大于两个)的时候,对于回归模型的结果有一点困惑,搜索相关知识发现不少人也有相同的疑问,通过查阅资料这里给出自己的理解。

首先看一个实例(数据下载自:http://freakonometrics.free.fr/db.txt)

> db <- read.table("db.txt",header=TRUE,sep=";")

> head(db)

Y X1 X2 X3

1 1 3.297569 16.25411 B

2 1 6.418031 18.45130 D

3 1 5.279068 16.61806 B

4 1 5.539834 19.72158 C

5 1 4.123464 18.38634 C

6 1 7.778443 19.58338 C

> summary(db)

Y X1 X2 X3

Min. :0.000 Min. :-1.229 Min. :10.93 A:197

1st Qu.:1.000 1st Qu.: 4.545 1st Qu.:17.98 B:206

Median :1.000 Median : 5.982 Median :20.00 C:196

Mean :0.921 Mean : 5.958 Mean :19.94 D:197

3rd Qu.:1.000 3rd Qu.: 7.358 3rd Qu.:21.89 E:204

Max. :1.000 Max. :11.966 Max. :28.71

> reg <- glm(Y~X1+X2+X3,family=binomial,data=db)

> summary(reg) Call:

glm(formula = Y ~ X1 + X2 + X3, family = binomial, data = db) Deviance Residuals:

Min 1Q Median 3Q Max

-2.98017 0.09327 0.19106 0.37000 1.50646 Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) -4.45885 1.04646 -4.261 2.04e-05 ***

X1 0.51664 0.11178 4.622 3.80e-06 ***

X2 0.21008 0.07247 2.899 0.003745 **

X3B 1.74496 0.49952 3.493 0.000477 ***

X3C -0.03470 0.35691 -0.097 0.922543

X3D 0.08004 0.34916 0.229 0.818672

X3E 2.21966 0.56475 3.930 8.48e-05 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1 (Dispersion parameter for binomial family taken to be 1) Null deviance: 552.64 on 999 degrees of freedom

Residual deviance: 397.69 on 993 degrees of freedom

AIC: 411.69 Number of Fisher Scoring iterations: 7

该数据集三个自变量中 X1, X2为连续型变量,X3为分类变量(A,B,C,D,E)。 获取逻辑回归结果时发现X3变量的表示形式和X1,X2不一样,并且分别产生了X3B, X3C, X3D, X3E四个新的变量,但是又没有X3A变量。后来查阅相关资料才明白原来逻辑回归中处理分类变量和连续型变量是不一样的。

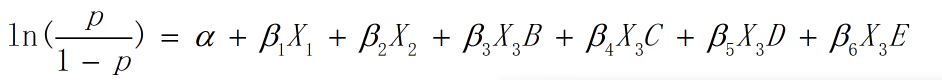

当分类自变量的类别大于两个的时候,需要建立一组虚拟变量(哑变量)来代表变量的归属性质。一般虚拟变量的数目比分类变量的数目少一个,少掉的那个就作为参照类(reference category)。例如本例中,A就是参照类,X3B, X3C, X3D, X3E就是四个虚拟变量。参照类的选取是随意的,R语言逻辑回归默认将分类变量的第一个factor设置为虚拟变量。此时的回归模型如下:

四个虚拟变量的取值为1或0,即当观测值中的分类变量属于某一组时,该组的虚拟变量值为1,剩下的虚拟变量值为0。

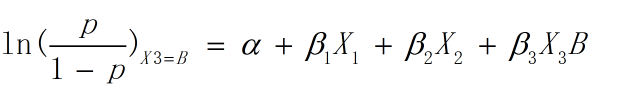

例如,当一组观测值(X1,X2,X3,Y)中 X3 的值为B时,虚拟变量X3B = 1, X3C, X3D, X3E 都为0,此时:

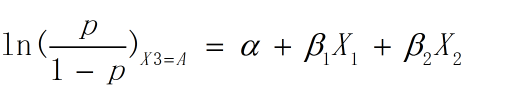

而当一组观测值(X1,X2,X3,Y)中 X3 的值为A时, 因为A为参照类,所以此时X3B, X3C, X3D, X3E都为0,此时:

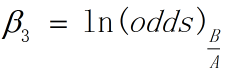

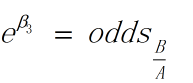

因此在控制变量条件下,即假设两组观测值中,X1, X2相同,而X3分别为A和B, 由上面两式相减可得:

此处odds(B/A)为变量B对变量A的发生比率,即变量B的发生比与变量A的发生比的比值。大于1的发生比率表明事件发生的可能性会提高,或者说自变量对事件发生的概率有正的作用。例如,假如说odds(B/A)的数值大于1,那么说明在X1,X2不变的条件下,X3取值B比X3取值A有更大的概率使Y的值为1。(王济川,郭志刚. Logistic 回归模型 —— 方法与应用[M]. 北京:高等教育出版社)

回到开头的例子,根据结果我们得以得出这样的结论,变量X3取值A,C,D对Y的影响差不多,而变量X3取值B,E会使得Y取值为1的概率比去A,C,D显著增大。简单看一下:

> db_a <- db[db$X3 == "A",]

> db_b <- db[db$X3 == "B",]

> db_c <- db[db$X3 == "C",]

> db_d <- db[db$X3 == "D",]

> db_e <- db[db$X3 == "E",] > table(db_a$Y) > table(db_b$Y) > table(db_c$Y) > table(db_d$Y) > table(db_e$Y)

大致从结果看出确实变量B,E组的Y值为1的比例要高于A,C,D组。

我们也可以自己定义虚拟变量:

> levels(db$X3)

[] "A" "B" "C" "D" "E"

> db$X3 <- relevel(db$X3, "B")

> levels(db$X3)

[] "B" "A" "C" "D" "E"

同上面的回归模型:

> reg <- glm(Y~X1+X2+X3,family=binomial,data=db)

> summary(reg) Call:

glm(formula = Y ~ X1 + X2 + X3, family = binomial, data = db) Deviance Residuals:

Min 1Q Median 3Q Max

-2.98017 0.09327 0.19106 0.37000 1.50646 Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) -2.71389 1.07274 -2.530 0.011410 *

X1 0.51664 0.11178 4.622 3.8e-06 ***

X2 0.21008 0.07247 2.899 0.003745 **

X3A -1.74496 0.49952 -3.493 0.000477 ***

X3C -1.77966 0.51002 -3.489 0.000484 ***

X3D -1.66492 0.50365 -3.306 0.000947 ***

X3E 0.47470 0.66354 0.715 0.474364

---

Signif. codes: ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ (Dispersion parameter for binomial family taken to be ) Null deviance: 552.64 on degrees of freedom

Residual deviance: 397.69 on degrees of freedom

AIC: 411.69 Number of Fisher Scoring iterations:

主要内容就这么多,如果想要更详细的了解可以参考:王济川,郭志刚. Logistic 回归模型 —— 方法与应用[M]. 北京:高等教育出版社

以及链接:https://www.r-bloggers.com/logistic-regression-and-categorical-covariates/

版权声明:本文为博主原创文章,博客地址:http://www.cnblogs.com/Demo1589/p/8973731.html,转载请注明出处。

含有分类变量(categorical variable)的逻辑回归(logistic regression)中虚拟变量(哑变量,dummy variable)的理解的更多相关文章

- 机器学习 (三) 逻辑回归 Logistic Regression

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang 的个人 ...

- Coursera公开课笔记: 斯坦福大学机器学习第六课“逻辑回归(Logistic Regression)” 清晰讲解logistic-good!!!!!!

原文:http://52opencourse.com/125/coursera%E5%85%AC%E5%BC%80%E8%AF%BE%E7%AC%94%E8%AE%B0-%E6%96%AF%E5%9D ...

- 机器学习总结之逻辑回归Logistic Regression

机器学习总结之逻辑回归Logistic Regression 逻辑回归logistic regression,虽然名字是回归,但是实际上它是处理分类问题的算法.简单的说回归问题和分类问题如下: 回归问 ...

- 机器学习(四)--------逻辑回归(Logistic Regression)

逻辑回归(Logistic Regression) 线性回归用来预测,逻辑回归用来分类. 线性回归是拟合函数,逻辑回归是预测函数 逻辑回归就是分类. 分类问题用线性方程是不行的 线性方程拟合的是连 ...

- 机器学习入门11 - 逻辑回归 (Logistic Regression)

原文链接:https://developers.google.com/machine-learning/crash-course/logistic-regression/ 逻辑回归会生成一个介于 0 ...

- 机器学习方法(五):逻辑回归Logistic Regression,Softmax Regression

欢迎转载,转载请注明:本文出自Bin的专栏blog.csdn.net/xbinworld. 技术交流QQ群:433250724,欢迎对算法.技术.应用感兴趣的同学加入. 前面介绍过线性回归的基本知识, ...

- ML 逻辑回归 Logistic Regression

逻辑回归 Logistic Regression 1 分类 Classification 首先我们来看看使用线性回归来解决分类会出现的问题.下图中,我们加入了一个训练集,产生的新的假设函数使得我们进行 ...

- 逻辑回归(Logistic Regression)详解,公式推导及代码实现

逻辑回归(Logistic Regression) 什么是逻辑回归: 逻辑回归(Logistic Regression)是一种基于概率的模式识别算法,虽然名字中带"回归",但实际上 ...

- 逻辑回归 logistic regression(1)逻辑回归的求解和概率解释

本系列内容大部分来自Standford公开课machine learning中Andrew老师的讲解,附加自己的一些理解,编程实现和学习笔记. 第一章 Logistic regression 1.逻辑 ...

- 逻辑回归Logistic Regression 之基础知识准备

0. 前言 这学期 Pattern Recognition 课程的 project 之一是手写数字识别,之二是做一个网站验证码的识别(鸭梨不小哇).面包要一口一口吃,先尝试把模式识别的经典问题—— ...

随机推荐

- 一日一练-CSS-CSS 居中

特别声明:此篇文章内容来源于@CHRIS COYIER 的Centering in CSS:A Complete Guide 子曰:CSS 居中是一个非常常见的问题,无论是在项目中,还是在各种面试资料 ...

- SpringBoot(三):springboot启动参数

springboot默认启动入口函数是支持接收参数,并且在整个应用程序内部也可以获取到这些参数,并且如果传递的参数是一些内部定义的参数将会被映射到springboot内部配置项,从而达到配置效果. s ...

- Java-NIO(四):通道(Channel)的原理与获取

通道(Channel): 由java.nio.channels包定义的,Channel表示IO源与目标打开的连接,Channel类似于传统的“流”,只不过Channel本身不能直接访问数据,Chann ...

- MongoDB系列五(地理空间索引与查询).

一.经纬度表示方式 MongoDB 中对经纬度的存储有着自己的一套规范(主要是为了可以在该字段上建立地理空间索引).包括两种方式,分别是 Legacy Coordinate Pairs (这个词实在不 ...

- this对象指向

this表示函数运行时,自动生成的一个内部对象,只能在函数内部运行 function test(){ this.x = 1; } 随着使用场景的变化,this的值会发生变化 原则:this指的值调用函 ...

- eclipse下如何使用Hibernate反转工程生与数据库对应的实体类和映射文件(以MySQL为例)

首先需要为eclipse添加对Hibernate的支持(也就是下载的Hibernate中的jar包),下载方法另查,这里不多做阐述. 想要使用反转工程,首先要下载Hibernate反转工程的插件Jbo ...

- 福利:100G Java全套学习视频免费送了

嗯 是的 众所周知 java工会自开办以来 一直致力于分享一些 java技术总结 学习方法..等等等 所以 从我做这个公众号以来 我的手机就没有消停过一天 因为 每天都有很多粉丝问我 "您好 ...

- java之设计模式工厂三兄弟之简单工厂模式

[学习难度:★★☆☆☆,使用频率:★★★☆☆] 工厂模式是最常用的一类创建型设计模式,通常我们所说的工厂模式是指工厂方法模式,它也是使用频率最高的工厂模式.本章将要学习的简单工厂模式是工厂方法模式的& ...

- PostgreSQL 常用系统自带方法

数据库字符编码问题: -- 查看PostgreSQL数据库服务器端编码: show server_encoding; -- 查看PostgreSQL客户端工具psql编码: s ...

- java设计模式之单例设计模式和多例设计模式

单例设计模式:构造方法私有化,在类的内部定义static属性和方法,利用static方法来取得本类的实例化对象:无论外部产生多少个实例化对象,本质上只有一个实例化对象 饿汉式单例设计 class Si ...