[Done]SnowFlake 分布式环境下基于ZK构WorkId

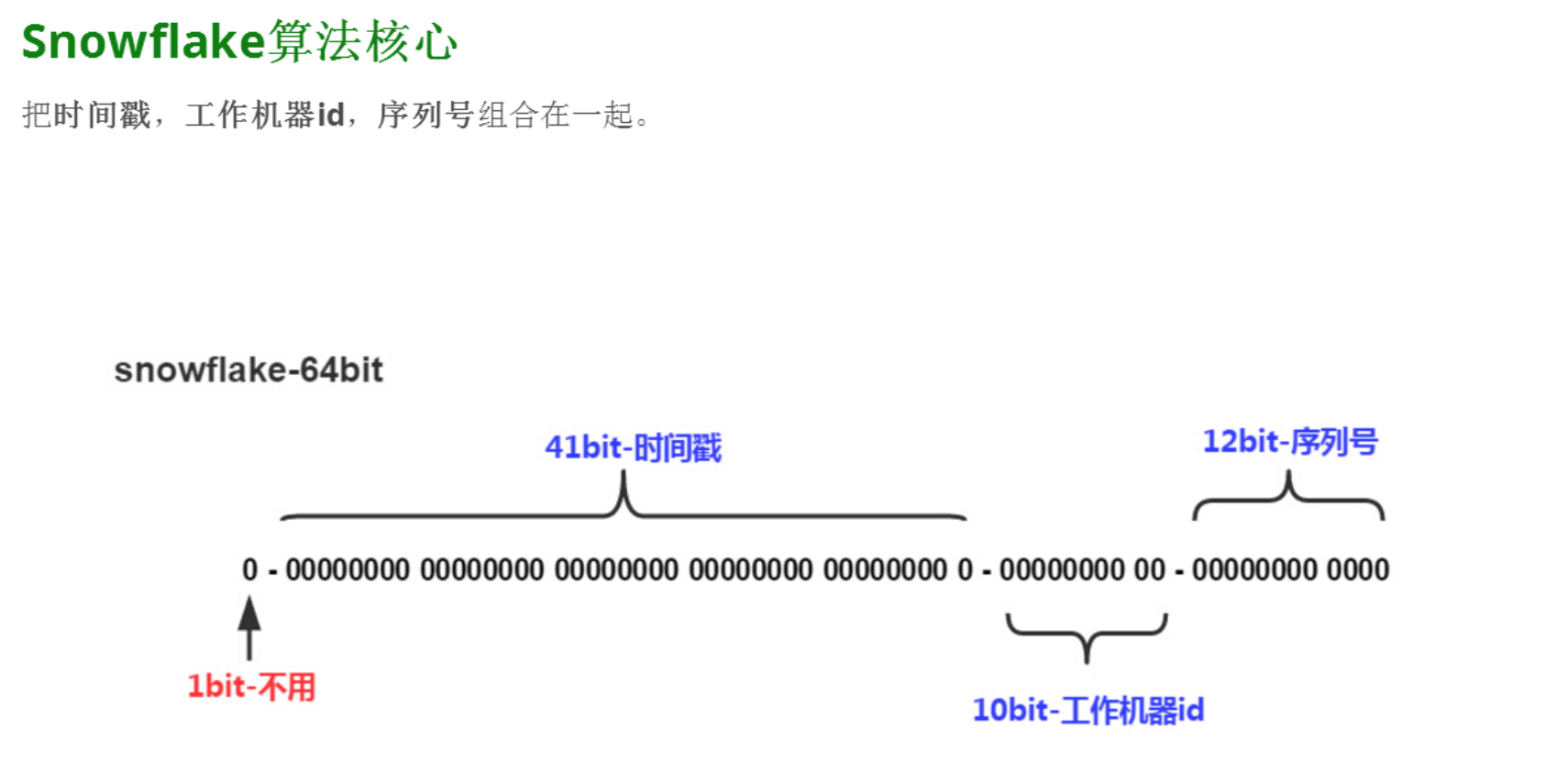

Twitter 的 Snowflake 大家应该都熟悉的,先上个图:

时间戳 序列号一般不会去改造,主要是工作机器id,大家会进行相关改造,我厂对工作机器进行了如下改造(估计大家都差不多吧,囧~~~):

机房号,不同的机房搞个初始化配置即可(当然若机房数量多也可考虑分布式动态获取),

主要是机器编号,在如何动态获取,以下workId获取方式供参考:

public class WorkIdBuilder {

private final static Logger logger = LoggerFactory.getLogger(WorkIdBuilder.class);

// 省略字段和get set 方法public void close() {

if (null != client && null == client.getState()) {

client.close();

}

client = null;

}

public void init() {

if (StringUtils.isBlank(this.appName)) {

logger.error("应用名称不能为空!");

throw new RuntimeException("应用名称不能为空!");

}

if (client != null) {

close();

}

client = CuratorFrameworkFactory.builder()

.connectString(address)

.connectionTimeoutMs(connectionTimeout)

.sessionTimeoutMs(sessionTimeout)

.canBeReadOnly(false)

.retryPolicy(new ExponentialBackoffRetry(baseSleepTimeOut, Integer.MAX_VALUE))

.build();

client.start();

buildWorkId(this.appName);

}

// 序号集,当前最大支持 256 个节点,每个节点去占用编号,通过InterProcessLock来控制分布式环境下的获取

private static Set<Integer> OrderIdSet ;

static {

OrderIdSet = new HashSet<>();

for(int i = 0; i < MAX_ORDER; i++){

OrderIdSet.add(i);

}

}

/***

* 获取workId

* @param appPath 应用名称

*/

private void buildWorkId(final String appPath){

// 检测client是否已经连接上

if (null == client) {

throw new RuntimeException("本节点注册到ZK异常。");

}

// lockPath,用于加锁,注意要与nodePath区分开

final String lockPath = this.ROOT_NAME +"/" + this.appName ;

// nodePath 用于存放集群各节点初始路径

final String nodePath = this.ROOT_NAME +"/" + this.appName + this.NODE_NAME;

// InterProcessMutex 分布式锁(加锁过程中lockPath会自动创建)

InterProcessLock interProcessLock = new InterProcessMutex(client, lockPath);

try {

// 加锁 此处逻辑非常重要

if (!interProcessLock.acquire(lockTimeOut, TimeUnit.MILLISECONDS)) {

throw new TimeoutException("ZK分布式锁 加锁超时,超时时间: " + lockTimeOut);

}

// nodePath 第一次需初始化,永久保存, 或者节点路径为临时节点,则设置为永久节点

if (null == client.checkExists().forPath(nodePath)) {

client.create().creatingParentsIfNeeded().withMode(CreateMode.PERSISTENT).forPath(nodePath);

}

// 获取nodePath下已经创建的子节点

List<String> childPath = client.getChildren().forPath(nodePath);

Set<Integer> nodeIdSet = new LinkedHashSet<>();

if(CollectionUtils.isNotEmpty(childPath)){

for(String path : childPath){

try {

nodeIdSet.add(Integer.valueOf(path));

}

catch (Exception e){

logger.warn("路径由不合法操作创建,注意["+nodePath+"]仅用于构建workId");

// ignore

}

}

}

// 遍历所有id,构建workId,主要是判断可用id是否已经被集群中其他节点占用

for (Integer order : OrderIdSet) {

if (!nodeIdSet.contains(order)) {

final String currentNodePath = nodePath + "/" + order;

String nodeDate = String.format("[ip:%s,hostname:%s,pid:%s]",

InetAddress.getLocalHost().getHostAddress(),

InetAddress.getLocalHost().getHostName(),

ManagementFactory.getRuntimeMXBean().getName().split("@")[0]);

// 事务提交, 应用断开zk连接时候,删除该节点数据,此处CreateMode = EPHEMERAL (非常重要)

// 当本节点zk断开时,其他client.getChildren().forPath(nodePath)进行操作时,子节点逻辑已释放,orderId可复用

client.inTransaction()

.create().withMode(CreateMode.EPHEMERAL).forPath(currentNodePath)

.and().setData().forPath(currentNodePath,nodeDate.getBytes("UTF-8"))

.and().commit();

long pathCreateTime = client.checkExists().forPath(currentNodePath).getCtime();

// 以下逻辑主要用于检测断开重连情况

TreeCache treeCache = new TreeCache(client, currentNodePath);

// 添加监听器

treeCache.getListenable().addListener(new TreeCacheListener() {

public void childEvent(CuratorFramework curatorFramework,

TreeCacheEvent treeCacheEvent) throws Exception {

long pathTime;

try {

pathTime = curatorFramework.checkExists().forPath(currentNodePath).getCtime();

} catch (Exception e) {

pathTime = 0;

}

// 如果pathTime != pathCreateTime, 那么只能一种情况:

// 当前应用与zk失去联系,且/nodePath/{currentNodePath}不存在或者被其它应用占据了(表象为pathCreateTime变化)

// 无论哪种情况,当前应用都要重新注册节点

if (pathCreateTime != pathTime) {

logger.info("从ZK断开,再次注册...") ;

// 关闭之前旧的treeCache

try{

treeCache.close();

}

catch (Exception e){

logger.warn("treeCache关闭失败");

}

// 再次注册

finally {

buildWorkId(appPath);

}

}

}

});

treeCache.start();

this.workerId = order;

logger.info("基于ZK成功构建 workId:{}",this.workerId);

return;

}

}

throw new RuntimeException("获取WorkId失败,共["+this.MAX_ORDER+"]个可用WorkId, 已全部用完。 ");

} catch (Exception e) {

logger.error("获取分布式WorkId异常",e);

} finally {

// 构建成功后释放锁

if(interProcessLock != null) {

try {

interProcessLock.release();

} catch (Exception e) {

logger.warn("释放锁失败");

}

}

}

}

}

供参考。

以上。

[Done]SnowFlake 分布式环境下基于ZK构WorkId的更多相关文章

- 分布式环境下Unique ID生成方法

ID即标示符,在某个搜索域内能唯一标示其中某个对象.在关系型数据库中每个表都需要定义一个主键来唯一标示一条记录.为了方便一般都会使用一个auto_increment属性的整形数做为ID.因为数据库本身 ...

- 分布式环境下的id生成方法

分布式环境下的id生成方法 前几天研究数据库分表分库的问题,其中有一个关键的地方就是生成唯一键的问题,假如数据表有1亿条数据,而且还在不断的增加,这里我们就需要考虑到分表分库,假设我们采用Hash ...

- 集群/分布式环境下5种session处理策略

转载自:http://blog.csdn.net/u010028869/article/details/50773174?ref=myread 前言 在搭建完集群环境后,不得不考虑的一个问题就是用户访 ...

- 【架构师之路】集群/分布式环境下5种session处理策略

[架构师之路]集群/分布式环境下5种session处理策略 转自:http://www.cnblogs.com/jhli/p/6557929.html 在搭建完集群环境后,不得不考虑的一个问题就是 ...

- 【转】分布式环境下5种session处理策略(大型网站技术架构:核心原理与案例分析 里面的方案)

前言 在搭建完集群环境后,不得不考虑的一个问题就是用户访问产生的session如何处理.如果不做任何处理的话,用户将出现频繁登录的现象,比如集群中存在A.B两台服务器,用户在第一次访问网站时,Ngin ...

- 【转】集群/分布式环境下5种session处理策略

转载至:http://blog.csdn.net/u010028869/article/details/50773174 在搭建完集群环境后,不得不考虑的一个问题就是用户访问产生的session如何处 ...

- 集群/分布式环境下,Session处理策略

前言 在搭建完集群环境后,不得不考虑的一个问题就是用户访问产生的session如何处理.如果不做任何处理的话,用户将出现频繁登录的现象.比如集中中存在A.B两台服务器,用户在第一次访问网站是,Ngin ...

- Shiro权限管理框架(二):Shiro结合Redis实现分布式环境下的Session共享

首发地址:https://www.guitu18.com/post/2019/07/28/44.html 本篇是Shiro系列第二篇,使用Shiro基于Redis实现分布式环境下的Session共享. ...

- .NET环境下基于RBAC的访问控制

.NET环境下基于RBAC的访问控制 Access Control of Application Based on RBAC model in .NET Environment 摘 要:本文从目前信息 ...

随机推荐

- IOS学习笔记41--图片的缩放(一)

图片的缩放 一:Pinch手势对图片进行缩放.即用两根手指往不同方向拖拉照片,照片会被缩小或放大. 我理解的原理:等比缩放 先看如下关键代码: 1.初始化参数 - (void)viewDidLoad ...

- 解决Arcgis10.2.2中dbf文件用EXCEL打开乱码问题

1.开始 -- 运行,输入”Regedit“,打开 注册表 . 2.如是用的是 10.x 版本 ArcGIS Desktop,定位到 ‘计算机\HKEY_CURRENT_USER\Software\E ...

- 如何下载android源码与android内核源码

首先,要分清楚,android的源代码和android的内核代码一般是分开的,要分别进行下载. 1.先下载android的源代码.(这里不包括android的内核代码) 下载最新的源代码,一 ...

- java编码问题总结

第一篇:JAVA字符编码系列一:Unicode,GBK,GB2312,UTF-8概念基础 第二篇:JAVA字符编码系列二:Unicode,ISO-8859,GBK,UTF-8编码及相互转换 第三篇:J ...

- Kafka实现细节(三)

如果你第一次看kafka的文章,请先看<分布式消息系统kafka初步> 之前有人问kafka和一般的MQ之间的区别,这个问题挺难回答,我觉得不如从kafka的实现原理来分析更为透彻,这篇将 ...

- 混沌数学之logistic模型

logistic回归又称logistic回归分析,主要在流行病学中应用较多,比较常用的情形是探索某疾病的危险因素,根据危险因素预测某疾病发生的概率. 相关DEMO参见:混沌数学之离散点集图形DEMO ...

- std::vector利用swap()函数进行内存的释放【转】

首先,vector与deque不同,其内存占用空间只会增长,不会减小.比如你首先分配了10,000个字节,然后erase掉后面9,999个,则虽然有效元素只有一个,但是内存占用仍为10,000个.所有 ...

- Android实现随机验证码——自定义View

一.问题描述 熟悉web开发中童鞋们都知道为了防止恶意破解.恶意提交.刷票等我们在提交表单数据时,都会使用随机验证码功能.在Android应用中我们同样需要这一功能,该如何实现呢,下面我们就自定义一个 ...

- Android -- 自定义标题栏,背景颜色填充满

设置标题栏背景 1> 准备背景图片: background_pix.png 注:用背景图片比用颜色好处,可以让背景看起来有凹凸感. 2> drawable文件夹下放xml文件 bitmap ...

- jquery制作一个简单的轮播

效果图: 演示地址: http://ae6623.cn/demo/slider/index.html 思路: 利用css的定位属性 left 进行调整图片的显示,每次点击上一页下一页按钮的时候,-图片 ...