python爬取猫眼电影Top100榜单的信息

爬取并写入MySQL中

import pymysql

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/80.0.3987.163 Safari/537.36 '

}

connect = pymysql.Connect(

host='localhost',

port=3306,

user='root',

passwd='root',

db='python',

charset='utf8'

)

# 获取游标

cursor = connect.cursor()

def toMySQL(imgBlob, titleSQL, starringSQL, releaseTimeSQL, scoreSQL):

print(requests.get(imgBlob).content)

print(imgBlob)

print(titleSQL)

print(starringSQL[3:])

print(releaseTimeSQL[5:])

print(scoreSQL)

insertSql = """INSERT INTO `python`.`maoyan`(`img`, `title`, `starring`, `release_time`, `score`) VALUES ('{a}','{b}','{c}','{d}','{e}')"""

cursor.execute(

insertSql.format(a=r'' + str(requests.get(imgBlob).content), b=titleSQL, c=starringSQL[3:], d=releaseTimeSQL[5:],

e=scoreSQL))

print("------------------执行了插入")

connect.commit()

def mingzihaonanqi(page):

url = 'https://maoyan.com/board/4?offset=' + str(page)

res = requests.get(url, headers=headers)

# 页面session失效, 需要重新验证, 打印出来方便使用

print(res.url)

# 打印出页面的所有代码

# print(res.text)

soup = BeautifulSoup(res.text, 'html.parser')

ResultSets = soup.find_all('dd')

for resultSet in ResultSets:

tag = resultSet

soupTag = BeautifulSoup(str(tag), 'html.parser')

Title = soupTag.find('a').get('title')

imgSrc = soupTag.find('img', class_='board-img').get('data-src')

starring = soupTag.find('p', class_='star').text.strip()

releaseTime = soupTag.find('p', class_='releasetime').text.strip()

score = soupTag.find('p', class_='score').text.strip()

toMySQL(imgSrc, Title, starring, releaseTime, score)

print(str(page) + "----------")

if __name__ == '__main__':

for i in range(30, 100, 10):

print(i) # 0 10 20 ````

mingzihaonanqi(i)

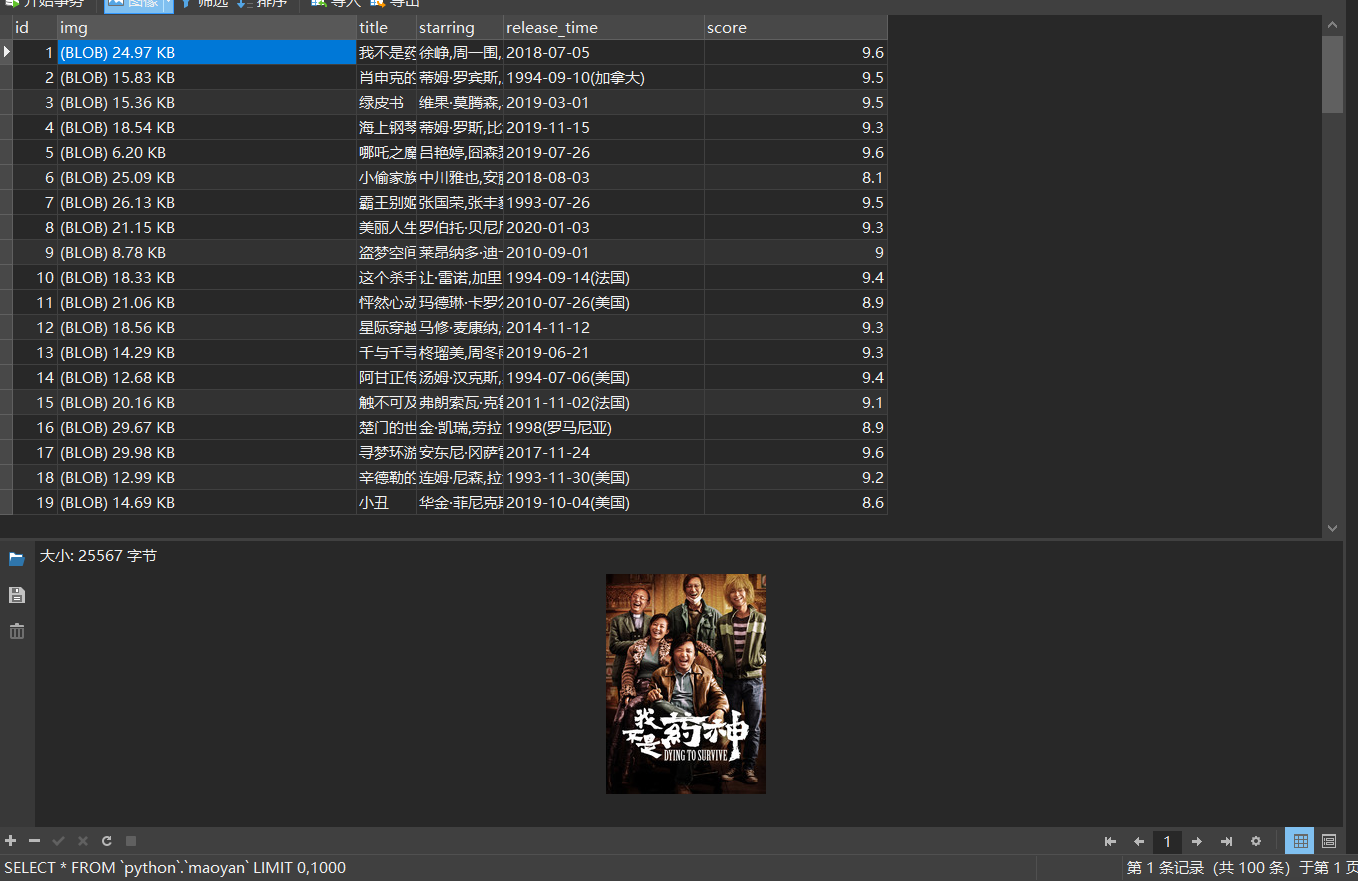

库表信息

运行结果:

爬取后写入MongoDB

import pymongo

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/80.0.3987.163 Safari/537.36 '

}

def toMongoDB(imgSrc, Title, starring, releaseTime, score):

print(imgSrc)

print(Title)

print(starring[3:])

print(releaseTime[5:])

print(score)

myClient = pymongo.MongoClient("mongodb://localhost:27017/")

myDb = myClient["maoyan"]

myCollection = myDb["maoyanTop100"]

myDictionary = {

"imgSrc": imgSrc,

"Title": Title,

"starring": starring[3:],

"releaseTime": releaseTime[5:],

"score": score

}

result = myCollection.insert_one(myDictionary)

print(result)

pass

def mingzihaonanqi(page):

url = 'https://maoyan.com/board/4?offset=' + str(page)

res = requests.get(url, headers=headers)

# 页面session失效, 需要重新验证, 打印出来方便使用

print(res.url)

# 打印出页面的所有代码

# print(res.text)

soup = BeautifulSoup(res.text, 'html.parser')

ResultSets = soup.find_all('dd')

for resultSet in ResultSets:

tag = resultSet

soupTag = BeautifulSoup(str(tag), 'html.parser')

Title = soupTag.find('a').get('title')

imgSrc = soupTag.find('img', class_='board-img').get('data-src')

starring = soupTag.find('p', class_='star').text.strip()

releaseTime = soupTag.find('p', class_='releasetime').text.strip()

score = soupTag.find('p', class_='score').text.strip()

# 写入MongoDB

toMongoDB(imgSrc, Title, starring, releaseTime, score)

print(str(page) + "----------")

if __name__ == '__main__':

for i in range(0, 100, 10):

print(i) # 0 10 20 ````

mingzihaonanqi(i)

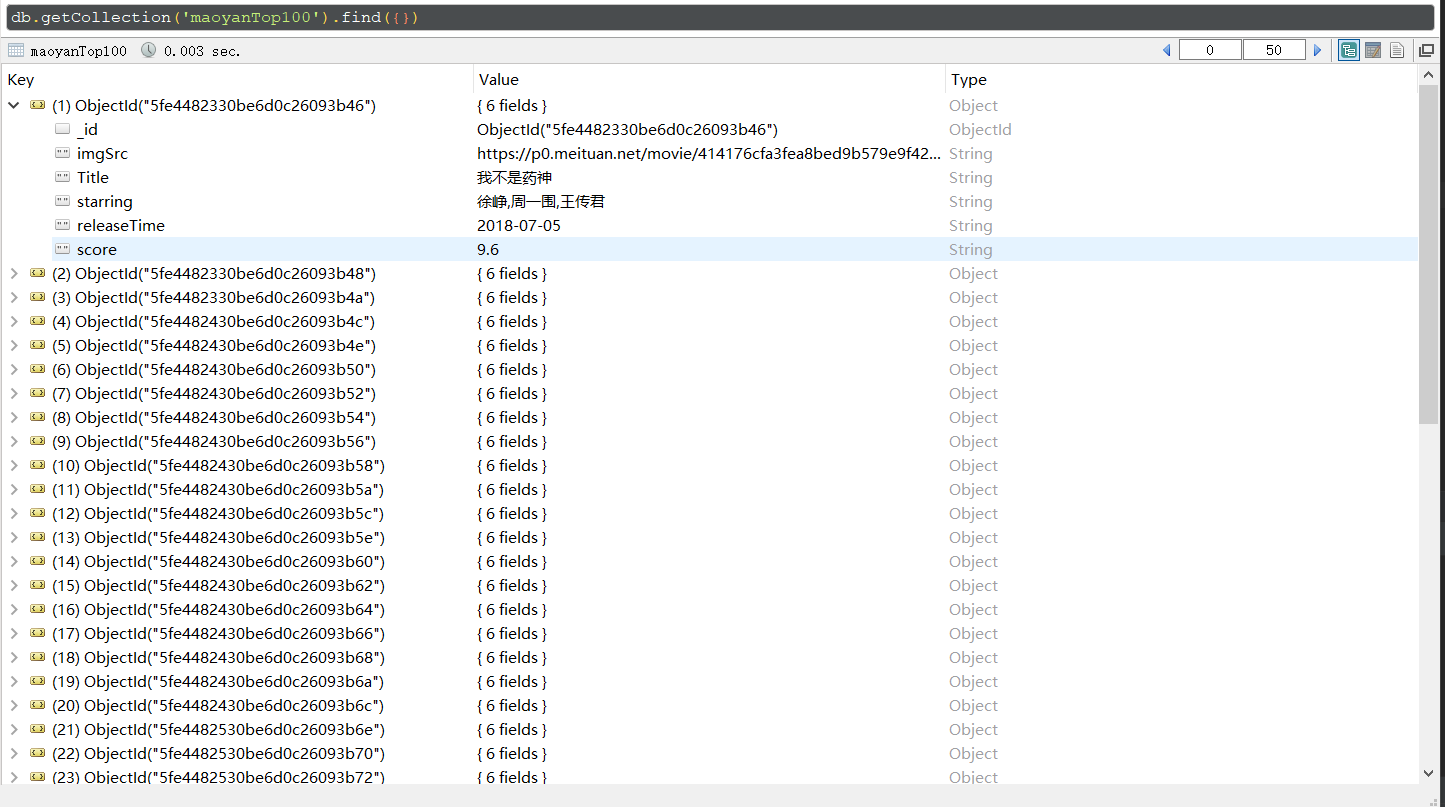

运行结果

python爬取猫眼电影Top100榜单的信息的更多相关文章

- 爬虫系列(1)-----python爬取猫眼电影top100榜

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天在整理代码时,整理了一下之前自己学习爬虫的一些代码,今天先上一个简单的例子,手把手教你入门Python爬虫,爬取 ...

- 使用requests爬取猫眼电影TOP100榜单

Requests是一个很方便的python网络编程库,用官方的话是"非转基因,可以安全食用".里面封装了很多的方法,避免了urllib/urllib2的繁琐. 这一节使用reque ...

- python 爬取猫眼电影top100数据

最近有爬虫相关的需求,所以上B站找了个视频(链接在文末)看了一下,做了一个小程序出来,大体上没有修改,只是在最后的存储上,由txt换成了excel. 简要需求:爬虫爬取 猫眼电影TOP100榜单 数据 ...

- 50 行代码教你爬取猫眼电影 TOP100 榜所有信息

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天,恋习Python的手把手系列,手把手教你入门Python爬虫,爬取猫眼电影TOP100榜信息,将涉及到基础爬虫 ...

- 40行代码爬取猫眼电影TOP100榜所有信息

主要内容: 一.基础爬虫框架的三大模块 二.完整代码解析及效果展示 1️⃣ 基础爬虫框架的三大模块 1.HTML下载器:利用requests模块下载HTML网页. 2.HTML解析器:利用re正则表 ...

- Python爬虫项目--爬取猫眼电影Top100榜

本次抓取猫眼电影Top100榜所用到的知识点: 1. python requests库 2. 正则表达式 3. csv模块 4. 多进程 正文 目标站点分析 通过对目标站点的分析, 来确定网页结构, ...

- Requests+正则表达式爬取猫眼电影(TOP100榜)

猫眼电影网址:www.maoyan.com 前言:网上一些大神已经对猫眼电影进行过爬取,所用的方法也是各有其优,最终目的是把影片排名.图片.名称.主要演员.上映时间与评分提取出来并保存到文件或者数据库 ...

- Python爬取猫眼电影100榜并保存到excel表格

首先我们前期要导入的第三方类库有; 通过猫眼电影100榜的源码可以看到很有规律 如: 亦或者是: 根据规律我们可以得到非贪婪的正则表达式 """<div class ...

- python爬取猫眼电影top100

最近想研究下python爬虫,于是就找了些练习项目试试手,熟悉一下,猫眼电影可能就是那种最简单的了. 1 看下猫眼电影的top100页面 分了10页,url为:https://maoyan.com/b ...

- python 爬取猫眼下的榜单(一)--单个页面

#!/usr/bin/env python # -*- coding: utf- -*- # @Author: Dang Kai # @Date: -- :: # @Last Modified tim ...

随机推荐

- 2021版idea关于translation插件翻译报错

cn.yiiguxing.plugin.translate.trans.TranslateException: Google 翻译 :: 翻译失败: 未知错误 这是idea拉下来的报错信息,trans ...

- spring-security-oauth2-authorization-server

旧依赖的移除 长久以来,使用Spring Security整合oauth2,都是使用Spring Security Oauth2这个系列的包: <dependency> <group ...

- 树莓派4B的Node-Red编程(一)

一.树莓派烧写 二.Node-Red 环境搭建 (一)安装Node.js (二)安装Node-Red (三)启动服务:win+R输入CMD:输入Node-red. (四)进入浏览器127.0.0.1: ...

- 将Vue项目部署到Nginx中,出现的400,405,200响应空等问题处理

最近用Vue3写了个项目,然后对接后台接口. 在本地vue配置文件中,配置了反向代理.成功请求了后端接口. 自测没有问题. 打包vue,发布到nginx中.运行nginx,成功显示了页面. 当点击页面 ...

- goland 快捷键

goland常用快捷键 Coldestmonth 2018-07-17 17:26:37 18067 收藏 14版权Ctrl+/ 或 Ctrl+Shift+/ 注释(// 或者/-/ )Ctrl+D ...

- .netCore Nuget包引用记录

1.画图 System.Drawing.Common 2.

- WLAN - AP上线

1 保证AC,AP互通2 AP上线capwap 1 AP组创建 2 管理域模板 3 AC组和管理域模板绑定 4 指定AC的接口 5 导入AP3 WALN的业务配置 1 安全模板 2 SSID 模板 3 ...

- Java中String相关知识

String 1.String概述 String代表字符串,Java程序中所有的字符串文字(例如'abc")都被实现为此类的实例,也就是说,Java中所有的双引号字符串都是String类的对 ...

- 导入ssm项目时,项目基本的配置文件

一.ssm框架基本的配置文件 上面的这些配置文件对于比较简单的ssm项目其实大同小异,逻辑上是差不多的. 在config目录下 在lib下就是各种jar包 二.导入ssm项目后,本地环境配置和项目本身 ...

- jsp第4个作业(2)

<%@ page language="java" import="java.util.*" pageEncoding="utf-8"% ...