第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

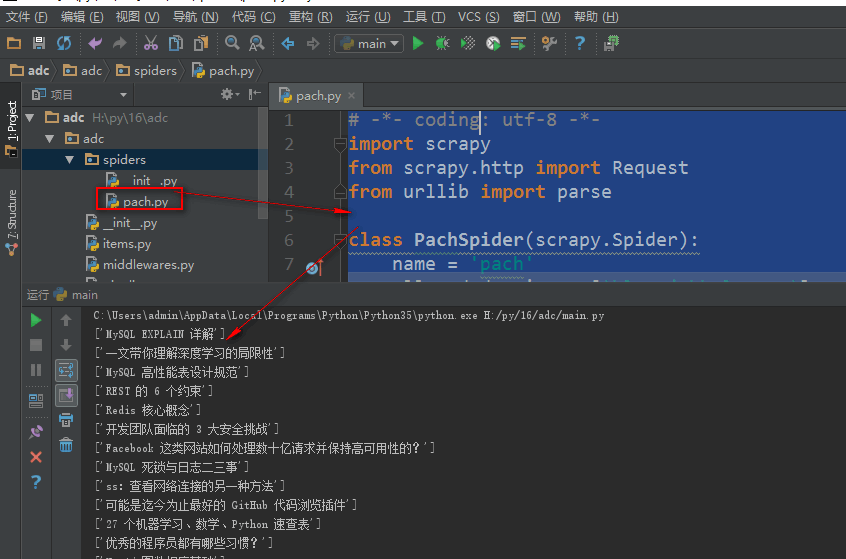

编写spiders爬虫文件循环抓取内容

Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数,

参数:

url='url'

callback=页面处理函数

使用时需要yield Request()

parse.urljoin()方法,是urllib库下的方法,是自动url拼接,如果第二个参数的url地址是相对路径会自动与第一个参数拼接

# -*- coding: utf-8 -*-

import scrapy

from scrapy.http import Request #导入url返回给下载器的方法

from urllib import parse #导入urllib库里的parse模块 class PachSpider(scrapy.Spider):

name = 'pach'

allowed_domains = ['blog.jobbole.com'] #起始域名

start_urls = ['http://blog.jobbole.com/all-posts/'] #起始url def parse(self, response):

"""

获取列表页的文章url地址,交给下载器

"""

#获取当前页文章url

lb_url = response.xpath('//a[@class="archive-title"]/@href').extract() #获取文章列表url

for i in lb_url:

# print(parse.urljoin(response.url,i)) #urllib库里的parse模块的urljoin()方法,是自动url拼接,如果第二个参数的url地址是相对路径会自动与第一个参数拼接

yield Request(url=parse.urljoin(response.url, i), callback=self.parse_wzhang) #将循环到的文章url添加给下载器,下载后交给parse_wzhang回调函数 #获取下一页列表url,交给下载器,返回给parse函数循环

x_lb_url = response.xpath('//a[@class="next page-numbers"]/@href').extract() #获取下一页文章列表url

if x_lb_url:

yield Request(url=parse.urljoin(response.url, x_lb_url[0]), callback=self.parse) #获取到下一页url返回给下载器,回调给parse函数循环进行 def parse_wzhang(self,response):

title = response.xpath('//div[@class="entry-header"]/h1/text()').extract() #获取文章标题

print(title)

Request()函数在返回url时,同时可以通过meta属性返回一个自定义字典给回调函数

# -*- coding: utf-8 -*-

import scrapy

from scrapy.http import Request #导入url返回给下载器的方法

from urllib import parse #导入urllib库里的parse模块

from adc.items import AdcItem #导入items数据接收模块的接收类 class PachSpider(scrapy.Spider):

name = 'pach'

allowed_domains = ['blog.jobbole.com'] #起始域名

start_urls = ['http://blog.jobbole.com/all-posts/'] #起始url def parse(self, response):

"""

获取列表页的文章url地址,交给下载器

"""

#获取当前页文章url

lb = response.css('div .post.floated-thumb') #获取文章列表区块,css选择器

# print(lb)

for i in lb:

lb_url = i.css('.archive-title ::attr(href)').extract_first('') #获取区块里文章url

# print(lb_url) lb_img = i.css('.post-thumb img ::attr(src)').extract_first('') #获取区块里文章缩略图

# print(lb_img) yield Request(url=parse.urljoin(response.url, lb_url), meta={'lb_img':parse.urljoin(response.url, lb_img)}, callback=self.parse_wzhang) #将循环到的文章url添加给下载器,下载后交给parse_wzhang回调函数 #获取下一页列表url,交给下载器,返回给parse函数循环

x_lb_url = response.css('.next.page-numbers ::attr(href)').extract_first('') #获取下一页文章列表url

if x_lb_url:

yield Request(url=parse.urljoin(response.url, x_lb_url), callback=self.parse) #获取到下一页url返回给下载器,回调给parse函数循环进行 def parse_wzhang(self,response):

title = response.css('.entry-header h1 ::text').extract() #获取文章标题

# print(title) tp_img = response.meta.get('lb_img', '') #接收meta传过来的值,用get获取防止出错

# print(tp_img) shjjsh = AdcItem() #实例化数据接收类

shjjsh['title'] = title #将数据传输给items接收模块的指定类

shjjsh['img'] = tp_img yield shjjsh #将接收对象返回给pipelines.py处理模块

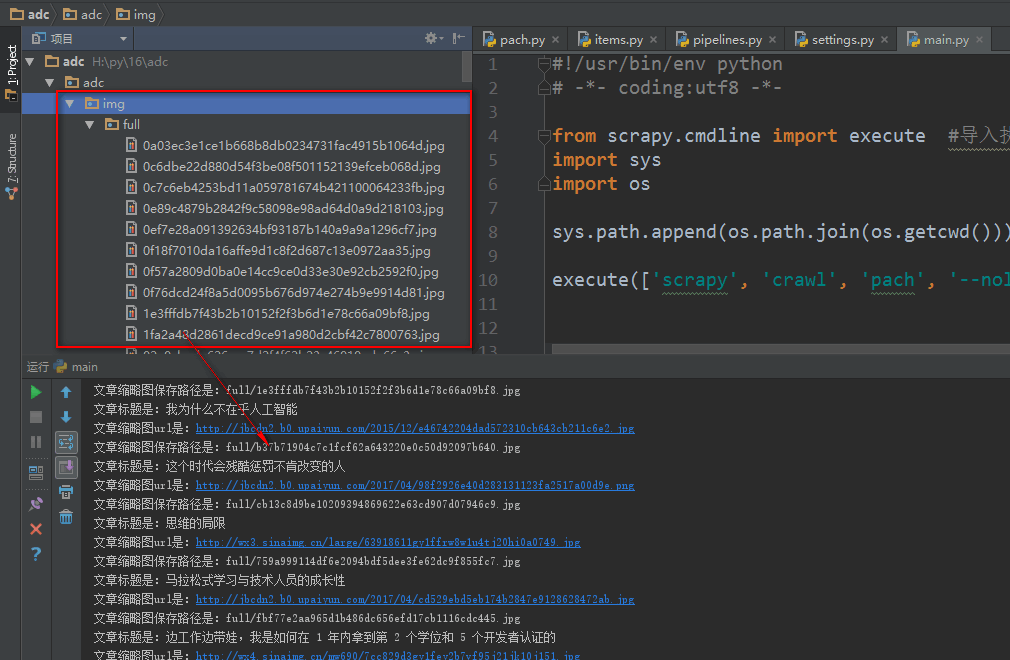

Scrapy内置图片下载器使用

Scrapy给我们内置了一个图片下载器在crapy.pipelines.images.ImagesPipeline,专门用于将爬虫抓取到图片url后将图片下载到本地

第一步、爬虫抓取图片URL地址后,填充到 items.py文件的容器函数

爬虫文件

# -*- coding: utf-8 -*-

import scrapy

from scrapy.http import Request #导入url返回给下载器的方法

from urllib import parse #导入urllib库里的parse模块

from adc.items import AdcItem #导入items数据接收模块的接收类 class PachSpider(scrapy.Spider):

name = 'pach'

allowed_domains = ['blog.jobbole.com'] #起始域名

start_urls = ['http://blog.jobbole.com/all-posts/'] #起始url def parse(self, response):

"""

获取列表页的文章url地址,交给下载器

"""

#获取当前页文章url

lb = response.css('div .post.floated-thumb') #获取文章列表区块,css选择器

# print(lb)

for i in lb:

lb_url = i.css('.archive-title ::attr(href)').extract_first('') #获取区块里文章url

# print(lb_url) lb_img = i.css('.post-thumb img ::attr(src)').extract_first('') #获取区块里文章缩略图

# print(lb_img) yield Request(url=parse.urljoin(response.url, lb_url), meta={'lb_img':parse.urljoin(response.url, lb_img)}, callback=self.parse_wzhang) #将循环到的文章url添加给下载器,下载后交给parse_wzhang回调函数 #获取下一页列表url,交给下载器,返回给parse函数循环

x_lb_url = response.css('.next.page-numbers ::attr(href)').extract_first('') #获取下一页文章列表url

if x_lb_url:

yield Request(url=parse.urljoin(response.url, x_lb_url), callback=self.parse) #获取到下一页url返回给下载器,回调给parse函数循环进行 def parse_wzhang(self,response):

title = response.css('.entry-header h1 ::text').extract() #获取文章标题

# print(title) tp_img = response.meta.get('lb_img', '') #接收meta传过来的值,用get获取防止出错

# print(tp_img) shjjsh = AdcItem() #实例化数据接收类

shjjsh['title'] = title #将数据传输给items接收模块的指定类

shjjsh['img'] = [tp_img] yield shjjsh #将接收对象返回给pipelines.py处理模块

第二步、设置 items.py 文件的容器函数,接收爬虫获取到的数据填充

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html import scrapy #items.py,文件是专门用于,接收爬虫获取到的数据信息的,就相当于是容器文件 class AdcItem(scrapy.Item): #设置爬虫获取到的信息容器类

title = scrapy.Field() #接收爬虫获取到的title信息

img = scrapy.Field() #接收缩略图

img_tplj = scrapy.Field() #图片保存路径

第三步、在pipelines.py使用crapy内置的图片下载器

1、首先引入内置图片下载器

2、自定义一个图片下载内,继承crapy内置的ImagesPipeline图片下载器类

3、使用ImagesPipeline类里的item_completed()方法获取到图片下载后的保存路径

4、在settings.py设置文件里,注册自定义图片下载器类,和设置图片保存路径

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

from scrapy.pipelines.images import ImagesPipeline #导入图片下载器模块 class AdcPipeline(object): #定义数据处理类,必须继承object

def process_item(self, item, spider): #process_item(item)为数据处理函数,接收一个item,item里就是爬虫最后yield item 来的数据对象

print('文章标题是:' + item['title'][0])

print('文章缩略图url是:' + item['img'][0])

print('文章缩略图保存路径是:' + item['img_tplj']) #接收图片下载器填充的,图片下载后的路径 return item class imgPipeline(ImagesPipeline): #自定义一个图片下载内,继承crapy内置的ImagesPipeline图片下载器类

def item_completed(self, results, item, info): #使用ImagesPipeline类里的item_completed()方法获取到图片下载后的保存路径

for ok, value in results:

img_lj = value['path'] #接收图片保存路径

# print(ok)

item['img_tplj'] = img_lj #将图片保存路径填充到items.py里的字段里

return item #将item给items.py 文件的容器函数 #注意:自定义图片下载器设置好后,需要在

在settings.py设置文件里,注册自定义图片下载器类,和设置图片保存路径

IMAGES_URLS_FIELD 设置要下载图片的url地址,一般设置的items.py里接收的字段

IMAGES_STORE 设置图片保存路径

# Configure item pipelines

# See http://scrapy.readthedocs.org/en/latest/topics/item-pipeline.html

ITEM_PIPELINES = {

'adc.pipelines.AdcPipeline': 300, #注册adc.pipelines.AdcPipeline类,后面一个数字参数表示执行等级,

'adc.pipelines.imgPipeline': 1, #注册自定义图片下载器,数值越小,越优先执行

} IMAGES_URLS_FIELD = 'img' #设置要下载图片的url字段,就是图片在items.py里的字段里

lujin = os.path.abspath(os.path.dirname(__file__))

IMAGES_STORE = os.path.join(lujin, 'img') #设置图片保存路径

第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器的更多相关文章

- 二十 Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

编写spiders爬虫文件循环抓取内容 Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数, 参数: url='url' callback=页面处理函数 使用时需要yield ...

- 第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存

第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存 注意:数据保存的操作都是在pipelines.py文件里操作的 将数据保存为json文件 spider是一个信号检测 ...

- 二十一 Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存

注意:数据保存的操作都是在pipelines.py文件里操作的 将数据保存为json文件 spider是一个信号检测 # -*- coding: utf-8 -*- # Define your ite ...

- 第三百五十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—将selenium操作谷歌浏览器集成到scrapy中

第三百五十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—将selenium操作谷歌浏览器集成到scrapy中 1.爬虫文件 dispatcher.connect()信号分发器,第一个参数信 ...

- 第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门搜索

第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门 我的搜素简单实现原理我们可以用js来实现,首先用js获取到 ...

- 第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引

第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引 倒排索引 倒排索引源于实际应用中需要根据属性的值来查找记录.这种索引表中的每一项都包 ...

- 第三百四十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用、自动限速、自定义spider的settings,对抗反爬机制

第三百四十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用.自动限速.自定义spider的settings,对抗反爬机制 cookie禁用 就是在Scrapy的配置文件set ...

- 第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware中间件全局随机更换user-agent浏览器用户代理

第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware随机更换user-agent浏览器用户代理 downloadmiddleware介绍中间件是 ...

- 第三百四十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—Requests请求和Response响应介绍

第三百四十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—Requests请求和Response响应介绍 Requests请求 Requests请求就是我们在爬虫文件写的Requests() ...

随机推荐

- CNN及其可解释性

https://stats385.github.io/readings https://arxiv.org/pdf/1311.2901.pdf A Mathematical Theory of Dee ...

- Machine Learning Books Suggested by Michael I. Jordan from Berkeley

http://www.statsblogs.com/2014/12/30/machine-learning-books-suggested-by-michael-i-jordan-from-berke ...

- vscode 换行符\n 变成\r\n

VSCode是一个开源的强大代码编写器,但是如果没有好好的配置使用,会适得其反. 这里总结VSCode的一些配置,方便自己查询,也方便网友. 1.编辑器配置 为特定类型文件指定缩进大小.缩进类型(空格 ...

- python __name__ = '__main__' 的作用

很多新手刚开始学习python的时候经常会看到python 中__name__ = \'__main__\' 这样的代码,可能很多新手一开始学习的时候都比较疑惑,python 中__name__ = ...

- linux命令(42):tr命令

Linux tr命令 Linux tr 命令用于转换或删除文件中的字符. tr 指令从标准输入设备读取数据,经过字符串转译后,将结果输出到标准输出设备. 语法: tr [-cdst][--help][ ...

- bash shell(4):读取文件大小,移动文件,复制文件,字符串转数字

下面是代码:注意: 1.if [ expression ],表达式两边需要空格 2.a=$[aa],字符串转为int类型 3.赋值的时候不能有空格 #!/bin/shell fn="file ...

- iOS 减法计算器

一: 在界面上拖入相应的控件 二: 给每个控件设置关联 //监听按钮的点击 - (IBAction)compute:(id)sender; //第一个文本输入框的值 @property (weak, ...

- 【嵌入式】bootloader,linux,filesystem的烧写

平台: 深圳市优龙科技有限公司的FS2410(基于ARM9) 准备: 1.用串口(UART1,J8)线与PC机相连,这个是用来传输数据和显示信息的 2.连接USB数据下载线(usb device),注 ...

- ubuntu14.04 +nginx+php5-fpm

一,安装Nginx apt-get install nginx 1,配置nginx nginx所有的配置在 /etc/nginx/nginx.conf中 nginx.conf配置里面包括了 inclu ...

- 关于一点pthread_cond_t条件锁的思考以及实验

转:http://blog.csdn.net/aniao/article/details/5802015 APUE上,关于条件锁.其中有这么几条总结: 1.使用条件锁前必须先锁住对应的互斥锁. 2.条 ...