HBase独立集群部署

HBase是分布式、面向列式存储的开源数据库,来源于Google的论文BigTable,HBase运行于Hadoop平台之上,不同于一般的关系数据库,是一个适合非结构化数据存储的分布式数据库

安装Hbase之前首先系统应该做通用的集群环境准备工作,这些是必须的:

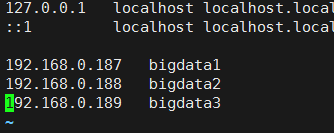

1、集群中主机名必须正确配置,最好有实际意义;并且主机名都在hosts文件中对应主机IP,一一对应,不可缺少

这里是3台主机,分别对应

2、JDK环境正确安装

3、集群中每台机器关闭防火墙,保证通信畅通

4、配置集群间ssh免密登录

5、集群ntp服务开启,保证时间同步

6、Hadoop HDFS服务开启

前面5步都配置好的基础上,首先配置Hadoop集群,在bigdata1上做配置操作

首先解压hadoop,并安装至指定目录:

tar -xvzf hadoop-2.6..tar.gz

mkdir /bigdata/hadoop

mv hadoop-2.6. /bigdata/hadoop

cd /bigdata/hadoop/hadoop-2.6.

就是简单的释放,然后为了方便可以将HADOOP_HOME添加至环境变量

配置hadoop需要编辑以下几个配置文件:

hadoop-env.sh core-site.xml hdfs-site.xml mapred-site.xml yarn-site.xml slaves

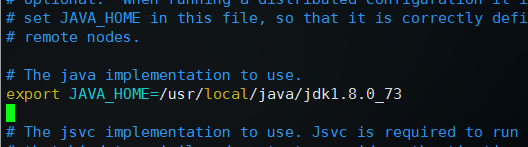

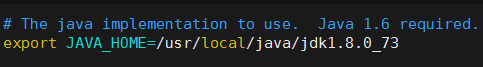

1、编辑hadoop-env.sh

修改export JAVA_HOME=${JAVA_HOME}为自己的实际安装位置

这里是export JAVA_HOME=/usr/local/java/jdk1.8.0_73

2、编辑core-site.xml,在configuration标签中间添加如下代码:

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/bigdata/hadoop/tmp</value>

</property>

其中bigdata1是namenode节点

3、编辑hdfs-site.xml ,添加如下代码:

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///bigdata/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///bigdata/hadoop/hdfs/data</value>

</property>

<!-- 这个地方是为Hbase的专用配置,最小为4096,表示同时处理文件的上限,不配置会报错 -->

<property>

<name>dfs.datanode.max.xcievers</name>

<value>4096</value>

</property>

关于第4组配置已经注释说明了

4、编辑mapred-site.xml,添加如下配置:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

5、编辑yarn-site.xml,添加如下配置:

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

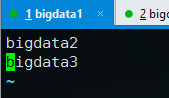

6、编辑slaves,添加datanode节点

bigdata2

bigdata3

这些都保存完毕,将/bigdata/下的hadoop目录整体发送至集群中其他主机,其他主机应该事先建立好bigdata目录

scp -r /bigdata/hadoop bigdata2:/bigdata

scp -r /bigdata/hadoop bigdata3:/bigdata

然后在bigdata1上格式化文件系统:

bin/hdfs namenode -format

然后启动hdfs服务:

sbin/start-dfs.sh

启动完成之后,执行 jps 命令,在主节点可以看到NameNode和SecondaryNameNode进程;其他节点可以看到DataNode进程

然后启动yarn守护进程: sbin/start-yarn.sh

主节点会增加:ResourceManager进程,其他节点会增加:NodeManager进程

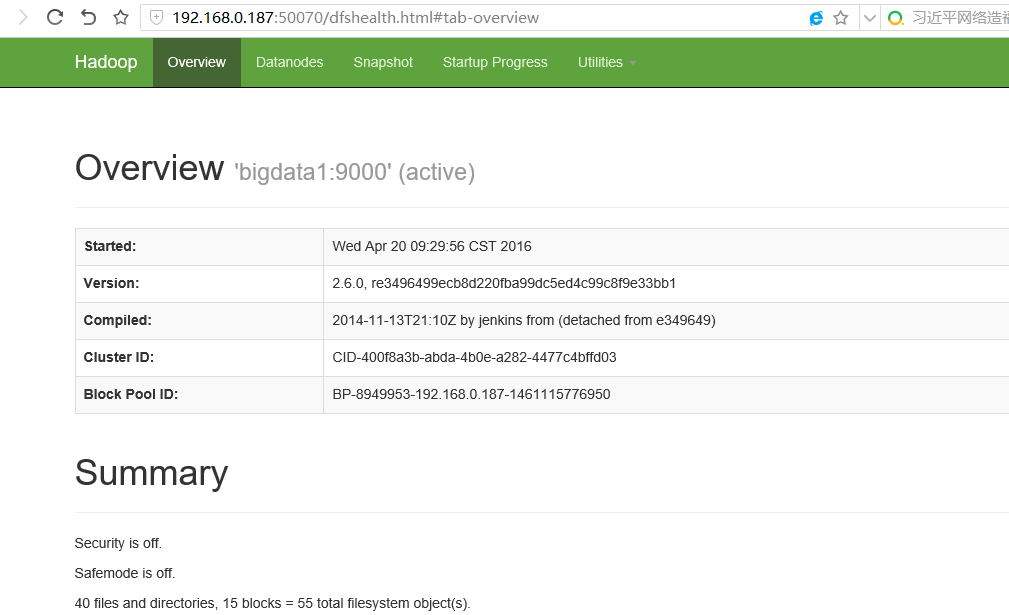

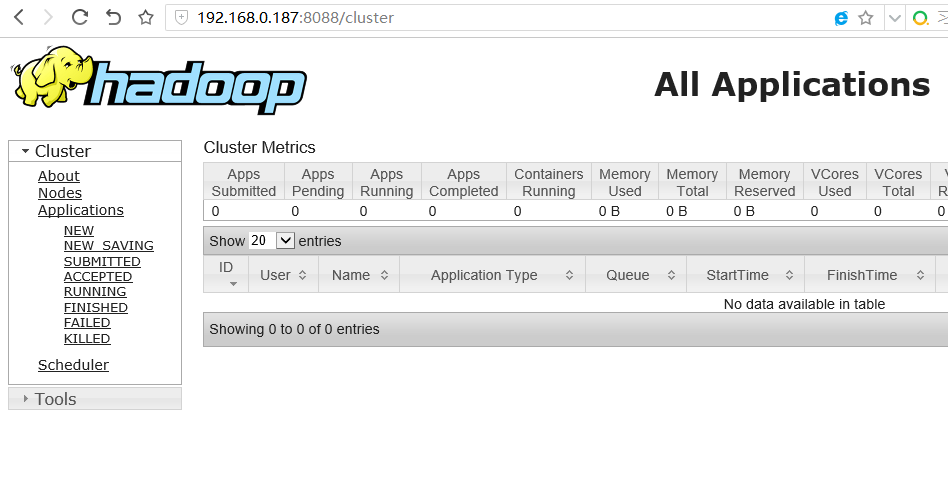

现在通过浏览器可以打开相应的管理界面,以bigdata1的IP访问:

http://192.168.0.187:50070

http://192.168.0.187:8088

到这里hadoop hdfs就部署完成了,然后开始部署HBase,这里使用的版本为:hbase-0.98.18-hadoop2-bin.tar.gz

和释放hadoop包一样将hbase释放到对应的目录并进入,这里是:/bigdata/hbase/hbase-0.98.18-hadoop2

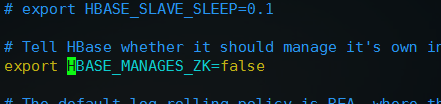

首先编辑配置文件: vim conf/hbase-env.sh

去掉JAVA_HOME前面的注释,改为自己实际的JDK安装路径,和配置hadoop类似

然后,去掉export HBASE_MANAGES_ZK=true前面的注释并改为export HBASE_MANAGES_ZK=false,配置不让HBase管理Zookeeper

配置完这两项之后,保存退出

编辑文件 vim conf/hbase-site.xml 在configuration标签之间加入如下配置:

<!-- 指定HBase在HDFS上面创建的目录名hbase -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://bigdata1:9000/hbase</value>

</property>

<!-- 开启集群运行方式 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

分别将hadoop配置下的core-site.xml和hdfs-site.xml复制或者做软链接到hbase配置目录下:

cp /bigdata/hadoop/hadoop-2.6./etc/hadoop/core-site.xml conf/

cp /bigdata/hadoop/hadoop-2.6./etc/hadoop/hdfs-site.xml conf/

执行 vim conf/regionservers 编辑运行regionserver存储服务的Hbase节点,就相当于hadoop slaves中的DataNode节点

保存之后,配置完毕,将hbase发送至其他数据节点:

scp -r /bigdata/hbase/ bigdata2:/bigdata/

scp -r /bigdata/hbase/ bigdata3:/bigdata/

然后在bigdata1启动Hbase

bin/start-hbase.sh

启动成功,在bigdata1会增加进程:HMaster 在bigdata2和bigdata3会增加进程:HRegionServer

到这里HBase就部署完毕,这里没有包含Zookeeper

执行命令: /bigdata/hadoop/hadoop-2.6./bin/hdfs dfs -ls / 可以查看hbase是否在HDFS文件系统创建成功

看到/hbase节点表示创建成功

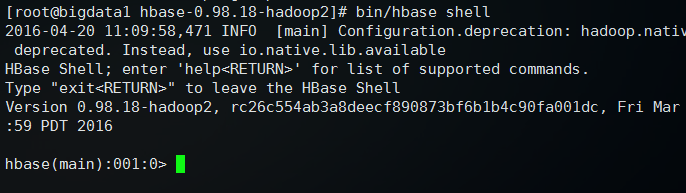

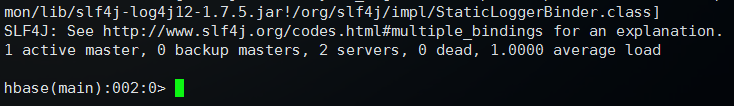

然后执行: bin/hbase shell 可以进入Hbase管理界面

输入 status 查看状态

返回状态,表示HBase可以正常使用

输入 quit 可以退出管理,回到命令行

HBase独立集群部署的更多相关文章

- HBase集群部署与基础命令

HBase 集群部署 安装 hbase 之前需要先搭建好 hadoop 集群和 zookeeper 集群.hadoop 集群搭建可以参考:https://www.cnblogs.com/javammc ...

- Hbase集群部署及shell操作

本文详述了Hbase集群的部署. 集群部署 1.将安装包上传到集群并解压 scp hbase-0.99.2-bin.tar.gz mini1:/root/apps/ tar -zxvf hbase-0 ...

- HBase 集群部署

前提条件:hadoop及zookeeper机群已经搭建好. 配置hbase集群步骤: 1.配置hbase集群,要修改3个文件 注意:要把hadoop的hdfs-site.xml和core-site. ...

- Hbase集群部署

1.安装Hadoop集群 这个之前已经写过 2.安装Zookeeper 这个之前也已经写过 3.下载hbase,放到master机器,解压 4.修改hbase-env.sh,添加Java地址 expo ...

- HBase集群部署脚本

#!/bin/bash # Sync HBASE_HOME across the cluster. Must run on master using HBase owner user. HBASE_H ...

- HBase集成Zookeeper集群部署

大数据集群为了保证故障转移,一般通过zookeeper来整体协调管理,当节点数大于等于6个时推荐使用,接下来描述一下Hbase集群部署在zookeeper上的过程: 安装Hbase之前首先系统应该做通 ...

- Hadoop及Zookeeper+HBase完全分布式集群部署

Hadoop及HBase集群部署 一. 集群环境 系统版本 虚拟机:内存 16G CPU 双核心 系统: CentOS-7 64位 系统下载地址: http://124.202.164.6/files ...

- 在Azure HDInsight HBase集群中使用Thrift接口

Sun wei Wed, Feb 25 2015 2:17 AM Apache Thrift 是一种可扩展的跨语言服务接口,可以通过内置的代码生成引擎帮助创建跨语言服务类库,Apache HBase ...

- 基于Hadoop集群的HBase集群的配置

一 Hadoop集群部署 hadoop配置 二 Zookeeper集群部署 zookeeper配置 三 Hbase集群部署 1.配置hbase-env.sh HBASE_MANAGES_ZK:用来 ...

随机推荐

- [MongoDB]入门操作

摘要 在工作中也经常使用mongodb,每次遇到新的操作都需要去查,比较麻烦,准备在博客中系统的学习一下mongodb.首先在本地安装mongodb环境,可以下载一个windows的版本. 官网地址 ...

- winsow xp不能安装软件, 提示"中断" 是因为设置了 软件限制策略

原来是我为了优化和安全, 设置了软件限制策略. 我设置的是: secpol.msc中, 设置 "软件限制策略" -> "其他规则"中 , 指定了 c:/d ...

- 理解Memcached的分布式

Memcached尽管是"分布式"的缓存系统,但是服务器端并没有分布式功能.各个Memcached实例不会相互通信以共享信息,Memcached如何进行分布式完全取决于客户端的实现 ...

- Java字节流:ByteArrayInputStream ByteArrayOutputStream

----------------------------------------------------------------------------------- ByteArrayInputSt ...

- [设计模式] javascript 之 桥接模式

桥接模式说明 定义:分离抽象化与实现化,使之可以自由独立的变化: 说明:由于软件环境需求原因,使得类型抽象具有多种实现以自身变化定义等情况,这使得我们要分离抽象实现与具体实现,使得抽象化与实现化解耦, ...

- OFFICE文档(DOC,XLS,PPT)打开报错的解决办法!

一般情况下,打开OFFICE文档报错都是因为模板文件出错!! 至于为什么会出错这个问题不好说,可能是不正确关闭文档等等,重装OFFICE也不一定能解决问题! 出现这种情况一般是所有的Word文档或者E ...

- linux系统安装yum环境

http://blog.sina.com.cn/s/blog_63d8dad80101cn2s.html 1.卸载rhel的默认安装的yum包 查看yum包 rpm -qa|grep yum 卸载之 ...

- RelativeLayout布局

RelativeLayout用到的一些重要的属性: 第一类:属性值为true或falseandroid:layout_centerHrizontal 水平居中android:layout_center ...

- Triangle leetcode

Given a triangle, find the minimum path sum from top to bottom. Each step you may move to adjacent n ...

- EF接触02

Ado.net Entity Framework早期称为ObjectSpace.基于Ado.net操作数据库的一组类库. 什么是ADO.NET? 基础.net平台下的操作数据库的一组Api或组建.五大 ...