Python爬虫之简单的爬取百度贴吧数据

首先要使用的第类库有 urllib下的request 以及urllib下的parse 以及 time包 random包

之后我们定义一个名叫BaiduSpider类用来爬取信息

属性有 url:用来爬取的网址 headers:请求头

class BaiduSpider(object):

def __init__(self):

self.url = 'http://tieba.baidu.com/f?kw={}&pn={}'

self.headers = {'User-Agent':'Win7:Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1'}

之后我们定义三个方法 不涉及清洗数据

获取页面

#获取页面

def get_page(self,url):

#定义请求对象

req = request.Request(url=url,headers=self.headers)

#发起请求

res = request.urlopen(req)

#获取相应对象

html = res.read().decode('utf-8', 'ignore')

return html

保存数据

#保存数据

def write_page(self,filename,html):

#将数据保存到本地

with open(filename,'w',encoding='utf-8') as f:

f.write(html)

主函数

#主函数

def main(self):

name = input('请输入贴吧名:>>>>')

start = int(input('请输入起始页'))

end = int(input('请输入终止页'))

for page in range(start,end+1):

#拼接URL地址 'http://tieba.baidu.com/f?kw{}&pn={}'

#进行编码 将中文字符编码为url地址编码

kw = parse.quote(name)

#获取当前页数

pn = (page-1)*50

#进行url地址的拼接

url = self.url.format(kw,pn)

#获取相应

html = self.get_page(url)

filename = '{}-第{}页.html'.format(name,page)

self.write_page(filename,html)

#提示

print('第{}页爬取成功'.format(page))

#控制爬取速度

time.sleep(random.randint(1,3))

最后 所有的代码展示如下

#导入模块

from urllib import request,parse

import time

import random class BaiduSpider(object):

def __init__(self):

self.url = 'http://tieba.baidu.com/f?kw={}&pn={}'

self.headers = {'User-Agent':'Win7:Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1'} #获取页面

def get_page(self,url):

#定义请求对象

req = request.Request(url=url,headers=self.headers)

#发起请求

res = request.urlopen(req)

#获取相应对象

html = res.read().decode('utf-8', 'ignore')

return html #解析数据

def parse_page(self):

pass #保存数据

def write_page(self,filename,html):

#将数据保存到本地

with open(filename,'w',encoding='utf-8') as f:

f.write(html) #主函数

def main(self):

name = input('请输入贴吧名:>>>>')

start = int(input('请输入起始页'))

end = int(input('请输入终止页'))

for page in range(start,end+1):

#拼接URL地址 'http://tieba.baidu.com/f?kw{}&pn={}'

#进行编码 将中文字符编码为url地址编码

kw = parse.quote(name)

#获取当前页数

pn = (page-1)*50

#进行url地址的拼接

url = self.url.format(kw,pn)

#获取相应

html = self.get_page(url)

filename = '{}-第{}页.html'.format(name,page)

self.write_page(filename,html)

#提示

print('第{}页爬取成功'.format(page))

#控制爬取速度

time.sleep(random.randint(1,3)) if __name__ == '__main__':

spider = BaiduSpider()

spider.main()

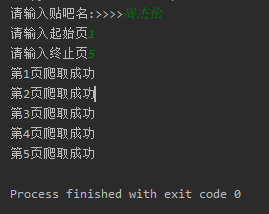

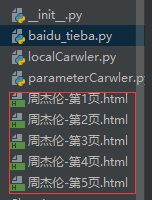

一个非常非常简单的爬虫就完成了 让我们看一下运行效果截图:

html文件打开后 与我们正常打开的网页并没有太大的差别

Python爬虫之简单的爬取百度贴吧数据的更多相关文章

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

- Python爬虫:为什么你爬取不到网页数据

前言: 之前小编写了一篇关于爬虫为什么爬取不到数据文章(文章链接为:Python爬虫经常爬不到数据,或许你可以看一下小编的这篇文章), 但是当时小编也是胡乱编写的,其实里面有很多问题的,现在小编重新发 ...

- Python开发简单爬虫(二)---爬取百度百科页面数据

一.开发爬虫的步骤 1.确定目标抓取策略: 打开目标页面,通过右键审查元素确定网页的url格式.数据格式.和网页编码形式. ①先看url的格式, F12观察一下链接的形式;② 再看目标文本信息的标签格 ...

- Python爬虫:通过关键字爬取百度图片

使用工具:Python2.7 点我下载 scrapy框架 sublime text3 一.搭建python(Windows版本) 1.安装python2.7 ---然后在cmd当中输入python,界 ...

- Python 基础语法+简单地爬取百度贴吧内容

Python笔记 1.Python3和Pycharm2018的安装 2.Python3基础语法 2.1.1.数据类型 2.1.1.1.数据类型:数字(整数和浮点数) 整数:int类型 浮点数:floa ...

- Python爬虫入门教程 42-100 爬取儿歌多多APP数据-手机APP爬虫部分

1. 儿歌多多APP简单分析 今天是手机APP数据爬取的第一篇案例博客,我找到了一个儿歌多多APP,没有加固,没有加壳,没有加密参数,对新手来说,比较友好,咱就拿它练练手,熟悉一下Fiddler和夜神 ...

- 【学习笔记】Python 3.6模拟输入并爬取百度前10页密切相关链接

[学习笔记]Python 3.6模拟输入并爬取百度前10页密切相关链接 问题描述 通过模拟网页,实现百度搜索关键词,然后获得网页中链接的文本,与准备的文本进行比较,如果有相似之处则代表相关链接. me ...

- python爬虫:了解JS加密爬取网易云音乐

python爬虫:了解JS加密爬取网易云音乐 前言 大家好,我是"持之以恒_liu",之所以起这个名字,就是希望我自己无论做什么事,只要一开始选择了,那么就要坚持到底,不管结果如何 ...

随机推荐

- [LibreOJ 3124]【CTS2019】氪金手游【容斥原理】【概率】【树形DP】

Description Solution 首先它的限制关系是一个树形图 首先考虑如果它是一个外向树该怎么做. 这是很简单的,我们相当于每个子树的根都是子树中最早出现的点,概率是容易计算的. 设DP状态 ...

- PTA 刷题与Z老师的头发

刷题与Z老师的头发 (10 分) 在Pintia上,每天Z老师出题.小盆友们刷题.Z老师的头发遵从以下规律: 1.每天生长出60根头发: 2.每出一道题,减少20根头发: 3.每天结束时统计累积做题情 ...

- Unity3D_(API)场景切换SceneManager

Unity场景切换SceneManager 官方文档:传送门 静态方法 创建场景 CreateScene Create an empty new Scene at runtime with the g ...

- Linux下不同组件运行命令

Spark优化配置 添加外包路径 1.1 vim $SPARK_HOME/conf/spark-defaults.conf spark.executor.extraClassPath file:/// ...

- C++入门经典-例2.9-输出十六进制数以及大写的十六进制数

1:代码如下: #include "stdafx.h" #include <iostream> #include <iomanip> using names ...

- 利用docker启动 wordpress

网上有很多教程哈,我只是记录自己怎么玩的,没啥教学意义 查看镜像说明的mysql/data目录,方便挂载 [root@docker ~]# docker inspect -f {{.Config.Vo ...

- elk5.0 版本遇到的安装问题

问题1:max_map_count不够大 max virtual memory areas vm.max_map_count [65536] likely too low, increase to a ...

- Mac下破解百度网盘限速(Chrome + Aria2GUI)

基本原理是利用Aria2GUI的多线程下载来达到提速的目的,具体步骤如下: 1.下载Aria2GUI客户端(注意,客户端文件要放入‘应用程序’,否则会报错),使用时注意修改线程数,默认为16,不够用, ...

- Kotlin之环境的配置和搭建

第一步 . 安装和配置JDK http://www.cnblogs.com/loaderman/p/6402948.html 第二步 安装和下载Kotlin 进入Kotlin官网 :https :// ...

- CSS二级菜单

0.需求:当鼠标hover到按钮上时,出现下拉菜单导航条. 1.问题拆解: (1)HTML应该如何组织比较方便合理 因为题中要求下拉菜单位于按钮的正下方,可以使用列表<li>中嵌套无序列表 ...